论文作者:Hongyang Li,Hao Zhang,Zhaoyang Zeng,Shilong Liu,Feng Li,Tianhe Ren,Lei Zhang

作者单位:South China University of Technology; The Hong Kong University of Science and Technology; International Digital Economy Academy (IDEA); Tsinghua University

论文链接:http://arxiv.org/abs/2307.12972v1

项目链接:https://github.com/IDEA-Research/3D-deformable-attention.git

内容简介:

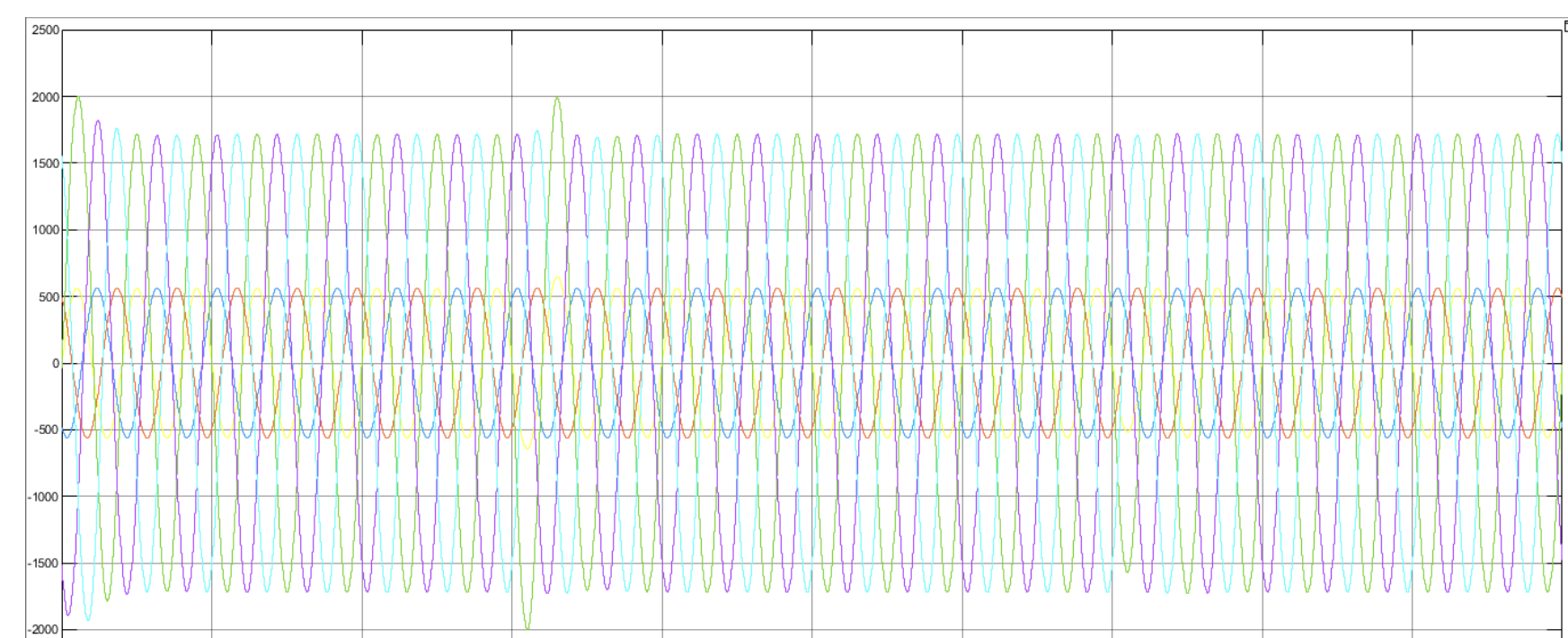

1)方向:3D DeFormable Attention (DFA3D)

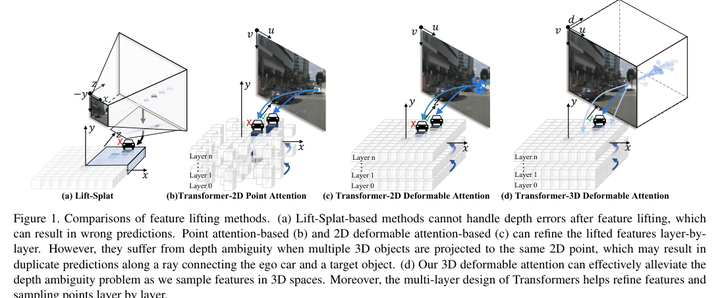

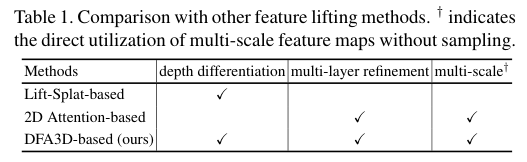

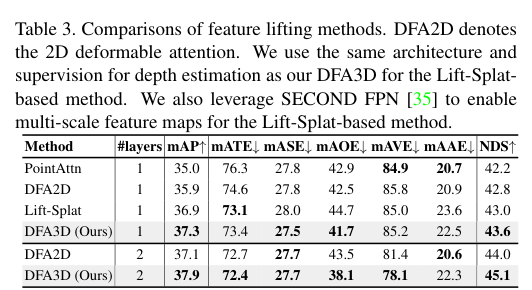

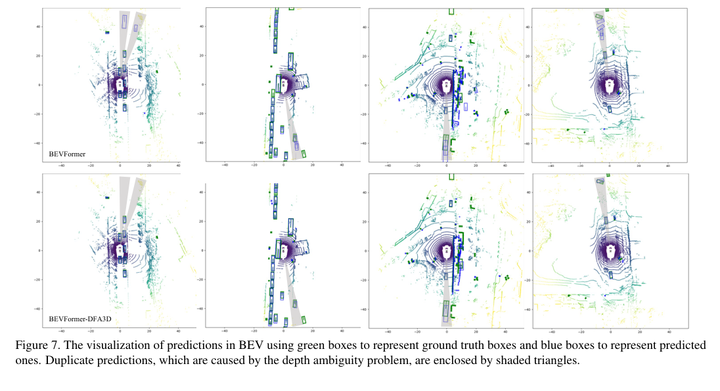

2)背景:现有的特征提升方法要么使用估计的深度获取伪LiDAR特征并将其投射到3D空间,但这是一种单次操作,没有特征细化;要么忽略深度,通过2D注意机制提升特征,虽然可以获得更精细的语义信息,但存在深度模糊问题。

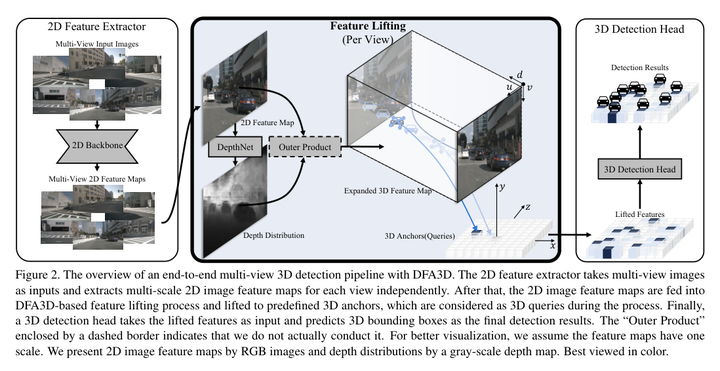

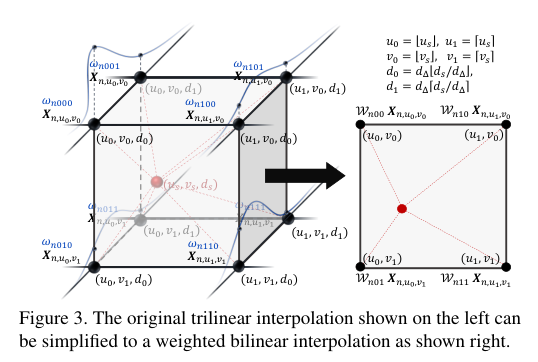

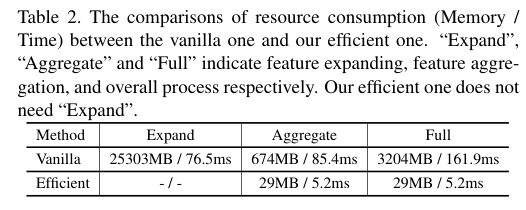

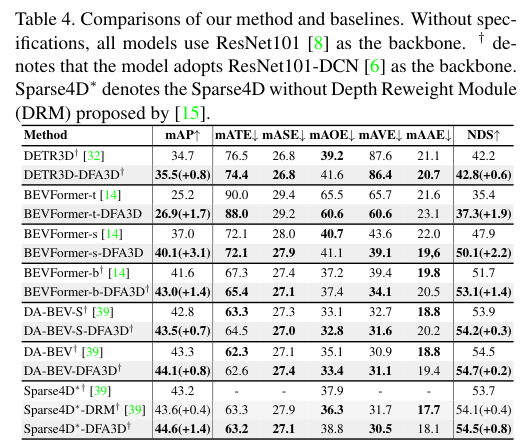

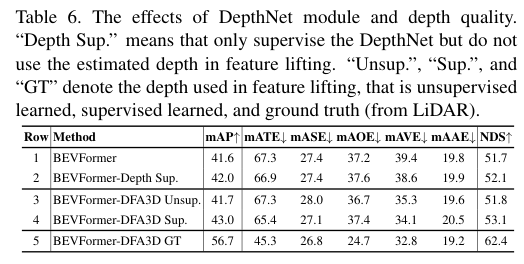

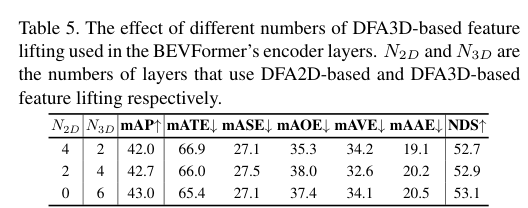

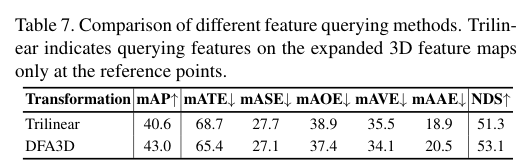

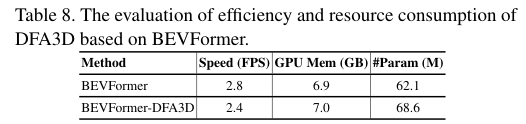

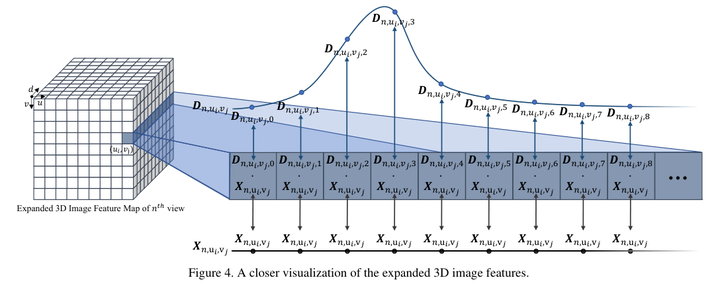

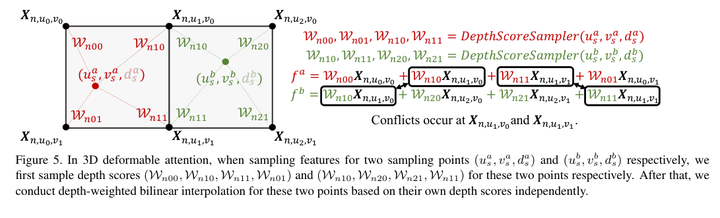

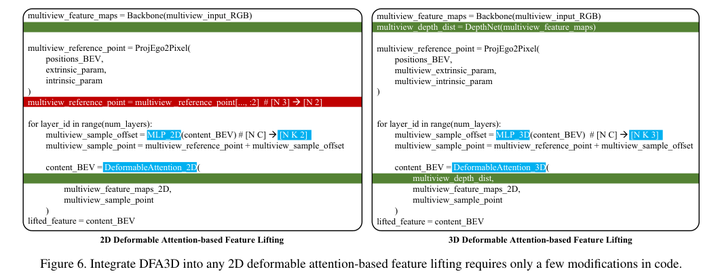

3)方法:本文所提出方法首先利用估计的深度将每个视角的2D特征图扩展到3D,并利用DFA3D从扩展的3D特征图中聚合特征。通过DFA3D的帮助,可以从根本上有效地减轻深度模糊问题,并且通过Transformer-like架构逐层逐渐细化提升的特征。将DFA3D集成到几种使用2D注意特征提升的方法中,只需对代码进行少量修改,并在nuScenes数据集上进行评估。

4)结果:实验结果显示,平均mAP提高了+1.41%,当有高质量深度信息时,mAP提高了高达+15.1%,证明了DFA3D的优越性、适用性和巨大潜力。代码可在https://github.com/IDEA-Research/3D-deformable-attention.git上获取。

![[计算机入门] Windows附件程序介绍(游戏类)](https://img-blog.csdnimg.cn/6e7c86fe47f648bfab886cb3784e1fba.png)