1.简介:

组织机构:智谱/清华

代码仓:https://github.com/THUDM/ChatGLM2-6B

模型:THUDM/chatglm2-6b

下载:https://huggingface.co/THUDM/chatglm2-6b

镜像下载:https://aliendao.cn/models/THUDM/chatglm2-6b

硬件环境:Jetson AGX Orin

2.代码和模型下载

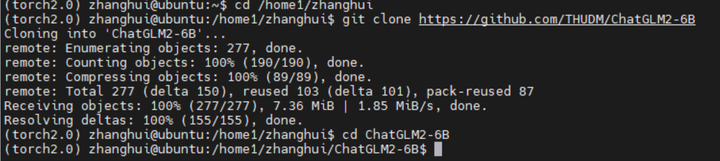

cd /home1/zhanghui

下载代码仓:

git clone https://github.com/THUDM/ChatGLM2-6B

git clone https://huggingface.co/THUDM/chatglm2-6b

查看 https://github.com/git-lfs/git-lfs/blob/main/INSTALLING.md

貌似是要安装git-lfs

sudo apt-get install git-lfs

重来:

git clone https://huggingface.co/THUDM/chatglm2-6b

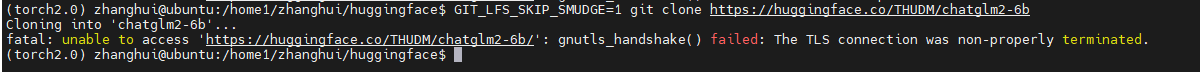

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/THUDM/chatglm2-6b

看来huggingface.co是怎么都连不上了。

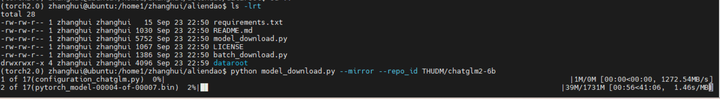

查看镜像站:https://aliendao.cn/models/THUDM/chatglm2-6b

从镜像下载模型的方法如下:

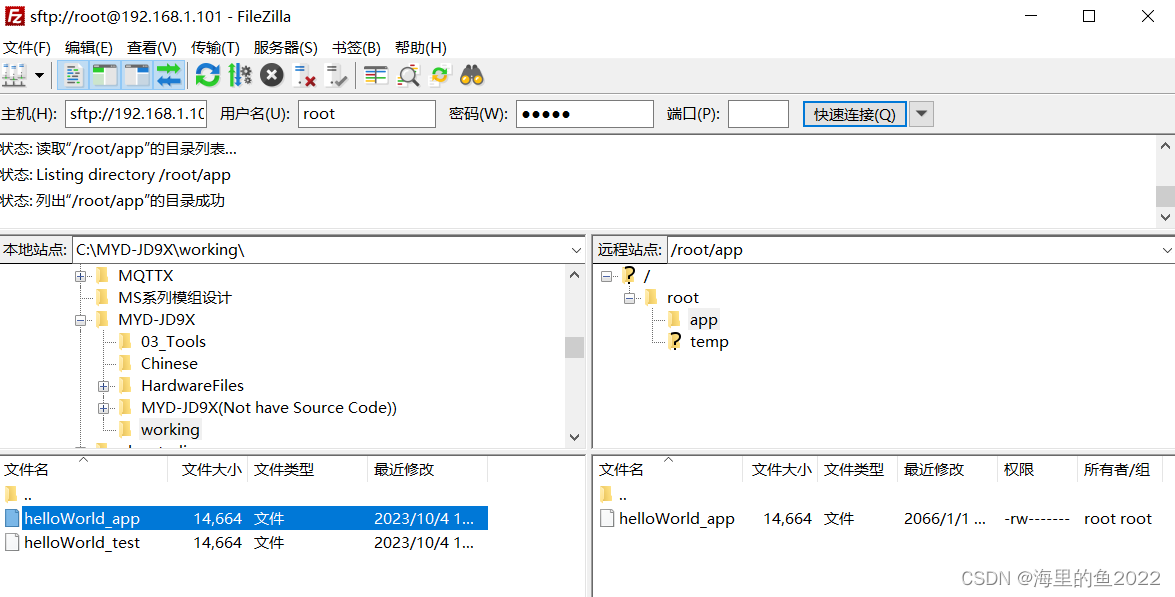

cd /home1/zhanghui/aliendao

python3 model_download.py --mirror --repo_id THUDM/chatglm2-6b

实验表明镜像站下载大的模型文件大概率还是会会出现下载卡住的情形。

还是使用huggingface官网下载到本地的方式吧!

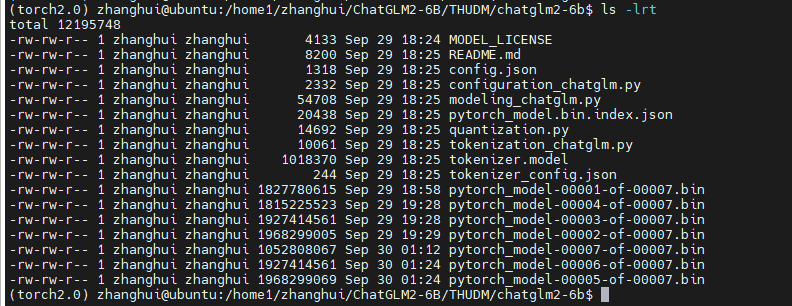

下载完毕后,可将下载好的文件移动到 /home1/zhanghui/ChatGLM2-6B/THUDM/chatglm2-6b 目录下(gitattributes文件可以改名为 .gitattributes)

3.安装依赖

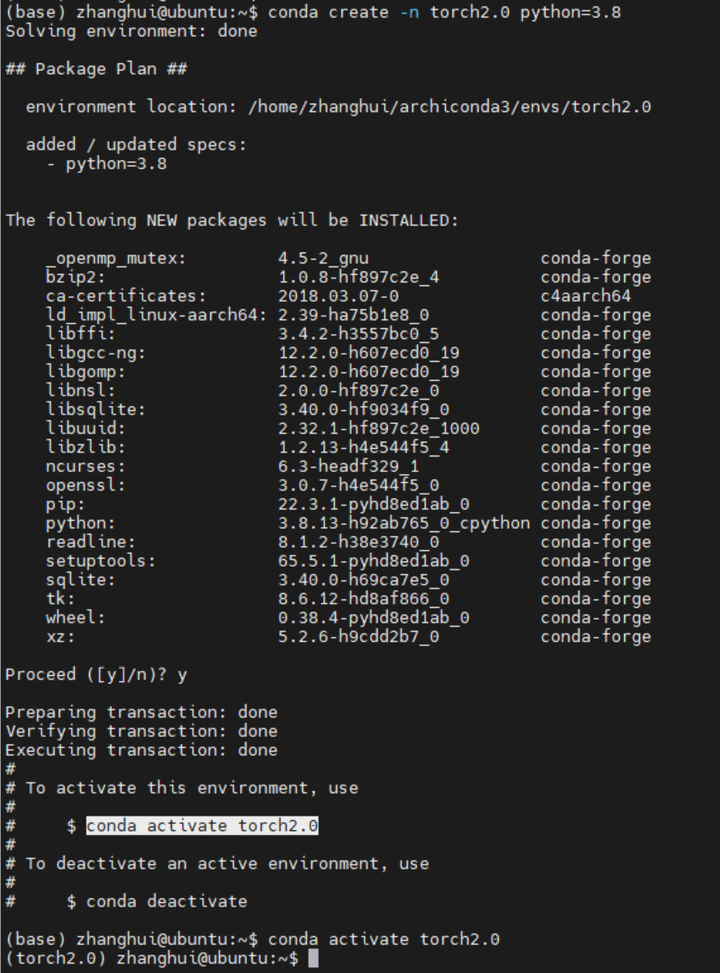

做一个pytorch 2.0,python 3.8的conda环境。

conda create -n torch2.0 python=3.8

conda activate torch2.0

cd /home1/zhanghui

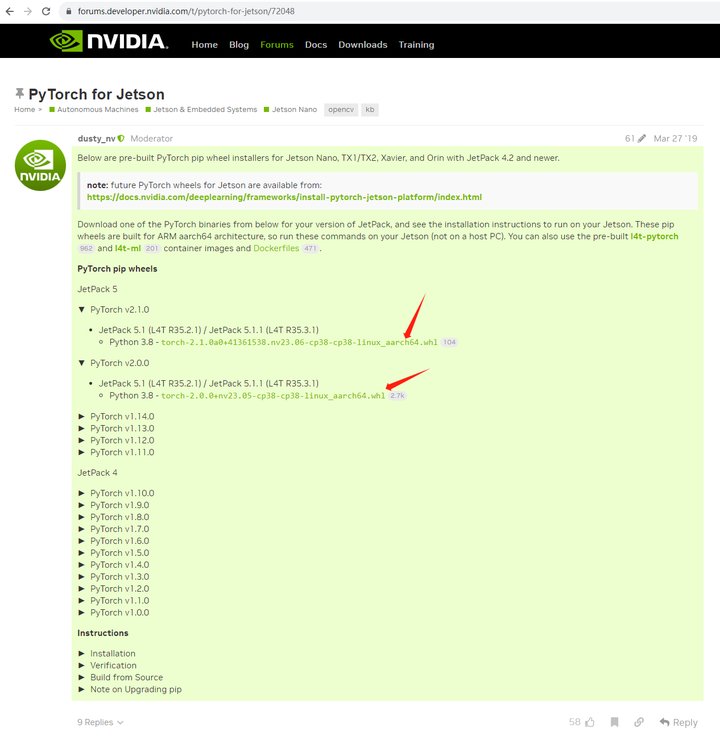

这个是jetson设备,需要安装专门的whl包。

打开https://forums.developer.nvidia.com/t/pytorch-for-jetson-version-1-10-now-available/72048

下载pytorch jetson专用安装包:

cd ..

下载pytorch 2.1版本:

wget https://developer.download.nvidia.cn/compute/redist/jp/v512/pytorch/torch-2.1.0a0+41361538.nv23.06-cp38-cp38-linux_aarch64.whl

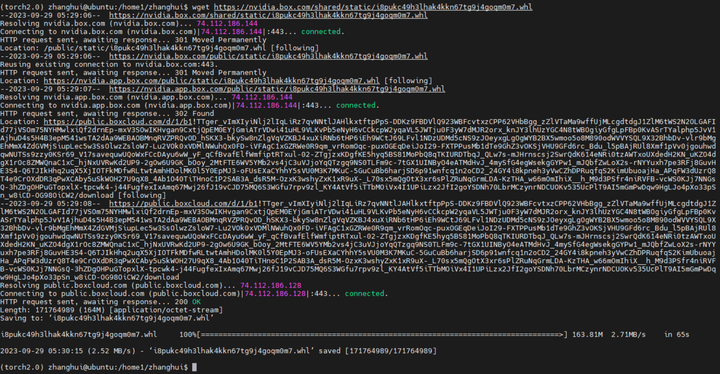

下载pytorch 2.0版本:

wget https://nvidia.box.com/shared/static/i8pukc49h3lhak4kkn67tg9j4goqm0m7.whl

mv i8pukc49h3lhak4kkn67tg9j4goqm0m7.whl torch-2.0.0+nv23.05-cp38-cp38-linux_aarch64.whl

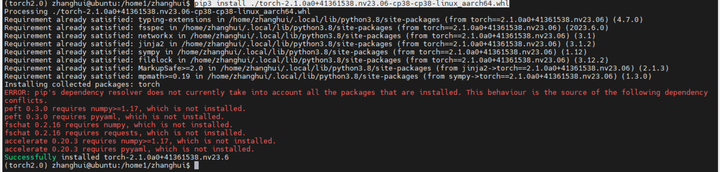

安装pytorch 2.1的版本试试:

pip3 install ./torch-2.1.0a0+41361538.nv23.06-cp38-cp38-linux_aarch64.whl

cd ChatGLM2-6B

安装依赖包:

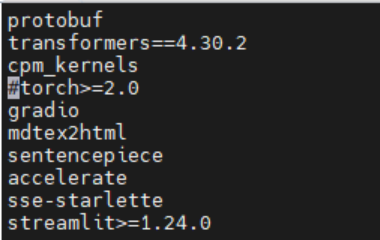

修改requirements.txt文件,注释掉torch

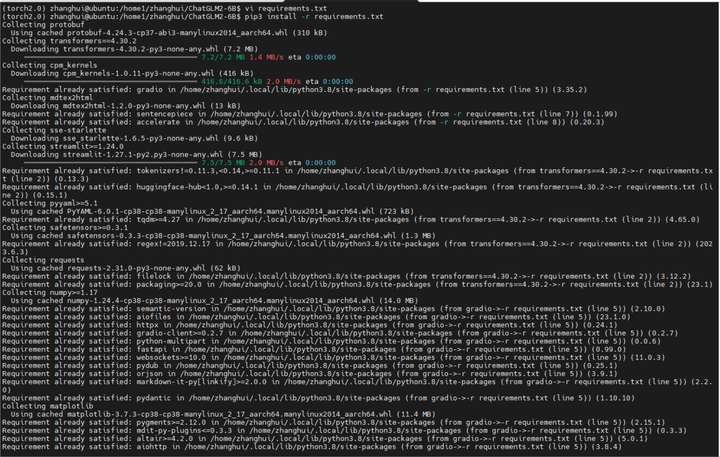

pip3 install -r requirements.txt

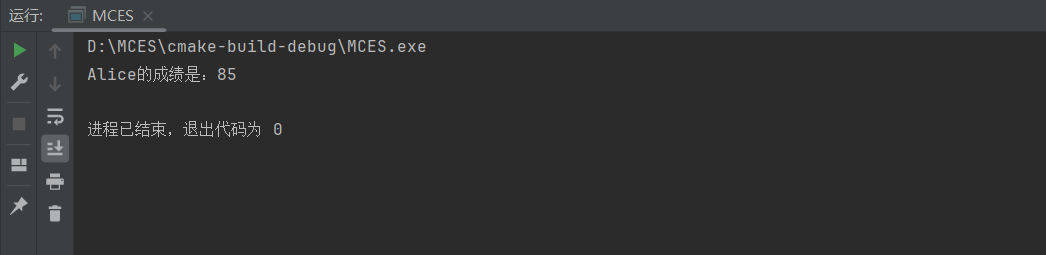

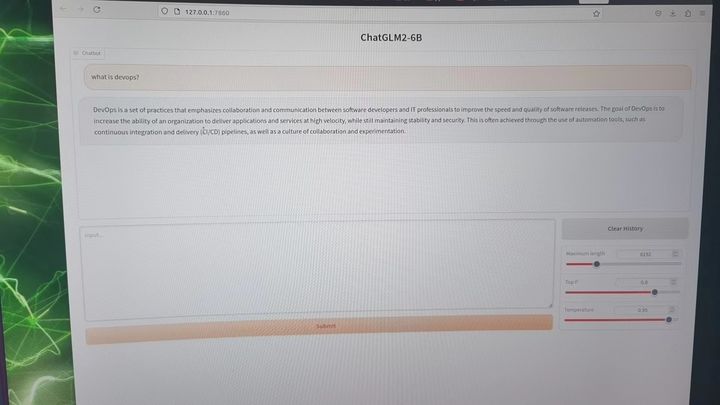

4.部署验证

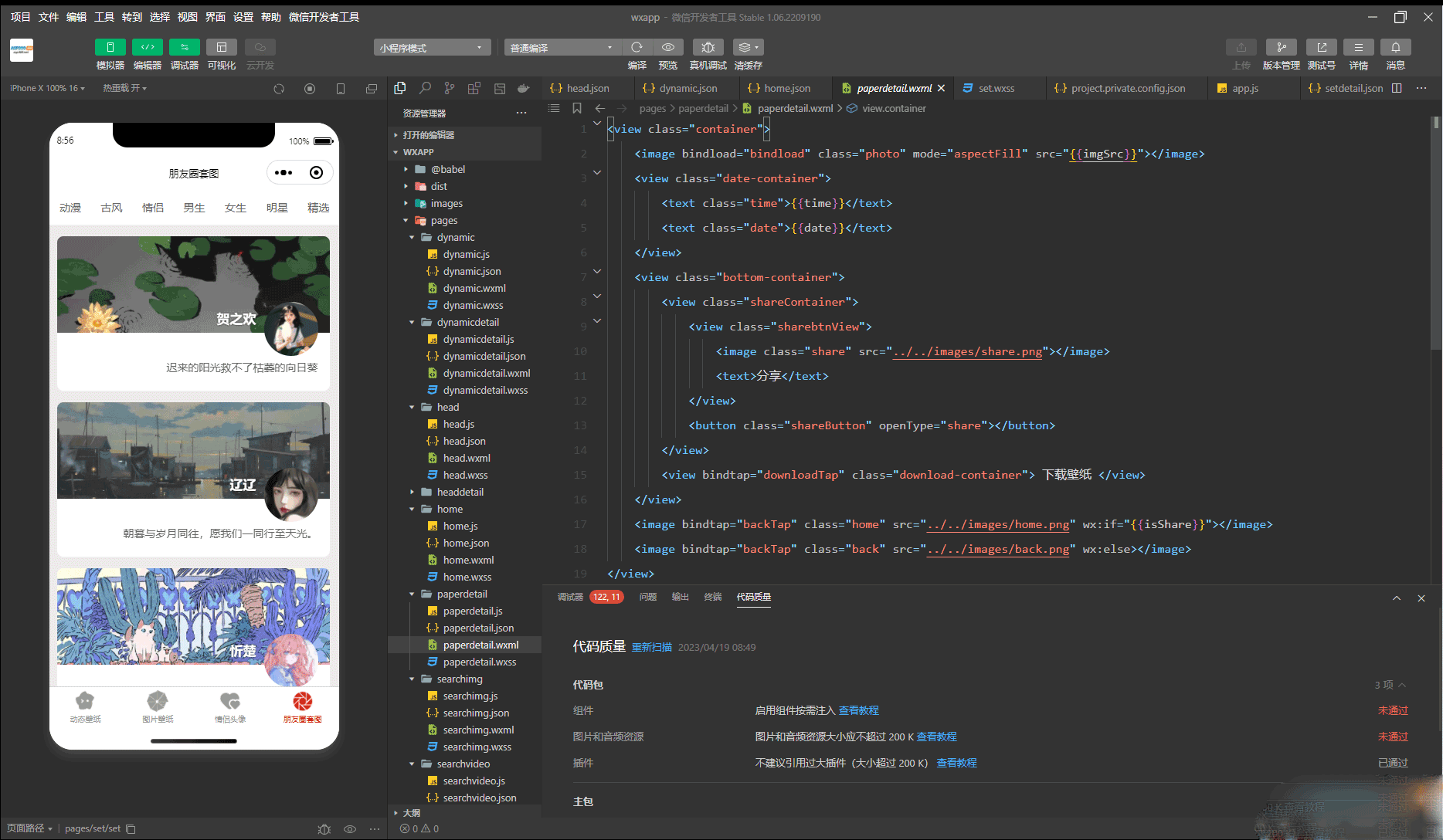

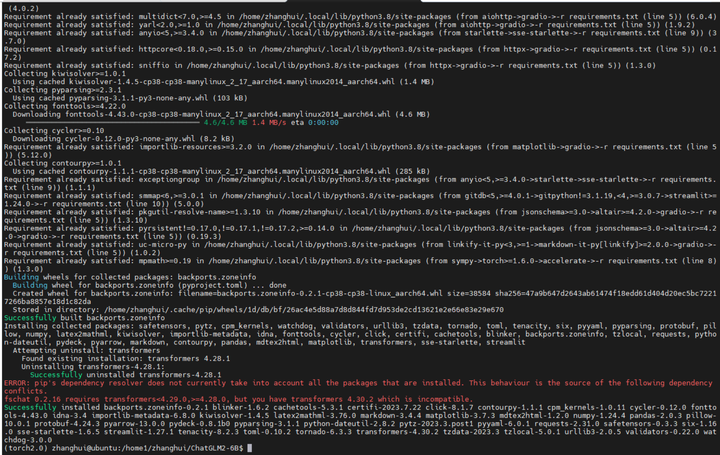

启动基于 Gradio 的网页版 demo

python web_demo.py

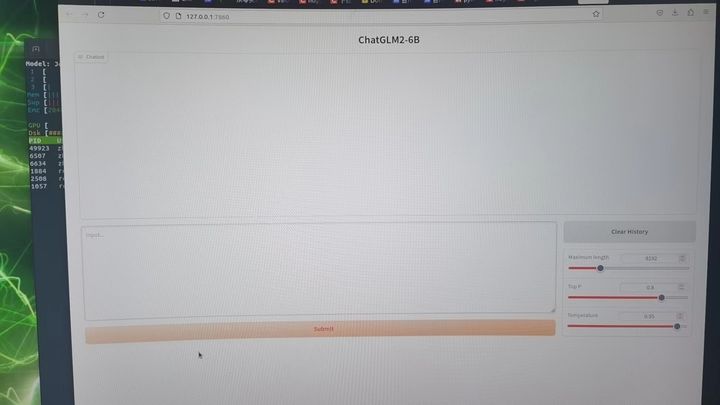

浏览器打开 http://192.168.199.181:7860/

在Jetson Orin的桌面上打开试试:

好像可以的。

提个问题试试:

查看GPU运行情况:

换个问题:

(全文完,谢谢阅读)