💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文目录如下:🎁🎁🎁

目录

💥1 概述

📚2 运行结果

🎉3 参考文献

🌈4 Matlab代码及文章

💥1 概述

文献:

使用不同的相机设置或光谱波段(无论是来自一个或多个传感器)对从单个来源获得的图像进行单独分析都非常困难。为了解决这个问题,通常通过组合图像来创建包含每个源图像中所有独特信息的单个图像,此过程称为图像融合。该文提出一种简单高效的基于像素的图像融合方法,该方法利用高斯滤波对所有源图像中每个像素的边缘信息进行加权,与与相邻图像的距离成正比。使用多模态医学图像、多传感器可见光和红外图像、多焦点图像和多曝光图像对所提出的高斯差异(GD)方法进行了评估,并利用客观融合质量指标与现有的最先进的融合方法进行了比较。通过采用模式搜索(PS)算法进一步增强了GD方法的参数,从而形成了自适应优化策略。大量实验表明,所提出的GD融合方法在客观质量指标和CPU时间消耗方面平均排名优于其他方法。

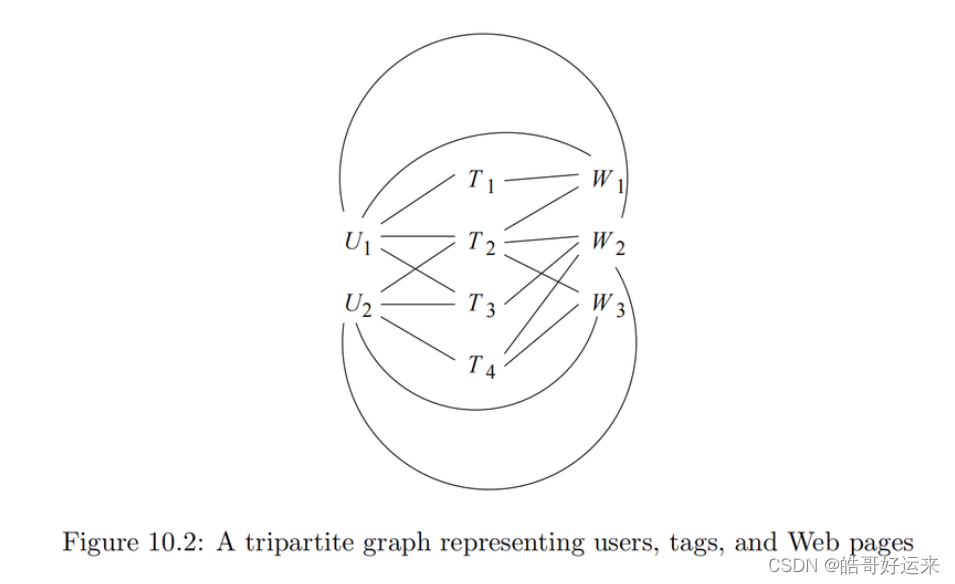

图像融合的目的是将来自多个源图像的互补信息合并为一个统一的图像[1,2,3,4]。在多模态医学图像融合中,将来自不同成像方式的两张或多幅图像组合在一起[5]。磁共振 (MR) 和计算机断层扫描 (CT) 是两种不同的医学成像方式,具有互补的优势和劣势。CT图像具有高空间分辨率,使骨骼更明显,而MR图像具有高对比度分辨率,可显示器官等软组织[6]。可见光和红外图像融合是一种计算技术,它包括来自红外和可见光谱图像的组合信息,以提高物体的可见性并增强图像的对比度,特别是用于增强夜视,遥感和全色锐化[7,8,9,10,11,12].多重曝光图像融合涉及集成多个图像,每个图像以不同的曝光水平捕获,以生成高动态范围(HDR)图像。HDR图像保留了黑暗和明亮区域的细节,从而提高了图像质量,提高了视觉保真度,并改善了计算机视觉任务中的图像分析[13,14]。采用多焦点图像融合将多个具有不同焦距水平的图像合并为单个合成图像[15,16,17,18,19]。这提高了整体清晰度,增强了景深,并增强了视觉感知[20]。这些优势能够在计算机视觉应用中更准确地分析和解释融合图像。

文献中的图像融合方法基本上可以分为两类:像素域和变换域[21]。像素域(或空间域)技术使用源图像的灰度或彩色像素值直接组合源图像。这种技术最著名的例子是源图像的算术平均。算术平均可用于组合多传感器和多焦点图像,但这种方法的最大缺点是降低了图像对比度[22]。多尺度、基于变换的图像融合方法的基本思想是对每个源图像应用多分辨率分解,将分解结果与各种规则相结合,创建统一的表示,最后应用逆多分辨率变换[23]。这些方法的著名例子包括主成分分析(PCA)、离散小波变换(DWT)、拉普拉斯金字塔(LP)和其他基于金字塔的变换[24]。近年来,已经提出了几种基于机器学习和深度学习方法的图像融合算法[3,25,26,27,28]。这些方法稳健,并表现出卓越的性能。然而,训练阶段需要强大的高性能计算系统和大量的输入训练数据。此外,经过训练的模型对于实时应用程序可能非常耗时[29]。

像素级、特征级和决策级是可以进行图像融合的三个层次。像素级融合直接整合源图像的原始数据,产生融合的图像,对计算机处理和人类视觉感知都更具信息性。与其他融合方法相比,该方法致力于提高融合图像的视觉质量和计算效率。Li等人提出了一种基于像素的方法,通过计算源图像中每个像素的像素可见性[30]。Yang和Li提出了一种基于空间频率和形态算子的多焦点图像融合方法[31]。通常,在像素级图像融合中,权重是根据各种像素的活动水平确定的[32]。在这些研究中,使用神经网络[33]和支持向量机[34]来选择具有最显着活动的像素,使用小波系数作为输入特征。Ludusan和Lavialle提出了一种基于误差估计理论和偏微分方程的变分像素图像融合方法,以减轻图像噪声[35]。在[36]中,介绍了一种多曝光图像融合技术,该技术涉及两个主要阶段:计算图像特征,包括局部对比度,亮度和颜色差异,以生成权重图,并使用递归滤波进一步改进。随后,通过使用基于这些精炼的权重图的加权和组合源图像来形成融合图像。除了许多可用的像素级方法外,还提出了使用块[37]或自适应区域[38,39]的基于区域的空间方法,以优于现有方法。

在基于各向异性扩散滤波(ADF)的图像融合算法框架内,通过图像平滑形成权重图层,采用边缘保护方法。这些权重图图层在应用融合规则之前经过后续处理,最终实现最终输出[40]。Kumar引入了交叉二进制滤波器(CBF)方法,该方法考虑了相邻像素的灰度相似性和几何接近性,而无需抗锯齿。使用CBF方法从源图像中提取的详细图像计算的权重,根据加权平均值组合源图像[41]。四阶偏微分方程(FDPE)方法首先将微分方程应用于每个源图像以获得近似图像。然后,使用PCA获得详细图像的最佳权重,然后将其组合以获得最终的详细图像。图像的最终近似是通过对近似图像集执行平均运算得出的。随后,通过将最终近似值与详细图像合并来计算融合图像[42]。基于上下文增强 (GFCE) 的方法保留了可见输入图像和背景场景中的细节。因此,它可以成功地将重要的红外信息传输到合成图像[43]。基于梯度透射和总变异(TV)最小化的梯度转移融合(GTF)方法试图同时保持外观信息和热辐射[44]。混合多尺度分解方法(HMSD)使用双边滤波器和通用高斯方法的组合将源图像分解为非常远的纹理细节和边缘特征。这种偏移使我们能够更好地捕获重要的非常敏感的红外光谱特征,并将精细纹理细节与大边缘分开[45]。红外特征提取和视觉信息保存(IFEVIP)方法提供了红外和可见光图像的简单,快速但有效的融合。首先,利用四叉树分解和贝塞尔插值法对红外背景进行重建;随后,通过从红外图像中减去重建的背景来提取明亮的红外特征,然后进行细化过程以减少冗余的背景信息[46]。多分辨率奇异值分解(MSVD)方法是一种图像融合技术,其基于类似于小波变换的过程,涉及使用低通和高通有限脉冲响应(FIR)滤波器独立滤波信号,然后将每个滤波器的输出抽取两倍以实现第一级分解[47].VSMWLS方法旨在增强重要视觉细节的传输,同时最大限度地减少合并图像中不相关的红外(IR)细节或噪声的包含,该方法代表了一种多尺度融合技术,该技术结合了视觉显著性图(VSM)和加权最小二乘图(WLS)优化[48]。Liu等人提出了一种基于深度卷积神经网络(CNN)的方法,用于红外-可见光图像融合[49]和多焦点图像融合[50]。他们成功了利用暹罗卷积网络,整合来自两张源图像的像素活动信息,构建权重图,解决了图像融合中活动水平测量和权重分配的关键问题[49]。另一方面,由于焦点估计和图像融合是两个不同的问题,传统的图像融合技术有时难以令人满意地执行。Liu等人提出了一种深度学习方法,该方法通过学习源图像和焦点图之间的直接映射来避免单独焦点估计的需要[50]。

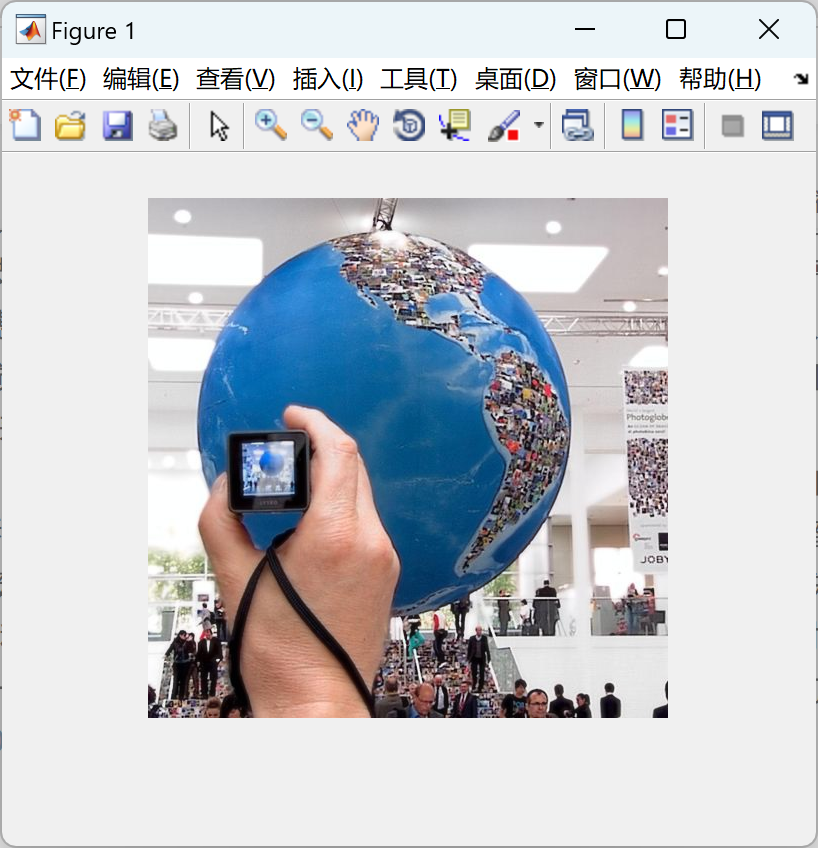

📚2 运行结果

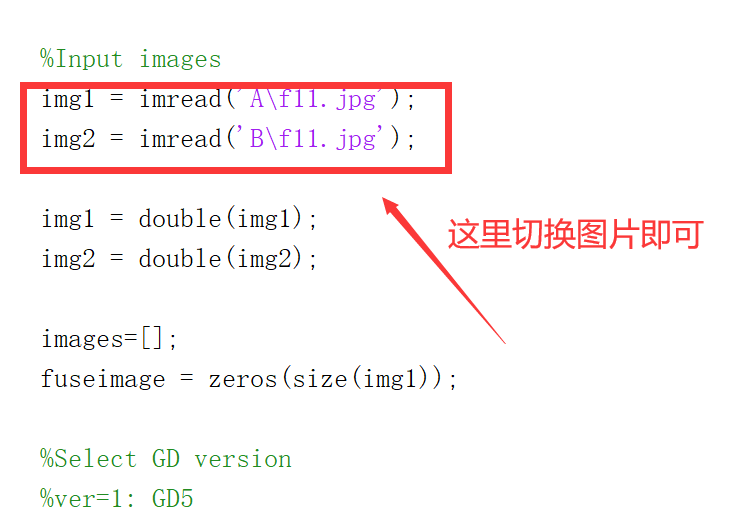

部分代码:

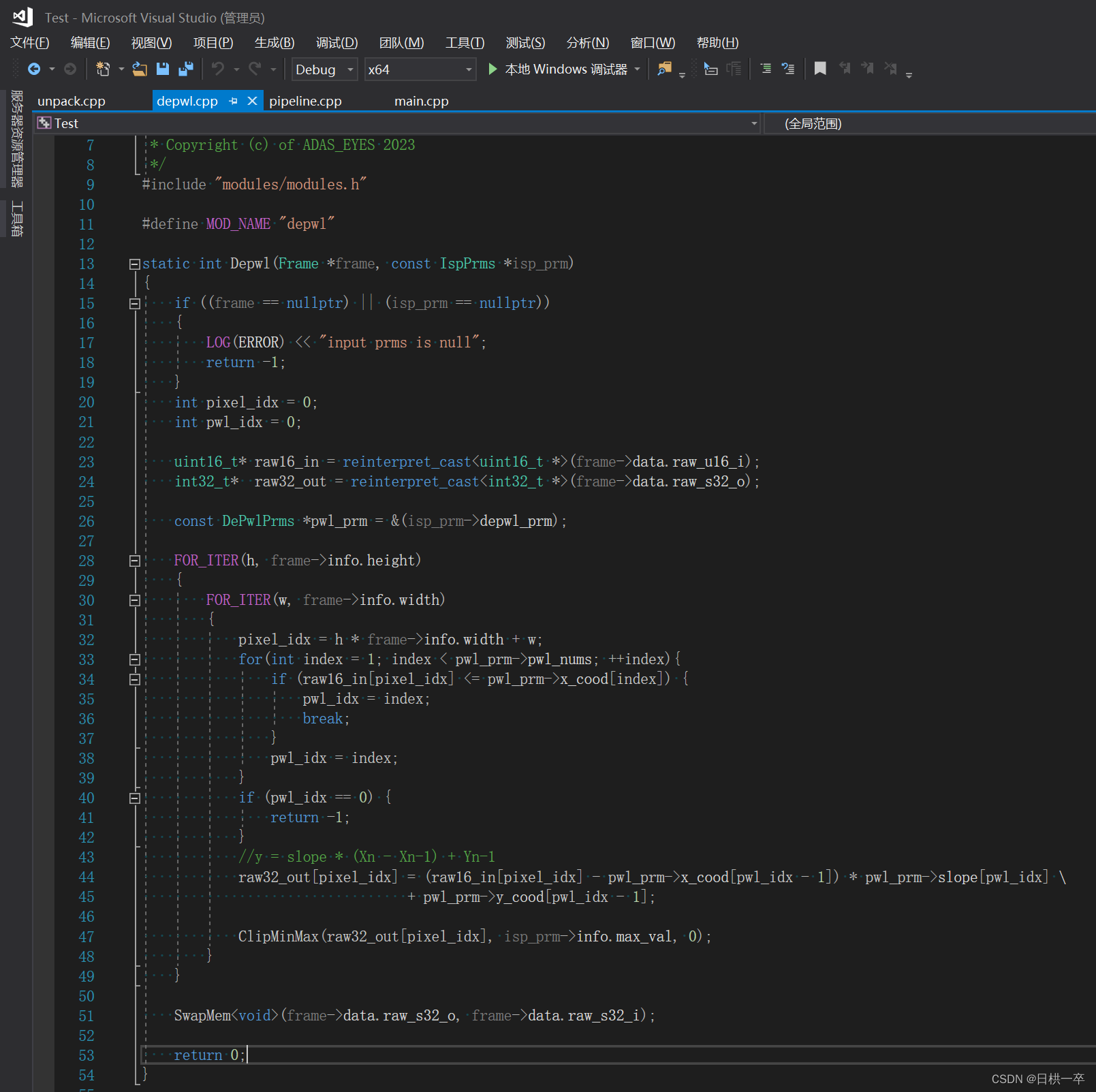

% Gaussian of differences: a simple and efficient general image fusion method

function fuseimage = GD(images,ver)

%ver=1: GD5

%ver=2: GD10

%ver=3: GD15

%ver=4: GDPSQABF

%ver=5: GDPSQCD

%ver=6: GDPSQCV

if ver==1

k=5;

fuseimage = mfiltw(images,k);

elseif ver==2

k=10;

fuseimage = mfiltw(images,k);

elseif ver==3

k=15;

fuseimage = mfiltw(images,k);

elseif ver==4

fitmetric="Qabf";

[fuseimage]=mfiltw_opt(images,fitmetric);

elseif ver==5

fitmetric="Qcb";

[fuseimage]=mfiltw_opt(images,fitmetric);

elseif ver==6

fitmetric="Qcv";

[fuseimage]=mfiltw_opt(images,fitmetric);

end

% Gaussian of differences: a simple and efficient general image fusion method

function fuseimage = GD(images,ver)

%ver=1: GD5

%ver=2: GD10

%ver=3: GD15

%ver=4: GDPSQABF

%ver=5: GDPSQCD

%ver=6: GDPSQCV

if ver==1

k=5;

fuseimage = mfiltw(images,k);

elseif ver==2

k=10;

fuseimage = mfiltw(images,k);

elseif ver==3

k=15;

fuseimage = mfiltw(images,k);

elseif ver==4

fitmetric="Qabf";

[fuseimage]=mfiltw_opt(images,fitmetric);

elseif ver==5

fitmetric="Qcb";

[fuseimage]=mfiltw_opt(images,fitmetric);

elseif ver==6

fitmetric="Qcv";

[fuseimage]=mfiltw_opt(images,fitmetric);

end

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。