©PaperWeekly 原创 · 作者 | 林义杰

单位 | 四川大学

研究方向 | 多模态、多视角学习

论文标题:

Graph Matching with Bi-level Noisy Correspondence

论文地址:

https://arxiv.org/pdf/2212.04085.pdf

开源代码:

https://github.com/XLearning-SCU/2023-ICCV-COMMON

https://github.com/Thinklab-SJTU/ThinkMatch

本篇文章介绍我们发表于 ICCV 2023 的一项图结构匹配工作(Graph Matching with Bi-level Noisy Correspondence),该工作在国际上率先揭示了图匹配问题中可能存在的“双重噪声关联”问题——图像中关键点标注错误导致图结构中同时出现的节点错误关联与边错误关联,并提出相应解决方案。

背景

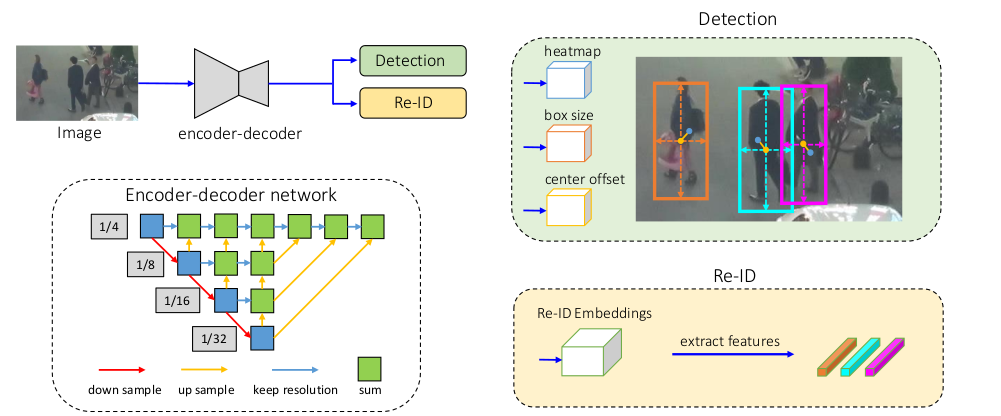

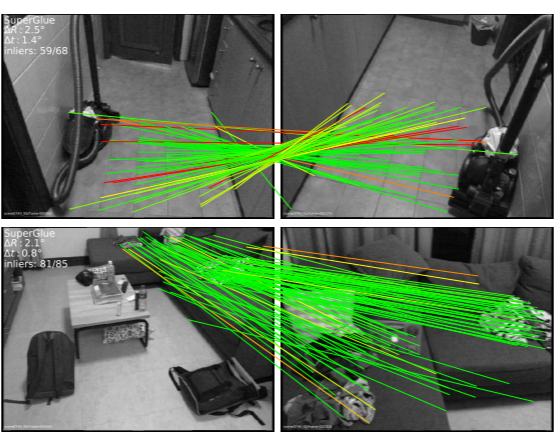

图匹配技术(Graph Matching)广泛应用于各种视觉应用中,如三维重建、目标跟踪、人脸识别等。图匹配算法通过将图像关键点构建为图结构,可实现更鲁棒的特征点配准。基于图匹配方法构建的特征点对应关系,可以拼接与融合不同视角的图像,估计相机姿态、构建三维场景等。

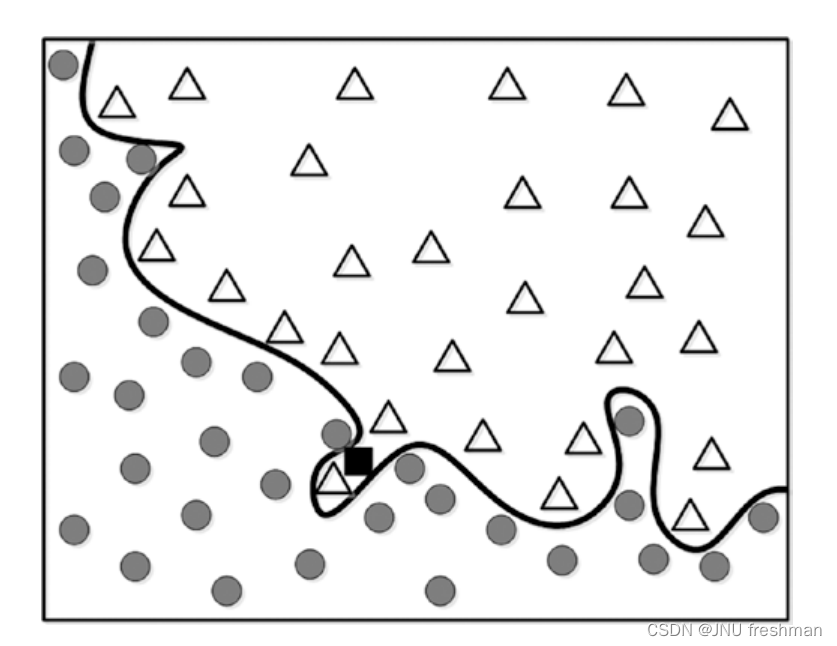

▲ 图1 特征匹配示例

尽管图匹配技术在各种应用中取得了很好的性能,目前的匹配方案高度依赖于完美标注的对齐数据。具体地说,现有的图匹配方法几乎均需通过精准对齐的关键点对来指导训练,但是真实数据中关键点的标注异常困难。实际场景下往往存在图像能见度差、图像间视角差异大、关键点遮挡等问题,导致人为标注的关键点不精准,甚至存在明显错误。

错误标注的特征关键点会产生不同图像间错误的匹配关系,我们将之称为噪声关联(Noisy Correspondence,NC [1-2]),该问题阻碍了现有的图匹配方法的正常训练,最终导致次优甚至错误的匹配结果。目前所有的图匹配方法都忽视了噪声关联对网络训练的影响,难以取得最优的特征匹配性能。由于特征点标注任务繁杂(待标注关键点多、图像能见度差等等),人为标注大量精准的关键点艰巨且不现实。因此,研究和设计能够适用于噪声关联的鲁棒图匹配方法,具备很高的应用前景和实际价值。

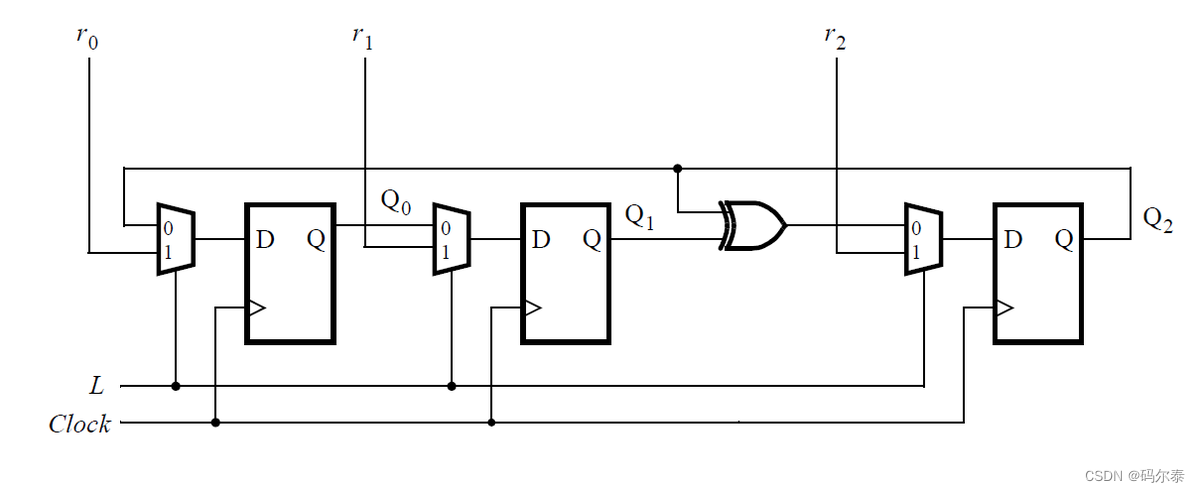

▲ 图2 图匹配中的双重噪声关联问题,以存在视角差异的沙发为例。图中绿色和红色点表示标注正确和错误的关键点,绿色和红色方块表示正确和错误的指派。

创新

一方面,本论文 [3] 在国际上率先揭示了图像特征匹配问题中存在但一直被忽略的重要问题——双重噪声关联(Bi-level Noisy Correspondence, BNC)。如图 2 所示:

1. 由于图像可识别性差和图像间视角差异大,不可避免地会出现一些标注偏移、混淆的关键点,从而导致两个节点之间的不匹配(Node-level Noisy correspondence, NNC);

2. 节点关联噪声问题会进一步污染相对应的边与边之间的关联,从而导致边级别噪声关联(Edge-level noisy correspondence, ENC)。

需要说明的是,图匹配中的噪声关联问题与传统的噪声标签或图文检索中的关联不同。图匹配中对齐关系需要服从一一对应的指派约束,即图 A 中的每个关键点在图 B 中必须具有唯一的对应关系。正所谓“牵一发而动全身”,图匹配中单个结点存在的噪声关联可能会导致全局的对齐失败。

另一方面,为解决双重噪声关联问题,本文提出了一种鲁棒匹配方案——基于动量蒸馏的对比匹配(COntrastive Matching with MOmentum distillation, COMMON)。

该方案包含一个鲁棒的二阶对比损失,其创新点在于1)针对图结构定制化的二阶对比学习损失,可更好地探索节点与节点、边与边的相关性;2)基于动量网络估计得到的置信度自适应地惩罚双重噪声关联,实现鲁棒图匹配。我们在三个特征匹配数据集中进行了验证,较为充分验证了方案对双重噪声关联的鲁棒性。

方法

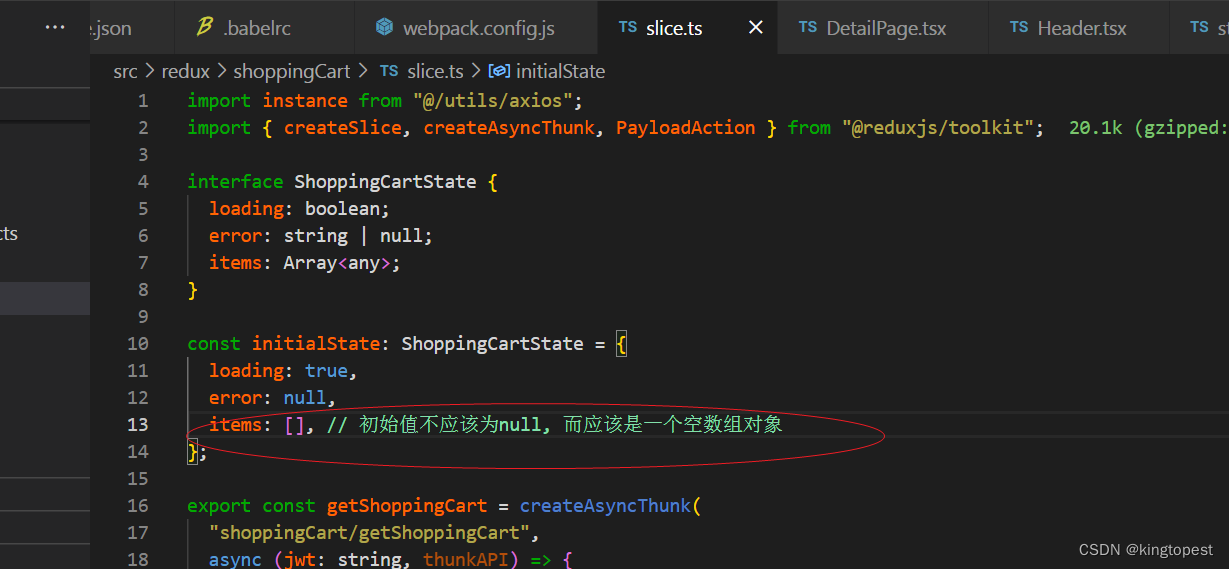

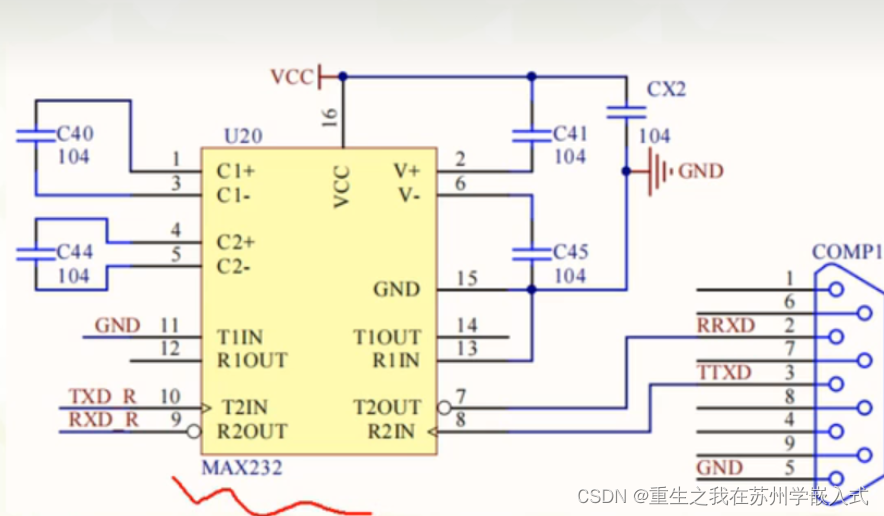

本文提出了一种基于动量蒸馏的对比匹配方案。为更好地探索图结构中的双重相关性,本文提出了一种二阶对比损失,其由三个联合学习目标组成,即对比学习损失、跨图一致性损失和图内一致性损失。为减轻双重噪声关联的影响,方案通过图像输入到动量编码器网络中,利用动量编码器估计的节点和边的置信度自适应地平衡噪声关联。

▲ 图3 算法框架图。图中绿色和红色的点分别表示标注正确和错误的关键点。红色和绿色方块指示噪声关联和相应估计得到的置信度。

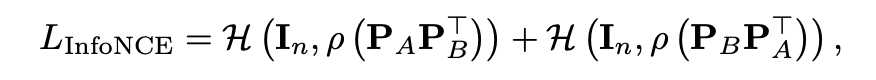

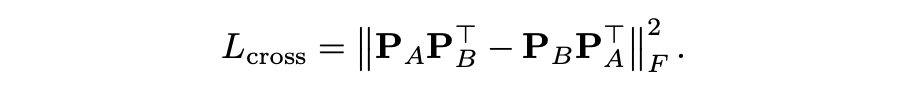

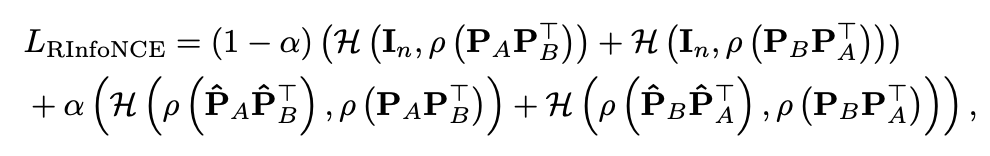

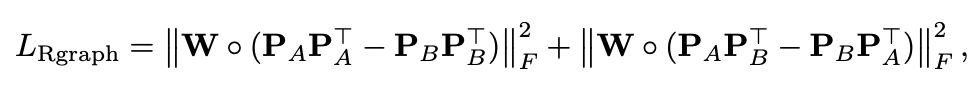

具体地,受近期 Artem 等在 ECCV 2022 [4]上发表的二阶对比学习工作启发,即对比学习算法等价于一阶线性指派问题的求解,其仅考虑到实例间的一阶相关性而忽视了更高阶的关联,我们采用图几何一致性损失来增强对比学习,使其适配图结构的匹配问题。具体地,分别给定图像 A 与图像 B 中的关键点 与 ,所采用的损失函数包含标准对比学习损失 、图内边一致性损失 和跨图边一致性损失 如下所示,

其中 为交叉熵损失函数,

按行归一化的 Softmax 激活函数。如图 3 中图结构样例所示,图内一致性损失尝试最小化图像 A 与图像 B 中的对应边之间的差异,例如 和 。而除了考虑图内边的对齐之外,还应当考虑跨图边的对齐:为了更好地匹配图像之间的关键点,需要消除同类对象之间的语义差异,例如两匹马之间的种类差异。

因此,给定两条对应的图内边(例如 和 ),我们应当期望同一类型的关键点是等价的、可交换的(例如 和 )。因此,我们通过交换图内边上的关键点去构建跨图边,得到 和 ,并最小化跨图边一致性损失进一步增强二阶对齐能力。

进一步,我们通过动量蒸馏算法去缓解双重噪声关联的不利影响。与传统的噪声标签问题不同,图匹配问题是一个多对多的组合优化问题,而不是一对多的分类问题。因而现有的基于数据划分或标签纠正的噪声标签学习方法并不适用于噪声关联。

启发于神经网络的记忆效应(即网络倾向于优先拟合简单的模式,缓慢更新的动量网络可部分缓解对噪声的拟合),我们采用移动指数平均更新方式的动量网络进行蒸馏从而缓解噪声关联。具体地,我们通过动量网络生成的高质量伪对齐目标去平衡二阶对比学习损失:

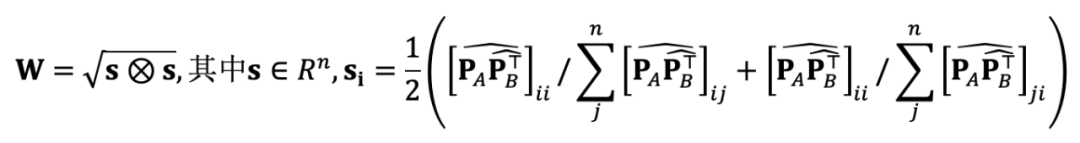

其中 与 是由动量网络得到的关键点特征, 是噪声关联矫正超参数, 是通过动量网络估计得到的边置信度,具体如下,

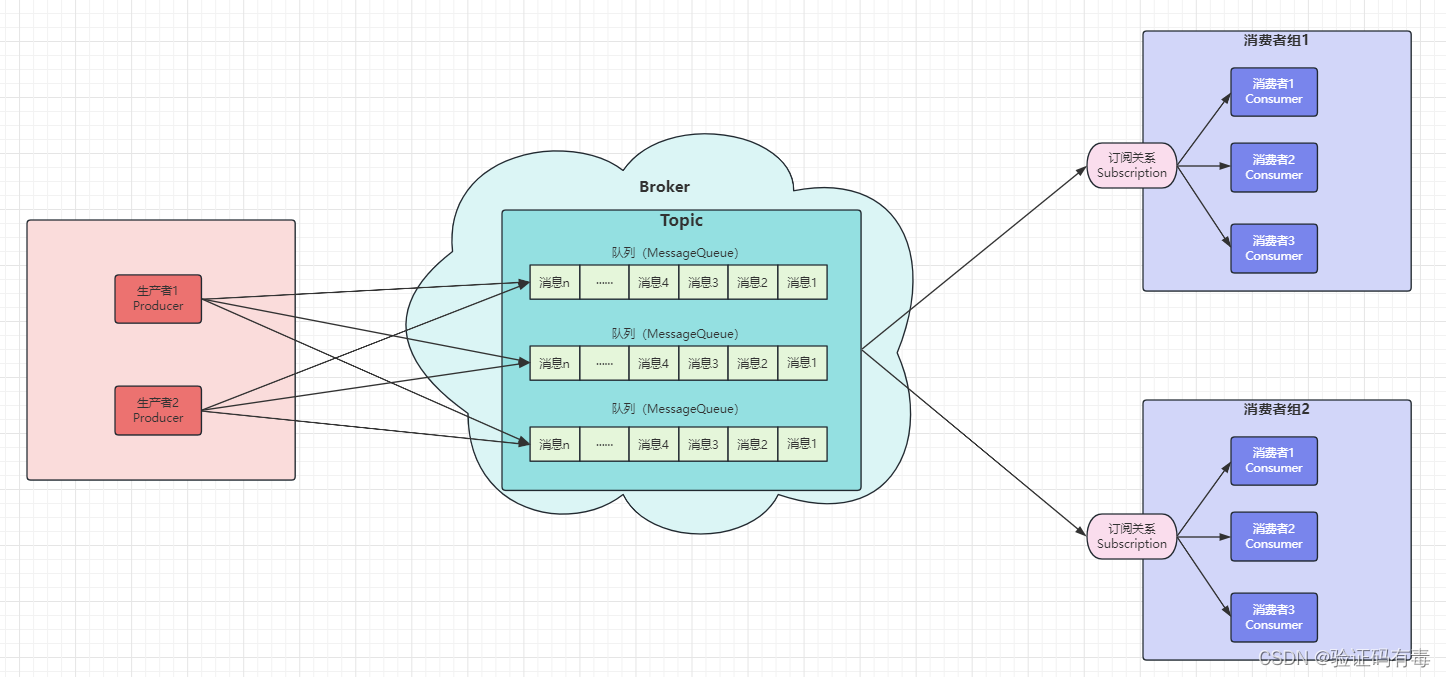

实验

本文在真实场景下的特征匹配数据集 Pascal VOC、SPair-71K、Willow Object Class 上进行了实验,并在 Willow 数据集上通过手动添加关键点扰动模拟噪声,探究方法对噪声关联的有效性。以下展示部分实验结果,更多结果和分析详见原文。

▲ 表1 在Pascal VOC数据集上的匹配性能比较

▲ 表2 在Spair-71k数据集上的匹配性能比较

▲ 图4 针对噪声关联的有效性分析

总结

本文是噪声关联学习 NeurIPS2021 Oral [1]、CVPR2022 [2] 等工作的深入延续。[1] 针对跨模态匹配问题,基于对真实数据集 Conceptual Captions 的观察,揭示了假阳性的错误配对现象,首次正式提出了噪声关联学习的概念和方向,并给出了解决方案。[2] 以跨模态行人重识别任务为应用,揭露了噪声标签和其带来的噪声关联,即孪生噪声标签问题。

本文进一步探索视觉应用中特征匹配问题,揭示了图匹配中低质关键点标注导致的双重噪声关联问题,从不同粒度和层次拓宽了噪声关联问题的外沿。

参考文献

[1] Z. Huang, G. Niu, X. Liu, W. Ding, X. Xiao, H. Wu, and X. Peng*, Learning with Noisy Correspondence for Cross-modal Matching (NeurIPS), Dec 6-12, 2021, Online. (Oral,录用率约0.6%)

[2] M. Yang, Z. Huang, P. Hu, T. Li, J. Lv, X. Peng*, Learning with Twin Noisy Labels for Visible-Infrared Person Re-Identification, IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), New Orleans, LA. Jun. 19-25, 2022.

[3] Y. Lin, M. Yang, J. Yu, P. Hu, C. Zhang, X. Peng*, Graph Matching with Bi-level Noisy Correspondence, International Conference on Computer Vision (ICCV), Paris, France. Oct. 4-6, 2023.

[4] A. Moskalev, I. Sosnovik, V. Fischer, A. Smeulders, Contrasting quadratic assignments for set-based representation learning, European Conference on Computer Vision (ECCV), 2022.

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·