显式构造

隐式构造

loss通常是一个标量

batchsize越小其实越好

回归 预测的是一个连续 softmax回归是一个多分类问题

分类 预测是一个离散值

Huber RoBust Loss, 也就是通常所说SmoothL1损失

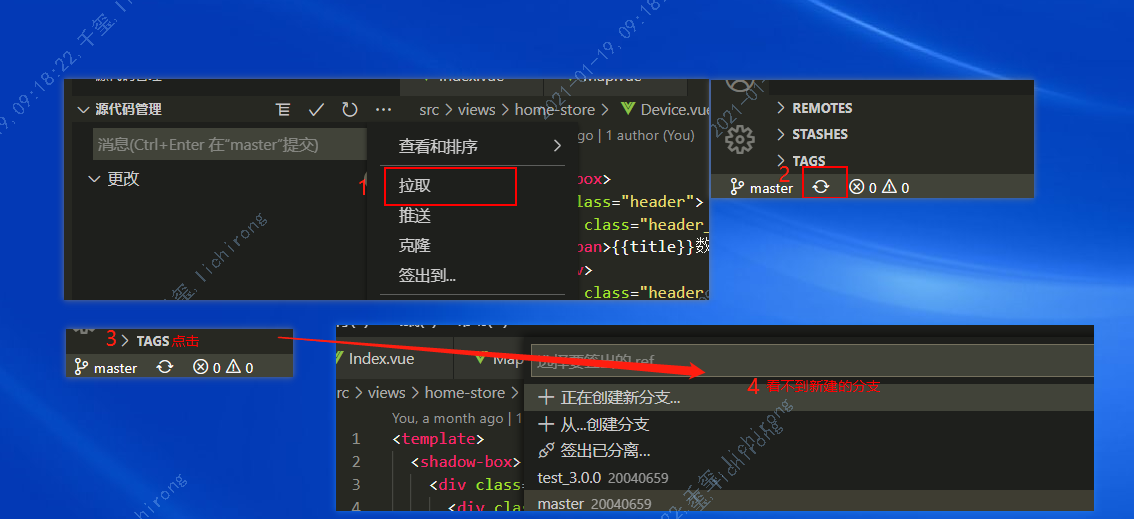

常用命令

import torch

import torchvision

from torchvision import transforms

softmax 实现:

- 对每个项求e的幂

- 对每一行求和

- 将每一项除以每一行的和

logistic 回归

最小化损失函数==最大化似然函数

num_worker 取决于python的实现 进程

CNN 主要学纹理

感知机:二分类 -1或1

只能产生线性分割面,不能解决XOR问题

多层感知机解决

SVM 数学更好

训练误差:模型在训练数据上的误差

泛化误差:模型在新数据上的误差

验证数据集:一个用来评估模型好坏的

测试数据集:只用一次的数据集

K-折交叉验证

求均值 方差

正则化:

1.权重衰退 weight_decay 一般是取1e-3 1e-4

dropout 正则项 不是投票的思想

hintor 胶囊网络

随机种子固定

cudnn 每次算矩阵结果不一样,

数值稳定性常见的两个问题

- 梯度爆炸——16位浮点数(6e-5-6e4)

- 梯度消失

数值过大过小都会导致数值问题

relu 破坏线性

not a number 梯度爆炸

每秒钟计算浮点数———GFlops

显卡 温度

带宽

cuda

两个原则:平移不变性;局部性

卷积超参数:核大小、 步幅、 填充、输出通道数

池化层:缓解卷积对位置的敏感性

LeNet‘ 手写体数字识别 mnist数据集