【引言】

训练样本D和最终测试h的样本都是来自同一个数据分布,这是机器能够 学习的前提。另外,训练样本D应该足够大,且hypothesis set的个数是有限的,这样 根据霍夫丁不等式,才不会出现Bad Data,保证Ein≈Eout,即有很好的泛化能 力。同时,通过训练,得到使Ein最小的h,作为模型最终的矩g,g接近于目标函数。

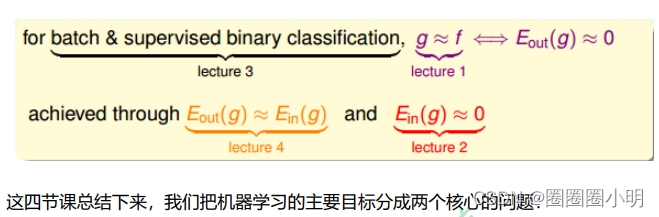

这里,我们总结一下前四节课的主要内容:

第一节课,我们介绍了机器学习的定义, 目标是找出最好的矩g,使g≈f ,保证Eout≈0 ;

第二节课,我们介绍了如何让 Ein≈0,可以使用PLA、pocket等演算法来实现;

第三节课,我们介绍了机器学习 的分类,我们的训练样本是批量数据(batch),处理监督式(supervised)二元分类 (binary classification)问题;

第四节课,我们介绍了机器学习的可行性,通过统计 学知识,把 Ein(g)与 Eout(g)联系起来,证明了在一些条件假设下 Ein(g)≈Eout(g), 成立。

【GPT的解释】

"训练样本D和最终测试h的样本都是来自同一个数据分布,这是机器能够学习的前提。"

- 这句话强调了机器学习的基本假设,即训练数据集(D)和最终要测试的假设(hypothesis)都应该来自相同的数据分布。这意味着模型的训练和测试数据应该具有相似的统计特性,否则模型将无法有效地泛化到新的数据。

"另外,训练样本D应该足够大,且hypothesis set的个数是有限的,这样根据霍夫丁不等式,才不会出现Bad Data,保证Ein≈Eout,即有很好的泛化能力。"

- 这句话强调了两个重要概念: a. 训练样本的大小:训练数据集D应该足够大,以便模型能够捕获数据的真实分布。如果训练集太小,模型可能无法学到足够好的规律。 b. 假设集的有限性:模型的假设集(hypothesis set)应该是有限的,意味着模型的复杂度受限。这有助于避免出现所谓的“Bad Data”,即无法泛化的情况。这也是使用霍夫丁不等式的理论基础,该不等式帮助我们理解训练误差(Ein)与测试误差(Eout)之间的关系。

"同时,通过训练,得到使Ein最小的h,作为模型最终的矩g,g接近于目标函数。"

- 这句话表明,在训练过程中,我们的目标是找到能够最小化训练误差(Ein)的假设h。一旦找到了这个最优假设h,它将被用作最终的模型,代表我们对目标函数(真实数据分布)的估计。这个模型g应该尽可能地接近目标函数。

"这里,我们总结一下前四节课的主要内容:第一节课,我们介绍了机器学习的定义,目标是找出最好的矩g,使g≈f ,保证Eout≈0 ;第二节课,我们介绍了如何让Ein≈0,可以使用PLA、pocket等算法来实现;第三节课,我们介绍了机器学习的分类,我们的训练样本是批量数据(batch),处理监督式二元分类问题;第四节课,我们介绍了机器学习的可行性,通过统计学知识,把 Ein(g)与 Eout(g)联系起来,证明了在一些条件假设下 Ein(g)≈Eout(g),成立。"

- 这句话是对前面提到的内容的总结。它提到了前四节课的主要要点:

- a. 机器学习的定义和目标是找到一个最好的模型g,以使其尽可能接近真实数据分布f,并实现测试误差Eout接近零。

- b. 介绍了一些算法,如PLA(感知器学习算法)和pocket算法,以帮助减小训练误差Ein。

- c. 强调了机器学习通常涉及监督式二元分类问题,其中我们试图将输入数据分为两个类别。

- d. 讨论了机器学习的可行性,以统计学知识为基础,将训练误差Ein与测试误差Eout联系在一起,并在一些条件下证明它们大致相等,这对于泛化很重要。

总的来说,这段话强调了在机器学习中的关键原则,包括数据分布一致性、训练样本大小、模型复杂度控制、最小化训练误差以及模型的泛化能力。这些原则是确保机器学习模型有效性和泛化能力的基础。

GPT的解释:

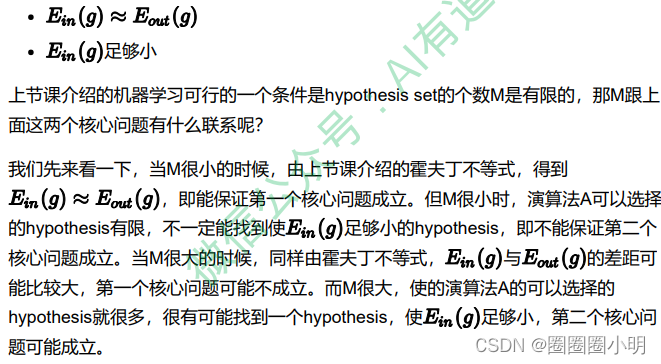

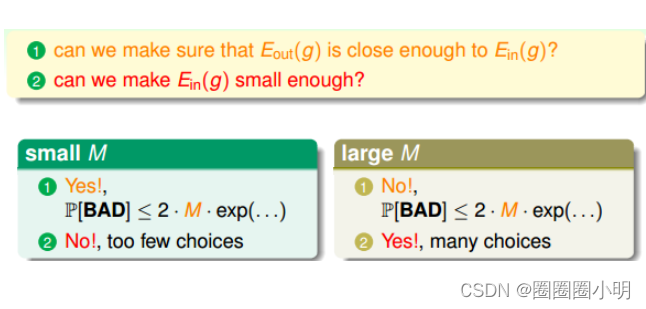

这段话讨论了在机器学习中两个核心问题的关联,即第一个核心问题是让训练误差(Ein)接近测试误差(Eout),第二个核心问题是在模型复杂度适当的情况下找到足够小的Ein。这两个问题都与假设集的大小(M)有关。

1. 当M很小的时候,霍夫丁不等式告诉我们 Ein(g)≈Eout(g)。

- 这意味着如果假设集的大小相对较小,那么训练误差Ein和测试误差Eout之间的差距可能不会很大。这是因为在有限的假设集中,模型可能无法很好地拟合数据的真实分布,因此Ein和Eout都可能较高。

2. 当M很大的时候,Ein(g)与Eout(g)的差距可能比较大。

- 当假设集的大小M很大时,模型有更多的选择,有更多的可能性能够找到一个使Ein足够小的假设。然而,这也增加了过拟合的风险。过拟合是指模型过于复杂,过分地适应了训练数据中的噪声和随机性,导致在新数据上的性能下降。因此,虽然在训练数据上Ein可能很小,但模型在测试数据上的泛化能力可能很差,从而导致Eout增大,Ein与Eout之间的差距变大。

要解决这两个核心问题,需要在假设集大小和模型复杂度之间进行权衡。选择适当的模型复杂度可以确保模型能够很好地拟合数据分布,从而使Ein小,同时也有良好的泛化能力,保证Eout也不会太大。这通常需要使用交叉验证等技术来选择适当的复杂度参数,以平衡这两个核心问题。

从上面的分析来看,M的选择直接影响机器学习两个核心问题是否满足,M不能太大 也不能太小。那么如果M无限大的时候,是否机器就不可以学习了呢?例如PLA算法 中直线是无数条的,但是PLA能够很好地进行机器学习,这又是为什么呢?如果我们 能将无限大的M限定在一个有限的 内,问题似乎就解决了。

![Flask框架-1-[群聊]: flask-socketio实现websocket的功能](https://img-blog.csdnimg.cn/d8335e34937946ae8cd7c9a54f47831f.png)