一、说明

W在训练神经网络时,最常用的算法是反向传播。在该算法中,参数(模型权重)根据损失函数相对于给定参数的梯度进行调整。损失函数计算神经网络产生的预期输出和实际输出之间的差异。

目标是获得尽可能接近零的损失函数的结果。反向传播算法通过神经网络向后遍历,以调整权重和偏差以重新训练模型。这种随着时间的推移重新训练模型的来回和前进过程将损失减少到 0,称为梯度下降。

为了计算这些梯度,PyTorch有一个名为torch.autograd的内置微分引擎。它支持任何计算图的梯度自动计算。

%matplotlib inline

import torch

x = torch.ones(5) # input tensor

y = torch.zeros(3) # expected output

w = torch.randn(5, 3, requires_grad=True)

b = torch.randn(3, requires_grad=True)

z = torch.matmul(x, w)+b

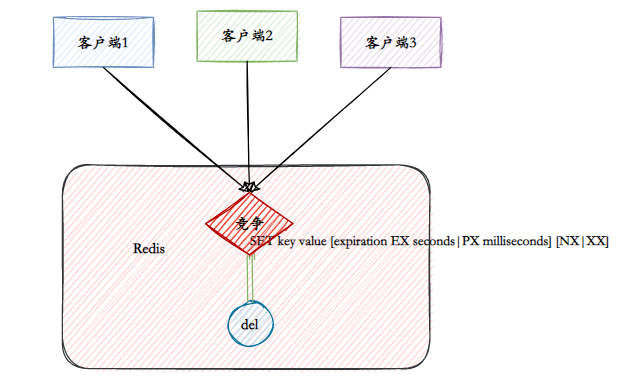

loss = torch.nn.functional.binary_cross_entropy_with_logits(z, y)二、张量、函数和计算图

这段代码定义了以下计算图:

在这个网络中,w和b是我们需要优化的参数。因此,我们需要能够计算损失函数相对于这些变量的梯度。为了做到这一点,我们设置了这些张量的requires_grad属性。

我们应用于张量来构造计算图的函数实际上是一个对象类函数。此对象知道如何在向前方向上计算函数,以及如何在向后传播步骤中计算其导数。对向后传播函数的引用存储在张量的 grad_fn 属性中。

print('Gradient function for z =',z.grad_fn)

print('Gradient function for loss =', loss.grad_fn)Gradient function for z = <AddBackward0 object at 0x00000280CC630CA0>

Gradient function for loss = <BinaryCrossEntropyWithLogitsBackward object at 0x00000280CC630310>三、计算梯度

为了优化神经网络中参数的权重,我们需要计算损失函数相对于参数的导数,即我们需要在x和y的固定值下∂w/∂loss和∂loss/∂b。为了计算这些导数,我们调用 loss.backward(),然后从 w.grad 和 b.grad 中检索值。

loss.backward()

print(w.grad)

print(b.grad)tensor([[0.2739, 0.0490, 0.3279],

[0.2739, 0.0490, 0.3279],

[0.2739, 0.0490, 0.3279],

[0.2739, 0.0490, 0.3279],

[0.2739, 0.0490, 0.3279]])

tensor([0.2739, 0.0490, 0.3279]) 四、禁用渐变跟踪

默认情况下,所有 requires_grad=True 的张量都在跟踪它们的计算历史并支持梯度计算。但是,在某些情况下,我们不需要这样做,例如,当我们训练了模型并只想将其应用于某些输入数据时,即我们只想通过网络进行前向计算。我们可以通过在计算代码周围用 torch.no_grad() 块来停止跟踪计算。

z = torch.matmul(x, w)+b

print(z.requires_grad)

with torch.no_grad():

z = torch.matmul(x, w)+b

print(z.requires_grad)True

False 您可能想要禁用梯度跟踪的原因如下:

- 将神经网络中的某些参数标记为冻结参数。这是微调预训练网络的一种非常常见的方案。

- 在只执行正向传递时加快计算速度,因为对不跟踪梯度的张量的计算会更有效。

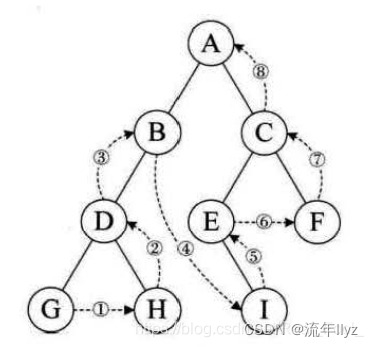

C从概念上讲,Autograd 在由函数对象组成的有向无环图 (DAG) 中记录数据(张量)和所有执行的操作(以及生成的新张量)。在此 DAG 中,叶子是输入张量,根是输出张量。通过跟踪从根到叶的图形,您可以使用链式规则自动计算梯度。

在正向传递中,autograd 同时做两件事:

- 运行请求的操作以计算生成的张量

- 在 DAG 中维护操作的梯度函数

在向后传递中,.back() 在 DAG 根目录上调用。然后,

autograd :- 计算每个.grad_fn

的梯度 - 将它们累积在相应张量的 .grad 属性

中 - 使用链式规则一直传播到叶张量

DAG 在 PyTorch 中是动态的。

需要注意的重要一点是,图形是从头开始重新创建的;每次 .backward() 调用后,Autograd 开始填充一个新图形。这正是允许您在模型中使用控制流语句的原因。

如果需要,您可以在每次迭代时更改形状、大小和操作。

五、张量梯度和雅可比积

在许多情况下,我们有一个标量损失函数,我们需要计算相对于某些参数的梯度。但是,在某些情况下,输出函数是任意张量。在这种情况下,PyTorch 允许您计算所谓的雅可比乘积,而不是实际的梯度。

对于向量函数 y* = f(x*),其中 x* = (x1, ..., xn) 和 y* = (y1, ..., ym),

y* 相对于 x* 的梯度由雅可比矩阵给出,其元素 J 包含 ∂xi/∂yj。

PyTorch 不是计算雅可比矩阵本身,而是允许您计算雅可比乘积。J 对于给定的输入向量 v = (v1, ..., vm)。

这是通过使用 v 作为参数向后调用来实现的。v 的大小应该与原始张量的大小相同,我们想要计算乘积。

inp = torch.eye(5, requires_grad=True)

out = (inp+1).pow(2)

out.backward(torch.ones_like(inp), retain_graph=True)

print("First call\n", inp.grad)

out.backward(torch.ones_like(inp), retain_graph=True)

print("\nSecond call\n", inp.grad)

inp.grad.zero_()

out.backward(torch.ones_like(inp), retain_graph=True)

print("\nCall after zeroing gradients\n", inp.grad)First call

tensor([[4., 2., 2., 2., 2.],

[2., 4., 2., 2., 2.],

[2., 2., 4., 2., 2.],

[2., 2., 2., 4., 2.],

[2., 2., 2., 2., 4.]])

Second call

tensor([[8., 4., 4., 4., 4.],

[4., 8., 4., 4., 4.],

[4., 4., 8., 4., 4.],

[4., 4., 4., 8., 4.],

[4., 4., 4., 4., 8.]])

Call after zeroing gradients

tensor([[4., 2., 2., 2., 2.],

[2., 4., 2., 2., 2.],

[2., 2., 4., 2., 2.],

[2., 2., 2., 4., 2.],

[2., 2., 2., 2., 4.]])请注意,当我们使用相同的参数第二次向后调用时,梯度的值是不同的。发生这种情况是因为在进行向后传播时,PyTorch 会累积梯度,即计算梯度的值被添加到计算图的所有叶节点的 grad 属性中。如果要计算正确的梯度,则需要在之前将 grad 属性归零。在现实生活中的训练中,优化器可以帮助我们做到这一点。