Overview

- StyleDrop

- Summary

- Abstract

- 1 Introduction

- 2 Related Work

- 3 StyleDrop: Style Tuning for Text-to-Image Synthesis

- 3.1 Preliminary: Muse [4], a masked Transformer for Text-to-Image Synthesis

StyleDrop

Summary

题目: StyleDrop: Text-to-Image Generation in Any Style

机构:谷歌

论文: https://arxiv.org/pdf/2306.00983.pdf

代码:未开源代码 https://styledrop.github.io

任务: 图像风格学习

特点:

方法:

前置相关工作:

Abstract

尽管文生图如火如荼,但是如何通过文本生成图像的风格是很难做到的,因为文本本身就具有含糊之处,很难去很好地刻画诸如设计版式,质地,材料等性质。在本文中,我们提出了StyleDrop这样一种方法,能够通过文生图模型很好地进行风格的遵循以及生成。它能够很高效地进行新风格的学习,但只需要finetune非常少的训练参数(<1%),并且通过迭代训练以及人类/自动反馈,进一步提升了生成的质量。更为NB的是,styledrop可以做到仅需要提供一张图像,也能够很好地风格提取以及学习。StyleDrop是基于Muse模型进行试验的,相比于DreamBooth, textual inversion(基于Imagen/SD),取得了更好的效果。

尽管文生图如火如荼,但是如何通过文本生成图像的风格是很难做到的,因为文本本身就具有含糊之处,很难去很好地刻画诸如设计版式,质地,材料等性质。在本文中,我们提出了StyleDrop这样一种方法,能够通过文生图模型很好地进行风格的遵循以及生成。它能够很高效地进行新风格的学习,但只需要finetune非常少的训练参数(<1%),并且通过迭代训练以及人类/自动反馈,进一步提升了生成的质量。更为NB的是,styledrop可以做到仅需要提供一张图像,也能够很好地风格提取以及学习。StyleDrop是基于Muse模型进行试验的,相比于DreamBooth, textual inversion(基于Imagen/SD),取得了更好的效果。

1 Introduction

在大图像和文本对上训练的文本到图像模型能够创建包含许多流派和主题的丰富多样的图像,由此产生的创作引起了轰动,据报道,Midjourney [2] 是世界上最大的 Discord 服务器 [1]。对于著名艺术家的风格,比如梵高,也许能够通过他的作品出现在训练数据中而得以学习,除此之外,流行的一些风格,此外,诸如“动漫”或“蒸汽朋克”之类的流行风格,当添加到输入文本提示时,可以根据训练数据转换为特定的视觉输出。尽管在“prompt engineering”方面投入了大量精力,但由于配色方案、照明和其他特征的细微差别,各种风格很难以文本形式描述。举个例子,梵高有不同风格的画作(例如,图1,顶行,最右边的三列)。因此,简单地说“梵高”的文本提示可能会导致一种特定的风格(随机选择),或者导致几种风格的不可预测的混合。这些都不是理想的结果。

在本文中,我们介绍了 StyleDrop,它能够在给定少量甚至一张风格图像的参考下,进行高水平的风格化文生图。我们的实验(图 1)表明 StyleDrop 在风格化图像合成方面实现了前所未有的准确性和保真度。 StyleDrop 建立在几个关键组件的基础上:

- 基于transformer的文本到图像生成模型: Muse

- Adapter tuning

- 迭代训练以及反馈

对于第一个组件,我们发现 Muse [4](一个对离散视觉token序列进行建模的transformer模型)在从单个图像学习细粒度样式方面表现出优于 Imagen [31] 和 Stable Diffusion [29] 等扩散模型。对于第二个组件,我们采用Adapter tuning[12]来有效地微调大型文本到图像transformer生成模型。具体来说,我们通过组合内容和风格文本描述符来构建风格参考图像的文本输入,以促进内容风格的解耦,这对于组合图像合成至关重要[28, 36]。最后,对于第三个组件,我们提出了一个迭代训练框架,该框架根据从先前训练的adapter采样的图像来训练新的适配器。我们发现,当在一小组高质量合成图像上进行训练时,迭代训练有效地缓解了过度拟合,这是在极少数(例如一个)图像上微调文本到图像模型的普遍问题。我们在第 2 节中使用 CLIP 评分(例如图像文本对齐)和人类反馈来研究高质量样本选择方法。 4.4.3、进一步验证了两者是能够彼此增益的。

2 Related Work

Personalized Text-to-Image Synthesis

个性化文本到图像合成已经被研究,通过利用预先训练的文本到图像模型的力量来编辑个人资产的图像。textual inversion [8] 和hard prompt make easy(PEZ)[34] 找到与对象的一组图像相对应的文本表示(例如,embedding、token),而无需更改文本到图像模型的参数。

DreamBooth [30] 在描述感兴趣主题的一些图像上微调整个文本到图像模型。因此,它更具表现力并以更多细节捕捉主题。采用参数高效微调(PEFT)方法,例如 LoRA [13] 或Adapter tuning [12],可以来提高其效率 [3, 23]。自定义扩散 [17] 和 SVDiff [10] 扩展了 DreamBooth 以同时合成多个主题。不同于基于SD的模型,StyleDrop本身是基于Muse的。

Neural Style Transfer (NST)

StyleDrop 在很多方面与 NST 不同;我们的模型基于文本到图像的模型来生成内容,而 NST 使用图像来指导内容(例如空间结构)进行合成;我们使用adapter来捕获细粒度的视觉样式属性;我们结合反馈信号来改进单个输入图像的风格。

Parameter Efficient Fine Tuning (PEFT)

是一种通过仅调整更少数量的参数而不是整个模型来微调深度学习模型的新范式。这些参数要么是原始训练模型的子集,要么是为微调阶段添加的少量参数。 PEFT 已在大型语言模型 [12,20,13] 的背景下引入,然后通过 LoRA [3] 或Adapter tuning [23] 应用于文本到图像扩散模型 [31, 29]。自回归(AR)[7,38,18]和非自回归(NAR)[5,4,33]生成视觉transformer的微调[32]最近有被研究,但没有文本模态。

3 StyleDrop: Style Tuning for Text-to-Image Synthesis

StyleDrop 构建于 Muse [4] 之上,下面依次按照回顾Muse,对生产式视觉transformer进行PEFT训练,迭代训练 + 反馈来进行后续章节的组织。最后,我们也讨论了如果通过两个fine-tuned模型来进行图像的生成。

3.1 Preliminary: Muse [4], a masked Transformer for Text-to-Image Synthesis

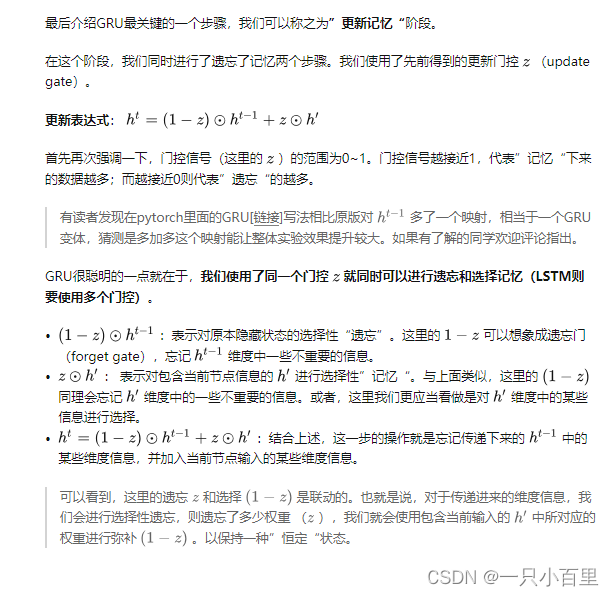

Muse [4] 本是基于MaskGIT [5]的,它包含两个用于基础图像生成的合成模块 (256

×

\times

× 256)和超分辨率(512

×

\times

× 512 或 1024

×

\times

× 1024)。每一个模块,由文本编码器T,一个transformer G,一个采样器S,一个图像编码器E,以及一个图像解码器D组成。T将文本提示词

t

∈

T

t \in T

t∈T编码到连续特征空间

ϵ

\epsilon

ϵ,然后G将文本特征

e

∈

ϵ

e\in \epsilon

e∈ϵ来进行logit

l

∈

L

l \in L

l∈L(用于视觉token序列的生成)。S通过采样序列的视觉tokens

v

∈

V

v \in V

v∈V(从logits迭代解码得到),具体而言就是基于文本编码特征

e

e

e以及从之前steps解码得到的视觉tokens来进行少量步数的transformer推理。最终,D将离散的tokens映射到像素空间

I

I

I。总结下来就行,给定一段文本描述

t

t

t,一张图像通过如下的方式进行生成:

I

=

D

(

S

(

G

,

T

(

t

)

)

,

l

k

=

G

(

v

k

,

T

(

t

)

)

+

λ

(

G

(

v

k

,

T

(

t

)

)

−

G

(

v

k

,

T

(

n

)

)

)

I = D(S(G, T(t)), l_k = G(v_k, T(t)) + \lambda(G(v_k, T(t))-G(v_k, T(n)))

I=D(S(G,T(t)),lk=G(vk,T(t))+λ(G(vk,T(t))−G(vk,T(n)))

其中

n

∈

T

n\in T

n∈T是负面提示词,

λ

\lambda

λ是引导系数,

k

k

k是生成的步数,

l

k

l_k

lk是logits。其中T用的是T5-XXL,E,D用的是VQ-GAN,通过大量的图文对来训练G(基于视觉token建模损失)

其中M是掩码操作,CE_m是weighted 交叉熵(仅基于掩码的tokens)。