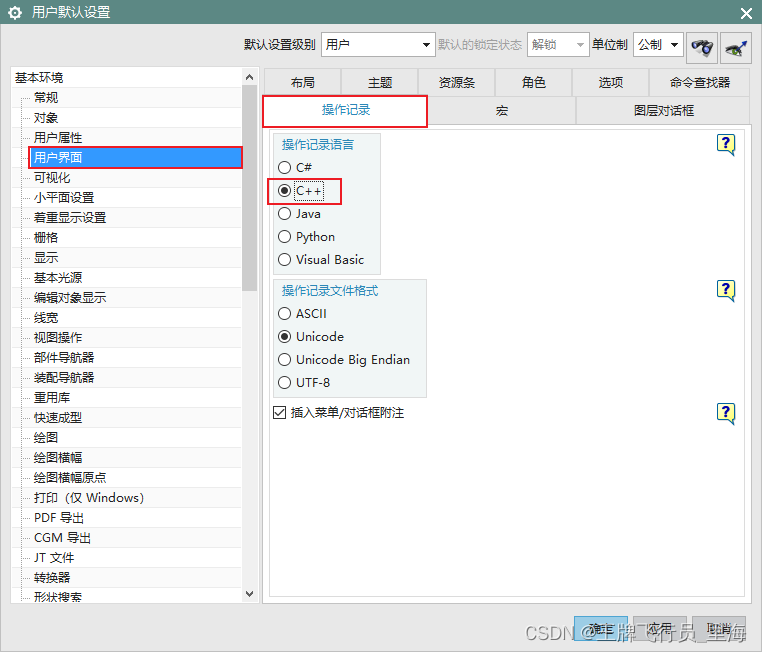

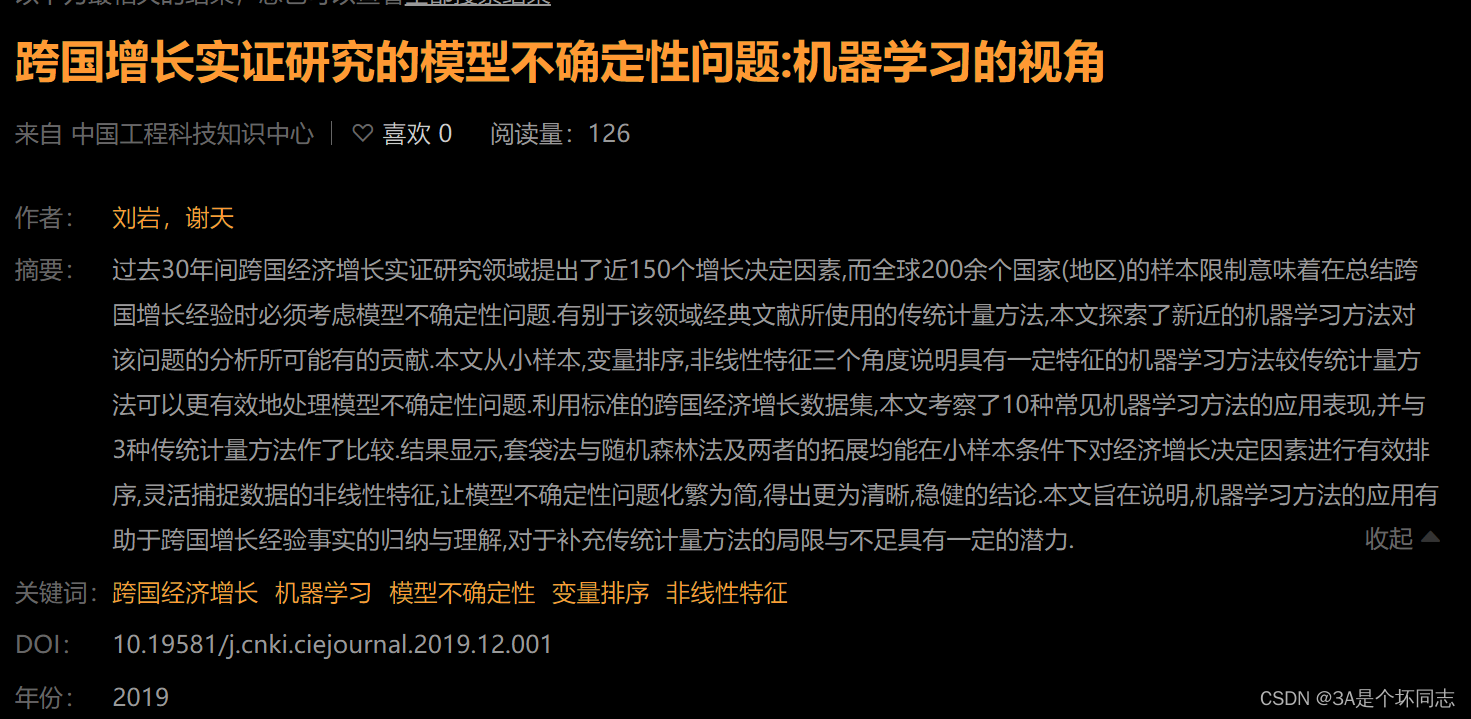

最近有人给我发了篇文章:

一个问题有一堆变量,我们要选取哪些变量来建模呢?我们来看看这篇文章是怎么做的:

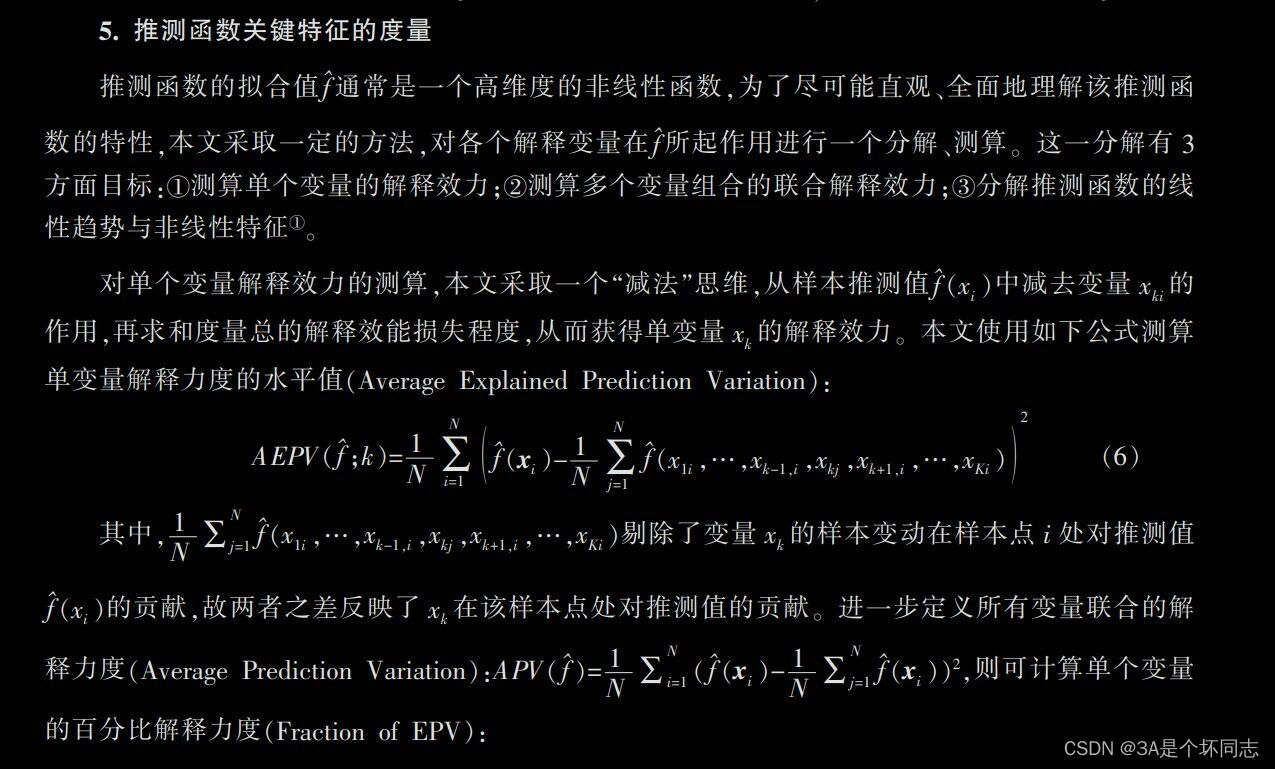

这个方法简单来说就是:对于这一堆变量,我们每次尝试剔除其中一个变量,然后用剩下的变量训练一个新模型。那么,少了一个变量,模型的效果就会有区别,这个区别就是该变量的贡献。最后,我们选出贡献比较大的那些变量,构成我们的最终模型。

这种认识明显是错的。举一个易懂的反例:我们都知道深度模型数据越多上限越高(也就是现在大家说的“涌现”),但同时数据越多也会导致训练难度越高——也就是说,用少量数据训练小模型,和用大量数据训练大模型,在不调参的情况下,很可能前者的效果远远超过后者——如果按这篇文章的说法,那推出的结果就是“大量数据是没用的”,这显然是错的。出现这种现象只是因为少量数据训练的小模型比大量数据训练的大模型下限更高而已。

我这么说之后,有个学经济的同学说我说的不对,这篇文章说的这个方法其实是经济学建模常用的方法“最优子集选择法”——如果你也这么认为,那就说明你既不懂数学上的函数拟合、也不懂经济学上的回归分析。首先,“最优子集选择法”不是用来干这件事的,其次,“最优子集选择法”也不能在这种模型上用。下面我来讲讲为什么。

为什么非线性模型不能用最优子集选择法

大部分人应该是在学习回归分析时接触的最优子集选择法——在使用线性模型进行回归分析时,用这个方法来剔除共线性的解释变量。为什么我们要发现并剔除共线性的变量?因为经济学模型的目的是解释现象,对于线性回归分析,就是要根据拟合后每个自变量的系数来解释它对响应变量的影响。但如果存在两个变量共线性,就会造成一个变量的系数可以被另一个变量吸收。比如A、B两个变量共线,那拟合之后的结果在极端情况可能是100A+0B或100B+0A——但这并不代表其中一个有超大的影响,另一个没有影响,只是因为一个变量的影响被另一个吸收了。对于这种结果,你是无法做出正确解释的。

在这个时候,我们就可以使用最优子集选择法:分别做一个有A无B的模型和有B无A的模型,发现这两个模型从参数到结果都很类似,只不过是第二个模型把第一个模型的A换成了B——这种情况就说明他俩共线性——A和B的背后有一个共同的隐变量,是这个隐变量在对响应变量施加影响。那么我可以继续研究这个隐变量到底是什么。或者分析A和B哪个与那个隐变量更相关,从而选取更好的解释变量。

但是非线性模型就不存在这个问题——你要想一想,为什么线性模型里两个共线变量的参数会互相吸收?这只是因为多项式分配律而已。而非线性模型不是这个多项式形式,所以不会直接出现变量间互相吸收的情况——一个好的非线性模型,即使参数A和参数B有一丁点不一样,它也能把这一丁点不一样分离出来,然后用于预测。所以,对于非线性模型,对预测没有帮助的充分条件是两个变量一模一样[1](这时你一定可以至少去除一个),而并非共线。

基于以上分析,我们再回来看为什么非线性模型不能用最优子集选择法——我前面说了,“最优子集选择法”不是用来干这件事的,这是因为最优子集选择法是在帮助我们排除影响解释的因素,而并非直接让预测结果更好。事实上,对于线性模型,即使解释变量间存在共线性,但只要这些变量都与响应变量线性相关(而没有把无关变量混杂进来),那么它们同时存在也对预测精度没有太大影响。因此使用最优子集选择法的根本目的不是提高预测精度,你也不应该用预测精度作为指标来比较不同的变量子集好坏。“最优子集选择法”也不能在这种模型上用,这是因为非线性模型不需要检测共线性,两个共线性的变量也可能给预测提供有用信息。同时,因为使用不同的变量子集时,模型的最优超参数是不同的,所以,你也不能在不调参的情况下比较两个变量子集的好坏(即本文最开始说的反例)。

为什么最优子集选择法在某些情况下可以提高预测精度

不过,虽然我说“最优子集选择法”不是用来提高预测精度的,因此不应该用预测精度作为指标来比较不同的变量子集好坏,但是很多学经济的同学在实践中确实在用该方法进行变量选择,并获得比较好的模型,这样做为什么可以work呢?

仔细看前文可以发现,我强调两个不同变量子集训练出的模型预测精度无法直接比较的原因是,两个模型的最优超参数是不同的,超参数决定了优化迭代的初值和动力学路径。在不调参的情况下,两个模型在训练时可能一个走的是径直向下的山路,一个走的是凹凸不平的丘陵,显然前者会更快收敛到更好的参数,获得更好的预测精度,但这只是因为二者在训练过程中所走的路径不同,并不能说明前者的数据比后者更好(没有控制变量)。

但是,广义线性模型的最小二乘损失均为凸函数,因此无论你把初值选择在哪个地方,它都会沿着梯度方向收敛到最优参数(事实上这个凸函数的最小值是可以解析求解的,我们平时都是把数据带入这个解析解,直接得到最优参数,不需要进行迭代),因此就消除了超参数这个无法控制的变量——给出一组数据,直接就能得到能达到最好预测精度的最优参数。在这种情况下,预测精度是可以一定程度上说明两组数据的好坏的。

但这是否说明最优子集选择法可以用来提高预测精度呢?我前面已经说了,在使用线性模型时,如果你选取的解释变量全部与响应变量线性相关,那么再用最优子集选择法不会对精度有影响——所以,一些经济学同学使用“最优子集选择法”进行“变量选择”的本质仅仅是使用试错的方法排除了一些相关性较弱的变量而已。事实上,你直接计算一下每个解释变量和响应变量间的线性相关系数,然后进行排除,也可以有类似的结果,而且计算次数还会更少……如果你刻舟求剑,发现这个方法在线性模型上“有效”,然后像这个作者一样在非线性模型上还想用,那就是完全错误了……

最后我吐槽一句:都3202年了,能不能别抱着中文论文不放了?你看这作者犯的错误,他明显就是那种把经济当文科学,基本不懂数学,拿着几个方法到处生搬硬套的——总看这种人的文章,你能有好果汁吃?

[1] T. Liu, S. Zhang and Q. Xiong, "Separated Model for Stopping Point Prediction of Autoregressive Sequence," 2023 IEEE 12th Data Driven Control and Learning Systems Conference (DDCLS), Xiangtan, China, 2023, pp. 799-803, doi: 10.1109/DDCLS58216.2023.10167110.