由算能举办的TPU编程竞赛-AI应用挑战赛正式开赛啦!本次大赛会为选手们提供一个预训练的分割模型UNet及数据集,无需训练模型,选手使用算能的MLIR开源编译器进行编译、量化及调优,兼顾精度与推理速度,最终实现UNet模型在算能1684X芯片上的部署。

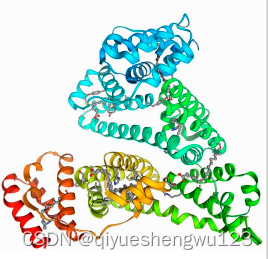

图像分割是图像处理和计算机视觉领域的一个重要课题,广泛应用于场景理解、医学图像分析、机器人感知、视频监控、增强现实和图像压缩等领域,UNet作为经典的神经网络,在图像分割任务中具有大量的应用。

有许多新的方法在此基础上融合改进,基于UNet的模型简单、高效,可以从小数据集中训练就能获得很好的效果,将UNet移植到TPU上可以进一步放大模型的优势,在实际的AI部署中非常有价值。

本次比赛要求使用开源的TPU-MLIR进行编译。TPU-MLIR项目是算能智能AI芯片的TPU编译器工程。该工程提供了一套完整的工具链,其可以将不同框架下预训练的神经网络,转化为可以在算能TPU上高效运算的二进制文件。

TPU编程竞赛作为一个高水平的AI竞赛平台,致力于为国家发现和培育AI算法人才、极致挖掘TPU硬件澎湃算力、用算法和软件的创新解决社会或业务问题,激发开源创新活力,培养开源实践人才,助力开源生态建设。

评估标准

客观部分(0-1.3分)

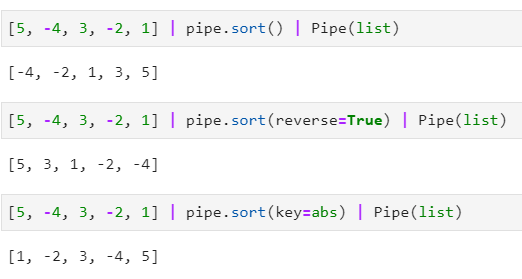

1. 通过dice指标评估模型精度;

2. 通过模型推理时间评估模型性能,单位为秒;

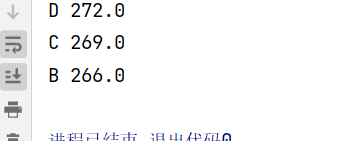

3. 最终得分计算公式为: score = dice_score + (0.3 - time_score),结果将会精确到小数点后三位,例如0.728;

4. 要求精度dice不低于0.85,平均推理延时小于0.3s。

主观部分(0-0.5分)

1. 清楚的描述整个UNet适配过程

a. 步骤详细

b. 结果可复现

2. 给出几个解决问题的过程

a. 列举一下在适配过程中遇到的困难以及解决方法

3. 提出一些TPU-MLIR可以改进的部分

a. 在使用上可以精简的地方

b. 在功能上可以增强的地方(需具备可行性)

4. 介绍一下对TPU-MLIR工程的看法

a. 对MLIR的看法

b. 对TPU-MLIR在DSA相关编译器的看法

c. 对TPU-MLIR在异构计算编译器方面的看法

5. 提交补丁到TPU-MLIR工程(可选,加分项)

a. 可以是文档修正

b. 代码注释

c. 修复bug

减分项:

1. 作品抄袭

2. 伪造测试结果

3. 作品无法复现

4. 过程描述混乱和造假

赛事声明

1. 为了确保整个大赛顺利、公正地进行,以及保证参赛选手的合法权益,参赛选手报名时应阅读和确认大赛官网上的参赛协议,自觉遵守协议规定;

2. 在大赛举办过程中,竞赛规程可能会有少量的变更和调整,所有内容均以大赛官网为准;

3. 本大赛规程的最终解释权归TPU编程竞赛委员会所有。

竞赛链接:基于TPU-MLIR实现UNet模型部署