一、引言

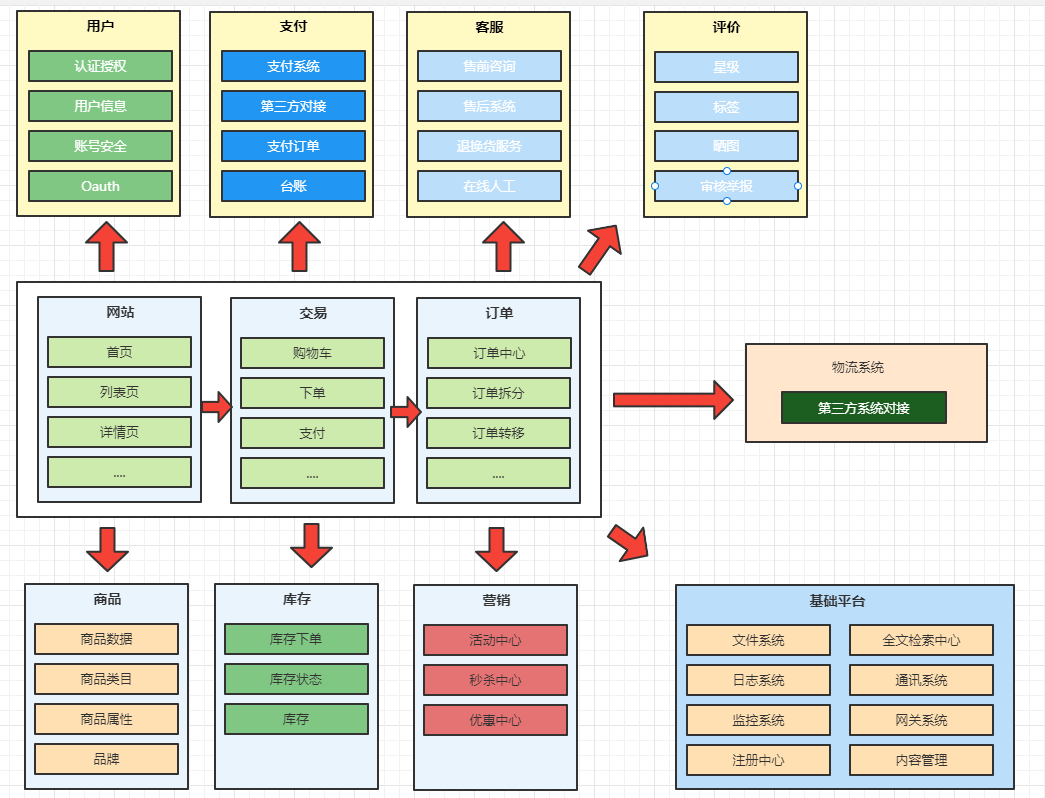

随着信息时代的发展,人们的关注点日益复杂多样。社交媒体、新闻网站和论坛等平台上涌现了大量的信息,这使得热点分析成为了解社会热点话题和舆情动向的重要手段。词频统计是热点分析的基础,本文将分别介绍基于ElasticSearch、基于Spark和基于Python的三种词频统计技术方案。

几种常见的热点词频统计技术方案:

- 基于ElasticSearch的聚合功能: ElasticSearch是一种开源的分布式搜索和分析引擎,具备强大的文本分析和聚合功能。通过使用ElasticSearch的聚合功能,可以对文档中的关键词进行聚合,统计每个关键词的出现次数,从而得到热点词频统计结果。

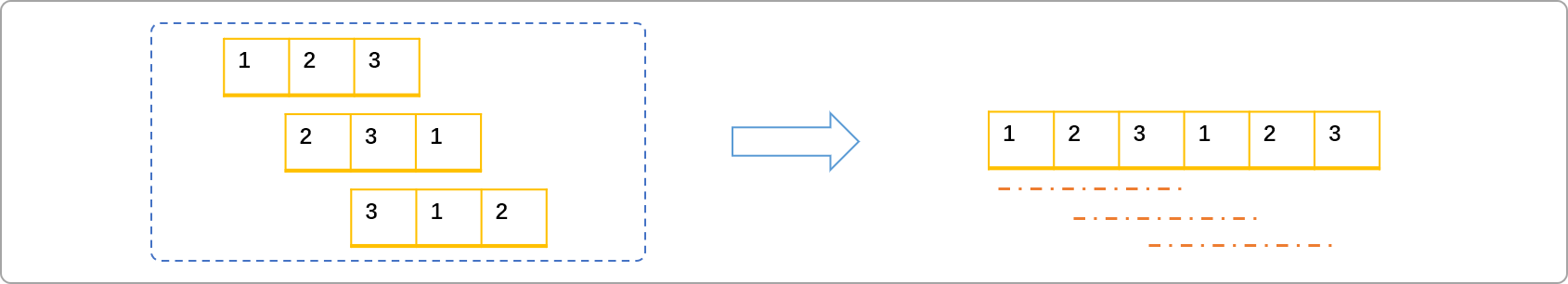

- 基于Spark的分布式计算: Spark是一种基于内存的分布式计算框架,能够高效地处理大规模数据。在Spark中,可以通过MapReduce等算子实现词频统计,从而进行热点词频统计。

- 基于Python的本地计算: 对于小规模的数据集,可以使用Python编程语言进行热点词频统计。Python拥有丰富的文本处理库和工具,能够快速实现简单的词频统计任务。

- 基于自然语言处理(NLP)技术: NLP技术能够从文本中提取关键词、短语和实体等信息,可以帮助实现更加智能化和精准的热点词频统计。NLP技术包括分词、词性标注、命名实体识别等。

- 基于机器学习模型: 通过训练机器学习模型,可以预测和识别出现频率较高的关键词,从而实现热点词频统计。常用的机器学习模型包括朴素贝叶斯、支持向量机(SVM)等。

- 基于深度学习模型: 深度学习模型如循环神经网络(RNN)、长短期记忆网络(LSTM)等能够学习文本中的语义信息,可以帮助更好地理解文本内容,实现更准确的热点词频统计。

二、技术原理

1、热点词频统计

热点词频统计是一种基于文本数据的频次分析方法,用于统计文本中每个单词出现的次数,并按照出现次数降序排列,从而找出频率最高的关键词。这些关键词通常是热点话题的代表,其出现频次反映了社会关注的焦点。以下是热点词频统计的技术原理:

- 文本预处理: 在进行词频统计之前,需要对原始文本进行预处理。预处理包括以下步骤:

- 将文本转换为小写:为了确保大小写不敏感的统计,通常将所有单词转换为小写形式。

- 分词:将文本拆分成单词或词语的序列,这个过程称为分词。分词的方法可以根据实际情况选择,例如基于空格、标点符号或者更复杂的自然语言分词处理技术。

- 构建词频统计表: 将预处理后的文本数据按照单词进行统计,构建一个词频统计表。该表将每个单词作为键,出现的次数作为对应的值,记录了每个单词的频率信息。

- 排序与选取热点词: 对词频统计表按照出现次数降序排列,从频率最高的关键词开始,这些关键词即为热点词。通常情况下,只有少数几个词频最高的单词才会被认为是热点词,因为它们代表了社会话题的核心。

2、中文分词

中文分词是将中文文本切分成一个个独立的词语或词组的过程。由于中文不像英文那样有空格或标点符号来界定词语的边界,因此中文分词是自然语言处理中的一个重要任务。以下是几种常见的中文分词技术:

- 基于规则的分词方法: 这种方法依赖于预先定义的规则和词典来进行分词。将中文文本与词典中的词语进行匹配,如果找到匹配项,则切分出该词语。如果匹配不上,则根据预定义的规则进行切分。这种方法比较简单,但需要手动维护词典和规则,不适用于生僻词等情况。

- 基于统计的分词方法: 这种方法利用统计模型和概率分布来进行分词。常用的方法包括最大匹配法、最大概率分词法和隐马尔可夫模型(HMM)。最大匹配法是一种启发式算法,从文本的左边开始找到最长的匹配词,然后从剩余文本中继续找下一个最长匹配词,直到整个文本被切分完毕。最大概率分词法是基于条件概率计算词的分割点。HMM是一种序列标注模型,通过学习文本中的词语出现概率和相邻词语之间的转移概率来进行分词。

- 基于机器学习的分词方法: 这种方法利用机器学习算法,如条件随机场(CRF)、支持向量机(SVM)和深度学习模型(如循环神经网络)来进行分词。这些模型能够自动学习词语的特征和上下文信息,从而更准确地进行分词。

- 基于字典的分词方法: 这种方法是将中文文本切分成字的序列,然后通过字典匹配的方式将字序列组合成词。这种方法对于未登录词有较好的处理效果,但由于字的组合较多,对于歧义较大的文本有一定挑战。

- 结合多种方法的分词技术: 为了提高分词的准确性,有些分词系统结合了多种方法,如规则+统计、规则+机器学习等。通过综合利用不同方法的优势,可以得到更好的分词结果。

三、实现方案

1、基于ElasticSearch方式

ElasticSearch是一种开源的分布式搜索和分析引擎,它提供了强大的文本分析功能,非常适合进行词频统计和热点分析。

优点:

- 实现简单,只需要配置好ElasticSearch,并将数据导入即可。

- 性能高,ElasticSearch可以利用分布式计算和缓存机制来加速查询和聚合。

- 可扩展性强,ElasticSearch可以动态地增加或减少节点来应对不同的数据量和负载。

缺点:

- 数据预处理较复杂,需要对数据进行分词,过滤,标准化等操作。

- 聚合结果可能不准确,因为ElasticSearch默认使用倒排索引来存储词频,这会导致一些词被忽略或合并。

- 资源消耗较大,ElasticSearch需要占用大量的内存和磁盘空间来存储索引和缓存。

适用于:

- 数据量大,更新频繁,需要实时查询和分析的场景。

- 数据结构简单,不需要复杂的语义分析和处理的场景。

主要有两种实现方式:

方案一:使用ElasticSearch聚合功能实现热点词频统计

该方案主要利用ElasticSearch的聚合功能来实现热点词频统计。通过使用Terms Aggregation将文档中的关键词进行聚合,并统计每个关键词的出现次数,从而得到热点词频统计结果。

public class ElasticSearchAggregationDemo {

public static void main(String[] args) throws IOException {

// 创建RestHighLevelClient客户端

RestHighLevelClient client = new RestHighLevelClient();

// 创建SearchRequest请求

SearchRequest searchRequest = new SearchRequest("your_index_name");

SearchSourceBuilder searchSourceBuilder = new SearchSourceBuilder();

// 设置查询条件,这里假设要查询的字段为"text"

searchSourceBuilder.query(QueryBuilders.matchAllQuery());

// 创建聚合器,使用terms聚合方式

TermsAggregationBuilder aggregation = AggregationBuilders.terms("hot_keywords")

.field("text.keyword"); // 使用.keyword来表示不分词

// 将聚合器添加到查询中

searchSourceBuilder.aggregation(aggregation);

// 设置size为0,表示只获取聚合结果而不获取具体文档

searchSourceBuilder.size(0);

// 将SearchSourceBuilder设置到SearchRequest中

searchRequest.source(searchSourceBuilder);

// 执行搜索请求

SearchResponse searchResponse = client.search(searchRequest, RequestOptions.DEFAULT);

// 获取聚合结果

Terms terms = searchResponse.getAggregations().get("hot_keywords");

for (Terms.Bucket bucket : terms.getBuckets()) {

String keyword = bucket.getKeyAsString();

long docCount = bucket.getDocCount();

System.out.println("Keyword: " + keyword + ", Count: " + docCount);

}

// 关闭客户端

client.close();

}

}方案二:使用ElasticSearch Term Vector功能实现热点词频统计

该方案通过使用ElasticSearch的Term Vector功能,直接获取文档中的词频信息,实现热点词频统计。这种方法可以更细粒度地获取单个文档的词频信息,适用于需要深入分析单个文档的场景。

public class ElasticSearchTermVectorDemo {

public static void main(String[] args) throws IOException {

// 创建RestHighLevelClient客户端

RestHighLevelClient client = new RestHighLevelClient();

// 创建TermVectorsRequest请求

TermVectorsRequest termVectorsRequest = new TermVectorsRequest("your_index_name", "your_document_id");

termVectorsRequest.setFields("text"); // 设置要统计的字段名

// 设置term_statistics为true,表示需要获取词频信息

termVectorsRequest.setTermStatistics(true);

// 执行termvector请求

TermVectorsResponse termVectorsResponse = client.termvectors(termVectorsRequest, RequestOptions.DEFAULT);

// 获取termvector结果

Map<String, Integer> termFreqMap = termVectorsResponse.getTermFreqMap("text");

for (Map.Entry<String, Integer> entry : termFreqMap.entrySet()) {

String term = entry.getKey();

int freq = entry.getValue();

System.out.println("Term: " + term + ", Frequency: " + freq);

}

// 关闭客户端

client.close();

}

}这两种方案都可以实现热点词频统计,具体选择哪种方案取决于实际需求和数据规模。方案一适用于对整个索引或多个文档进行热点词频统计,而方案二适用于深入分析单个文档的词频信息。根据具体场景,可以选择合适的方案或者结合两者使用,以达到更好的分析效果。

2、基于Spark方式

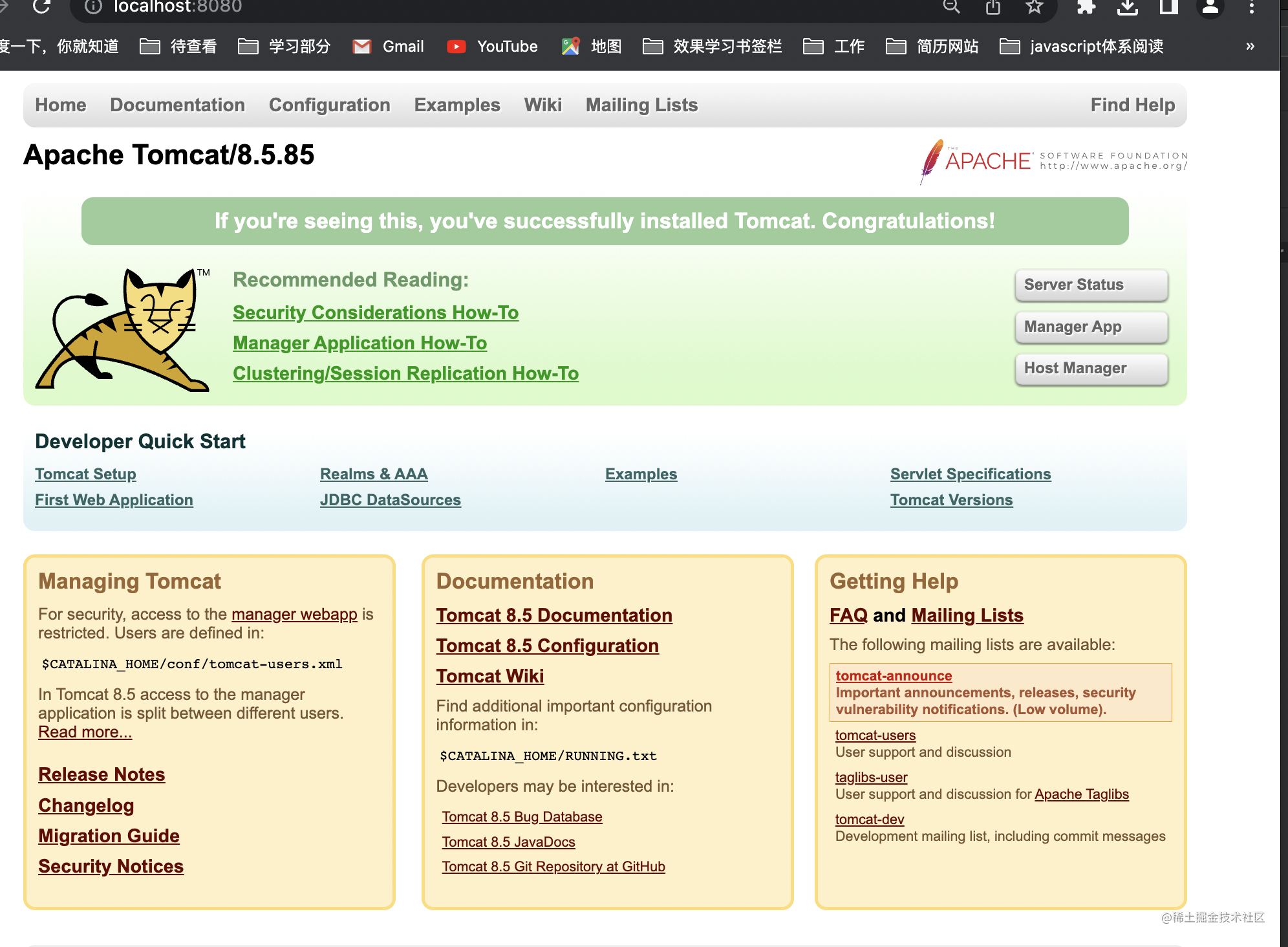

Spark是一种基于内存的分布式计算框架,它能够高效地处理大规模数据。通过Spark,我们可以实现并行处理大量文本数据,进行词频统计和热点分析。

优点:

- 实现灵活,可以使用不同的编程语言(如Java, Scala, Python等)和API(如RDD, DataFrame, Dataset等)来编写Spark应用。

- 性能高,Spark可以利用内存计算和懒加载机制来加速数据处理。

- 可扩展性强,Spark可以动态地调整资源分配和任务调度来应对不同的数据量和负载。

缺点:

- 数据预处理较复杂,需要对数据进行分词,过滤,标准化等操作。

- 资源消耗较大,Spark需要占用大量的内存和CPU资源来执行任务。

适用于:

- 数据量大,更新频繁,需要批处理或流处理的场景。

- 数据结构复杂,需要复杂的语义分析和处理的场景。

具体实现:

Spark官方提供了JavaWordCount的Demo,演示了如何使用Spark进行词频统计。该Demo使用Java编写,但Spark也支持Scala和Python等多种编程语言,具有较高的灵活性和可扩展性。

public class JavaWordCount {

public static void main(String[] args) {

// 创建Spark配置

SparkConf conf = new SparkConf()

.setAppName("JavaWordCount")

.setMaster("local[*]"); // 在本地模式下运行,使用所有可用的CPU核心

// 创建JavaSparkContext

JavaSparkContext sc = new JavaSparkContext(conf);

// 读取文本文件

JavaRDD<String> lines = sc.textFile("input.txt");

// 切分每行文本为单词

JavaRDD<String> words = lines.flatMap(line -> Arrays.asList(line.split(" ")).iterator());

// 转换每个单词为键值对,并计数

JavaPairRDD<String, Integer> wordCounts = words

.mapToPair(word -> new Tuple2<>(word, 1))

.reduceByKey((count1, count2) -> count1 + count2);

// 打印结果

wordCounts.foreach(pair -> System.out.println(pair._1() + ": " + pair._2()));

// 关闭JavaSparkContext

sc.close();

}

}

3、基于Python方式

对于简单的数据词频统计,Python是一种简便高效的方式。Python的代码量通常较少,但它足够应对小规模数据集的热点分析需求。

优点:

- 实现简单,只需要使用Python的标准库或第三方库即可。

- 代码简洁,Python有着优雅的语法和风格,可以用少量的代码实现复杂的功能。

- 适应性强,Python可以与其他语言或工具(如C, Java, R, Excel等)进行交互和集成。

缺点:

- 可扩展性差,Python不支持分布式计算和并行处理,难以应对大规模的数据和负载。

- 兼容性差,Python有着多个版本和实现(如Python 2, Python 3, CPython, PyPy等),它们之间可能存在不兼容的问题。

适用于:

- 数据量小,更新不频繁,不需要实时查询和分析的场景。

- 数据结构简单,不需要复杂的语义分析和处理的场景。

以下是一个基于Python的简单词频统计示例:

text = "http request high client spring boot"

data = text.lower().split()

words = {}

for word in data:

if word not in words:

words[word] = 1

else:

words[word] += 1

result = sorted(words.items(), key=lambda x: x[1], reverse=True)

print(result)四、小结

不同的热点分析技术方案适用于不同的场景。如果处理的数据量较小,且仅需简单的词频统计,Python是最为便捷的选择。对于大规模数据的处理,基于ElasticSearch或Spark的方式更为适合。ElasticSearch提供了强大的文本分析功能,而Spark能够高效地处理分布式计算任务。因此,在选择合适的技术方案时,需要结合实际场景和需求综合考虑。

如果文章对你有帮助,欢迎点赞+关注!