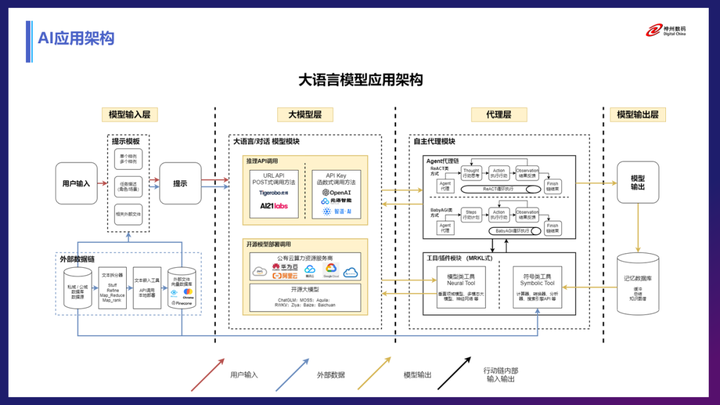

现如今,大模型早已成为街谈巷议的 AI 话题,ChatGPT 更火出了圈。NLP、CV 和多模态领域的大模型层出不穷,并朝着通用方向不断演进,让人们看到了 AGI 的希望。

在大模型时代,除了继续升级预训练、微调等技术和算法之外,构建开源开放的大模型评测体系和生态同等重要。

说来容易,但做起来很难。仅就开源而言,谷歌、OpenAI 等头部 AI 企业对自己的大模型大多并没有开源或仅开放 API 使用,正在逐渐形成壁垒。

在国内,BAT等大型互联网大厂在AI领域正持续发力,关于它们的新闻也是层出不穷。

然而,IEEE Spectrum官网发表的一则消息,却吸引了我的注意。

IEEE Spectrum 是由电气和电子工程师协会(IEEE)发行的一份学术期刊。

该杂志会刊登有关影响商业和社会的技术和科学趋势的同行评审文章。2012 年,IEEE Spectrum 被评为国家杂志奖“杰出思想领袖杂志”类别的获奖者。

大语言模型为什么一定要大?小不可以吗?北京智源人工智能研究院推出的“悟道 3.0”就在小而精上下起了功夫。

作为研究成果,悟道3.0·天鹰是首个具备中英双语知识,支持商用许可协议、国内数据合规需求的开源语言大模型。

这一模型在中英文高质量语料基础上从“0”开始训练,通过数据质量的控制、多种训练的优化方法,实现在更小的数据集、更短的训练时间获得更优的性能。

为什么要缩小模型的规模?

训练成本高昂、芯片被卡脖子、监管变态的严苛,让悟道 2.0这样的大语言模型很难实施下去。最终,他们选择生产参数较小的模型,供国内其它公司使用。

另外,开源相对较小的模型也可能是该公司的战略选择,因为它是一个非营利性研究机构,再训练一个大语言模型的投资回报很低,这样的话,很不划算。

对于较小的开源模型,运行模型输出结果的成本会比较低,可以更容易地商业化。它们特别适用于像医疗聊天机器人之类较为小众的市场。

另外,模型小,训练需要的芯片数也少,在当前芯片短缺的情况下,模型的训练不会受较大影响。

悟道3.0·天鹰模型在国内并没有引起太多关注,可能是因为其参数规模与其他可用的开源模型相似,比如Meta的LLaMA和Llama 2。

为大模型构建基础,通过开源合作促进创新,北京智源正在努力创建一个类似于Linux的开源生态系统。

希望他们再接再历,在人工智能领域上开辟一条道路。

文章来源:

https://spectrum.ieee.org/china-chatgpt-wu-dao