0x0. 前言

本文在对VLLM进行解析时只关注单卡情况,忽略基于ray做分布式推理的所有代码。

0x1. 运行流程梳理

先从使用VLLM调用opt-125M模型进行推理的脚本看起:

from vllm import LLM, SamplingParams

# Sample prompts.

prompts = [

"Hello, my name is",

"The president of the United States is",

"The capital of France is",

"The future of AI is",

]

# Create a sampling params object.

sampling_params = SamplingParams(temperature=0.8, top_p=0.95)

# Create an LLM.

llm = LLM(model="facebook/opt-125m")

# Generate texts from the prompts. The output is a list of RequestOutput objects

# that contain the prompt, generated text, and other information.

outputs = llm.generate(prompts, sampling_params)

# Print the outputs.

for output in outputs:

prompt = output.prompt

generated_text = output.outputs[0].text

print(f"Prompt: {prompt!r}, Generated text: {generated_text!r}")

可以看到这里创建了一个LLM对象,然后调用了LLM对象的generate函数。这就是vllm的入口点,接下来我们对LLM这个类的generaet过程进行解析。首先看一下LLM类的初始化函数:

class LLM:

"""这是一个名为LLM(语言模型)的Python类,这个类用于从给定的提示和采样参数生成文本。

类的主要部分包括tokenizer(用于将输入文本分词)、语言模型(可能分布在多个GPU上执行)

以及为中间状态分配的GPU内存空间(也被称为KV缓存)。给定一批提示和采样参数,

该类将使用智能批处理机制和高效的内存管理从模型中生成文本。

这个类设计用于离线推理。在线服务的话,应使用AsyncLLMEngine类。

对于参数列表,可以参见EngineArgs。

Args:

model: HuggingFace Transformers模型的名称或路径.

tokenizer: HuggingFace Transformers分词器的名称或路径。默认为None。.

tokenizer_mode: 分词器模式。"auto"将使用快速分词器(如果可用),

"slow"将总是使用慢速分词器。默认为"auto"。.

trust_remote_code: 当下载模型和分词器时,是否信任远程代码

(例如,来自HuggingFace的代码)。默认为False。

tensor_parallel_size: 用于分布式执行的GPU数量,使用张量并行性。默认为1。

dtype: 模型权重和激活的数据类型。目前,我们支持float32、float16和bfloat16。

如果是auto,我们使用在模型配置文件中指定的torch_dtype属性。

但是,如果配置中的torch_dtype是float32,我们将使用float16。默认为"auto"。

seed: 初始化采样的随机数生成器的种子。默认为0。

"""

def __init__(

self,

model: str,

tokenizer: Optional[str] = None,

tokenizer_mode: str = "auto",

trust_remote_code: bool = False,

tensor_parallel_size: int = 1,

dtype: str = "auto",

seed: int = 0,

**kwargs, # 其它关键字参数。

) -> None:

# 在初始化函数中,首先检查kwargs中是否包含"disable_log_stats"键,

# 如果没有,则在kwargs中添加该键并设置其值为True。

if "disable_log_stats" not in kwargs:

kwargs["disable_log_stats"] = True

# 使用所有给定的参数(包括通过kwargs传递的任何额外参数)来初始化EngineArgs对象,

# 然后使用这些参数来初始化LLMEngine对象

engine_args = EngineArgs(

model=model,

tokenizer=tokenizer,

tokenizer_mode=tokenizer_mode,

trust_remote_code=trust_remote_code,

tensor_parallel_size=tensor_parallel_size,

dtype=dtype,

seed=seed,

**kwargs,

)

self.llm_engine = LLMEngine.from_engine_args(engine_args)

# 初始化一个名为request_counter的Counter对象,用于请求计数。

self.request_counter = Counter()

可以看到LLM类似于对LLMEngine进行了封装,一个LLM对象对应了一个LLMEngine对象。接下来我们解析一下EngineArgs和LLMEngine,首先来看EngineArgs:

# 这段代码定义了一个名为EngineArgs的Python数据类,该类包含vLLM engine 的所有参数。

@dataclass

class EngineArgs:

"""Arguments for vLLM engine."""

model: str # 字符串类型,指定模型的名称。

tokenizer: Optional[str] = None # 可选的字符串类型,用于指定分词器的名称。

tokenizer_mode: str = 'auto' # 字符串类型,指定分词器的模式。

trust_remote_code: bool = False # 布尔类型,是否信任远程代码。

download_dir: Optional[str] = None # 可选的字符串类型,指定模型和分词器的下载路径。

use_np_weights: bool = False # 布尔类型,是否使用numpy权重。

use_dummy_weights: bool = False # 布尔类型,是否使用虚拟权重。

dtype: str = 'auto' # 字符串类型,指定数据类型。

seed: int = 0 # 整型,用于初始化随机数生成器的种子。

worker_use_ray: bool = False # 布尔类型,worker节点是否使用ray库。

pipeline_parallel_size: int = 1 # 整型,指定流水线并行的大小。

tensor_parallel_size: int = 1 # 整型,指定张量并行的大小。

block_size: int = 16 # 整型,指定block_size的大小。

swap_space: int = 4 # GiB

gpu_memory_utilization: float = 0.90 # 浮点型,指定GPU内存使用率。

max_num_batched_tokens: int = 2560 # 整型,指定最大批量token数。

max_num_seqs: int = 256 # 整型,一个 iteration 最多处理多少个tokens。

disable_log_stats: bool = False # 布尔类型,是否禁用日志统计。

# 它在数据类实例化后立即执行。该函数将tokenizer设置为model(如果tokenizer为None),

# 并将max_num_seqs设置为max_num_seqs和max_num_batched_tokens之间的最小值。

def __post_init__(self):

if self.tokenizer is None:

self.tokenizer = self.model

self.max_num_seqs = min(self.max_num_seqs, self.max_num_batched_tokens)

# 它接受一个argparse.ArgumentParser实例,并添加共享的命令行接口参数。

@staticmethod

def add_cli_args(

parser: argparse.ArgumentParser) -> argparse.ArgumentParser:

"""Shared CLI arguments for vLLM engine."""

...

# 根据命令行接口参数创建EngineArgs实例。

@classmethod

def from_cli_args(cls, args: argparse.Namespace) -> 'EngineArgs':

# Get the list of attributes of this dataclass.

attrs = [attr.name for attr in dataclasses.fields(cls)]

# Set the attributes from the parsed arguments.

engine_args = cls(**{attr: getattr(args, attr) for attr in attrs})

return engine_args

# 根据EngineArgs实例的参数创建一组配置(ModelConfig、CacheConfig、

# ParallelConfig和SchedulerConfig)并返回它们。

def create_engine_configs(

self,

) -> Tuple[ModelConfig, CacheConfig, ParallelConfig, SchedulerConfig]:

# Initialize the configs.

# ModelConfig 包括了对 model 和 tokenizer 的定义,dtype 和随机数 seed

# 以及是否用 pretrained weights 还是 dummy weights 等。

model_config = ModelConfig(self.model, self.tokenizer,

self.tokenizer_mode, self.trust_remote_code,

self.download_dir, self.use_np_weights,

self.use_dummy_weights, self.dtype,

# CacheConfig 包括 block_size(每个 block 多大), gpu_utilization(GPU 利用率,

# 后面 allocate 的时候占多少 GPU)和 swap_space(swap 的空间大小)。

# 默认 block_size=16,swap_space=4GiB。

cache_config = CacheConfig(self.block_size,

self.gpu_memory_utilization,

self.swap_space)

# ParallelConfig 包括了 tensor_parallel_size 和 pipeline_parallel_size,

# 即张量并行和流水线并行的 size

parallel_config = ParallelConfig(self.pipeline_parallel_size,

self.tensor_parallel_size,

self.worker_use_ray)

# SchdulerConfig 包括了 max_num_batched_tokens(一个 iteration 最多处理多少个

# tokens),max_num_seqs(一个 iteration 最多能处理多少数量的 sequences)

# 以及 max_seq_len(最大生成多长的 context length,也就是一个 sequence 的最长长度,

# 包含 prompt 部分和 generated 部分)。

scheduler_config = SchedulerConfig(self.max_num_batched_tokens,

self.max_num_seqs,

model_config.get_max_model_len())

return model_config, cache_config, parallel_config, scheduler_config

接下来对LLMEngine进行解析:

class LLMEngine:

"""这段代码定义了一个名为 LLMEngine 的类,它是一个接收请求并生成文本的语言模型(LLM)引擎。

这个类是vLLM引擎的主要类,它从客户端接收请求,并从LLM生成文本。

这个类包含了一个分词器,一个语言模型(可能在多个GPU之间切分),

以及为中间状态(也称为KV缓存)分配的GPU内存空间。

此类使用了迭代级别的调度和有效的内存管理来最大化服务吞吐量。

LLM 类将此类封装用于离线批量推理,而 AsyncLLMEngine 类将此类封装用于在线服务

注意:配置参数源自 EngineArgs 类。有关参数的完整列表,请参见 EngineArgs。

Args:

model_config: 与LLM模型相关的配置。

cache_config: 与KV缓存内存管理相关的配置。

parallel_config: 与分布式执行相关的配置。

scheduler_config: 与分布式执行相关的配置。

distributed_init_method: 分布式执行的初始化方法,参见torch.distributed.init_process_group了解详情。

stage_devices: 每个stage的设备列表. 每个stage都是一个(rank, node_resource, device)元组.

log_stats: 是否记录统计数据。

"""

def __init__(

self,

model_config: ModelConfig,

cache_config: CacheConfig,

parallel_config: ParallelConfig,

scheduler_config: SchedulerConfig,

distributed_init_method: str,

placement_group: Optional["PlacementGroup"],

log_stats: bool,

) -> None:

logger.info(

"Initializing an LLM engine with config: "

f"model={model_config.model!r}, "

f"tokenizer={model_config.tokenizer!r}, "

f"tokenizer_mode={model_config.tokenizer_mode}, "

f"trust_remote_code={model_config.trust_remote_code}, "

f"dtype={model_config.dtype}, "

f"use_dummy_weights={model_config.use_dummy_weights}, "

f"download_dir={model_config.download_dir!r}, "

f"use_np_weights={model_config.use_np_weights}, "

f"tensor_parallel_size={parallel_config.tensor_parallel_size}, "

f"seed={model_config.seed})")

# TODO(woosuk): Print more configs in debug mode.

self.model_config = model_config

self.cache_config = cache_config

self.parallel_config = parallel_config

self.scheduler_config = scheduler_config

self.log_stats = log_stats

self._verify_args()

# 设置tokenizer

self.tokenizer = get_tokenizer(

model_config.tokenizer,

tokenizer_mode=model_config.tokenizer_mode,

trust_remote_code=model_config.trust_remote_code)

self.seq_counter = Counter()

# 对于每个 device(也即每张卡 / 每个 rank)创建一个 Worker。

# Worker 是运行 model 的单位。一个 Engine 管理所有的 workers。

# Create the parallel GPU workers.

if self.parallel_config.worker_use_ray:

self._init_workers_ray(placement_group)

else:

self._init_workers(distributed_init_method)

# 初始化这个 engine 的 KV cache。

# Profile the memory usage and initialize the cache.

self._init_cache()

# Create the scheduler.

self.scheduler = Scheduler(scheduler_config, cache_config)

# Logging.

self.last_logging_time = 0.0

# List of (timestamp, num_tokens)

self.num_prompt_tokens: List[Tuple[float, int]] = []

# List of (timestamp, num_tokens)

self.num_generation_tokens: List[Tuple[float, int]] = []

从LLMEngine的定义可以知道,它做了初始化tokenizer,创建并行的worker信息以及初始化KV Cache等事情,这里的worker是每个GPU对应一个,我们稍后会讲到。我们接着解析一下LLMEngine其它函数:

# _init_workers 这个方法是 LLMEngine 类的一个私有方法,其主要目的是初始化worker。

# 这些worker负责在硬件资源(如GPU)上执行计算任务。

# 这个函数只接受一个参数,即 distributed_init_method,它是一个字符串,用于指定分布式执行的初始化方法。

def _init_workers(self, distributed_init_method: str):

# 从vllm.worker.worker模块中导入Worker类。这个导入操作被放在了函数内部,

# 这样做的目的是为了避免在CUDA_VISIBLE_DEVICES被Worker类设定之前就导入

# 了torch.cuda/xformers,因为那样可能会产生问题。

from vllm.worker.worker import Worker # pylint: disable=import-outside-toplevel

# 断言self.parallel_config.world_size(并行世界的大小)等于1,如果不等于1,

# 则会抛出错误,提示用户需要使用Ray框架进行并行计算。

assert self.parallel_config.world_size == 1, (

"Ray is required if parallel_config.world_size > 1.")

self.workers: List[Worker] = []

# 创建一个新的 Worker 对象,并将其添加到 self.workers 列表中。

# 每个 Worker 对象都需要以下参数:

# self.model_config,self.parallel_config,self.scheduler_config,

# 以及工作节点的 rank(在这个例子中,rank 是0,表示这是第一个,也是唯一的工作节点)

# 和 distributed_init_method。

worker = Worker(

self.model_config,

self.parallel_config,

self.scheduler_config,

0,

distributed_init_method,

)

# 调用_run_workers方法,参数为 "init_model"

# 和 get_all_outputs=True,对所有的worker进行初始化。

self.workers.append(worker)

self._run_workers(

"init_model",

get_all_outputs=True,

)

def _verify_args(self) -> None:

# 这行代码调用model_config对象的verify_with_parallel_config方法来检查模型配置是否与并行配置兼容。

# self.model_config和self.parallel_config分别是ModelConfig和ParallelConfig对象,

# 它们包含了模型和并行计算的相关配置。

self.model_config.verify_with_parallel_config(self.parallel_config)

self.cache_config.verify_with_parallel_config(self.parallel_config)

# _init_cache函数是LLMEngine类的一个私有方法,不接受任何参数,没有返回值。

# 其目标是测量内存使用并初始化KV(键值)Cache。

def _init_cache(self) -> None:

"""Profiles the memory usage and initializes the KV cache."""

# Get the maximum number of blocks that can be allocated on GPU and CPU.

# 使用_run_workers方法来获取可以在GPU和CPU上分配的最大块数量。

# _run_workers函数执行的方法是profile_num_available_blocks,并且提供了如块大小、

# GPU内存使用率和CPU交换空间等参数,所有这些参数都是从cache_config对象中提取出来的。

num_blocks = self._run_workers(

"profile_num_available_blocks",

get_all_outputs=True,

block_size=self.cache_config.block_size,

gpu_memory_utilization=self.cache_config.gpu_memory_utilization,

cpu_swap_space=self.cache_config.swap_space_bytes,

)

# 找到所有workers中可用块的最小值,以确保所有的内存操作都可以应用到所有worker。

# 在这个步骤中,函数分别计算了GPU和CPU的块数量。

num_gpu_blocks = min(b[0] for b in num_blocks)

num_cpu_blocks = min(b[1] for b in num_blocks)

# FIXME(woosuk): Change to debug log.

logger.info(f"# GPU blocks: {num_gpu_blocks}, "

f"# CPU blocks: {num_cpu_blocks}")

# 如果GPU的块数量小于等于0,函数将抛出一个值错误。

# 这是为了确保在初始化引擎时,为缓存块提供足够的可用内存。

if num_gpu_blocks <= 0:

raise ValueError("No available memory for the cache blocks. "

"Try increasing `gpu_memory_utilization` when "

"initializing the engine.")

# 根据计算的块数量,更新cache_config对象的num_gpu_blocks和num_cpu_blocks属性。

self.cache_config.num_gpu_blocks = num_gpu_blocks

self.cache_config.num_cpu_blocks = num_cpu_blocks

# Initialize the cache.

# 使用_run_workers方法初始化缓存。此步骤中的_run_workers执行的方法

# 是init_cache_engine,并且提供了cache_config对象作为参数。

self._run_workers("init_cache_engine", cache_config=self.cache_config)

# from_engine_args是一个类方法(classmethod),这意味着它可以在没有创建类实例的情况下调用。

# 此方法需要接受一个EngineArgs类型的参数engine_args,并返回一个LLMEngine类型的对象。

@classmethod

def from_engine_args(cls, engine_args: EngineArgs) -> "LLMEngine":

"""Creates an LLM engine from the engine arguments."""

# Create the engine configs.

# 利用create_engine_configs方法从engine_args参数中创建引擎配置,该方法返回一个配置的列表,

# 其中包含了model_config、cache_config、parallel_config和scheduler_config。

# 这些配置都是初始化LLMEngine对象所需的。

engine_configs = engine_args.create_engine_configs()

# 提取并保存parallel_config,这是一个关于分布式执行的配置。

parallel_config = engine_configs[2]

# 使用initialize_cluster方法初始化集群,该方法接受parallel_config作为参数并返回两个结果:

# distributed_init_method(分布式执行的初始化方法)和placement_group。

distributed_init_method, placement_group = initialize_cluster(

parallel_config)

# 利用之前创建的引擎配置、初始化方法、放置组以及日志统计设置来创建一个新的LLMEngine对象。

# 这里使用了Python的*操作符,这样可以把列表中的每个元素分别作为单独的参数传递给LLMEngine类

# 的构造方法。log_stats参数用于决定是否需要记录统计数据,如果engine_args.disable_log_stats

# 为True,则不记录统计数据。

engine = cls(*engine_configs,

distributed_init_method,

placement_group,

log_stats=not engine_args.disable_log_stats)

return engine

# add_request函数是LLMEngine类的一个方法,它接受一个请求并将其加入到scheduler的请求池中。

# 这个请求在调用engine.step()函数时由调度器进行处理,具体的调度策略由调度器决定。

def add_request(

self,

request_id: str, # 请求的唯一ID。

prompt: Optional[str], # prompt字符串。如果提供了prompt_token_ids,这个参数可以为None。

sampling_params: SamplingParams, # 用于文本生成的采样参数。

# prompt的token ID。如果它为None,则使用分词器将提示转换为token ID。

prompt_token_ids: Optional[List[int]] = None,

arrival_time: Optional[float] = None, # 请求的到达时间。如果为None,则使用当前时间。

) -> None:

if arrival_time is None:

arrival_time = time.time()

if prompt_token_ids is None:

assert prompt is not None

prompt_token_ids = self.tokenizer.encode(prompt)

# Create the sequences.

# 每一个序列代表一次独立的文本生成任务。它们的数量由sampling_params.best_of决定。

# 每个序列都包含了唯一的seq_id,提示和标记ID,以及block_size(块大小)。

block_size = self.cache_config.block_size

seqs: List[Sequence] = []

for _ in range(sampling_params.best_of):

seq_id = next(self.seq_counter)

seq = Sequence(seq_id, prompt, prompt_token_ids, block_size)

seqs.append(seq)

# 创建序列组(SequenceGroup)。一个序列组包含了一组相关的序列,

# 它们共享相同的请求ID和采样参数,并且在同一时间到达。

seq_group = SequenceGroup(request_id, seqs, sampling_params,

arrival_time)

# Add the sequence group to the scheduler.

# 将序列组添加到调度器中。这样,当调用engine.step()函数时,

# 调度器就可以根据它的调度策略处理这些序列组。

self.scheduler.add_seq_group(seq_group)

# 此函数接受一个请求ID作为参数,并调用调度器的abort_seq_group方法来终止具有该ID的请求。

# 简单地说,这个函数的目的是取消一个特定的请求。

def abort_request(self, request_id: str) -> None:

"""Aborts a request with the given ID.

Args:

request_id: The ID of the request to abort.

"""

self.scheduler.abort_seq_group(request_id)

# 此函数没有参数,并返回当前的模型配置。模型配置是一个ModelConfig对象,

# 包含模型和分词器的配置信息,以及其他可能的模型相关的配置选项。

def get_model_config(self) -> ModelConfig:

"""Gets the model configuration."""

return self.model_config

# 此函数也没有参数,它返回未完成的请求的数量。它通过调用调度器的

# get_num_unfinished_seq_groups方法实现,该方法返回

# 未完成的序列组的数量,因为每个请求都对应一个序列组。

def get_num_unfinished_requests(self) -> int:

"""Gets the number of unfinished requests."""

return self.scheduler.get_num_unfinished_seq_groups()

# 此函数没有参数,并返回一个布尔值,指示是否有未完成的请求。

# 这是通过调用调度器的has_unfinished_seqs方法实现的。

# 如果有未完成的序列,该函数返回True,否则返回False。

def has_unfinished_requests(self) -> bool:

"""Returns True if there are unfinished requests."""

return self.scheduler.has_unfinished_seqs()

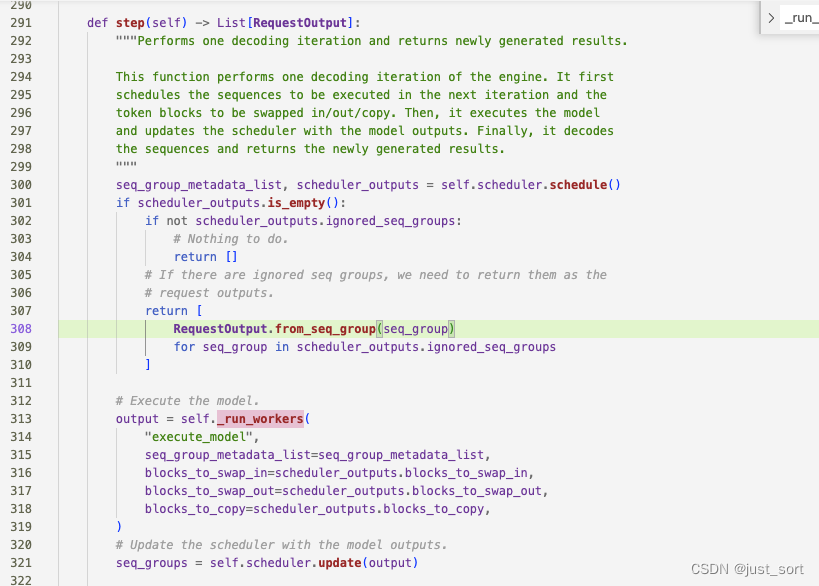

# 这个函数是 LLMEngine 类的一个关键函数,其功能是执行一次解码迭代并返回新生成的结果。

# 这个函数的执行过程可以分解为以下步骤:

def step(self) -> List[RequestOutput]:

"""Performs one decoding iteration and returns newly generated results.

This function performs one decoding iteration of the engine. It first

schedules the sequences to be executed in the next iteration and the

token blocks to be swapped in/out/copy. Then, it executes the model

and updates the scheduler with the model outputs. Finally, it decodes

the sequences and returns the newly generated results.

"""

# 首先,调用 self.scheduler.schedule() 进行调度,返回要在下一次迭代中执行的序列,

# 以及要被换入,换出,复制的 token 块。

seq_group_metadata_list, scheduler_outputs = self.scheduler.schedule()

# 然后,检查 scheduler_outputs 是否为空。如果为空并且没有被忽略的序列组,

# 则表示没有需要做的工作,函数返回空列表。如果存在被忽略的序列组,那么我们需要将它们作为请求输出返回。

if scheduler_outputs.is_empty():

if not scheduler_outputs.ignored_seq_groups:

# Nothing to do.

return []

# If there are ignored seq groups, we need to return them as the

# request outputs.

return [

RequestOutput.from_seq_group(seq_group)

for seq_group in scheduler_outputs.ignored_seq_groups

]

# Execute the model.

# 如果 scheduler_outputs 不为空,那么就会执行模型,将 seq_group_metadata_list、

# blocks_to_swap_in、blocks_to_swap_out 和 blocks_to_copy 作为参数传给 _run_workers

# 方法。这一步可能包括将一些状态从内存移到 GPU,执行模型计算,以及将一些状态从 GPU 移回内存。

output = self._run_workers(

"execute_model",

seq_group_metadata_list=seq_group_metadata_list,

blocks_to_swap_in=scheduler_outputs.blocks_to_swap_in,

blocks_to_swap_out=scheduler_outputs.blocks_to_swap_out,

blocks_to_copy=scheduler_outputs.blocks_to_copy,

)

# Update the scheduler with the model outputs.

# 之后,使用模型的输出结果来更新调度器。

seq_groups = self.scheduler.update(output)

# Decode the sequences.

# 然后对序列进行解码,并终止满足停止条件的序列。完成的序列组将被释放。

self._decode_sequences(seq_groups)

# Stop the sequences that meet the stopping criteria.

self._stop_sequences(seq_groups)

# Free the finished sequence groups.

self.scheduler.free_finished_seq_groups()

# Create the outputs.

# 最后,创建输出结果。对于每一个序列组,都将其转换为 RequestOutput 对象

# 并添加到输出列表中。如果 log_stats 为真,那么还会记录系统状态。

request_outputs: List[RequestOutput] = []

for seq_group in seq_groups + scheduler_outputs.ignored_seq_groups:

request_output = RequestOutput.from_seq_group(seq_group)

request_outputs.append(request_output)

if self.log_stats:

# Log the system stats.

self._log_system_stats(scheduler_outputs.prompt_run,

scheduler_outputs.num_batched_tokens)

return request_outputs

# _log_system_stats 函数的主要作用是记录和打印系统状态信息。

# 这些信息可以帮助理解系统的运行状态,包括吞吐量、请求的运行情况以及GPU和CPU的KV缓存使用情况等。

# 这是一个监控和调试工具,用于跟踪系统性能和资源使用情况。

def _log_system_stats(

self,

prompt_run: bool,

num_batched_tokens: int,

) -> None:

now = time.time()

# Log the number of batched input tokens.

# 函数首先记录当前时间,并根据prompt_run值,记录批处理输入标记的数量。

if prompt_run:

self.num_prompt_tokens.append((now, num_batched_tokens))

else:

self.num_generation_tokens.append((now, num_batched_tokens))

# 接下来,函数检查自上次记录日志以来是否已经过了足够的时间(由 _LOGGING_INTERVAL_SEC 定义)。

# 如果时间还没有过去足够,函数就会返回,不进行任何操作。

elapsed_time = now - self.last_logging_time

if elapsed_time < _LOGGING_INTERVAL_SEC:

return

# Discard the old stats.

# 如果已经过了足够的时间,函数会丢弃过旧的统计信息,

# 只保留在 _LOGGING_INTERVAL_SEC 时间窗口内的数据。

self.num_prompt_tokens = [(t, n) for t, n in self.num_prompt_tokens

if now - t < _LOGGING_INTERVAL_SEC]

self.num_generation_tokens = [(t, n)

for t, n in self.num_generation_tokens

if now - t < _LOGGING_INTERVAL_SEC]

# 函数然后计算prompt和genaration的平均吞吐量。

# 这是通过计算在指定时间窗口内处理的标记总数,然后除以时间窗口的长度来实现的。

if len(self.num_prompt_tokens) > 1:

total_num_tokens = sum(n for _, n in self.num_prompt_tokens[:-1])

window = now - self.num_prompt_tokens[0][0]

avg_prompt_throughput = total_num_tokens / window

else:

avg_prompt_throughput = 0.0

if len(self.num_generation_tokens) > 1:

total_num_tokens = sum(n

for _, n in self.num_generation_tokens[:-1])

window = now - self.num_generation_tokens[0][0]

avg_generation_throughput = total_num_tokens / window

else:

avg_generation_throughput = 0.0

# 函数接下来计算 GPU 和 CPU 的 KV 缓存使用情况。这是通过查看已使用的和总的缓存块的数量来实现的。

total_num_gpu_blocks = self.cache_config.num_gpu_blocks

num_free_gpu_blocks = (

self.scheduler.block_manager.get_num_free_gpu_blocks())

num_used_gpu_blocks = total_num_gpu_blocks - num_free_gpu_blocks

gpu_cache_usage = num_used_gpu_blocks / total_num_gpu_blocks

total_num_cpu_blocks = self.cache_config.num_cpu_blocks

if total_num_cpu_blocks > 0:

num_free_cpu_blocks = (

self.scheduler.block_manager.get_num_free_cpu_blocks())

num_used_cpu_blocks = total_num_cpu_blocks - num_free_cpu_blocks

cpu_cache_usage = num_used_cpu_blocks / total_num_cpu_blocks

else:

cpu_cache_usage = 0.0

# 最后,函数使用 logger.info 打印出所有的统计信息,并更新最后一次记录日志的时间。

logger.info("Avg prompt throughput: "

f"{avg_prompt_throughput:.1f} tokens/s, "

"Avg generation throughput: "

f"{avg_generation_throughput:.1f} tokens/s, "

f"Running: {len(self.scheduler.running)} reqs, "

f"Swapped: {len(self.scheduler.swapped)} reqs, "

f"Pending: {len(self.scheduler.waiting)} reqs, "

f"GPU KV cache usage: {gpu_cache_usage * 100:.1f}%, "

f"CPU KV cache usage: {cpu_cache_usage * 100:.1f}%")

self.last_logging_time = now

# 它遍历给定的序列组(seq_groups),并对每个处于运行状态的序列进行解码。

# 通过逐渐解码,它可以有效地处理和更新正在运行的序列,从而支持逐步生成和流式处理的用例。

def _decode_sequences(self, seq_groups: List[SequenceGroup]) -> None:

"""Decodes the sequence outputs."""

# 函数首先遍历传入的序列组列表。每个序列组都包含一组相关的序列。

for seq_group in seq_groups:

# 对于每个序列组,使用get_seqs方法并传入status=SequenceStatus.RUNNING参数,

# 从序列组中选择所有处于运行状态的序列。只有运行状态的序列才需要解码。

for seq in seq_group.get_seqs(status=SequenceStatus.RUNNING):

# 对于每个运行中的序列,函数调用detokenize_incrementally方法,

# 将序列的output_tokens逐渐解码为文本。这个解码过程考虑了最后一个

# 已经解码的标记,以及是否跳过特殊的标记。

# detokenize_incrementally方法返回新解码的token(new_token)

# 和新解码的输出文本(new_output_text)。

new_token, new_output_text = detokenize_incrementally(

self.tokenizer,

seq.output_tokens,

seq.get_last_token_id(),

skip_special_tokens=True,

)

# 如果有新的token被解码(new_token不是None),则将其追加到序列的output_tokens

# 列表中,并更新序列的output_text属性为新解码的文本。

if new_token is not None:

seq.output_tokens.append(new_token)

seq.output_text = new_output_text

# 这个函数_stop_sequences的主要目的是停止已完成的序列。完成可以由几种不同的条件定义,

# 例如序列生成了特定的停止字符串、达到了最大模型长度、达到了最大token数或生成了结束符(EOS)。

def _stop_sequences(self, seq_groups: List[SequenceGroup]) -> None:

"""Stop the finished sequences."""

# 函数开始通过遍历提供的序列组列表,检查每个组中的序列。

for seq_group in seq_groups:

# 当前序列组中获取采样参数sampling_params,它包含此序列组的特定设置,如停止字符串、最大标记数等。

sampling_params = seq_group.sampling_params

# 对于每个序列组,函数筛选出处于运行状态的序列进行处理。

for seq in seq_group.get_seqs(status=SequenceStatus.RUNNING):

# Check if the sequence has generated a stop string.

stopped = False

# 通过遍历sampling_params.stop中的每个停止字符串,

# 检查当前序列的输出文本是否以其中任何一个停止字符串结束。

for stop_str in sampling_params.stop:

if seq.output_text.endswith(stop_str):

# Truncate the output text so that the stop string is

# not included in the output.

# 如果序列以停止字符串结束,函数将截断该字符串,并将序列的状态设置为FINISHED_STOPPED。

seq.output_text = seq.output_text[:-len(stop_str)]

# 一旦找到停止字符串,就不再检查其余的停止字符串,并跳到下一个序列。

self.scheduler.free_seq(

seq, SequenceStatus.FINISHED_STOPPED)

stopped = True

break

if stopped:

continue

# Check if the sequence has reached max_model_len.

# 如果序列的长度大于scheduler_config.max_model_len,则将其状态设置

# 为FINISHED_LENGTH_CAPPED并继续处理下一个序列。

if seq.get_len() > self.scheduler_config.max_model_len:

self.scheduler.free_seq(

seq, SequenceStatus.FINISHED_LENGTH_CAPPED)

continue

# Check if the sequence has reached max_tokens.

# 如果序列的输出长度等于sampling_params.max_tokens,

# 则将其状态设置为FINISHED_LENGTH_CAPPED并继续处理下一个序列。

if seq.get_output_len() == sampling_params.max_tokens:

self.scheduler.free_seq(

seq, SequenceStatus.FINISHED_LENGTH_CAPPED)

continue

# Check if the sequence has generated the EOS token.

# 如果sampling_params.ignore_eos为False,并且序列的最后一个标记ID等于

# 分词器的eos_token_id,则将序列的状态设置为FINISHED_STOPPED并继续。

if not sampling_params.ignore_eos:

if seq.get_last_token_id() == self.tokenizer.eos_token_id:

self.scheduler.free_seq(

seq, SequenceStatus.FINISHED_STOPPED)

continue

def _run_workers(

self,

method: str,

*args,

get_all_outputs: bool = False,

**kwargs,

) -> Any:

"""Runs the given method on all workers."""

# 创建一个名为all_outputs的空列表,用于存储每个worker的输出。

all_outputs = []

# 通过遍历self.workers中的每个工作线程来运行给定的方法。

for worker in self.workers:

# 如果self.parallel_config.worker_use_ray为True,则使用远程执行(Ray框架的一部分)。

if self.parallel_config.worker_use_ray:

executor = partial(worker.execute_method.remote, method)

else:

# 如果为False,则直接在worker上获取和调用方法。

executor = getattr(worker, method)

# 用executor函数运行给定的方法,并将结果添加到all_outputs列表中。

output = executor(*args, **kwargs)

all_outputs.append(output)

# 如果使用了Ray进行远程执行,那么需要使用ray.get来获取远程执行的结果。

if self.parallel_config.worker_use_ray:

all_outputs = ray.get(all_outputs)

# 如果get_all_outputs参数为True,则返回all_outputs列表,其中包括每个worker的输出。

if get_all_outputs:

return all_outputs

# Make sure all workers have the same results.

# 如果为False,则确保所有工作线程的输出都相同,并仅返回第一个工作线程的输出。

output = all_outputs[0]

for other_output in all_outputs[1:]:

assert output == other_output

return output

LLMEngine实现了一个处理序列生成任务的引擎,我们对它的函数进行一个总结:

__init__:通过特定的EngineArgs来初始化LLMEngine,包括初始化tokenizer,创建并行的worker信息以及初始化KV Cache,创建调度器。_init_workers:初始化worker。这些worker负责在硬件资源(如GPU)上执行计算任务,一个GPU对应一个worker。_init_cache:profile gpu内存使用并初始化KV(键值)Cache。from_engine_args:此方法需要接受一个EngineArgs类型的参数engine_args,并返回一个LLMEngine类型的对象。add_request: 它接受一个请求并将其加入到scheduler的请求池中。 这个请求在调用engine.step()函数时由scheduler进行处理,具体的调度策略由scheduler决定。abort_request:终止某个请求id的请求。get_model_config返回当前的模型配置。get_num_unfinished_requests:返回scheduler中未完成的序列组(SequenceGroup)的数量,因为每个请求都对应一个序列组。has_unfinished_requests:scheduler中是否有未完成的序列(Sequence)。step:step 过程先从 scheduler 获取本次要作为输入的seq_group_metadata_list,同时产生一个scheduler_outputs和ignored_seq_groups。然后 engine 会调用 workers 的 execute_model。_log_system_stats:主要作用是记录和打印系统状态信息。这些信息可以帮助理解系统的运行状态,包括吞吐量、请求的运行情况以及GPU和CPU的KV缓存使用情况等。 这是一个监控和调试工具,用于跟踪系统性能和资源使用情况。_decode_sequences:它遍历给定的序列组(seq_groups),并对每个处于运行状态的序列进行解码。_stop_sequences: 这个函数的主要目的是停止已完成的序列。完成可以由几种不同的条件定义,例如序列生成了特定的停止字符串、达到了最大模型长度、达到了最大token数或生成了结束符(EOS)。_run_workers:在step函数中调用,实际上就是在每个GPU上的worker的模型推理。

从LLMEngine实现的函数来看,vllm关键的几个组件scheduler,worker,cache engine已经出现了。这三个组件的解析我们会分别单独开一节,这一节还是以走完整个vllm的generate流程为主旨。继续之前我们再看一下 detokenize_incrementally 这个函数的解析:

# 这个函数 detokenize_incrementally 负责将新token与之前的输出toke一起进行逐渐解码。

# tokenizer: 这是用于解码token的分词器对象.

# prev_output_tokens: 以前已解码的输出token列表。

# new_token_id: 要解码的新token ID。

# skip_special_tokens: 一个布尔值,如果为 True,特殊token将被跳过。

def detokenize_incrementally(

tokenizer: Union[PreTrainedTokenizer, PreTrainedTokenizerFast],

prev_output_tokens: List[str],

new_token_id: int,

skip_special_tokens: bool,

) -> Tuple[str, str]:

"""Detokenizes the new token in conjuction with the previous output tokens.

NOTE: This function does not update prev_output_tokens.

# 返回一个元组,其中包括新token作为字符串和新的输出文本作为字符串。

"""

# 如果 skip_special_tokens 为 True 并且新token ID是特殊令牌,

# 则直接返回 None 和 prev_output_tokens。

if skip_special_tokens and (new_token_id in tokenizer.all_special_ids):

return None, prev_output_tokens

# 使用 tokenizer.convert_ids_to_tokens 方法将新的token ID转换为token字符串。

new_token = tokenizer.convert_ids_to_tokens(

new_token_id, skip_special_tokens=skip_special_tokens)

# 将新token添加到先前的输出token列表中。

output_tokens = prev_output_tokens + [new_token]

# Convert the tokens to a string.

# Optimization: If the tokenizer does not have `added_tokens_encoder`,

# then we can directly use `convert_tokens_to_string`.

if not getattr(tokenizer, "added_tokens_encoder", {}):

# 如果分词器没有 added_tokens_encoder 属性,则可以直接使用

# convert_tokens_to_string 方法将输出token转换为字符串。

output_text = tokenizer.convert_tokens_to_string(output_tokens)

return new_token, output_text

# 否则,需要更复杂的逻辑来处理添加的token和特殊token,这涉及对输出token进行迭代并逐个解析。

# Adapted from

# https://github.com/huggingface/transformers/blob/v4.28.0/src/transformers/tokenization_utils.py#L921

# NOTE(woosuk): The following code is slow because it runs a for loop over

# the output_tokens. In Python, running a for loop over a list can be slow

# even when the loop body is very simple.

# 存储解析的子文本片段的列表。

sub_texts = []

# 存储当前正在处理的token的子文本的列表。

current_sub_text = []

# 对 output_tokens 中的每个token执行迭代。

for token in output_tokens:

# 如果 skip_special_tokens 为 True 并且token是特殊token,则跳过当前迭代。

if skip_special_tokens and token in tokenizer.all_special_tokens:

continue

# 如果token在 tokenizer.added_tokens_encoder 中,则:

if token in tokenizer.added_tokens_encoder:

if current_sub_text:

# 如果 current_sub_text 不为空,则使用 convert_tokens_to_string

# 将其转换为字符串,并将结果添加到 sub_texts 中。

sub_text = tokenizer.convert_tokens_to_string(current_sub_text)

sub_texts.append(sub_text)

# 清空 current_sub_text。

current_sub_text = []

# 将token本身添加到 sub_texts 中。

sub_texts.append(token)

else:

# 如果令牌不是特殊令牌也不是添加的令牌,则将其添加到 current_sub_text 中。

current_sub_text.append(token)

if current_sub_text:

# 如果遍历完成后 current_sub_text 不为空,则转换并添加到 sub_texts 中。

sub_text = tokenizer.convert_tokens_to_string(current_sub_text)

sub_texts.append(sub_text)

# 使用空格将 sub_texts 中的所有子文本连接在一起,形成最终的输出文本。

output_text = " ".join(sub_texts)

return new_token, output_text

接下来继续回到LLM类的generate过程解析:

# 个方法返回存储在类的 llm_engine 属性中的分词器对象。返回类型是 Union[PreTrainedTokenizer,

# PreTrainedTokenizerFast],表示可以返回这两种类型的任何一个。

def get_tokenizer(

self) -> Union[PreTrainedTokenizer, PreTrainedTokenizerFast]:

return self.llm_engine.tokenizer

# 这个方法接收一个参数 tokenizer,类型为 Union[PreTrainedTokenizer,

# PreTrainedTokenizerFast]。这个参数是新的分词器对象,将替换现有的分词器。

def set_tokenizer(

self,

tokenizer: Union[PreTrainedTokenizer, PreTrainedTokenizerFast],

) -> None:

self.llm_engine.tokenizer = tokenizer

# generate 函数是用于根据给定的prompts生成完整文本的核心方法。

def generate(

self,

prompts: Optional[Union[str, List[str]]] = None,

sampling_params: Optional[SamplingParams] = None,

prompt_token_ids: Optional[List[List[int]]] = None,

use_tqdm: bool = True,

) -> List[RequestOutput]:

"""Generates the completions for the input prompts.

NOTE: This class automatically batches the given prompts, considering

the memory constraint. For the best performance, put all of your prompts

into a single list and pass it to this method.

Args:

prompts: A list of prompts to generate completions for.

sampling_params: The sampling parameters for text generation. If

None, we use the default sampling parameters.

prompt_token_ids: A list of token IDs for the prompts. If None, we

use the tokenizer to convert the prompts to token IDs.

use_tqdm: Whether to use tqdm to display the progress bar.

Returns:

A list of `RequestOutput` objects containing the generated

completions in the same order as the input prompts.

"""

# 这段代码确保至少提供了prompts或prompts的token ID之一。

if prompts is None and prompt_token_ids is None:

raise ValueError("Either prompts or prompt_token_ids must be "

"provided.")

# 如果只提供了一个字符串prompts(而不是列表),这段代码将其转换为列表,以便后续处理。

if isinstance(prompts, str):

# Convert a single prompt to a list.

prompts = [prompts]

# 如果同时提供了prompts和prompts token ID,则此代码确保它们的长度相同。

if prompts is not None and prompt_token_ids is not None:

if len(prompts) != len(prompt_token_ids):

raise ValueError("The lengths of prompts and prompt_token_ids "

"must be the same.")

# 如果未提供采样参数,此代码将使用默认参数。

if sampling_params is None:

# Use default sampling params.

sampling_params = SamplingParams()

# Add requests to the engine.

# 此段代码循环遍历prompts或prompt token IDs,并使用它们调用 _add_request 方法

# 将请求添加到引擎。根据是否提供了prompts或token ID,适当地处理了参数。

if prompts is not None:

num_requests = len(prompts)

else:

num_requests = len(prompt_token_ids)

for i in range(num_requests):

prompt = prompts[i] if prompts is not None else None

if prompt_token_ids is None:

token_ids = None

else:

token_ids = prompt_token_ids[i]

self._add_request(prompt, sampling_params, token_ids)

# 此代码调用先前定义的 _run_engine 方法来运行引擎,并返回其输出。

# 这些输出是一个RequestOutput对象的列表,包含生成的完整文本,与输入prompt的顺序相同。

return self._run_engine(use_tqdm)

# LLM模型为 llm_engine 添加一个请求

def _add_request(

self,

prompt: Optional[str],

sampling_params: SamplingParams,

prompt_token_ids: Optional[List[int]],

) -> None:

# 从 self.request_counter 获取下一个值并转换为字符串来创建请求ID。

request_id = str(next(self.request_counter))

# 调用 llm_engine 的 add_request 方法,将请求添加到llm_engine中。

self.llm_engine.add_request(request_id, prompt, sampling_params,

prompt_token_ids)

# 这个函数负责运行 self.llm_engine的step函数,并收集已完成的请求的输出。

def _run_engine(self, use_tqdm: bool) -> List[RequestOutput]:

# Initialize tqdm.

# 如果参数 use_tqdm 为真,则代码初始化一个 tqdm 进度条来跟踪处理进度。

# tqdm 是一个流行的库,用于在命令行中显示循环的进度条。num_requests 是尚未完成的请求的数量。

if use_tqdm:

num_requests = self.llm_engine.get_num_unfinished_requests()

pbar = tqdm(total=num_requests, desc="Processed prompts")

# Run the engine.

outputs: List[RequestOutput] = []

# 主要的循环在引擎有未完成的请求时持续运行。在每个步骤中,通过调用引擎的 step 方法来处理请求。

# 如果输出表示已完成的请求,则将其添加到 outputs 列表中。如果使用 tqdm,进度条将相应地更新。

while self.llm_engine.has_unfinished_requests():

step_outputs = self.llm_engine.step()

for output in step_outputs:

if output.finished:

outputs.append(output)

if use_tqdm:

pbar.update(1)

# 如果使用了 tqdm,此代码段将关闭进度条。

if use_tqdm:

pbar.close()

# Sort the outputs by request ID.

# This is necessary because some requests may be finished earlier than

# its previous requests.

# 输出列表是按完成顺序排列的,这可能与原始请求顺序不同。

# 这一行代码通过请求ID将它们排序,确保输出按原始顺序排列。

outputs = sorted(outputs, key=lambda x: int(x.request_id))

return outputs

现在基本走完了vllm根据prompt,特定模型架构和特定采样参数去生成结果的全流程,我们再对这个流程总结一下。

首先,vllm进来之后先实例化一个LLM对象即:llm = LLM(model="facebook/opt-125m")。然后调用llm.generate函数,这个函数的输入是prompts(List[str]类型),采样参数,然后返回 List[RequestOutput],对应outputs = llm.generate(prompts, sampling_params)这行代码。从llm.generate的实现来看,对于每一个prompt都会生成一个request喂给llm_engine,然后执行_run_engine(这个函数负责运行 llm_engine.step函数,并收集已完成的请求的输出。)函数结束。llm_engine.step函数首先从scheduler获取当前的输入seq_group_metadata_list ,同时生成一个 scheduler_outputs,接下来会调用 workers 的 execute_model来指定模型的前向推理过程,拿到这个结果之后再进行解码(对应self._decode_sequences(seq_groups)这行)。最后scheduler再更新已经解码完毕的序列的状态,并释放序列占用的内存。

接下来,分别对vllm关键的几个组件scheduler,worker,cache engine进行解析。

0x2. worker

在llm_engine的实现中,和worker相关的就是_init_workers和_run_workers函数,_init_workers 用来初始化worker。这些worker负责在硬件资源(如GPU)上执行计算任务,一个GPU对应一个worker。llm_engine通过 _run_workers("<method_name>", *args, get_all_outputs, **kwargs) 来执行给定的方法。如果 get_all_outputs 参数为 True,那么它会将所有 workers 的返回结果包装成 List 来返回。否则,它只会返回第一个 worker 的结果,并且 assert 所有 workers 的输出都是一样的。

接下来我们对worker的实现做一个简要的解析,代码位置在 vllm/vllm/worker/worker.py 。

# 这个Worker类定义了一个执行模型在GPU上的工作单元。每个工作单元都与一个单独的GPU相关联。

# 在分布式推理的情况下,每个工作单元会被分配模型的一个部分。

class Worker:

# 这是类的构造函数,用于初始化Worker对象的新实例。它接受五个参数:

# model_config,parallel_config,scheduler_config,rank和distributed_init_method。

def __init__(

self,

model_config: ModelConfig,

parallel_config: ParallelConfig,

scheduler_config: SchedulerConfig,

rank: Optional[int] = None,

distributed_init_method: Optional[str] = None,

) -> None:

# 存储传入的配置

self.model_config = model_config

self.parallel_config = parallel_config

self.scheduler_config = scheduler_config

self.rank = rank

self.distributed_init_method = distributed_init_method

# 这部分代码设置了与缓存引擎相关的未初始化属性。从注释中可以了解,

# 这些属性将在之后的self.init_cache_engine()方法中进行初始化。

self.cache_config = None

self.block_size = None

self.cache_engine = None

self.cache_events = None

self.gpu_cache = None

# 在worker中初始化模型

def init_model(self):

# This env var set by Ray causes exceptions with graph building.

# 这行代码删除了名为NCCL_ASYNC_ERROR_HANDLING的环境变量。

# 从注释可以看出,这个环境变量会在构建计算图时导致异常。

os.environ.pop("NCCL_ASYNC_ERROR_HANDLING", None)

# Env vars will be set by Ray.

# 这部分代码首先检查self.rank是否已经设定。如果没有设定,它会尝试从环境变量中获取RANK的值。

# 然后,它从环境变量中获取LOCAL_RANK,这通常表示当前节点的编号或ID。

# 最后,它使用此local_rank为worker设置所使用的GPU设备。

self.rank = self.rank if self.rank is not None else int(

os.getenv("RANK", "-1"))

local_rank = int(os.getenv("LOCAL_RANK", "0"))

self.device = torch.device(f"cuda:{local_rank}")

# 这部分代码首先确保工作单元的rank有效。如果rank是一个无效值(小于0),

# 则会引发一个错误。接下来,它将当前CUDA设备设置为之前确定的self.device。

if self.rank < 0:

raise ValueError("Invalid or unspecified rank.")

torch.cuda.set_device(self.device)

# Initialize the distributed environment.

# 使用给定的并行配置、rank和分布式初始化方法来初始化分布式环境。

# 这涉及到设置必要的通信和同步机制以支持分布式训练或推理。

_init_distributed_environment(self.parallel_config, self.rank,

self.distributed_init_method)

# Initialize the model.

# 这里,首先设置随机种子以确保可重现性。然后,使用提供的model_config从

# get_model函数获取模型实例并存储在self.model中。

set_random_seed(self.model_config.seed)

self.model = get_model(self.model_config)

# 该函数主要用于基于配置的GPU和CPU内存约束来估计可以用于缓存块的最大数量。

@torch.inference_mode() # 使用PyTorch的inference_mode来确保在执行此函数时不会跟踪计算图或计算梯度。

# 函数名为profile_num_available_blocks,带有三个参数:块大小、GPU内存利用率和CPU交换空间。

# 函数返回一个包含两个整数的元组,分别代表可用的GPU和CPU块数。

def profile_num_available_blocks(

self,

block_size: int,

gpu_memory_utilization: float,

cpu_swap_space: int,

) -> Tuple[int, int]:

# Profile the memory usage of the model and get the maximum number of

# cache blocks that can be allocated with the remaining free memory.

# 清空CUDA内存缓存并重置内存使用峰值统计信息。

torch.cuda.empty_cache()

torch.cuda.reset_peak_memory_stats()

# Profile memory usage with max_num_sequences sequences and the total

# number of tokens equal to max_num_batched_tokens.

# Enable top-k sampling to reflect the accurate memory usage.

# 获取模型的词汇表大小,然后设置采样参数。

vocab_size = self.model.config.vocab_size

sampling_params = SamplingParams(top_p=0.99, top_k=vocab_size - 1)

# 从调度器配置中获取max_num_batched_tokens和max_num_seqs。

max_num_batched_tokens = self.scheduler_config.max_num_batched_tokens

max_num_seqs = self.scheduler_config.max_num_seqs

seqs = []

# 这部分代码为每个序列组生成一个SequenceGroupMetadata对象,并收集这些对象以供之后的模型输入准备。

for group_id in range(max_num_seqs):

seq_len = (max_num_batched_tokens // max_num_seqs +

(group_id < max_num_batched_tokens % max_num_seqs))

seq_data = SequenceData([0] * seq_len)

seq = SequenceGroupMetadata(

request_id=str(group_id),

is_prompt=True,

seq_data={group_id: seq_data},

sampling_params=sampling_params,

block_tables=None,

)

seqs.append(seq)

# 使用_prepare_inputs方法准备模型的输入数据。

input_tokens, input_positions, input_metadata = self._prepare_inputs(

seqs)

# Execute the model.

# 这部分代码运行模型来估计其在给定输入上的内存使用情况。

num_layers = self.model_config.get_num_layers(self.parallel_config)

self.model(

input_ids=input_tokens,

positions=input_positions,

kv_caches=[(None, None)] * num_layers,

input_metadata=input_metadata,

cache_events=None,

)

# Calculate the number of blocks that can be allocated with the

# profiled peak memory.

# 基于之前模型执行的内存使用情况来计算可以分配给缓存的块数。

torch.cuda.synchronize()

peak_memory = torch.cuda.max_memory_allocated()

total_gpu_memory = get_gpu_memory()

# 使用CacheEngine.get_cache_block_size方法根据给定的块大小、

# 模型配置和并行配置来计算缓存块的大小。

cache_block_size = CacheEngine.get_cache_block_size(

block_size, self.model_config, self.parallel_config)

# 这行代码计算了可以在GPU上分配的缓存块数量。首先,它考虑了GPU的总内存和指定的GPU内存利用率

#(gpu_memory_utilization)。从这个总量中减去了模型操作的峰值内存使用量,

# 然后将结果除以每个缓存块的大小来得到块的数量。

num_gpu_blocks = int(

(total_gpu_memory * gpu_memory_utilization - peak_memory) //

cache_block_size)

num_cpu_blocks = int(cpu_swap_space // cache_block_size)

num_gpu_blocks = max(num_gpu_blocks, 0)

num_cpu_blocks = max(num_cpu_blocks, 0)

# 再次清空CUDA的内存缓存。

torch.cuda.empty_cache()

# Reset the seed to ensure that the random state is not affected by

# the model initialization and profiling.

# 为确保此函数的执行不会影响模型的随机状态,重置随机种子。

set_random_seed(self.model_config.seed)

# 函数返回可以在GPU和CPU上分配的块数。

return num_gpu_blocks, num_cpu_blocks

# 这个函数的目的是初始化cache enegine

def init_cache_engine(self, cache_config: CacheConfig) -> None:

# 这里我们将cache_config参数(应该是一个缓存配置对象)赋值给该类的

# 成员变量self.cache_config,这样在类的其他部分也可以访问此配置。

self.cache_config = cache_config

# 从缓存配置中获取块大小并将其存储在self.block_size中。

self.block_size = cache_config.block_size

# 使用提供的缓存配置、模型配置和并行配置创建一个新的CacheEngine实例。

# CacheEngine 是一个专门负责处理和管理缓存的类。

self.cache_engine = CacheEngine(self.cache_config, self.model_config,

self.parallel_config)

self.cache_events = self.cache_engine.events

self.gpu_cache = self.cache_engine.gpu_cache

# 为模型准备输入数据

def _prepare_inputs(

self,

seq_group_metadata_list: List[SequenceGroupMetadata],

) -> Tuple[torch.Tensor, torch.Tensor, InputMetadata]:

# 初始化四个空列表,用于存储准备的数据。

seq_groups: List[Tuple[List[int], SamplingParams]] = []

input_tokens: List[int] = []

input_positions: List[int] = []

slot_mapping: List[int] = []

# Add prompt tokens.

# 初始化一个空列表,用于存储提示的长度。

prompt_lens: List[int] = []

# 遍历传入的seq_group_metadata_list列表。

for seq_group_metadata in seq_group_metadata_list:

# 如果当前seq_group_metadata不是提示,则跳过当前迭代。

if not seq_group_metadata.is_prompt:

continue

# 获取当前seq_group_metadata的序列ID和采样参数,并将它们添加到seq_groups列表中。

seq_ids = list(seq_group_metadata.seq_data.keys())

sampling_params = seq_group_metadata.sampling_params

seq_groups.append((seq_ids, sampling_params))

# Use any sequence in the group.

seq_id = seq_ids[0]

seq_data = seq_group_metadata.seq_data[seq_id]

prompt_tokens = seq_data.get_token_ids()

prompt_len = len(prompt_tokens)

prompt_lens.append(prompt_len)

# 将prompt tokens添加到input_tokens列表中,

# 并为每个token添加一个位置到input_positions列表中。

input_tokens.extend(prompt_tokens)

# NOTE(woosuk): Here we assume that the first token in the prompt

# is always the first token in the sequence.

input_positions.extend(range(len(prompt_tokens)))

# 如果当前的seq_group_metadata没有块表,为slot_mapping添加0,并跳过当前迭代。

if seq_group_metadata.block_tables is None:

# During memory profiling, the block tables are not initialized

# yet. In this case, we just use a dummy slot mapping.

slot_mapping.extend([0] * prompt_len)

continue

# Compute the slot mapping.

# 这个代码段计算了如何在内存中布局tokens,它使用了块大小和块表。

block_table = seq_group_metadata.block_tables[seq_id]

for i in range(prompt_len):

block_number = block_table[i // self.block_size]

block_offset = i % self.block_size

slot = block_number * self.block_size + block_offset

slot_mapping.append(slot)

# Add generation tokens.

# 这里初始化了两个整数用于存储最大的上下文长度和序列块表长度的最大值,

# 以及两个列表用于存储上下文的长度和每个生成的序列对应的块表。

max_context_len = 0

max_num_blocks_per_seq = 0

context_lens: List[int] = []

generation_block_tables: List[List[int]] = []

# 对seq_group_metadata_list中的每个seq_group_metadata进行迭代。

for seq_group_metadata in seq_group_metadata_list:

# 如果seq_group_metadata是一个提示,则跳过此次迭代,因为我们在这里只处理生成部分。

if seq_group_metadata.is_prompt:

continue

# 获取序列ID和采样参数,并将它们以元组形式添加到seq_groups列表中。

seq_ids = list(seq_group_metadata.seq_data.keys())

sampling_params = seq_group_metadata.sampling_params

seq_groups.append((seq_ids, sampling_params))

# 遍历每一个序列ID。

for seq_id in seq_ids:

# 对于当前的seq_id,获取其对应的序列数据。

seq_data = seq_group_metadata.seq_data[seq_id]

# 从seq_data获取最后一个token ID并将其添加到input_tokens列表中。

generation_token = seq_data.get_last_token_id()

input_tokens.append(generation_token)

# 取seq_data的长度,并计算位置(为最后一个token的位置),

# 然后将位置添加到input_positions列表中。

context_len = seq_data.get_len()

position = context_len - 1

input_positions.append(position)

# 获取seq_id对应的块表,并将其添加到generation_block_tables列表中。

block_table = seq_group_metadata.block_tables[seq_id]

generation_block_tables.append(block_table)

# 更新max_context_len和max_num_blocks_per_seq的值。

max_context_len = max(max_context_len, context_len)

max_num_blocks_per_seq = max(max_num_blocks_per_seq,

len(block_table))

# 将context_len添加到context_lens列表中。

context_lens.append(context_len)

# 计算当前token在内存中的插槽,并将其添加到slot_mapping列表中。

block_number = block_table[position // self.block_size]

block_offset = position % self.block_size

slot = block_number * self.block_size + block_offset

slot_mapping.append(slot)

# Optimization: Pad the input length to be a multiple of 8.

# This is required for utilizing the Tensor Cores in NVIDIA GPUs.

# 这里使用一个名为_pad_to_alignment的函数来将input_tokens和

# input_positions列表的长度填充到8的倍数。

# 这是一个针对NVIDIA Tensor Cores的优化,可以确保更高的性能。

input_tokens = _pad_to_alignment(input_tokens, multiple_of=8)

input_positions = _pad_to_alignment(input_positions, multiple_of=8)

# Convert to tensors.

# 上述代码将input_tokens和input_positions列表转化为PyTorch在CUDA上的LongTensor张量。

tokens_tensor = torch.cuda.LongTensor(input_tokens)

positions_tensor = torch.cuda.LongTensor(input_positions)

# 然后,slot_mapping和context_lens也被转换为在CUDA上的IntTensor张量。

slot_mapping_tensor = torch.cuda.IntTensor(slot_mapping)

context_lens_tensor = torch.cuda.IntTensor(context_lens)

# 对generation_block_tables中的每个block_table进行迭代,

# 并使用_pad_to_max函数来对其进行填充,确保其长度达到max_num_blocks_per_seq。

padded_block_tables = [

_pad_to_max(block_table, max_num_blocks_per_seq)

for block_table in generation_block_tables

]

# 将填充后的padded_block_tables转换为CUDA上的IntTensor张量。

block_tables_tensor = torch.cuda.IntTensor(padded_block_tables)

# 初始化一个空字典seq_data,然后遍历seq_group_metadata_list来收集所有的seq_data。

seq_data: Dict[int, SequenceData] = {}

for seq_group_metadata in seq_group_metadata_list:

seq_data.update(seq_group_metadata.seq_data)

# 使用收集到的数据来创建InputMetadata对象。

input_metadata = InputMetadata(

seq_groups=seq_groups,

seq_data=seq_data,

prompt_lens=prompt_lens,

slot_mapping=slot_mapping_tensor,

context_lens=context_lens_tensor,

max_context_len=max_context_len,

block_tables=block_tables_tensor,

)

return tokens_tensor, positions_tensor, input_metadata

@torch.inference_mode()

def execute_model(

self,

seq_group_metadata_list: List[SequenceGroupMetadata],

blocks_to_swap_in: Dict[int, int],

blocks_to_swap_out: Dict[int, int],

blocks_to_copy: Dict[int, List[int]],

) -> Dict[int, SequenceOutputs]:

# Issue cache operations.

issued_cache_op = False

if blocks_to_swap_in:

self.cache_engine.swap_in(blocks_to_swap_in)

issued_cache_op = True

if blocks_to_swap_out:

self.cache_engine.swap_out(blocks_to_swap_out)

issued_cache_op = True

if blocks_to_copy:

self.cache_engine.copy(blocks_to_copy)

issued_cache_op = True

if issued_cache_op:

cache_events = self.cache_events

else:

cache_events = None

# If there is no input, we don't need to execute the model.

if not seq_group_metadata_list:

if cache_events is not None:

for event in cache_events:

event.wait()

return {}

# Prepare input tensors.

input_tokens, input_positions, input_metadata = self._prepare_inputs(

seq_group_metadata_list)

# Execute the model.

output = self.model(

input_ids=input_tokens,

positions=input_positions,

kv_caches=self.gpu_cache,

input_metadata=input_metadata,

cache_events=cache_events,

)

return output

def _init_distributed_environment(

parallel_config: ParallelConfig,

rank: int,

distributed_init_method: Optional[str] = None,

) -> None:

"""Initialize the distributed environment."""

if torch.distributed.is_initialized():

torch_world_size = torch.distributed.get_world_size()

if torch_world_size != parallel_config.world_size:

raise RuntimeError(

"torch.distributed is already initialized but the torch world "

"size does not match parallel_config.world_size "

f"({torch_world_size} vs. {parallel_config.world_size}).")

elif not distributed_init_method:

raise ValueError(

"distributed_init_method must be set if torch.distributed "

"is not already initialized")

else:

torch.distributed.init_process_group(

backend="nccl",

world_size=parallel_config.world_size,

rank=rank,

init_method=distributed_init_method,

)

# A small all_reduce for warmup.

torch.distributed.all_reduce(torch.zeros(1).cuda())

initialize_model_parallel(parallel_config.tensor_parallel_size,

parallel_config.pipeline_parallel_size)

def _pad_to_alignment(x: List[int], multiple_of: int) -> List[int]:

return x + [0] * ((-len(x)) % multiple_of)

def _pad_to_max(x: List[int], max_len: int) -> List[int]:

return x + [0] * (max_len - len(x))

我们对worker的几个关键函数进行了解析,总结一下:

init_model:对模型进行初始化。profile_num_available_blocks: 这个函数首先运行一次模型来profile内存峰值占用并以次计算没张卡上的blocks个数。init_cache_engine:初始化 cache engine。execute_model:执行模型。

llm_engine通过 _run_workers("<method_name>", *args, get_all_outputs, **kwargs) 来和上面的三个函数建立起联系。从llm_engine.step函数我们基本可以看到scheduler,worker的关系:

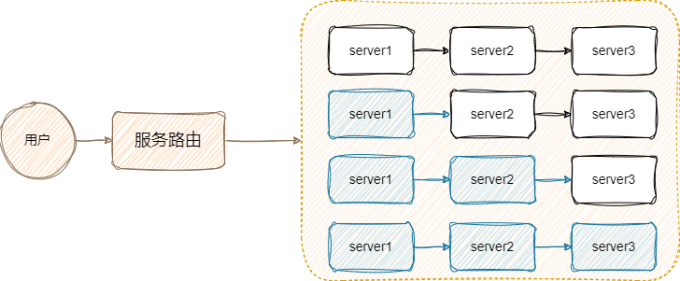

在原始的

在原始的LLM类的genarete函数中,对于每个输入的prompt,都会给 llm engine 生成一个 request并添加到scheduler里。然后调用 _run_engine 函数,这个函数的逻辑是对于所有未完成的 requests,就调用 llm engine 的 step 函数得到这一步的 outputs,然后 append 到返回的 List 里。在step函数里,由scheduler获取本次要作为输入的 seq_group_metadata_list ,同时产生一个 scheduler_outputs。然后 engine 会调用 worker 的 execute_model 来执行对 seq_group_metadata_list 的模型前向计算。

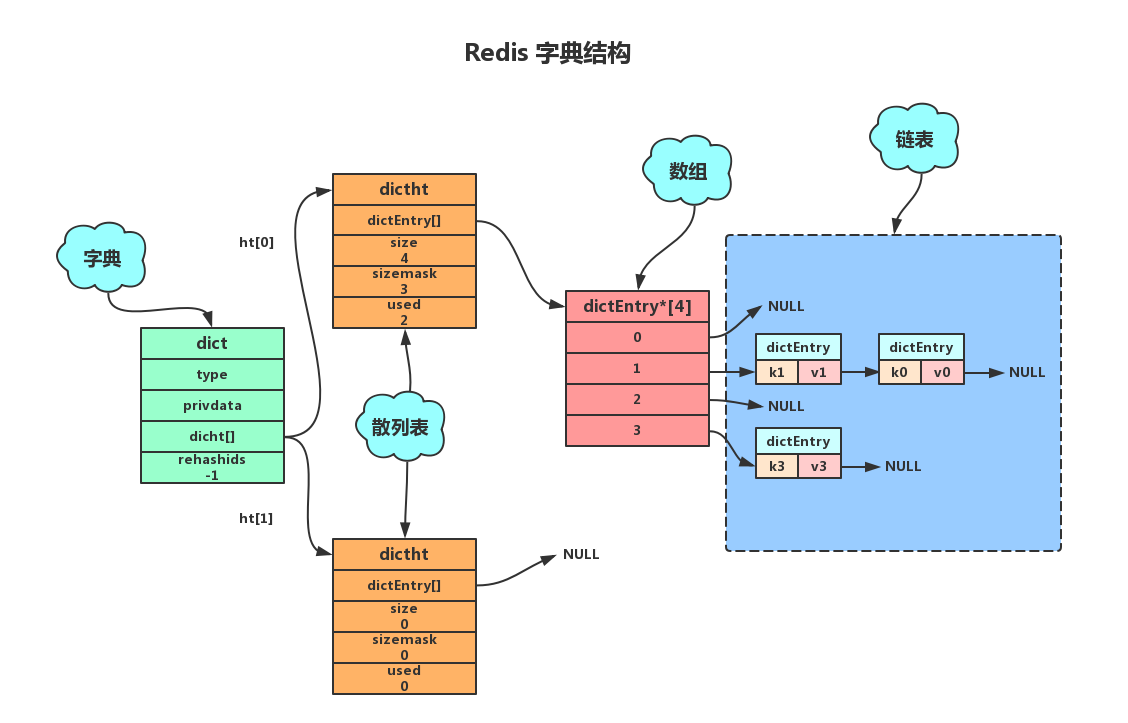

0x3. cache engine

上面的worker实现和普通的PyTorch执行模型前向最大的一个区别是它维护了一个cache engine,它是用管理模型的KV Cache的。下面仍然是对它的实现进行解析,它的实现在vllm/vllm/worker/cache_engine.py这个文件。

KVCache = Tuple[torch.Tensor, torch.Tensor]

# CacheEngine类的主要责任是初始化和管理GPU和CPU上的KV Cache,并为KV Cache 操作如交换和复制提供方法。

class CacheEngine:

"""Manages the KV cache.

This class is responsible for initializing and managing the GPU and CPU KV

caches. It also provides methods for performing KV cache operations, such

as swapping and copying.

"""

# 这个构造函数接受三个参数:cache_config、model_config和parallel_config,

# 分别对应缓存配置、模型配置和并行配置。

def __init__(

self,

cache_config: CacheConfig,

model_config: ModelConfig,

parallel_config: ParallelConfig,

) -> None:

# 下面三行代码保存了传入构造函数的配置信息,供类的其他方法使用。

self.cache_config = cache_config

self.model_config = model_config

self.parallel_config = parallel_config

# 根据模型配置提取了头的大小、层数、头的数量和数据类型,并保存为类的成员变量。

self.head_size = model_config.get_head_size()

self.num_layers = model_config.get_num_layers(parallel_config)

self.num_heads = model_config.get_num_heads(parallel_config)

self.dtype = model_config.dtype

# 这里从缓存配置中获取块的大小、GPU上的块数量和CPU上的块数量。

self.block_size = cache_config.block_size

self.num_gpu_blocks = cache_config.num_gpu_blocks

self.num_cpu_blocks = cache_config.num_cpu_blocks

# Initialize the cache.

# 这两行代码调用了这个类的2个成员函数来分配GPU和CPU缓存,并将结果保存为类的成员变量。

self.gpu_cache = self.allocate_gpu_cache()

self.cpu_cache = self.allocate_cpu_cache()

# Initialize the stream for caching operations.

# 首先创建了一个新的CUDA流并保存。接下来,它使用assert确保新创建的流不是当前的CUDA流。

self.cache_stream = torch.cuda.Stream()

assert self.cache_stream != torch.cuda.current_stream()

# Initialize the events for stream synchronization.

# 这行代码为每层创建了一个CUDA事件,并保存为一个列表。CUDA事件主要用于同步CUDA流。

self.events = [torch.cuda.Event() for _ in range(self.num_layers)]

# 这是CacheEngine类的一个成员函数get_key_block_shape,该函数的目的是返回KV Cache中key block的shape(维度)

def get_key_block_shape(self) -> Tuple[int, int, int, int]:

# torch.tensor([], dtype=self.dtype):创建一个空的Tensor,其数据类型由类的dtype属性指定。

# .element_size():此方法返回该Tensor的数据类型的元素大小(以字节为单位)。

# 例如,如果dtype是torch.float32(即32位浮点数),那么element_size将是4(字节)。

element_size = torch.tensor([], dtype=self.dtype).element_size()

# 这行代码将16除以前面计算得到的element_size(并执行整数除法),得到的结果赋值给变量x。

# 假设dtype是torch.float32(元素大小为4字节),那么x将是4。

x = 16 // element_size

# 这里构建并返回一个由四个整数构成的元组,这些整数描述了key block的形状。具体来说,形状的每个维度如下:

# 头的数量(由类的num_heads属性指定)。

# 头的大小除以x。

# 块的大小(由类的block_size属性指定)。

# x。

return (

self.num_heads,

self.head_size // x,

self.block_size,

x,

)

# 返回value block的形状

def get_value_block_shape(self) -> Tuple[int, int, int]:

return (

self.num_heads,

self.head_size,

self.block_size,

)

# 在GPU上申请key_block和value_block的内存

def allocate_gpu_cache(self) -> List[KVCache]:

gpu_cache: List[KVCache] = []

key_block_shape = self.get_key_block_shape()

value_block_shape = self.get_value_block_shape()

for _ in range(self.num_layers):

key_blocks = torch.empty(

size=(self.num_gpu_blocks, *key_block_shape),

dtype=self.dtype,

device="cuda",

)

value_blocks = torch.empty(

size=(self.num_gpu_blocks, *value_block_shape),

dtype=self.dtype,

device="cuda",

)

gpu_cache.append((key_blocks, value_blocks))

return gpu_cache

# 在CPU上申请key_block和value_block的内存

def allocate_cpu_cache(self) -> List[KVCache]:

cpu_cache: List[KVCache] = []

key_block_shape = self.get_key_block_shape()

value_block_shape = self.get_value_block_shape()

pin_memory = not in_wsl()

if not pin_memory:

# Pinning memory in WSL is not supported.

# https://docs.nvidia.com/cuda/wsl-user-guide/index.html#known-limitations-for-linux-cuda-applications

logger.warning("Using 'pin_memory=False' as WSL is detected. "

"This may slow down the performance.")

for _ in range(self.num_layers):

key_blocks = torch.empty(

size=(self.num_cpu_blocks, *key_block_shape),

dtype=self.dtype,

pin_memory=pin_memory,

)

value_blocks = torch.empty(

size=(self.num_cpu_blocks, *value_block_shape),

dtype=self.dtype,

pin_memory=pin_memory,

)

cpu_cache.append((key_blocks, value_blocks))

return cpu_cache

def _swap(

self,

src: List[KVCache],

dst: List[KVCache],

src_to_dst: Dict[int, int],

) -> None:

with torch.cuda.stream(self.cache_stream):

for i in range(self.num_layers):

src_key_cache, src_value_cache = src[i]

dst_key_cache, dst_value_cache = dst[i]

# Copy the key blocks.

cache_ops.swap_blocks(src_key_cache, dst_key_cache, src_to_dst)

# Copy the value blocks.

cache_ops.swap_blocks(src_value_cache, dst_value_cache,

src_to_dst)

event = self.events[i]

event.record(stream=self.cache_stream)

# paged attention的swap操作,有点像操作系统里的 swap 概念。in 就是 cpu to gpu,

# out 就是 gpu to cpu。内部实现由专门的 cu 函数 swap_blocks 支持。

def swap_in(self, src_to_dst: Dict[int, int]) -> None:

self._swap(self.cpu_cache, self.gpu_cache, src_to_dst)

def swap_out(self, src_to_dst: Dict[int, int]) -> None:

self._swap(self.gpu_cache, self.cpu_cache, src_to_dst)

# paged attention的copy操作,由专门的 cu 函数 copy_blocks 支持。

def copy(self, src_to_dsts: Dict[int, List[int]]) -> None:

key_caches = [key_cache for key_cache, _ in self.gpu_cache]

value_caches = [value_cache for _, value_cache in self.gpu_cache]

# NOTE(woosuk): This operation implicitly synchronizes the CPU and GPU.

cache_ops.copy_blocks(key_caches, value_caches, src_to_dsts)

# 这个函数get_cache_block_size是CacheEngine类的静态方法,用于计算缓存块的大小。

@staticmethod

def get_cache_block_size(

block_size: int,

model_config: ModelConfig,

parallel_config: ParallelConfig,

) -> int:

head_size = model_config.get_head_size()

num_heads = model_config.get_num_heads(parallel_config)

num_layers = model_config.get_num_layers(parallel_config)

key_cache_block = block_size * num_heads * head_size

value_cache_block = key_cache_block

total = num_layers * (key_cache_block + value_cache_block)

dtype_size = _get_dtype_size(model_config.dtype)

return dtype_size * total

def _get_dtype_size(dtype: torch.dtype) -> int:

return torch.tensor([], dtype=dtype).element_size()

Cache Engine根据之前调用workers里面profile 的数据(cpu/gpu blocks数)来申请 cache 内存。然后再给 caching 操作初始化一个 cuda Stream,并且为每个网络层创建了一个CUDA事件,并保存为一个列表。观察到key block的形状为[num_heads, head_size // x, block_size, x],符号的具体含义看上面的注释,这里为什么要// x 还不清楚,后续在cuda实现应该可以找到答案。接着我们看到Paged attention中对KV Cache的经典操作copy,swap_in/out都是由cuda kernel实现然后通过torch extension模块导出的。

接下来对cache相关的cuda算子进行解析。

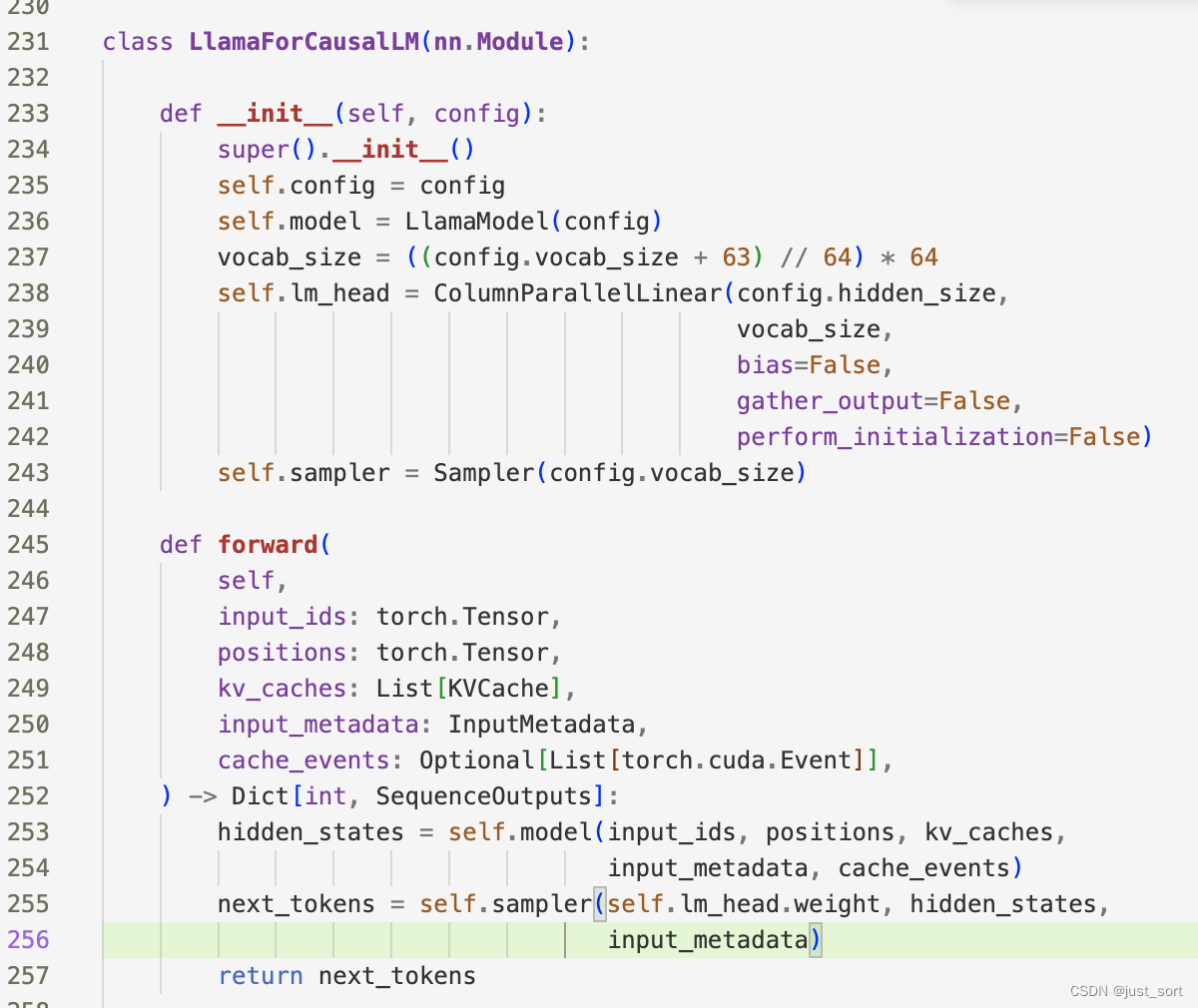

0x4. Sequence相关的数据结构解析

回顾一下,在原始的LLM类的genarete函数中,对于每个输入的prompt,都会给 llm engine 生成一个 request并添加到scheduler里。然后调用 _run_engine 函数,这个函数的逻辑是对于所有未完成的 requests,就调用 llm engine 的 step 函数得到这一步的 outputs,然后 append 到返回的 List 里。在step函数里,由scheduler获取本次要作为输入的 seq_group_metadata_list ,同时产生一个 scheduler_outputs。然后 engine 会调用 worker 的 execute_model 来执行对 seq_group_metadata_list 的模型前向计算。

这里的对于每个输入prompt,都会给llm engine生成一个request对应了llm_engine.add_request函数:

# add_request函数是LLMEngine类的一个方法,它接受一个请求并将其加入到scheduler的请求池中。

# 这个请求在调用engine.step()函数时由调度器进行处理,具体的调度策略由调度器决定。

def add_request(

self,

request_id: str, # 请求的唯一ID。

prompt: Optional[str], # prompt字符串。如果提供了prompt_token_ids,这个参数可以为None。

sampling_params: SamplingParams, # 用于文本生成的采样参数。

# prompt的token ID。如果它为None,则使用分词器将提示转换为token ID。

prompt_token_ids: Optional[List[int]] = None,

arrival_time: Optional[float] = None, # 请求的到达时间。如果为None,则使用当前时间。

) -> None:

if arrival_time is None:

arrival_time = time.time()

if prompt_token_ids is None:

assert prompt is not None

prompt_token_ids = self.tokenizer.encode(prompt)

# Create the sequences.

# 每一个序列代表一次独立的文本生成任务。它们的数量由sampling_params.best_of决定。

# 每个序列都包含了唯一的seq_id,提示和标记ID,以及block_size(块大小)。

block_size = self.cache_config.block_size

seqs: List[Sequence] = []

for _ in range(sampling_params.best_of):

seq_id = next(self.seq_counter)

seq = Sequence(seq_id, prompt, prompt_token_ids, block_size)

seqs.append(seq)

# 创建序列组(SequenceGroup)。一个序列组包含了一组相关的序列,

# 它们共享相同的请求ID和采样参数,并且在同一时间到达。

seq_group = SequenceGroup(request_id, seqs, sampling_params,

arrival_time)

# Add the sequence group to the scheduler.

# 将序列组添加到调度器中。这样,当调用engine.step()函数时,

# 调度器就可以根据它的调度策略处理这些序列组。

self.scheduler.add_seq_group(seq_group)

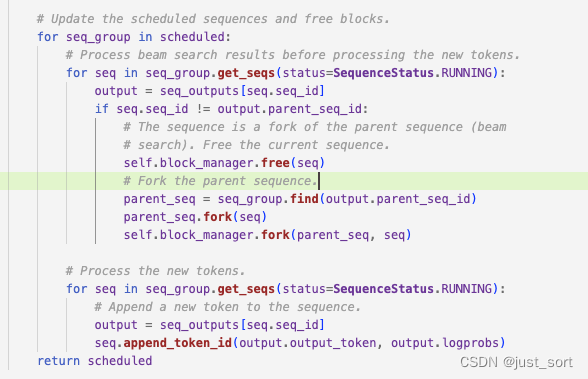

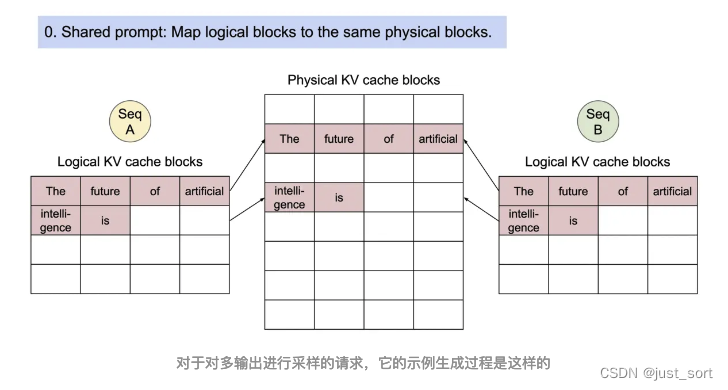

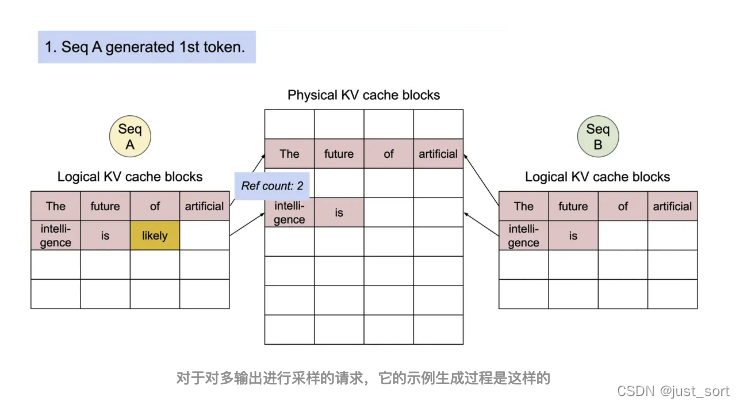

可以看到对于每个request vllm都会生成sampling_params.best_of个输出序列,在使用 beam search 时候这个参数也作为 beam width。这里有2个数据结构Sequence和SequenceGroup,对于每一个request我们都会构造sampling_params.best_of个Sequence,然后这些Sequence组成一个SequenceGroup。在构造 Sequence 的时候会给这个 Sequence 分配相应的 logical_token_blocks(是一个List[LogicalTokenBlock])。一个 LogicalTokenBlock对象对应 block_size 个 token ids。初始化的时候会把 token ids 分段存储在 logical blocks里面,但最后一个logical block可能是存不满的。SequenceGroup构造好之后会给到Scheduler(self.scheduler.add_seq_group(seq_group)),然后在llm_engine.step函数中seq_group_metadata_list, scheduler_outputs = self.scheduler.schedule()这行代码会把schdule出来的序列包装成SequenceGroupMetadata。接下来,在执行worker的execute_model函数时会通过_prepare_inputs转成 tokens_tensor,position_tensor 和 InputMetadata,然后execute_model函数实际上包含模型的前向推理和Sample过程,它的返回值数据集结构是Dict[int, SequenceOutputs],也就是 seq id -> 对应的输出,输出包含着 log prob。 这个输出会被传到 scheduler 的 update 接口,用于更新对应的 running sequences。最后这个Dict[int, SequenceOutputs]数据结构对象还会经过_decode_sequences并最终被包装成RequestOutput返回出来。接下来对Sequnence涉及到的数据结构进行代码解析:

"""Sequence and its related classes."""

import copy

import enum

from typing import Dict, List, Optional, Union

from vllm.block import LogicalTokenBlock

from vllm.sampling_params import SamplingParams

# 这行代码定义了一个新的枚举类SequenceStatus,它继承自Python的内置enum.Enum类。

class SequenceStatus(enum.Enum):

"""Status of a sequence."""

# 这些都是序列可能的状态。enum.auto()是一个方便的方法,用于自动分配枚举值。

WAITING = enum.auto() # 序列正在等待运行。

RUNNING = enum.auto() # 序列正在运行。

SWAPPED = enum.auto() # 序列已被交换

FINISHED_STOPPED = enum.auto() # 序列已经完成,并且是因为遇到停止标志而停止的。

FINISHED_LENGTH_CAPPED = enum.auto() # 序列已经完成,并且是因为达到最大长度限制而停止的。

FINISHED_ABORTED = enum.auto() # 序列已经完成,并且是因为某种异常或错误而中止的。

FINISHED_IGNORED = enum.auto() # 序列已经完成,但是被忽略了。

# 这是一个静态方法,接受一个序列状态作为输入,并返回该序列是否已经完成。

# 它通过检查状态是否在完成的状态列表中来做出决策。

@staticmethod

def is_finished(status: "SequenceStatus") -> bool:

return status in [

SequenceStatus.FINISHED_STOPPED,

SequenceStatus.FINISHED_LENGTH_CAPPED,

SequenceStatus.FINISHED_ABORTED,

SequenceStatus.FINISHED_IGNORED,

]

# 这也是一个静态方法,它返回一个序列完成的原因。如果序列没有完成,它返回None。

# 它使用一个简单的条件语句来决定完成的原因。

@staticmethod

def get_finished_reason(status: "SequenceStatus") -> Union[str, None]:

if status == SequenceStatus.FINISHED_STOPPED:

finish_reason = "stop"

elif status == SequenceStatus.FINISHED_LENGTH_CAPPED:

finish_reason = "length"

elif status == SequenceStatus.FINISHED_ABORTED:

finish_reason = "abort"

elif status == SequenceStatus.FINISHED_IGNORED:

finish_reason = "length"

else:

finish_reason = None

return finish_reason

# SequenceData类代表与序列关联的数据。

class SequenceData:

"""Data associated with a sequence.

Args:

prompt_token_ids: The token IDs of the prompt.

Attributes:

prompt_token_ids: The token IDs of the prompt.

output_token_ids: The token IDs of the output.

cumulative_logprob: The cumulative log probability of the output.

"""

# 在初始化方法中,对象接收提示的token IDs(prompt_token_ids)作为参数,并初始化了

# 两个其他属性:输出的token IDs(output_token_ids)和累积的对数概率(cumulative_logprob)。

def __init__(

self,

prompt_token_ids: List[int],

) -> None:

self.prompt_token_ids = prompt_token_ids

self.output_token_ids: List[int] = []

self.cumulative_logprob = 0.0

# 此方法接收一个token ID和其对应的对数概率,然后将token添加到output_token_ids列表,并累积对数概率。

def append_token_id(self, token_id: int, logprob: float) -> None:

self.output_token_ids.append(token_id)

self.cumulative_logprob += logprob

# 这个方法返回整个序列(提示+输出)的长度。

def get_len(self) -> int:

return len(self.output_token_ids) + len(self.prompt_token_ids)

# 此方法仅返回输出的长度。

def get_output_len(self) -> int:

return len(self.output_token_ids)

# 该方法返回整个token ID序列,包括提示和输出。

def get_token_ids(self) -> List[int]:

return self.prompt_token_ids + self.output_token_ids

# 此方法返回整个序列的最后一个token ID。如果没有输出,它会返回提示的最后一个token。

def get_last_token_id(self) -> int:

if not self.output_token_ids:

return self.prompt_token_ids[-1]

return self.output_token_ids[-1]

# 此方法提供了SequenceData对象的字符串表示形式,有助于调试和可读性。

def __repr__(self) -> str:

return (f"SequenceData("

f"prompt_token_ids={self.prompt_token_ids}, "

f"output_token_ids={self.output_token_ids}, "

f"cumulative_logprob={self.cumulative_logprob})")

# 这个类Sequence存储了一个序列的数据、状态和块信息。

class Sequence:

"""Stores the data, status, and block information of a sequence.

Args:

seq_id: The ID of the sequence.

prompt: The prompt of the sequence.

prompt_token_ids: The token IDs of the prompt.

block_size: The block size of the sequence. Should be the same as the

block size used by the block manager and cache engine.

"""

# 对象初始化时需要序列ID、prompt、prompt_token_ids和块大小作为参数。

def __init__(

self,

seq_id: int,

prompt: str,

prompt_token_ids: List[int],

block_size: int,

) -> None:

self.seq_id = seq_id

self.prompt = prompt

self.block_size = block_size

# 它还为序列设置了其他初始属性,如数据(使用SequenceData类)、

# 输出的对数概率、输出的token和输出文本。

self.data = SequenceData(prompt_token_ids)

self.output_logprobs: List[Dict[int, float]] = []

self.output_tokens: List[str] = []

self.output_text = ""

self.logical_token_blocks: List[LogicalTokenBlock] = []

# Initialize the logical token blocks with the prompt token ids.

self._append_tokens_to_blocks(prompt_token_ids)

self.status = SequenceStatus.WAITING

# 为logical_token_blocks列表添加新的LogicalTokenBlock。

def _append_logical_block(self) -> None:

block = LogicalTokenBlock(

block_number=len(self.logical_token_blocks),

block_size=self.block_size,

)

self.logical_token_blocks.append(block)

# 这个方法的目的是将给定的token_ids逐个添加到逻辑token块中。

def _append_tokens_to_blocks(self, token_ids: List[int]) -> None:

# 设置一个cursor变量为0,它用于迭代token_ids列表。

cursor = 0

while cursor < len(token_ids):

# 首先检查是否已经存在任何逻辑token块。如果没有,

# 则调用_append_logical_block方法添加一个新块。

if not self.logical_token_blocks:

self._append_logical_block()

# 获取logical_token_blocks的最后一个块。

last_block = self.logical_token_blocks[-1]

# 如果这个块已经满了(没有空位放置新tokens),那么就添加一个新块。

if last_block.is_full():

self._append_logical_block()

last_block = self.logical_token_blocks[-1]

# 计算上一个块中的空槽数量。

num_empty_slots = last_block.get_num_empty_slots()

# 添加尽可能多的token_ids到最后一个块中,不超过块的容量。

last_block.append_tokens(token_ids[cursor:cursor +

num_empty_slots])

# 更新cursor,使其指向下一个尚未处理的token。

cursor += num_empty_slots

# 将一个token ID及其对应的对数概率添加到序列中:

def append_token_id(

self,

token_id: int,

logprobs: Dict[int, float],

) -> None:

# 断言确保给定的token_id存在于logprobs字典中。

assert token_id in logprobs

# 断言确保给定的token_id存在于logprobs字典中。

self._append_tokens_to_blocks([token_id])

# 将logprobs添加到output_logprobs列表。

self.output_logprobs.append(logprobs)

# 更新data对象,添加token ID和其对数概率。

self.data.append_token_id(token_id, logprobs[token_id])

def get_len(self) -> int: # 返回整个序列的长度。

return self.data.get_len()

def get_output_len(self) -> int: # 返回序列输出的长度。

return self.data.get_output_len()

def get_token_ids(self) -> List[int]: # 返回整个token ID序列。

return self.data.get_token_ids()

def get_last_token_id(self) -> int: # 返回整个序列的最后一个token ID。

return self.data.get_last_token_id()

def get_output_token_ids(self) -> List[int]: # 返回序列输出的token IDs。

return self.data.output_token_ids

def get_cumulative_logprob(self) -> float: # 返回输出的累积对数概率。

return self.data.cumulative_logprob

def is_finished(self) -> bool: # 检查该序列是否已完成。

return SequenceStatus.is_finished(self.status)

# 这个方法用于创建一个当前序列的复制,并将其设置到另一个序列对象中。

# 它会深度复制当前序列的逻辑token块、输出对数概率和数据。

def fork(self, child_seq: "Sequence") -> None:

child_seq.logical_token_blocks = copy.deepcopy(

self.logical_token_blocks)

child_seq.output_logprobs = copy.deepcopy(self.output_logprobs)

child_seq.data = copy.deepcopy(self.data)

# 提供了Sequence对象的字符串表示形式,用于调试和可读性。

def __repr__(self) -> str:

return (f"Sequence(seq_id={self.seq_id}, "

f"status={self.status.name}, "

f"num_blocks={len(self.logical_token_blocks)})")

# 这是一个名为SequenceGroup的类,表示从相同提示生成的一组序列。

class SequenceGroup:

"""SequenceGroup表示从同一提示生成的序列集合。它有以下属性:

Args:

request_id: 请求的ID。

seqs: 序列列表。

sampling_params: 用于生成输出的采样参数。

arrival_time: 请求的到达时间。

"""

# 初始化方法设置了上述描述的属性。当创建一个SequenceGroup对象时,这些属性必须由用户提供。

def __init__(

self,

request_id: str,

seqs: List[Sequence],

sampling_params: SamplingParams,

arrival_time: float,

) -> None:

self.request_id = request_id

self.seqs = seqs

self.sampling_params = sampling_params

self.arrival_time = arrival_time

# 根据给定的状态返回序列列表。

def get_seqs(

self,

status: Optional[SequenceStatus] = None,

) -> List[Sequence]:

# 如果没有提供状态(默认为None),则返回所有序列。

if status is None:

return self.seqs

# 否则,返回具有给定状态的序列。

else:

return [seq for seq in self.seqs if seq.status == status]

# 返回具有给定状态的序列数量。如果没有提供状态,则返回所有序列的数量。

def num_seqs(self, status: Optional[SequenceStatus] = None) -> int:

return len(self.get_seqs(status))

# 在序列组中查找具有给定ID的序列。

def find(self, seq_id: int) -> Sequence:

for seq in self.seqs:

if seq.seq_id == seq_id:

return seq

raise ValueError(f"Sequence {seq_id} not found.")

# 检查序列组中的所有序列是否都已完成。

def is_finished(self) -> bool:

return all(seq.is_finished() for seq in self.seqs)

# 返回SequenceGroup对象的字符串表示形式,通常用于调试和可读性。

# 这将提供关于请求ID、采样参数和序列数量的简要信息。

def __repr__(self) -> str:

return (f"SequenceGroup(request_id={self.request_id}, "

f"sampling_params={self.sampling_params}, "

f"num_seqs={len(self.seqs)})")

# 这是一个名为SequenceGroupMetadata的类,它表示序列组的元数据。

# 这个类的主要目的是为了保存与特定SequenceGroup关联的元数据,可以用来创建InputMetadata。

class SequenceGroupMetadata:

"""Metadata for a sequence group. Used to create `InputMetadata`.

Args:

request_id: The ID of the request.

is_prompt: Whether the request is at prompt stage.

seq_data: The sequence data. (Seq id -> sequence data)

sampling_params: The sampling parameters used to generate the outputs.

block_tables: The block tables. (Seq id -> list of physical block

numbers)

"""

# 初始化方法会接收上述属性作为参数,并将它们设置为类的属性。

# 这意味着当你创建一个SequenceGroupMetadata对象时,必须提供这些参数。

def __init__(

self,

request_id: str,

is_prompt: bool,

seq_data: Dict[int, SequenceData],

sampling_params: SamplingParams,

block_tables: Dict[int, List[int]],

) -> None:

self.request_id = request_id

self.is_prompt = is_prompt

self.seq_data = seq_data

self.sampling_params = sampling_params

self.block_tables = block_tables

# 这是一个名为SequenceOutputs的类,代表与一个序列关联的模型输出。

class SequenceOutputs:

"""The model output associated with a sequence.

Args:

seq_id: The ID of the sequence.

parent_seq_id: The ID of the parent sequence (for forking in beam

search).

output_token: The output token ID.

logprobs: The logprobs of the output token.

(Token id -> logP(x_i+1 | x_0, ..., x_i))

"""

def __init__(

self,

seq_id: int, # 表示序列的ID。

# 表示父序列的ID。在进行如束搜索(beam search)这样的算法时,

# 可能会"分叉"或"分裂"序列,此时,新序列将具有一个"父序列"。

parent_seq_id: int,

output_token: int,

logprobs: Dict[int, float],

) -> None:

self.seq_id = seq_id

self.parent_seq_id = parent_seq_id

self.output_token = output_token # 输出的token ID。

# 这是一个字典,表示输出token的对数概率。键是token的ID,

# 值是给定先前所有token后,下一个token是当前token的对数概率。

self.logprobs = logprobs

def __repr__(self) -> str:

return (f"SequenceOutputs(seq_id={self.seq_id}, "

f"parent_seq_id={self.parent_seq_id}, "

f"output_token={self.output_token}), "

f"logprobs={self.logprobs}")

# 这是一个特殊的方法,允许对象进行等值比较。它定义了当两个SequenceOutputs对象

# 是否应该被认为是"相等"的条件。

def __eq__(self, other: object) -> bool:

if not isinstance(other, SequenceOutputs):

return NotImplemented

return (self.seq_id == other.seq_id

and self.parent_seq_id == other.parent_seq_id

and self.output_token == other.output_token

and self.logprobs == other.logprobs)

对于一个Sequence对象来说,它会被加到一个或者多个LogicalTokenBlock中,我们这里也简单解析一下LogicalTokenBlock和PhysicalTokenBlock的定义代码。

"""Token blocks."""

from typing import List

from vllm.utils import Device

# 这定义了一个私有常数_BLANK_TOKEN_ID,其值为-1。此常数用于在逻辑块中表示空位置。

_BLANK_TOKEN_ID = -1

# 这个类表示了一个逻辑块,其设计用于在KV Cache中代表相应的物理块的状态。

class LogicalTokenBlock:

"""A block that stores a contiguous chunk of tokens from left to right.

Logical blocks are used to represent the states of the corresponding

physical blocks in the KV cache.

"""

def __init__(

self,

block_number: int, # 表示此块的编号。

block_size: int, # 块的大小,即块可以容纳的最大token数量。

) -> None:

self.block_number = block_number

self.block_size = block_size

# 存储在这个块中的token的ID。初始化为_BLANK_TOKEN_ID的列表,长度为block_size。

self.token_ids = [_BLANK_TOKEN_ID] * block_size

# 块中当前token的数量。

self.num_tokens = 0

# 判断块是否为空。如果num_tokens为0,则块为空。

def is_empty(self) -> bool:

return self.num_tokens == 0

# 获取块中的空闲位置数量。这通过块的总大小和当前的token数量计算得出。

def get_num_empty_slots(self) -> int:

return self.block_size - self.num_tokens

# 判断块是否已满。如果num_tokens等于块的大小,则块已满。

def is_full(self) -> bool:

return self.num_tokens == self.block_size

# 将token ID列表追加到块中。函数首先检查新添加的token数量是否超出了块的空闲空间,

# 然后将新的token追加到块中,并更新num_tokens。

def append_tokens(self, token_ids: List[int]) -> None:

assert len(token_ids) <= self.get_num_empty_slots()

curr_idx = self.num_tokens

self.token_ids[curr_idx:curr_idx + len(token_ids)] = token_ids

self.num_tokens += len(token_ids)

# 获取存储在块中的token的ID列表。

def get_token_ids(self) -> List[int]:

return self.token_ids[:self.num_tokens]

# 获取块中的最后一个token的ID。如果块是空的,则会引发断言错误。

def get_last_token_id(self) -> int:

assert self.num_tokens > 0

return self.token_ids[self.num_tokens - 1]

# 这段代码定义了一个名为PhysicalTokenBlock的类。这个类代表KV Cache中一个块的状态。

class PhysicalTokenBlock:

"""Represents the state of a block in the KV cache."""

def __init__(

self,

device: Device,

block_number: int,

block_size: int,

) -> None:

self.device = device # 表示此块所在的设备,如CPU、GPU等。具体类型为Device,

self.block_number = block_number # 这是块的编号,用于识别或索引它。

self.block_size = block_size # 块的大小。这可能代表块可以容纳的数据量。

self.ref_count = 0 # 引用计数,通常用于跟踪有多少其他对象或操作正在引用或使用此物理块

def __repr__(self) -> str:

return (f'PhysicalTokenBlock(device={self.device}, '

f'block_number={self.block_number}, '

f'ref_count={self.ref_count})')

这一节介绍的Sequence相关的数据结构和Block相关的数据结构本质上都是在为Scheduler服务,来一起完成Paged Attention的内存管理功能。下一节我们对Scheduler也叫vllm的调度策略进行解析,它也包含了对在这里定义的Block的管理细节。

0x5. Scheduler

有了上面的铺垫,接下来我们可以对Scheduler进行解析了,对应源码在vllm/vllm/core/scheduler.py。在解析Scheduler的代码实现之前,我们解析一下vllm/vllm/core/目录下的policy.py和block_manager.py,它们分别负责实现Scheduler的队列中的优先法则以及KV Cache块的管理过程,并且实现都非常简单和简短。

首先来看 vllm/vllm/core/policy.py:

# 这是一个抽象的策略类。

class Policy:

# 计算一个 SequenceGroup 的优先级。子类需要重写这个方法来提供具体的优先级计算逻辑。

def get_priority(

self,

now: float,

seq_group: SequenceGroup,

) -> float:

raise NotImplementedError

# 根据优先级对一组 SequenceGroup 进行排序。这是一个通用方法,使用了前面的 get_priority() 方法。

def sort_by_priority(

self,

now: float,

seq_groups: List[SequenceGroup],

) -> List[SequenceGroup]:

return sorted(

seq_groups,

key=lambda seq_group: self.get_priority(now, seq_group),

reverse=True,

)

# 这是 Policy 的一个具体子类,它实现了先到先得(First-Come-First-Serve, FCFS)的调度策略。

# 它重写了 get_priority() 方法,以便为每个 SequenceGroup 分配一个与其到达时间相关的优先级。

# 此处,优先级是当前时间减去序列组的到达时间,这意味着越早到达的 SequenceGroup 优先级越高。

class FCFS(Policy):

def get_priority(

self,

now: float,

seq_group: SequenceGroup,

) -> float:

return now - seq_group.arrival_time

# 这是一个工厂类,用于创建和返回特定的策略对象。它使用一个名为 _POLICY_REGISTRY

# 的字典来注册策略类,其中键是策略的名称(如 'fcfs'),值是相应的策略类。

class PolicyFactory:

_POLICY_REGISTRY = {

'fcfs': FCFS,

}

# get_policy(): 是一个类方法,它接受策略名称作为参数,

# 查找 _POLICY_REGISTRY 字典并返回对应的策略对象实例。

@classmethod

def get_policy(cls, policy_name: str, **kwargs) -> Policy:

return cls._POLICY_REGISTRY[policy_name](**kwargs)

接下来解析一下 vllm/vllm/core/block_manager.py :

"""A block manager that manages token blocks."""

from typing import Dict, List, Optional, Set, Tuple

from vllm.block import PhysicalTokenBlock

from vllm.sequence import Sequence, SequenceGroup, SequenceStatus

from vllm.utils import Device

# 这段代码定义了一个 BlockAllocator 类,它管理设备上的PhysicalTokenBlock的分配和释放