在报告《交互式建模与学习:重建人类运动功能》中,清华大学副教授眭亚楠介绍了AI在重建人类运动功能时,从无模型学习(model-free learning)到基于模型学习(model-based learning)的转变,以及在现实世界中如何确保安全性和提高采样效率。他提到,早期的技术路线从无模型学习出发,针对物理世界的控制问题进行无模型的在线强化学习,技术上主要关注安全性(safety)、偏好(preference)、以及采样效率(sample efficiency)。

在报告《交互式建模与学习:重建人类运动功能》中,清华大学副教授眭亚楠介绍了AI在重建人类运动功能时,从无模型学习(model-free learning)到基于模型学习(model-based learning)的转变,以及在现实世界中如何确保安全性和提高采样效率。他提到,早期的技术路线从无模型学习出发,针对物理世界的控制问题进行无模型的在线强化学习,技术上主要关注安全性(safety)、偏好(preference)、以及采样效率(sample efficiency)。

在线强化学习非常有潜力,但需要面对未知的安全风险:在线安全强化学习,可以归约为一个约束优化问题。需要在每一步采样时满足约束条件,需要确保在整个优化过程中,安全约束都不被破坏。未知的安全约束可能会破坏评估过程,进而影响整个强化学习的循环。为了解决安全约束问题,需要引入安全探索的概念。在安全边界内进行探索和利用,并尽量扩大已知的安全边界。

在实际应用中,利用人类偏好反馈是一个重要问题。通过引入两两比较和贝叶斯偏好模型等方法,可以在在线强化学习中更好地处理这些问题。两两比较可以让用户在给定两个选项时选择哪个更好;通过贝叶斯偏好模型,可以构建空间的连续性和输入空间或动作空间之间的关联性。

眭亚楠在报告中进一步讨论了在线优化过程的应用,以及如何在实际场景中解决神经控制和运动功能问题。他提到,通过对神经系统的调控,可以帮助截瘫患者站起来,以及恢复高位截瘫患者的手部抓握能力。

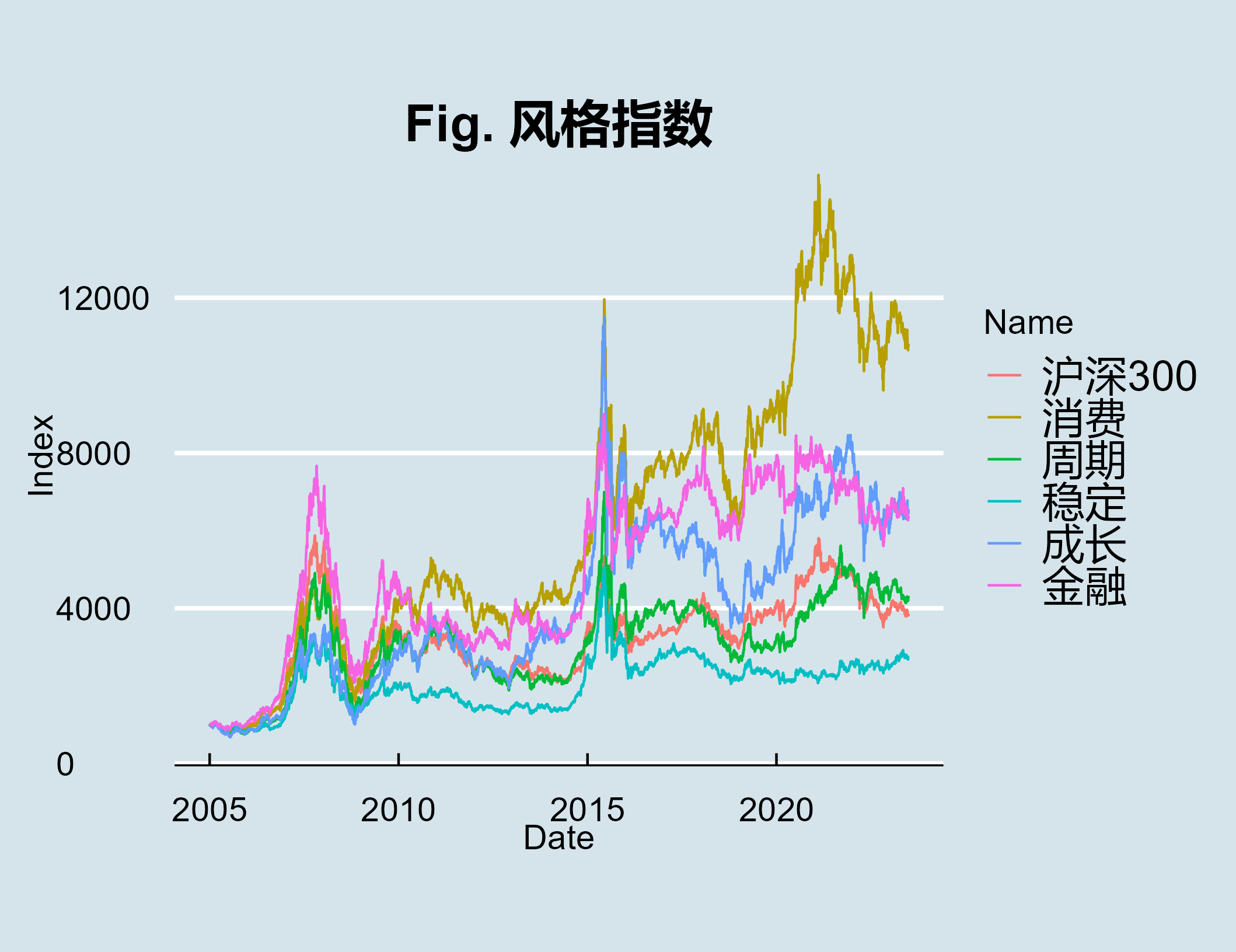

具身智能从构建世界模型(world model)延伸到构建人类自身模型(self model),通过神经-肌肉-骨骼系统建模,可以更准确地描述、理解和控制人的运动功能,为人类运动功能的重建带来更多可能性。