5分钟了解预训练、微调和上下文学习

- 什么是预训练?

- 什么是微调?

- 什么是上下文学习?

- 相关资料

近年来大语言模型在自然语言理解和生成方面、多模态学习等方面取得了显著进展。这些模型通过

预训练、

微调和

上下文学习的组合来学习。本文将快速介绍这三种主要方法,了解它们之间的差异,并探讨它们如何有助于语言模型的学习过程。

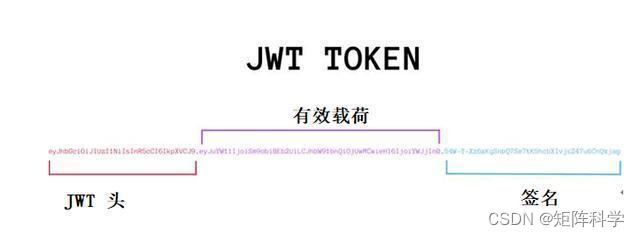

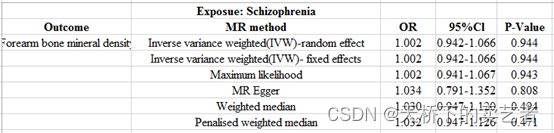

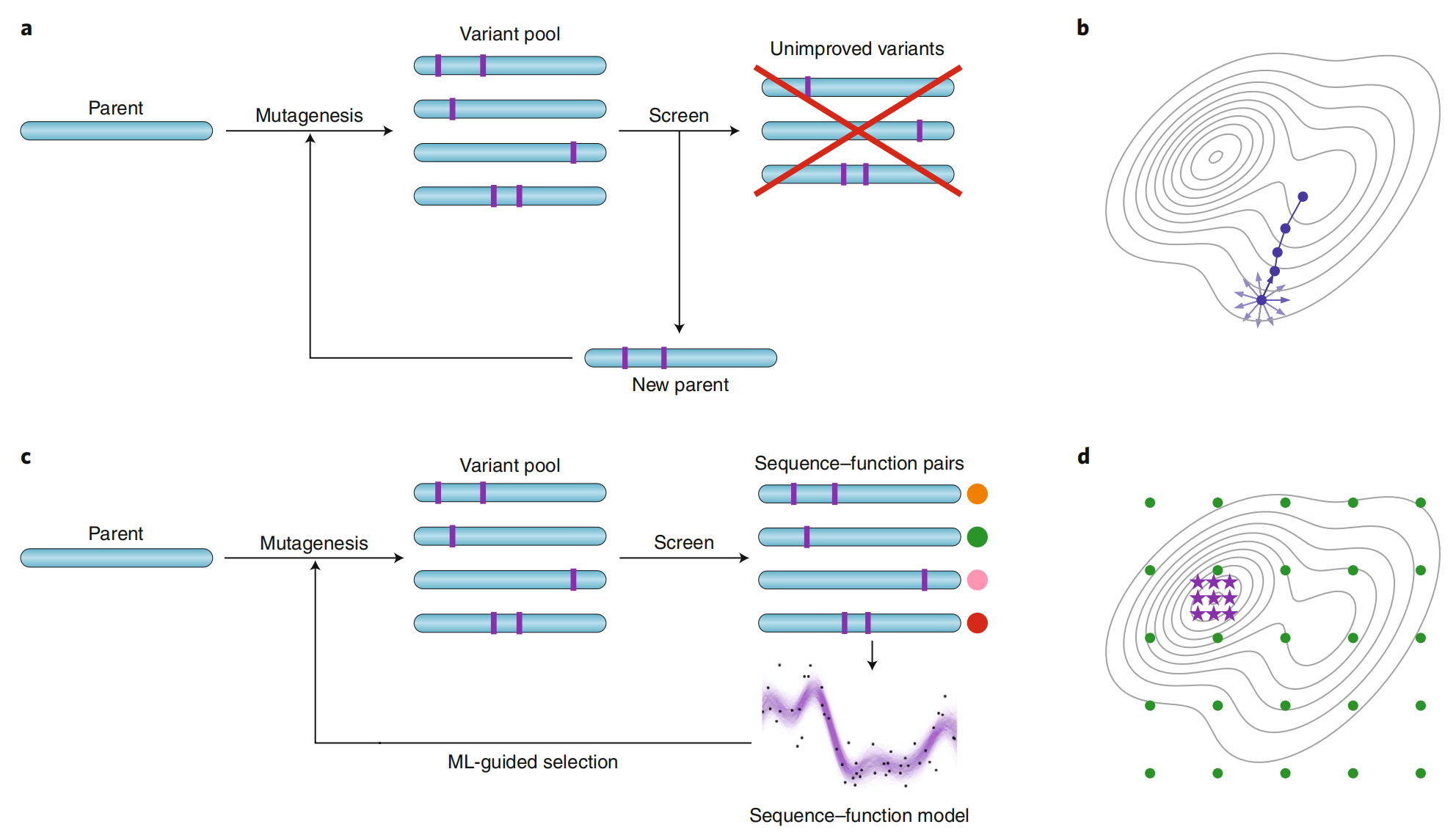

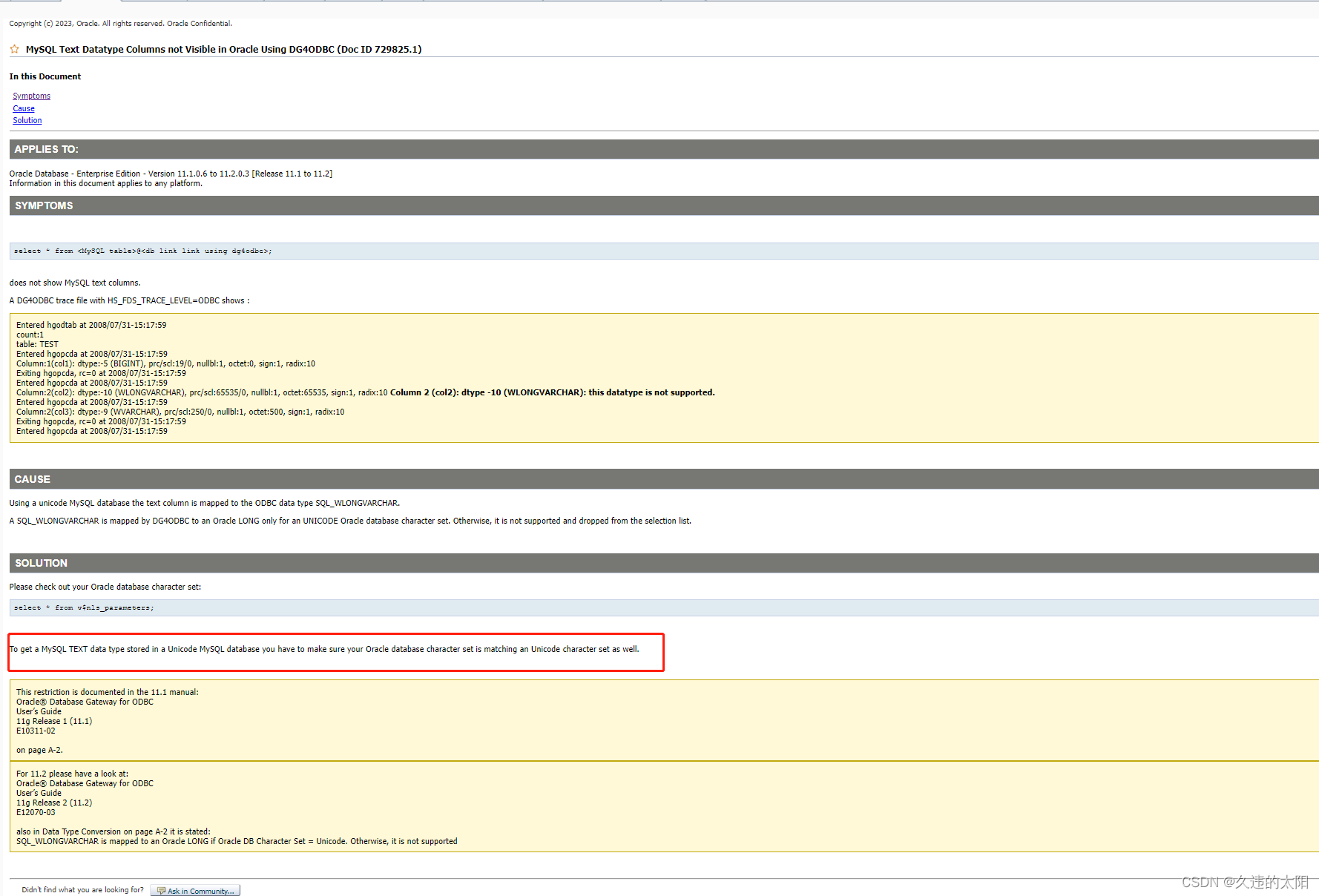

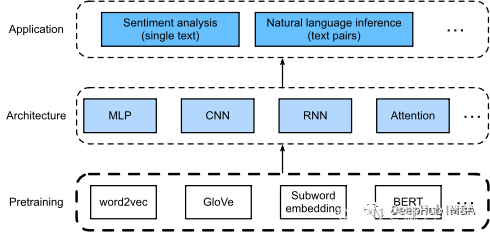

图1:预训练和微调的区别

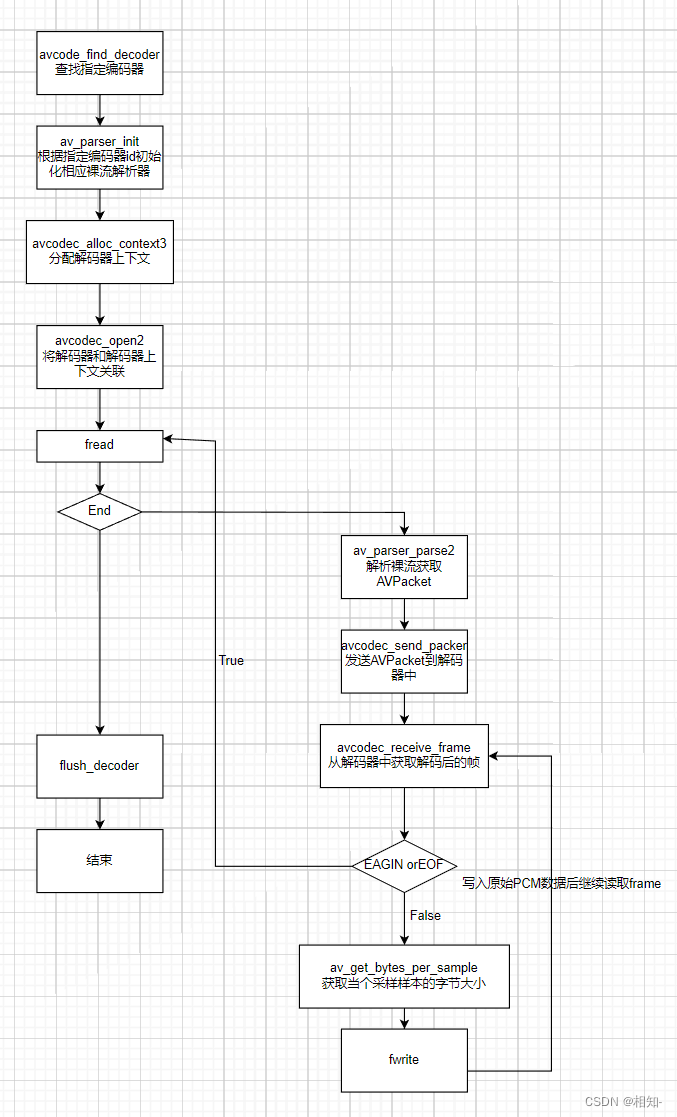

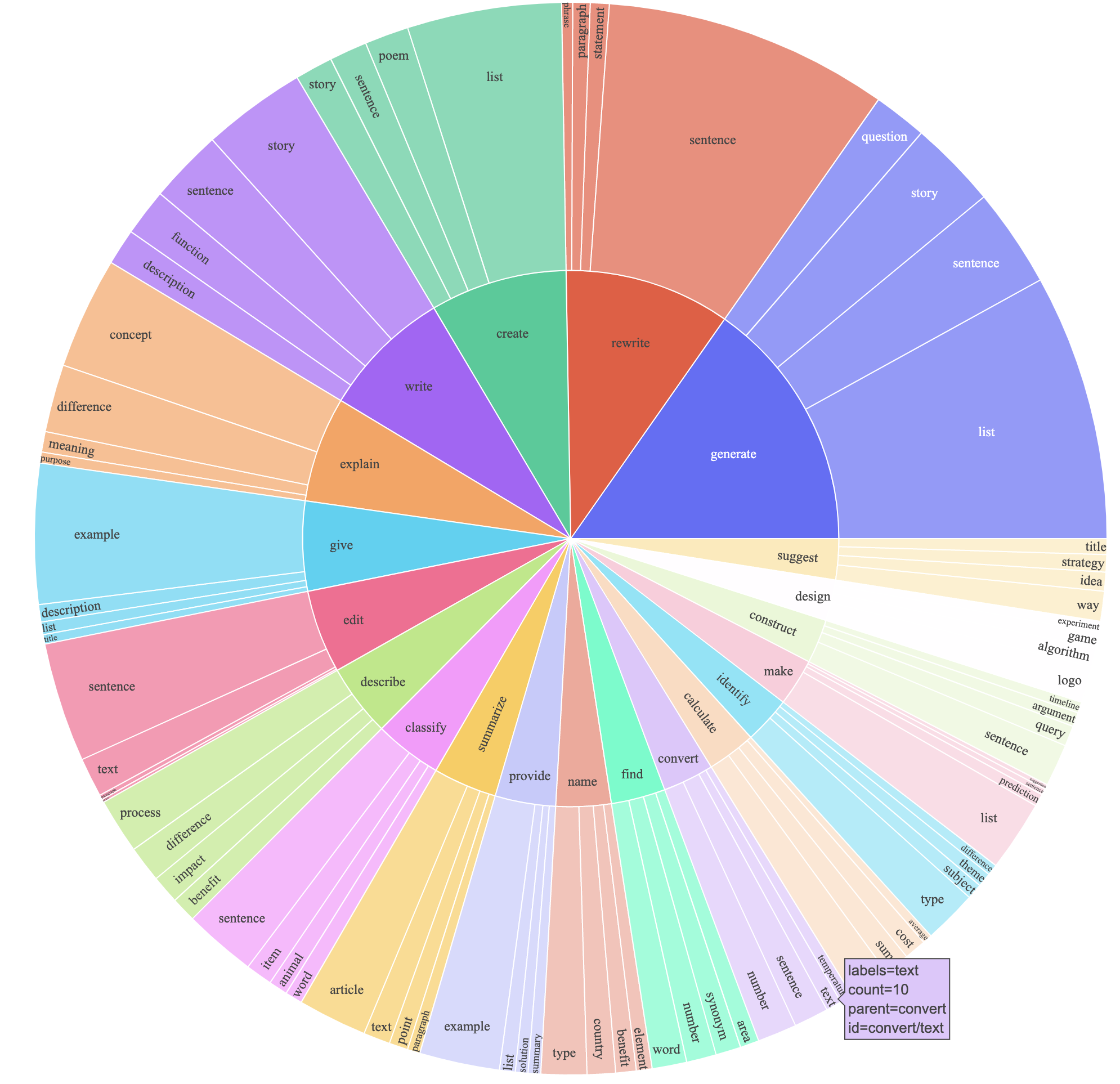

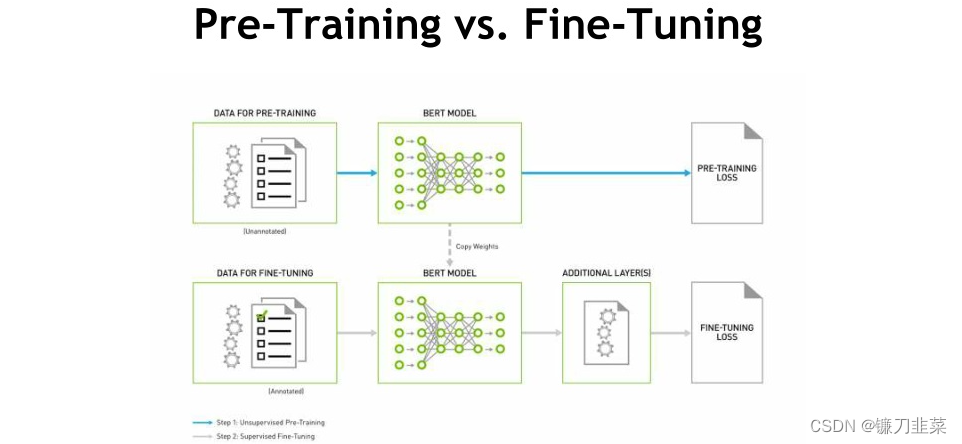

图2:预训练、微调和上下文学习的关系

什么是预训练?

预训练(Pre-training)是语言模型学习的初始阶段。在预训练期间,模型会接触到大量未标记的文本数据,例如书籍、文章和网站。在大量未标记文本数据上训练语言模型。比如说在包含数百万本书、文章和网站的数据集上预训练像 GPT-3 这样的语言模型。预训练目标是捕获文本语料库中存在的底层模式、结构和语义知识。

预训练(Pre-training)是指在目标任务之前,使用大规模数据集和无监督学习的方法对模型进行初始训练。在预训练阶段,模型通过学习输入数据的内部表示来获取知识和特征,以便在后续的具体任务上进行微调或迁移学习。

预训练通常是在无标签数据上进行的,这意味着训练数据不带有人工标注的目标输出。这种无监督的学习过程使得模型可以从大规模数据中提取有用的特征和模式,而无需人工标注的标签信息。

预训练的主要目的是通过大规模无监督学习来为模型提供初始的参数和表示。通常采用的方法是自编码器(autoencoder)或生成对抗网络(generative adversarial network, GAN)等。这些方法可以通过最大化数据的重构误差或通过生成与真实数据相似的样本来学习有效的特征表示。

预训练的主要特点:

- 无监督学习:预训练通常是一个无监督学习过程,模型在没有明确指导或标签的情况下从未标记的文本数据中学习。

- Masked Language Modeling:模型经过训练以预测句子中缺失或屏蔽的单词,学习上下文关系并捕获语言模式。

- Transformer 架构:预训练通常采用基于 Transformer 的架构,因为这种架构擅长捕获远程依赖关系和上下文信息。

预训练在自然语言处理(NLP)和计算机视觉(CV)等领域取得了很大的成功。例如,在NLP中,预训练的模型(如BERT、GPT)可以在大规模无监督的语料库上学习语言模型,然后通过微调在特定的下游任务上获得显著的性能提升。在CV领域,预训练的模型(如ImageNet预训练模型)可以在大规模图像数据上学习低级视觉特征,然后在目标识别、目标检测等任务上进行微调。

预训练的主要下游任务如下:

- 文本生成:预训练模型可以生成连贯且上下文相关的文本,使它们对聊天机器人、虚拟助手和内容生成等应用程序有价值。

- 语言翻译:预训练模型可以针对机器翻译任务进行微调,使它们能够准确地将文本从一种语言翻译成另一种语言。

- 情感分析:通过对带有情感标签的数据集的预训练模型进行微调,它们可用于对文本输入的情感进行分类,协助完成客户反馈分析和社交媒体监控等任务。

- 命名实体识别:可以对预训练模型进行微调,以从文本中识别和提取命名实体,从而促进新闻文章或法律文件中的实体识别等任务。

总的来说,预训练是一种利用大规模无监督学习的方法,通过学习数据的内部表示来为模型提供初始参数和特征表示,为后续的具体任务提供更好的初始状态,从而提高模型的性能和泛化能力。

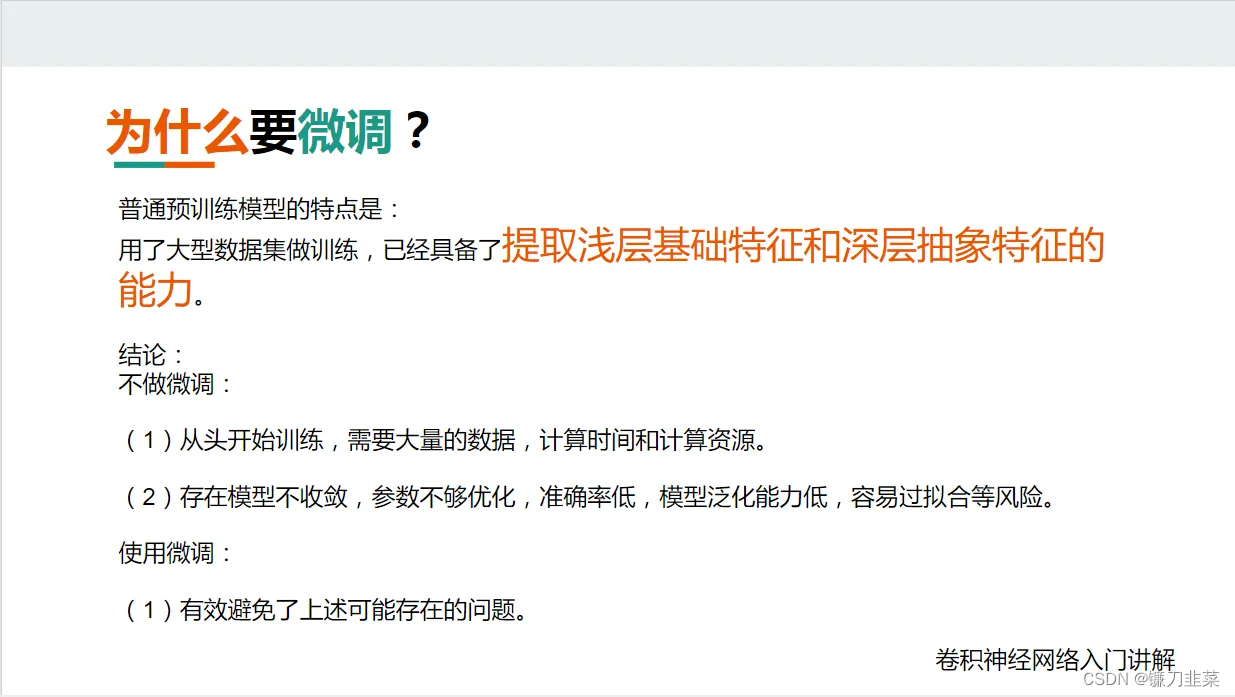

什么是微调?

微调(Fine-Tuning)是在特定任务或领域上进一步训练大型语言模型(LLM)的过程。这可以通过使用预训练的LLM作为起点,然后在特定任务或领域的标记数据集上训练它来完成。微调可以通过调整模型的权重来更好地拟合数据,从而提高LLM在特定任务或领域上的性能。

微调(Fine-tuning)是指在预训练(Pre-training)阶段之后,使用特定任务的有标签数据对模型进行进一步的训练和调整参数,以使其在目标任务上获得更好的性能。

在微调过程中,预训练得到的模型参数作为初始状态,然后在特定任务的有标签数据上进行训练。通常,只有少量的有标签数据可用于微调,这使得模型能够更好地适应目标任务的特定要求。

微调的关键是调整预训练模型的参数,以使其更好地适应目标任务的特定领域或数据分布。这个过程通常包括以下几个步骤:

- 冻结部分参数:为了保持预训练模型的初始表示能力,通常会冻结部分参数,特别是底层的参数,使其在微调过程中保持不变。这样可以避免较大的参数更新,防止过度调整模型的初始表示。

- 更新顶层参数:针对目标任务的特定要求,通常会添加一个或多个新的层,这些层称为顶层(top layers)。这些顶层将与预训练模型连接,并根据目标任务的标签数据进行训练。在微调过程中,主要是更新这些顶层参数,以使其适应目标任务的特定输出。

- 调整参数:在微调过程中,通过反向传播算法和优化方法(如随机梯度下降),根据目标任务的损失函数来调整模型的参数。由于预训练模型已经通过大规模无监督学习进行了初始化,微调过程通常只需要较少的训练数据和较少的迭代次数。

微调的目标是将预训练模型的泛化能力与目标任务的特定要求相结合,从而获得更好的性能。通过使用预训练模型的特征表示和参数初始化,微调可以加快模型在目标任务上的收敛速度,并提供更好的泛化能力。

微调广泛应用于自然语言处理(NLP)、计算机视觉(CV)和其他机器学习领域。例如,在NLP中,预训练模型(如BERT、GPT)可以通过微调在特定的下游任务上获得显著的性能提升。在CV领域,通过微调预训练模型(如ImageNet预训练模型),可以在特定的目标识别、目标检测任务上获得更好的结果。

- 监督微调(Supervised Fine-Tuning):SFT使用标记数据来训练LLM。标记的数据由输入和输出数据对组成。输入数据是LLM将得到的数据,输出数据是LLM期望生成的数据。SFT是一种相对简单和有效的方法来微调LLM。

- 基于人类反馈的强化学习(Reinforcement Learning from Human Feedback):RLHF使用人类反馈来训练LLM。反馈可以通过多种方式收集,例如调查、访谈或用户研究。RLHF是一种更复杂、更耗时的方法来微调LLM,但它比SFT更有效。

应该使用哪种方法?

微调 LLM 的最佳方法取决于许多因素,例如标记数据的可用性、可用时间和资源以及所需的性能。如果有很多可用的标记数据,SFT 是一个不错的选择。但是如果没有可用的标记数据,或者如果需要将 LLM 的性能提高到 SFT 无法达到的水平,RLHF 是一个不错的选择,但是RLHF 需要更多的事件和后期的人工参与。

微调的好处

微调可以提高 LLM 在特定任务或领域上的性能,可以为自然语言生成、问答和翻译等任务带来更好的结果。微调还可以使 LLM 更具可解释性,这有助于调试和理解模型的行为。

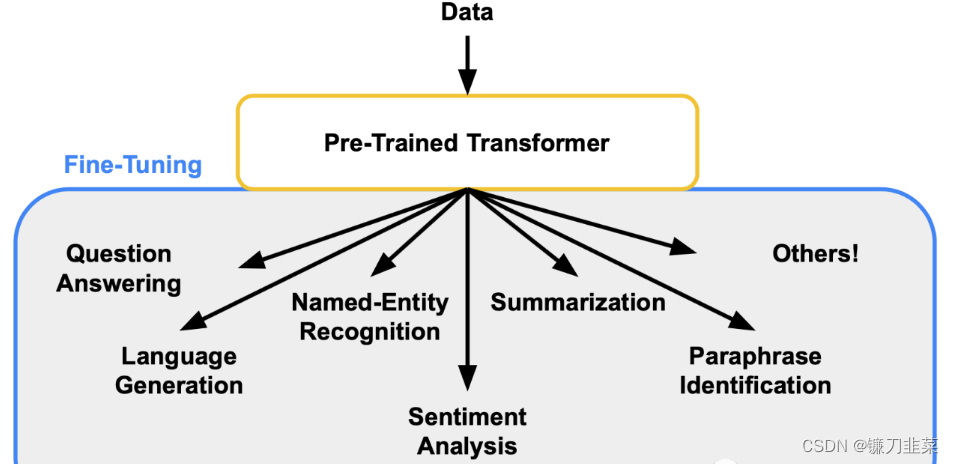

简而言之,Fine-tuning 是语言模型学习过程中的后续步骤。在经过预训练后,模型根据特定于任务的标记数据进行微调,以使其知识适应特定的下游任务。

- 迁移学习:微调利用迁移学习,其中模型将学习到的表示从预训练转移到目标任务。

- 特定于任务的数据:模型在特定于目标任务的标记数据上进行训练,例如带有情感标记的句子或问答对。

- 基于梯度的优化:微调通常涉及基于梯度的优化技术,以根据特定于任务的数据更新模型的参数。

微调使模型能够在各种特定的自然语言处理任务中表现出色,包括情感分析、问题回答、机器翻译和文本生成。像BERT这样的预训练语言模型可以在标有积极或消极情绪的客户评论数据集上进行微调。一般的微调任务如下:

- 情感分析:微调模型可以用于情感分析任务,例如分析客户评论、社交媒体情感监控和市场研究。

- 文本分类:微调允许模型将文本分类到预定义的类别中,从而支持主题分类、垃圾邮件检测和文档分类等应用程序。

- 问答:通过对问答对进行微调,可以使用模型根据给定的上下文回答特定的问题,帮助完成客户支持和信息检索等任务。

总的来说,微调是在预训练之后使用特定任务的有标签数据对模型进行进一步训练和调整参数的过程,以使其在目标任务上获得更好的性能。通过结合预训练模型的表示能力和特定任务的调整,微调可以提高模型的适应能力和泛化能力。

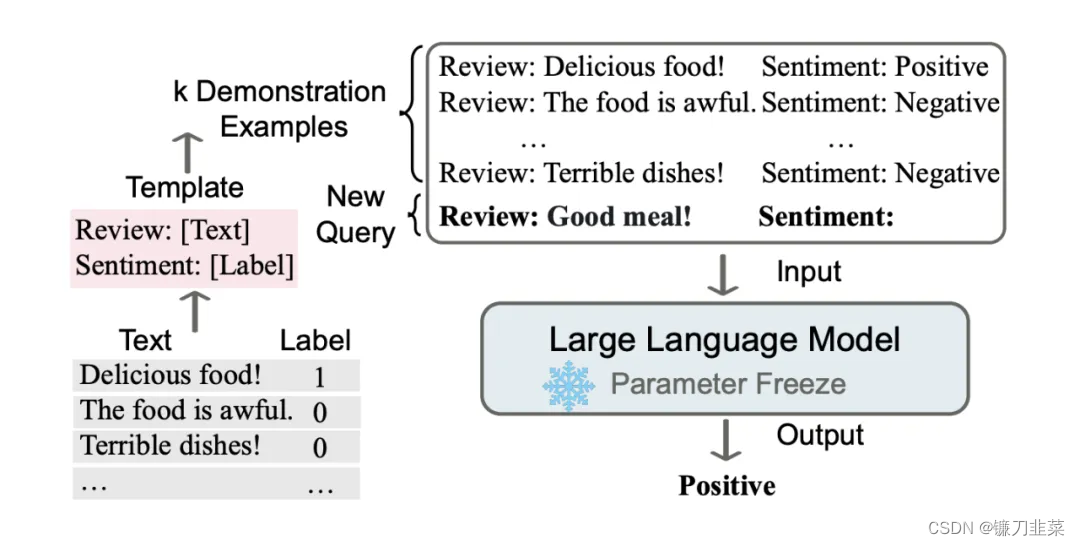

什么是上下文学习?

上下文学习(In-Context Learning)也可以翻译成情境学习:是一种新兴的方法,它结合了预训练和微调,同时在训练过程中结合特定任务的指令或提示。模型学会根据给定的指令生成与上下文相关的响应或输出,从而提高它们在特定任务中的表现。

In Context Learning(ICL)的关键思想是从类比中学习。上图给出了一个描述语言模型如何使用 ICL 进行决策的例子。首先,ICL 需要一些示例来形成一个演示上下文。这些示例通常是用自然语言模板编写的。然后 ICL 将查询的问题(即你需要预测标签的 input)和一个上下文演示(一些相关的 cases)连接在一起,形成带有提示的输入,并将其输入到语言模型中进行预测。

- 上下文提示:上下文学习包括提供明确的指令或提示,以指导模型在生成响应或输出时的行为。

- 强化学习或结构化反馈:上下文学习可以结合强化学习技术或结构化反馈来指导模型的响应。

- 迭代训练:模型经历多次迭代训练,接收反馈并根据提供的提示改进它们的响应。

值得注意的是,与需要使用反向梯度更新模型参数的训练阶段的监督学习不同,ICL 不需要参数更新,并直接对预先训练好的语言模型进行预测(这是与 prompt,传统 demonstration learning 不同的地方,ICL 不需要在下游 P-tuning 或 Fine-tuning)。希望该模型学习隐藏在演示中的模式,并据此做出正确的预测。

传统的学习方法通常是在孤立的、脱离实际应用环境的情况下进行的。然而,这种学习方式可能无法充分考虑到真实环境中的复杂性和不确定性,并且在将学习应用到实际情境中时可能存在困难。相比之下,上下文学习更加注重将学习过程置于特定的环境中,以便更好地理解和适应实际应用的需求。

上下文学习的核心思想是将学习任务与具体的上下文相关联,使学习过程更加贴近实际应用的情境。这可以通过以下方式实现:

- 真实场景模拟:提供具有实际环境特征的模拟环境,让学习者在其中进行实践和探索。这种模拟可以是虚拟的,如计算机仿真或虚拟现实环境;也可以是真实场景的简化版本,以减少复杂性和风险。

- 任务驱动学习:将学习任务与实际问题或任务紧密相关。学习者需要在特定的上下文中解决实际的问题,从中获取经验和知识,并通过反馈和实践不断改进。

- 社会互动与合作:通过与他人的互动和合作,学习者能够在真实的社交环境中进行学习。这可以促进知识的共享、协作和实践,提供更具丰富性和复杂性的学习体验。

上下文学习与预训练和微调的关系:

- 预训练侧重于从大规模未标记数据中进行无监督学习,获取一般语言理解。

- 微调建立在预训练的基础上,并使用特定于任务的标记数据使模型适应特定的任务,从而实现专门的性能。

- 上下文学习在训练过程中包含特定于任务的指令或提示,指导模型的行为并提高任务性能。

上下文学习包括训练语言模型,以根据特定的指令或提示生成与上下文相关的响应。主要训练语言模型以礼貌和有用的方式生成对客户查询的响应

- 聊天机器人和虚拟助手:上下文学习允许聊天机器人和虚拟助手为用户查询提供更适合上下文和有用的响应,增强用户体验。

- 对话系统:通过结合上下文学习,模型可以产生连贯和引人入胜的对话,改善对话系统中的人机交互。

- 个性化推荐:可以使用上下文学习来训练模型,根据用户偏好和历史数据提供个性化推荐,提高推荐的准确性和相关性。

上下文学习在许多领域中具有重要的应用,如教育、培训、人工智能和机器学习。它可以帮助学习者更好地理解和应用所学的知识,提高学习的效果和实用性。在人工智能领域,上下文学习也被广泛应用于智能系统的开发和训练过程中,以使其能够更好地适应和应用于实际应用场景中。

相关资料

- 什么是In-Context Learning(上下文学习)?

- What Does Pre-training a Neural Network Mean?

- 什么是微调(Fine Tune)?