RedPajama模型是TOGETHER发布的一个开源可商用的大模型。2023年6月6日,TOGETHER在官方宣布该模型完成训练,经过测试,该模型目前超过所有7B规模的大模型,比LLaMA-7B和Falcon-7B的效果还要好!

TOGETHER公司是一家由豪华管理团队组成的创业公司,由苹果公司前高管、斯坦福大学教授等一起创办。其目标是提供大型生成式模型的基础设施。

RedPajama是一个开源大模型项目,有TOGETHER联合多家公司发起。目前包括一个开源的数据集,有1.2万亿tokens,严格按照LLaMA模型论文中的方法收集。另外,还包括2个开源大模型,一个是RedPajama 3B,于5月5日宣布训练结束,可以在RTX 2070上使用。另一个模型就是本文提到的RedPajama 7B,在昨天宣布完成训练,效果超越目前所有同等规模的模型。

RedPajama 3B模型信息卡:

https://www.datalearner.com/ai-models/pretrained-models/RedPajama-INCITE-3B

一、RedPajama数据集简介

4月17日,TOGETHER发布了RedPajama项目,被大众所熟知。该项目希望建立一个开源的大语言模型,其第一步是重现LLaMA论文中提到的高质量预训练数据集。他们认为,高质量的大规模预训练数据集是大模型训练必要条件。而MetaAI开源的LLaMA模型可以理解为开源最强大模型。但是,他们仅仅开源了预训练结果,且不允许商用。而RedPajama则根据MetaAI的论文自己收集了这样的一个数据集。

因此,他们开源了1.2万亿tokens的RedPajama数据集。这是一个5TB大小的数据集,按照LLaMA论文描述的内容收集。目前已经被下载了几千次,而且用于超过100个模型的训练。

二、RedPajama 7B模型简介

4月23日,也就是RedPajama数据集发布1周后,TOGETHER宣布他们基于这个1.2万亿tokens的数据集正在训练一个叫RedPajama-7B模型,完成了40%的训练,但是效果已经超越Pythia-7B。这证明了大规模高质量预训练数据集的价值。

5月5日,RedPajama-7B模型的训练过程进行到80%,但是效果出乎意料,因此TOGETHER发布了0.1版本的RedPajama 7B,包含3个版本:基础大模型、基于chat微调的以及基于指令微调的。

| RedPajama-7B v0.1版本 | 预训练下载链接 |

|---|---|

| RedPajama-INCITE-Base-7B-v0.1 | https://huggingface.co/togethercomputer/RedPajama-INCITE-Base-7B-v0.1 |

| RedPajama-INCITE-Chat-7B-v0.1 | https://huggingface.co/togethercomputer/RedPajama-INCITE-Chat-7B-v0.1 |

| RedPajama-INCITE-Instruct-7B-v0.1 | https://huggingface.co/togethercomputer/RedPajama-INCITE-Instruct-7B-v0.1 |

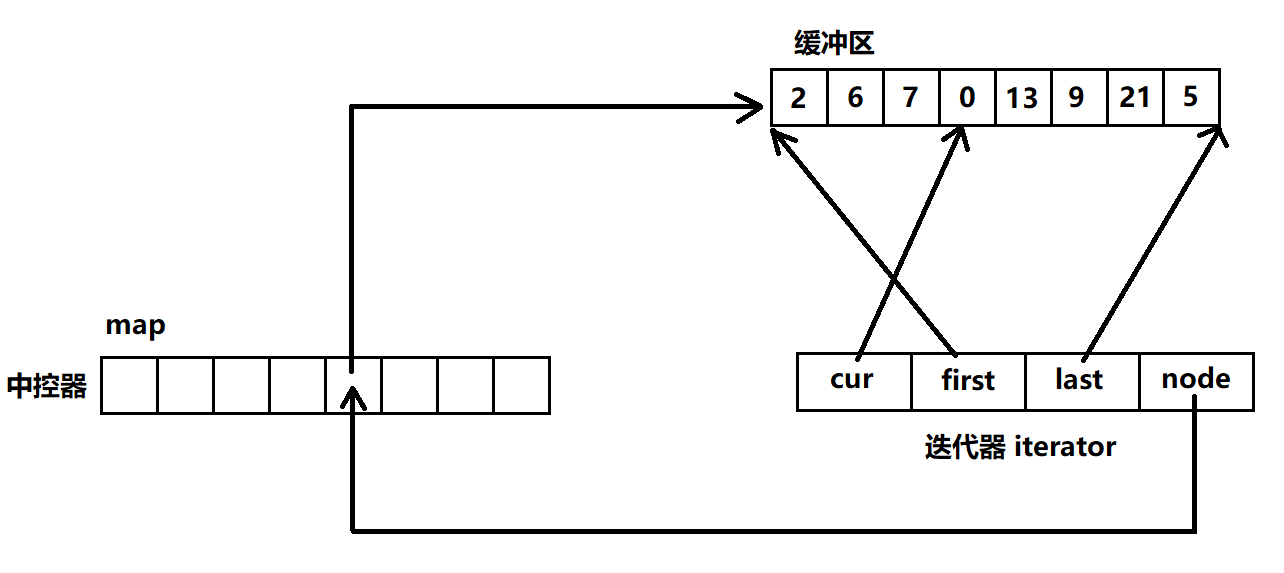

这里的Base模型是基础大语言模型,采用Pythia模型一样的架构,但是基于RedPajama数据集训练,而Chat则是基于Base模型训练进行指令微调的结果(基于Dolly2和OASST微调),Chat版本模型已经可以在OpenChatKit使用。Instruct则是基于Base模型针对few-shot prompts微调的结果。在很多NLP任务中微调(来自P3和Natural Instruction)。

今天,TOGETHER宣布RedPajama 7B完成所有训练。完整版本的3个RedPajama模型全部开源:

| RedPajama-7B v1.0版本 | 预训练下载链接 |

|---|---|

| RedPajama-INCITE-7B-Base | https://huggingface.co/togethercomputer/RedPajama-INCITE-7B-Base |

| RedPajama-INCITE-Chat-7B | https://huggingface.co/togethercomputer/RedPajama-INCITE-7B-Chat |

| RedPajama-INCITE-Instruct-7B | https://huggingface.co/togethercomputer/RedPajama-INCITE-7B-Instruct |

上述模型均使用Apache2.0开源协议,完全开源可商用!

三、RedPajama 7B模型的效果

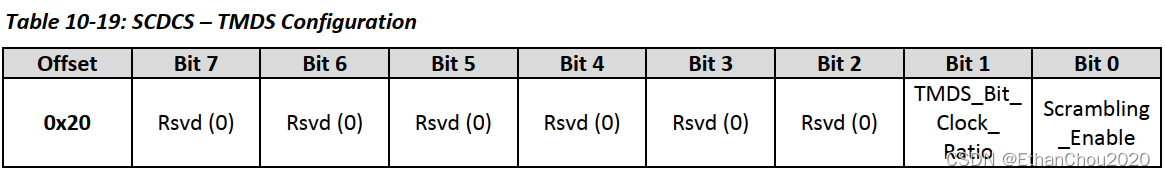

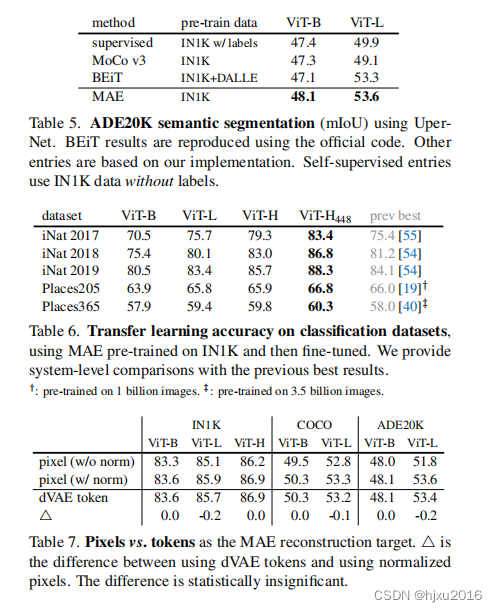

TOGETHER在HELM任务上做了评估。使用的是RedPajama-INCITE-Instruct-7B,从结果看,HELM平均得分上,RedPajama 7B Instruct0.492,超过LLaMA 7B的0.472和前段时间最强开源模型Falcon 7B的0.407。

RedPajama第二代模型即将登场

除了上述RedPajama 7B模型的开源外,官方还宣布了RedPajama V2版本的消息。RedPajama 2将在2-3万亿tokens数据集上训练。主要有以下规划:

-

准备基于DoReMi这样的技术自动学习不同数据的混合。

-

引入Pile v1(来自Eleuther.ai)和Pile v2(CrperAI)等数据集,提高训练数据多样性

-

处理更多的CommonCrawl数据集

-

使用更好的数据去重复策略

-

引入至少1500亿tokens的代码数据集。

而根据官方的描述RedPajama 2将继续开源!

RedPajama背后的INCITE超级计算机资助

RedPajama项目背后离不开美国国家科学基金会的一个INCITE项目,它通过资助申请者的DOE超级计算机使用时间来降低大家对超大规模计算资源的使用门槛。RedPajama总共使用了3072个V100的GPU进行训练。

可以看到,超级计算机的项目资助对于促进这样的大模型训练来说很重要。目前不知道国内是否有这样的资源可以供大家申请使用。如果有,这也许也会推动国内大模型的发展!