1 项目需求

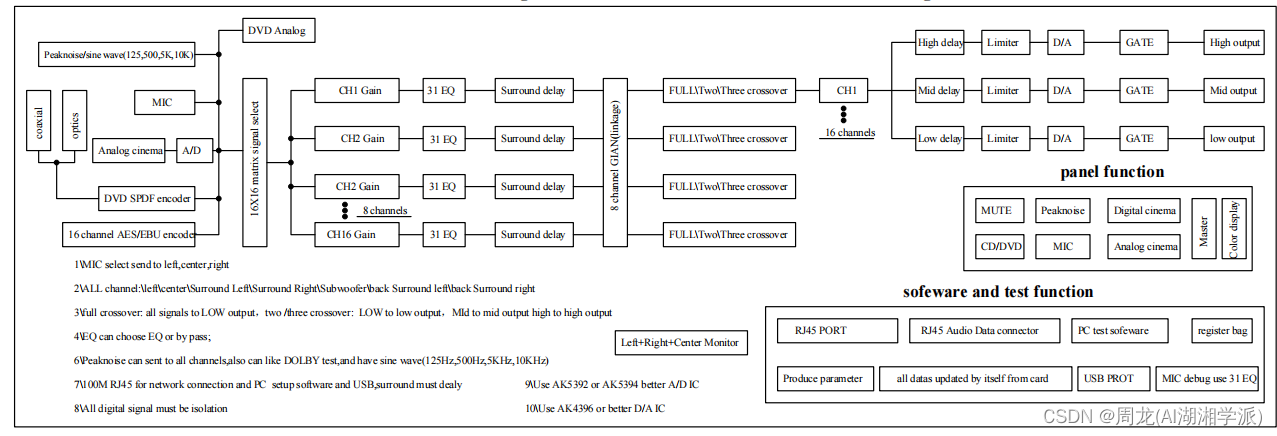

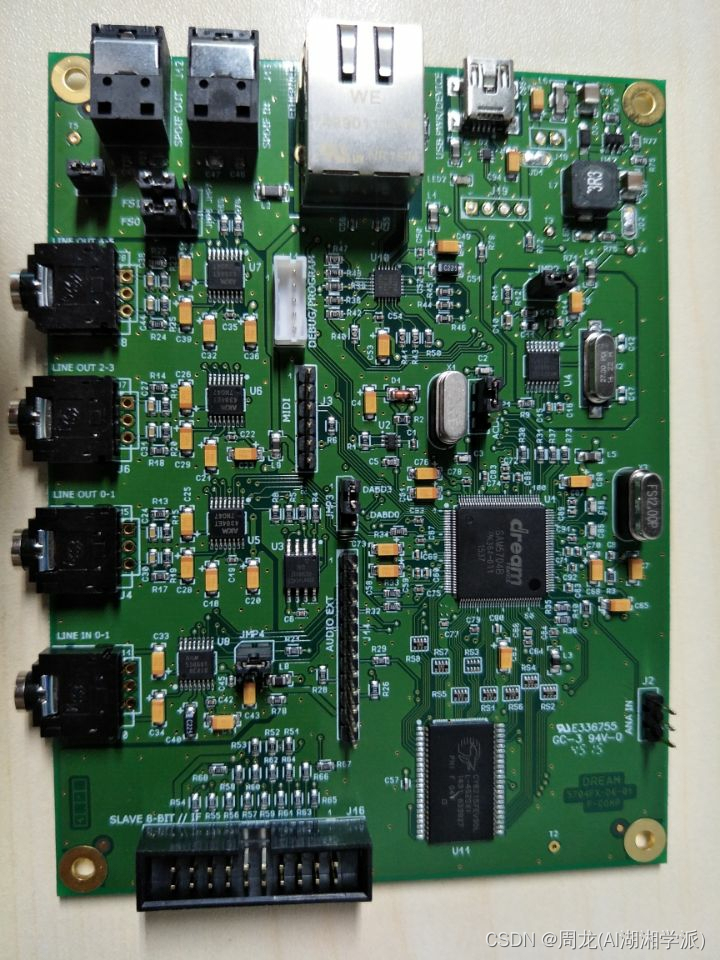

2 开发平台介绍

Dream S.A.S France公司网站:https://www.dream.fr

Dream全系列的芯片包含SAM2000 series ICs、SAM3000 series ICs以及SAM5000 series ICs。

SAM5000 series ICs包括 sam5504、sam5704、sam5708、sam5808、sam5716、sam5916。

目前dream的DSP广泛用于KTV前级效果器、吉他效果器、吉他音箱、调音台、点歌机机顶盒、电视KTV效果器、K歌声卡、

网路K歌效果器、K歌麦克风、电钢琴、电子琴、MIDI DVD、MIDI点歌机等等和麦克风音效及MIDI音频传输相关的领域。

3这种芯片如何开发?

2023/5/29 上午12:11:33

SAM5000系列IC的开发需要具备一定的硬件和软件开发技能,以下是一个简单的开发步骤:

硬件设计:根据应用需要,设计符合要求的硬件电路,并选择合适的外部器件(如晶振、存储器、接口芯片等)。

软件开发环境搭建:选择适合SAM5000系列IC的开发板,并在PC上安装相应的开发工具链(如Keil、IAR等)。

软件编写:使用开发工具进行软件编写,包括初始化代码、驱动程序、中断服务程序等。

调试与测试:将编写好的软件烧录到开发板上,对系统进行调试和测试,确保系统功能正常。

量产准备:根据产品需求,进行优化和调整,准备量产所需的生产文件和工具。

需要注意的是,SAM5000系列IC的开发涉及到多个领域,需要掌握相关知识和技能,才能顺利完成开发任务。同时,还需要遵守相关法律和标准,确保产品的可靠性和稳定性。

4 应用领域

电子乐器,电子琴,电子鼓等

5 虚拟环绕声HRTF算法实现

虚拟环绕声算法是一种利用数字信号处理技术实现的音效处理方法,它通过仿真环绕声的空间特性,使得音频在听觉上能够产生类似于物理环境中的“立体声”效果。其基本原理可以概括为以下几点:

声源定位:首先需要对声源进行定位,确定声源在空间中的位置和方向。这可以通过音频信号处理技术来实现,如延迟和滤波等方法。

立体声重建:将单声道信号转换成立体声信号,使得左右声道在空间上具有差异性。这可以通过相位差、振幅比例和延迟等技术来实现。

环绕声模拟:根据声源的位置和方向信息,对声音进行处理,产生类似于物理环境中的反射、衍射和吸收等效应,以模拟出环绕声效果。这可以通过卷积等运算来实现。

通过以上几个步骤的处理,虚拟环绕声算法可以将单声道音频转换成具有立体声和环绕声效果的音频,实现更加真实、自然的音效体验。

HRTF(Head-Related Transfer Function,头相关传递函数)是一种用于模拟人类听觉系统的算法,主要用于虚拟现实和3D音频应用中。以下是一个简单的HRTF算法的C语言实现示例:

// 常量定义

#define π 3.14159265358979323846

#define N 256

// 定义相关数组

double left_input[N], right_input[N];

double left_output[N], right_output[N];

// 定义 HRTF 变量

double azimuth, elevation;

double distance_left, distance_right;

// 计算 HRTF 参数

azimuth = ...; elevation = ...; // 获取方位角和仰角参数

distance_left = ...; distance_right = ...; // 获取左右声道距离参数

// 计算 HRTF 函数

for(int n = 0; n < N; n++) {

double time = n / sample_rate; // 计算当前时间

double left_delay = distance_left / speed_of_sound; // 计算左声道延迟

double right_delay = distance_right / speed_of_sound; // 计算右声道延迟

double left_amplitude = ...; // 根据左声道延迟计算振幅

double right_amplitude = ...; // 根据右声道延迟计算振幅

double left_phase = ...; // 计算左声道相位

double right_phase = ...; // 计算右声道相位

double left_input_sample = left_input[n]; // 获取当前左声道输入样本值

double right_input_sample = right_input[n]; // 获取当前右声道输入样本值

double left_output_sample = ...; // 根据左声道参数计算当前输出样本值

double right_output_sample = ...; // 根据右声道参数计算当前输出样本值

left_output[n] = left_output_sample; // 存储当前左声道输出样本值

right_output[n] = right_output_sample; // 存储当前右声道输出样本值

}

#include <stdio.h>

#include <math.h>

#define PI 3.14159265358979323846

// HRTF参数

#define NUM_ELEVATIONS 25 // 仰角数目

#define NUM_AZIMUTHS 50 // 方位角数目

#define NUM_SAMPLES 512 // 每个HRTF采样数目

#define LEFT_EAR 0 // 左耳

#define RIGHT_EAR 1 // 右耳

#define SOUND_SPEED 343.0 // 声速

// HRTF数据结构

typedef struct {

double azimuth;

double elevation;

double left_data[NUM_SAMPLES];

double right_data[NUM_SAMPLES];

} HRTF;

// 音源位置数据结构

typedef struct {

double x;

double y;

double z;

} SourcePosition;

// 利用插值获取HRTF

void interpolate_hrtf(HRTF hrtfs[NUM_ELEVATIONS][NUM_AZIMUTHS], double elevation, double azimuth,

double *left_hrtf, double *right_hrtf) {

int e_index = (int)floor(elevation);

int a_index = (int)floor(azimuth);

double e_ratio = elevation - e_index;

double a_ratio = azimuth - a_index;

double top_left = hrtfs[e_index][a_index].left_data[0] * (1 - a_ratio) + hrtfs[e_index][a_index+1].left_data[0] * a_ratio;

double top_right = hrtfs[e_index][a_index].right_data[0] * (1 - a_ratio) + hrtfs[e_index][a_index+1].right_data[0] * a_ratio;

double bottom_left = hrtfs[e_index+1][a_index].left_data[0] * (1 - a_ratio) + hrtfs[e_index+1][a_index+1].left_data[0] * a_ratio;

double bottom_right = hrtfs[e_index+1][a_index].right_data[0] * (1 - a_ratio) + hrtfs[e_index+1][a_index+1].right_data[0] * a_ratio;

double top = top_left * (1 - e_ratio) + top_right * e_ratio;

double bottom = bottom_left * (1 - e_ratio) + bottom_right * e_ratio;

*left_hrtf = top * (1 - e_ratio) + bottom * e_ratio;

top_left = hrtfs[e_index][a_index].left_data[NUM_SAMPLES/2] * (1 - a_ratio) + hrtfs[e_index][a_index+1].left_data[NUM_SAMPLES/2] * a_ratio;

top_right = hrtfs[e_index][a_index].right_data[NUM_SAMPLES/2] * (1 - a_ratio) + hrtfs[e_index][a_index+1].right_data[NUM_SAMPLES/2] * a_ratio;

bottom_left = hrtfs[e_index+1][a_index].left_data[NUM_SAMPLES/2] * (1 - a_ratio) + hrtfs[e_index+1][a_index+1].left_data[NUM_SAMPLES/2] * a_ratio;

bottom_right = hrtfs[e_index+1][a_index].right_data[NUM_SAMPLES/2] * (1 - a_ratio) + hrtfs[e_index+1][a_index+1].right_data[NUM_SAMPLES/2] * a_ratio;

top = top_left * (1 - e_ratio) + top_right * e_ratio;

bottom = bottom_left * (1 - e_ratio) + bottom_right * e_ratio;

*right_hrtf = top * (1 - e_ratio) + bottom * e_ratio;

}

// 计算声源到耳朵的距离

double calculate_distance(SourcePosition listener_position, SourcePosition source_position, int ear) {

double dx = source_position.x - listener_position.x;

double dy = source_position.y - listener_position.y;

double dz = source_position.z - listener_position.z;

if (ear == LEFT_EAR) {

dx -= 0.0875; // left ear position

} else if (ear == RIGHT_EAR) {

dx += 0.0875

6 PC端实验

要在Audition中生成虚拟环绕声,可以按照以下步骤操作:

导入需要处理的音频文件到Audition中。

点击“多轨”视图模式,并创建一个新的立体声多轨会话。

将音频文件拖放到左右两个音轨上,确保它们都是立体声文件。

在效果菜单中找到“Virtual Surround”,并将其应用到立体声音轨上。

调整“Virtual Surround”效果的参数,以获得最佳的虚拟环绕声效果。例如,您可以调整声道延迟,重复和混响等参数。

保存您的虚拟环绕声输出文件。

注意:要从虚拟环绕声中获得最佳效果,建议使用适当的音频输出设备或耳机,以确保音频可以正确解码并呈现空间效果。