一.安装jdk及配置环境变量:

下载地址:

https://www.oracle.com/java/technologies/downloads/#java8-windows

安装步骤:

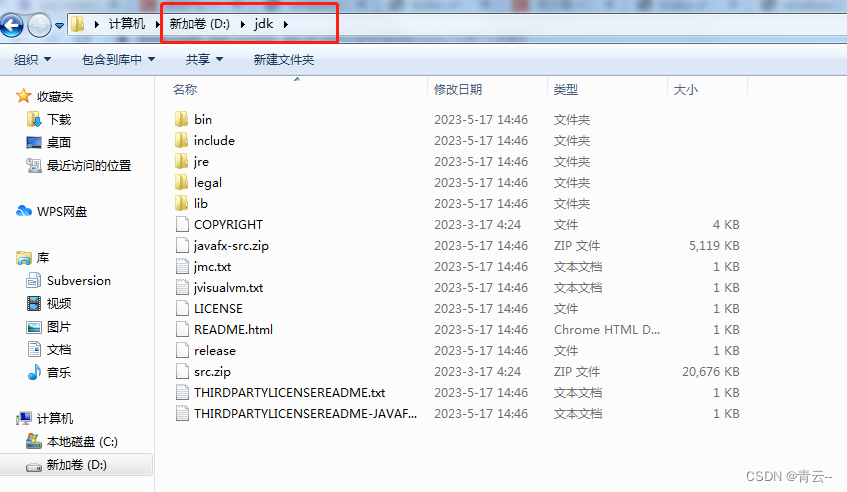

下载后点击安装,中途可以自定义安装路径,最后查看安装路径:

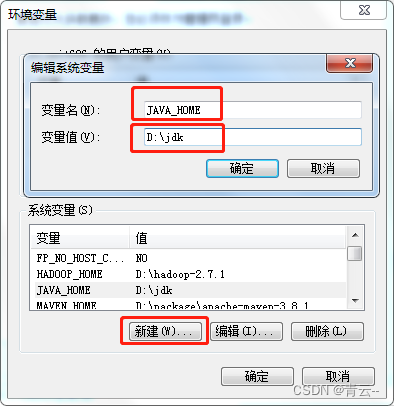

开始配置系统环境变量:

在系统变量中新建:

变量名: JAVA_HOME

变量值:D:\jdk 也就是jdk的安装路径

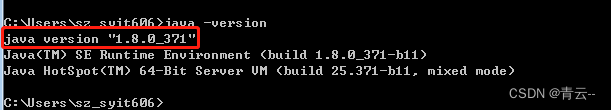

确认后,打开cmd,输入java version,出现如下界面:

说明java系统环境变量已配好。

二.安装spark及配置环境变量:

下载地址:

https://archive.apache.org/dist/spark/

点击想安装的版本(我安装的是spark-3.0.0):

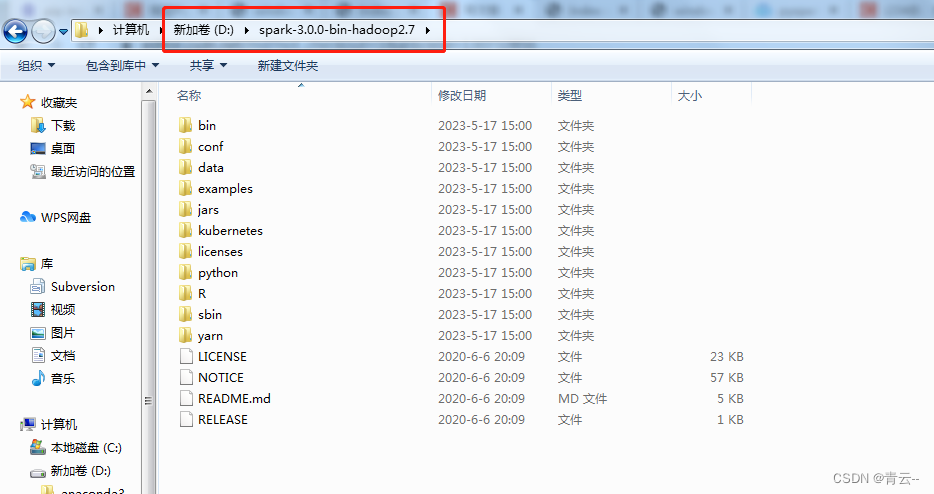

将压缩包放在喜欢的位置进行解压:

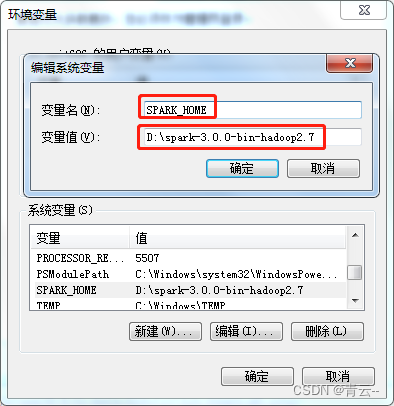

开始配置spark的系统环境变量:

在系统变量中新建:

变量名:SPARK_HOME

变量值:D:\spark-3.0.0-bin-hadoop2.7

三.安装hadoop及配置环境变量:

下载地址:

https://archive.apache.org/dist/hadoop/common/

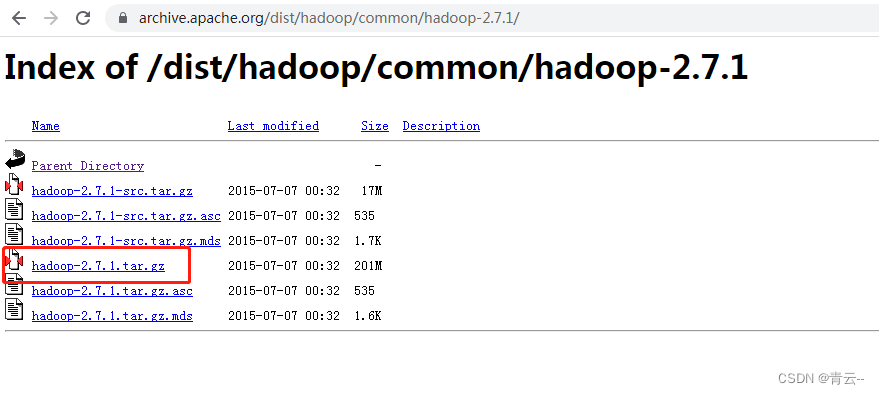

选择与spark对应的版本:

点击之后进行下载:

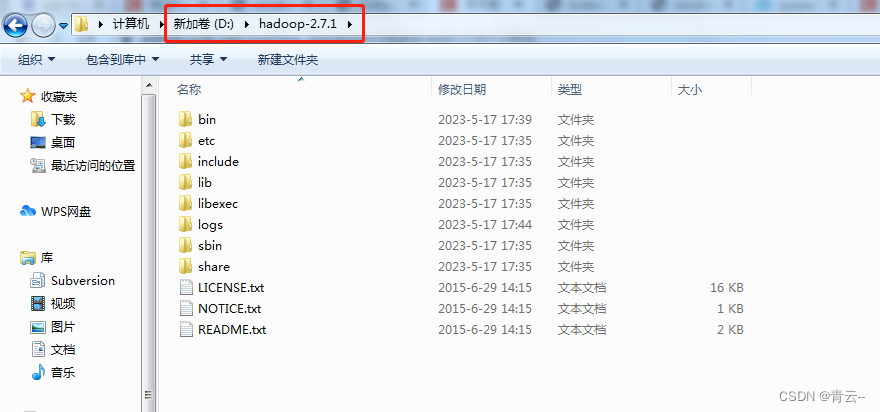

解压到喜欢的位置:

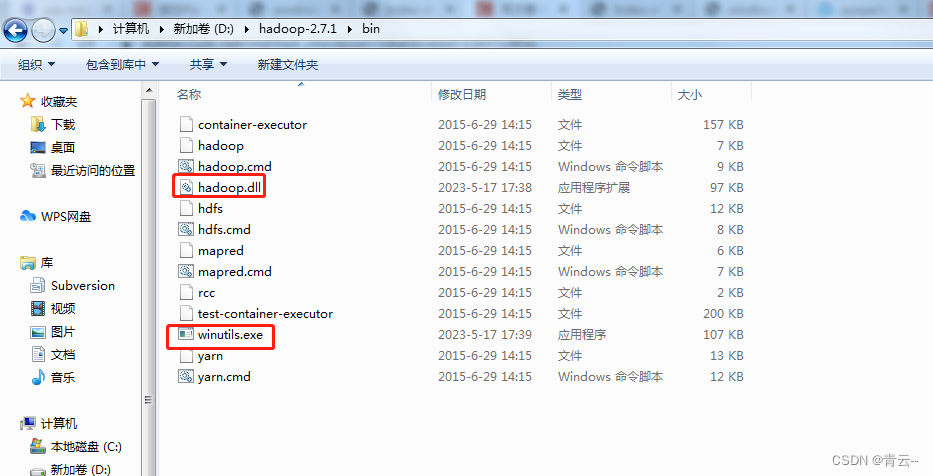

此时bin目录(D:\hadoop-2.7.1\bin)下可能没有hadoop.dll及winutils.exe文件,

需要进行下载:

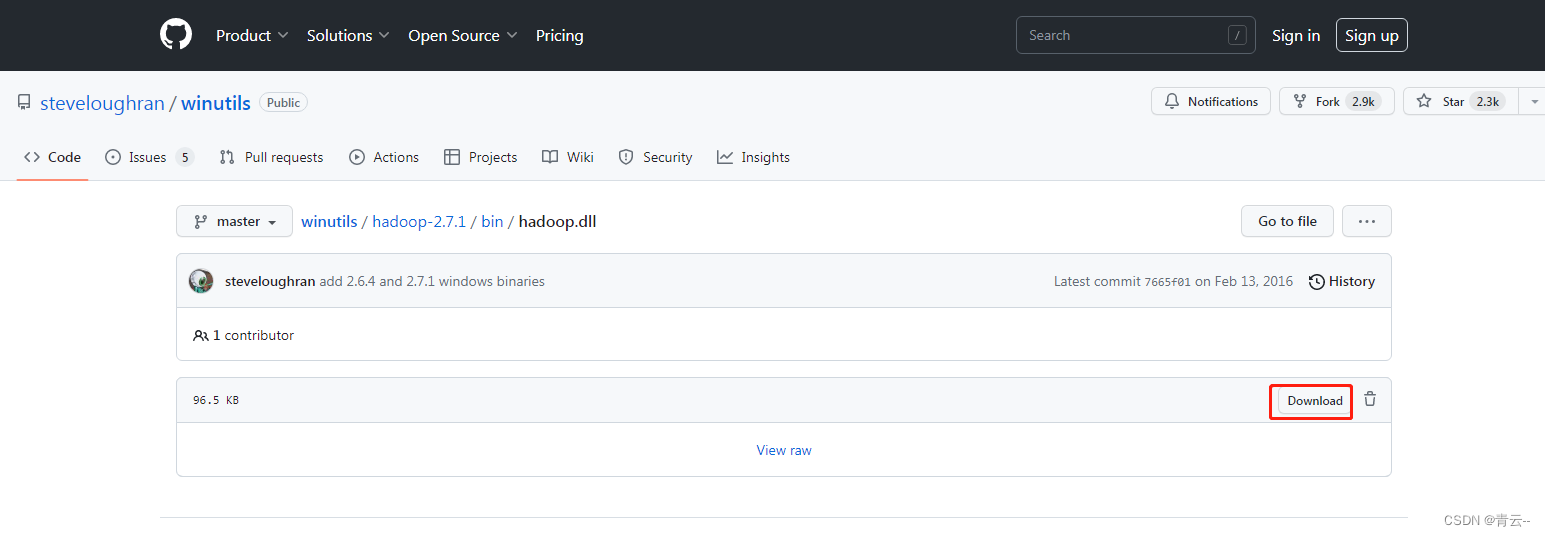

hadoop.dll:

https://github.com/steveloughran/winutils/blob/master/hadoop-2.7.1/bin/hadoop.dll

点击下载

winutils.exe:

https://github.com/steveloughran/winutils/blob/master/hadoop-2.7.1/bin/winutils.exe

下载方式同上

将hadoop.dll和winutils.exe均拷贝到D:\hadoop-2.7.1\bin下和C:\Windows\System32下(两个文件各拷贝一份)

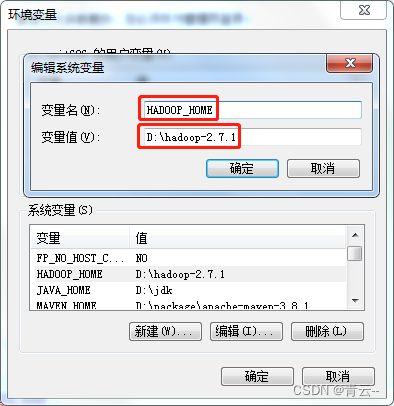

开始配置hadoop的系统环境变量:

新建系统变量:

变量名:HADOOP_HOME

变量值:D:\hadoop-2.7.1

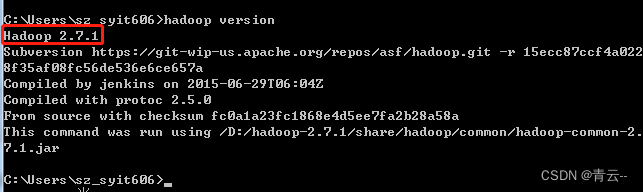

在cmd输入hadoop version,出现如下界面:

说明hadoop环境变量配置成功;

接着输入spark-shell,出现如下界面:

说明spark系统环境变量配置成功;

接下来安装py4j,在cmd中输入pip install py4j

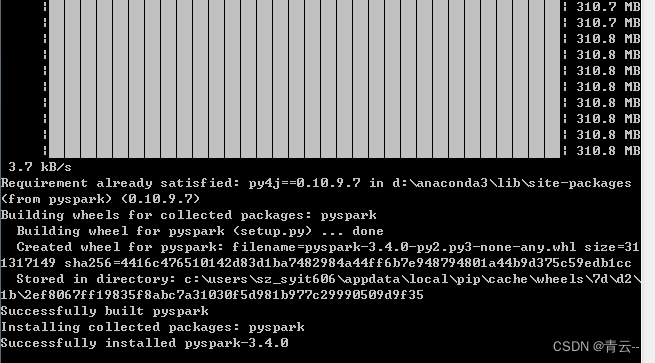

安装成功后接着输入pip install pyspark,安装好后出现如下界面:

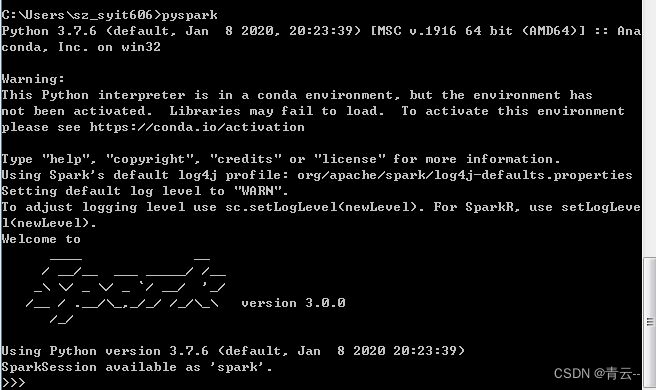

最后输入pyspark,出现如下界面:

再来pycharm看引用的pyspark代码,已经可以正常使用了:

至此,windows(win7)安装pyspark(3.0.0及以上版本)成功

![[FlareOn6]Overlong 题解](https://img-blog.csdnimg.cn/eed78ef6fb494f63bc63a0aee599d28b.png)