一、什么是BeautifulSoup

Beautiful Soup 简称 BS4(其中 4 表示版本号)是一个 Python 第三方库,它可以从 HTML 或 XML 文档中快速地提取指定的数据。

二、BS4下载安装

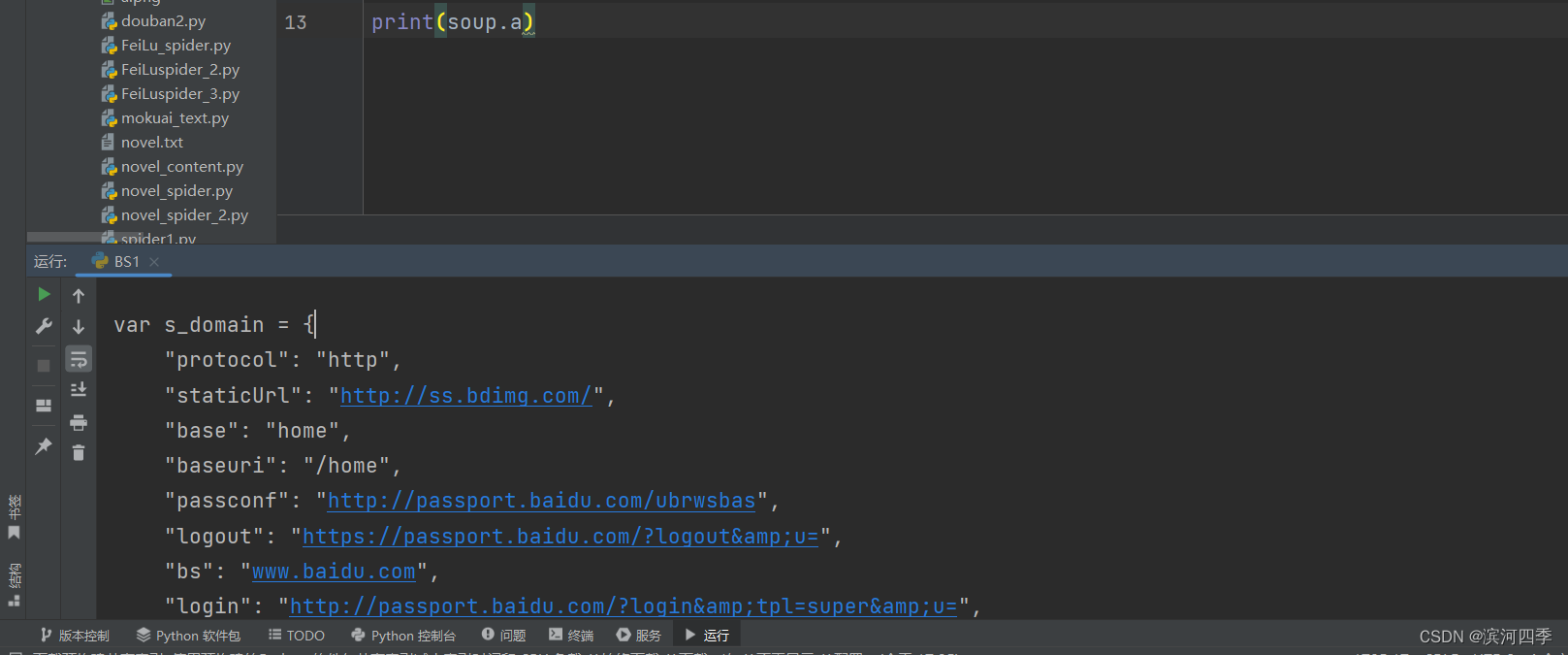

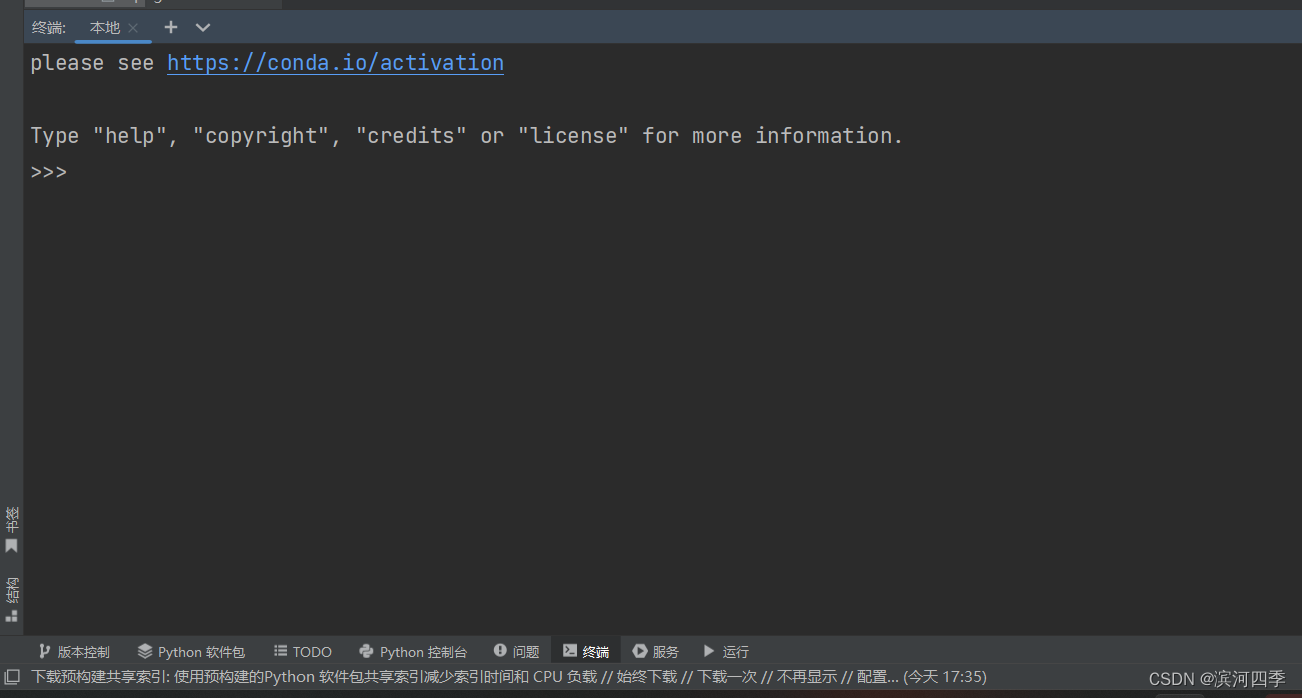

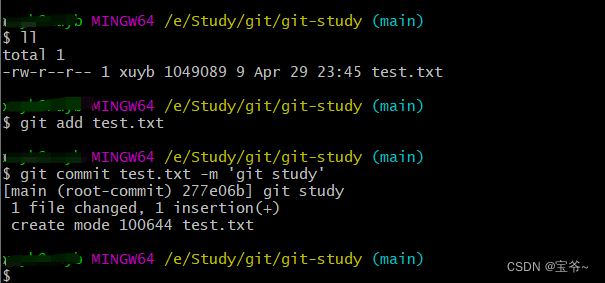

点击最下面的终端进如命令行界面

(进入成功界面:)

由于 Bautiful Soup 是第三方库,因此需要单独下载,下载方式非常简单,执行以下命令即可安装:

由于 BS4 解析页面时需要依赖文档解析器,所以 还需要安装 lxml 作为解析库:pip install bs4Python 也自带了一个文档解析库 html.parser, 但是其解析速度要稍慢于 lxml。除了上述解析器外,还可以使用 html5lib 解析器,安装方式如下:pip install lxml该解析器生成 HTML 格式的文档,但速度较慢。pip install html5lib“解析器容错”指的是被解析的文档发生错误或不符合格式时,通过解析器的容错性仍然可以按照既定的正确格式实现解析。

三、BS4解析对象

创建 BS4 解析对象是万事开头的第一步,这非常地简单,语法格式如下所示:

1、导入bs4包

2、创建bs解析对象

#导入解析包 from bs4 import BeautifulSoup #创建beautifulsoup解析对象 soup = BeautifulSoup(html_doc, 'html.parser')上述代码中,html_doc 表示要解析的文档,而 html.parser 表示解析文档时所用的解析器,此处的解析器也可以是 'lxml' 或者 'html5lib'。

#prettify()用于格式化输出html/xml文档

print(soup.prettify())

如果是外部文档,您也可以通过 open() 的方式打开读取,语法格式如下:

soup = BeautifulSoup(open('html_doc.html', encoding='utf8'), 'lxml')# 'html_doc.html'是文件名, # encoding='utf8'表示编码格式为utf-8, # 'lxml'是解析器类型

四、BS4常用语法

下面对爬虫中经常用到的 BS4 解析方法做详细介绍。

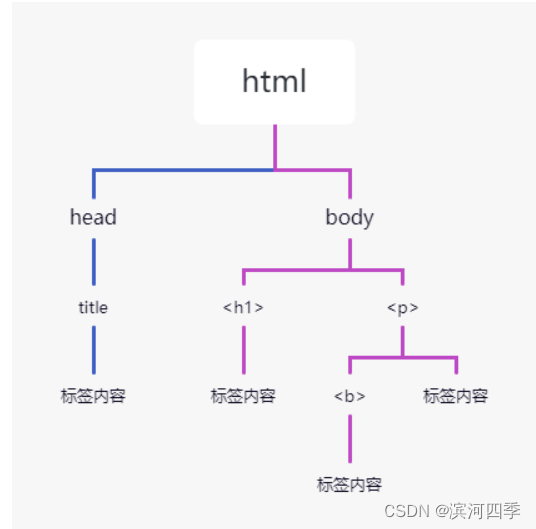

Beautiful Soup 将 HTML 文档转换成一个树形结构,该结构有利于快速地遍历和搜索 HTML 文档。下面使用树状结构来描述一段 HTML 文档:<html><head><title>c语言中文网</title></head><h1>c.biancheng.net</h1><p><b>一个学习编程的网站</b></p></body></html>树状图如下所示:

文档树中的每个节点都是 Python 对象,这些对象大致分为四类:Tag , NavigableString , BeautifulSoup , Comment 。其中使用最多的是 Tag 和 NavigableString。

- Tag:标签类,HTML 文档中所有的标签都可以看做 Tag 对象。

- NavigableString:字符串类,指的是标签中的文本内容,使用 text、string、strings 来获取文本内容。

- BeautifulSoup:表示一个 HTML 文档的全部内容,您可以把它当作一个特殊的 Tag 对象。

- Comment:(注释类,输出的内容不包含注释符号)表示 HTML 文档中的注释内容以及特殊字符串,它是一个特殊的 NavigableString。

1) Tag节点

标签(Tag)是组成 HTML 文档的基本元素。在 BS4 中,通过标签名和标签属性可以提取出想要的内容。但是默认拿到第一个找到的标签及内容;

看一组简单的示例:

html_doc = """ <html><head><title>The Dormouse's story</title></head> <body> <p class="title"><b>The Dormouse's story</b></p> <p class="story">Once upon a time there were three little sisters; and their names were <a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>, <a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and <a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>; and they lived at the bottom of a well.</p> <p class="story">...</p> """ from bs4 import BeautifulSoup# prettify()按照标准的缩进格式的结构输出print(soup.prettify())# 获取第一个head标签的html代码print(soup.head)# 获取整个title标签的html代码print(soup.title)# 获取tag的名字print(soup.title.name)# 获取tag的内容,使用NavigableString类中的string、text、get_text()print(soup.title.string)# 获取tag父标签的名字print(soup.title.parent.name)# 获取第一个找到的p标签print(soup.p)# 获取第一个a标签print(soup.a)# 获取所有的a标签print(soup.find_all('a'))# 根据class_或id或attr(其他属性,比如type)寻找标签,如果有多个,则返回找到的第一个标签print(soup.find(id="link3"))# 从文档中找到所有<a>标签的链接:for link in soup.find_all('a'): print(link.get('href'))# 从文档中获取所有文字内容:print(soup.get_text())# 获取第一个b标签(b标签是p标签的子标签,想要拿到子标签必须先拿到父标签)

print(soup.p.b)# 返回一个字典,里面是多有属性和值

print(soup.p.attrs)# 查看返回的数据类型

print(type(soup.p))# 根据属性,获取标签的属性值,返回值为列表

print(soup.p['class'])# 给class属性赋值,此时属性值由列表转换为字符串

soup.p['class'] = ['Web', 'Site'] print(soup.p)

五、文档的遍历

一个Tag可能包含多个字符串或其它的Tag,这些都是这个Tag的子节点.Beautiful Soup提供了许多操作和遍历子节点的属性;

比如 contents、 children 用来遍历子节点; parent 与parents 用来遍历父节点;而 next sibling 与 previous sibling 则用来遍历兄弟节点。示例如下:

注意: Beautiful Soup中字符串节点不支持这些属性,因为字符串没有子节点

html_doc = """ <html><head><title>The Dormouse's story</title></head> <body> <p class="title"><b>The Dormouse's story</b></p> <p class="story">Once upon a time there were three little sisters; and their names were <a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>, <a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and <a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>; and they lived at the bottom of a well.</p> <p class="story">...</p> """ from bs4 import BeautifulSoup soup = BeautifulSoup(html_doc, 'html.parser')

tag的name

# 操作文档树最简单的方法就是告诉它你想获取的tag的name.如果想获取 <head> 标签,只要用 :

soup.headsoup.head # <head><title>The Dormouse's story</title></head>soup.title # <title>The Dormouse's story</title># 这是个获取tag的小窍门,可以在文档树的tag中多次调用这个方法. 下面的代码可以获取<body>标签中的第一个<b>标签:soup.body.b # <b>The Dormouse's story</b># 通过点取属性的方式只能获得当前名字的第一个tag:

soup.a # <a class="sister" href="http://example.com/elsie" id="link1">Elsie</a># 如果想要得到所有的<a>标签,或是通过名字得到比一个tag更多的内容的时候,就需要用到 Searching the tree 中描述的方法,比如: find_all()

soup.find_all('a') # [<a class="sister" href="http://example.com/elsie" id="link1">Elsie</a>, # <a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>, # <a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]

遍历子节点

1)contents

tag的 属性可以将tag的子节点以列表的方式输出;

html_doc = """ <html><head><title>The Dormouse's story</title></head> <body> <p class="title"><b>The Dormouse's story</b></p> <p class="story">Once upon a time there were three little sisters; and their names were <a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>, <a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and <a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>; and they lived at the bottom of a well.</p> <p class="story">...</p> """ from bs4 import BeautifulSoup soup = BeautifulSoup(html_doc, 'html.parser') # 获取bs的head标签 head_tag = soup.head print(head_tag) # <head><title>The Dormouse's story</title></head> # 获取head标签的所有子节点 print(head_tag.contents) # [<title>The Dormouse's story</title>] # 获取到的子节点可以通过下标来得到想要的子标签 title_tag = head_tag.contents[0] print(title_tag) # <title>The Dormouse's story</title> print(title_tag.contents) # [u'The Dormouse's story']

2)children

获取Tag的所有子节点,返回一个生成器

for child in title_tag.children: print(child) # The Dormouse's story

六、文档的搜素

find_all() 与find() 是析 HTML 文档的常用方法,它们可以在 HTML 文档中按照一定的条件(相当于过滤器)查找所需内容。find() 与find_all() 的语法格式相似,希望大家在学习的时候,可以举一反三;

BS4 库中定义了许多用于搜索的方法,find() 与 find_all() 是最为关键的两个方法,其余方法的参数和使用与其类似。

1) find all()

find_all() 方法用来搜索当前 tag 的所有子节点,并判断这些节点是否符合过滤条件,最后以列表形式将符合条件的内容返回;【语法格式如下】:

find_all(name, attrs, recursive, text, **kwargs)

【参数说明】:

- name: 查找所有名字为 name 的 tag 标签,字符串对象会被自动忽略。

- attrs: 按照属性名和属性值搜索 tag 标签,注意由于 class 是 Python 的关键字吗,所以要使用"class_"。

- recursive: find all() 会搜索 tag 的所有子孙节点,设置recursive=False 可以只搜索 tag 的直接子节点。

- text: 用来搜文档中的标签里的字符串内容,该参数可以接受字符串、正则表达式、列表、True。

- limit: 由于 find all() 会返回所有的搜索结果,这样会影响执行效率,通过 imit 参数可以限制返回结果的数量。

from bs4 import BeautifulSoup import re html_doc = """ <html><head><title>"c语言中文网"</title></head> <body> <p class="title"><b>c.biancheng.net</b></p> <p class="website">一个学习编程的网站</p> <a href="http://c.biancheng.net/python/" id="link1">python教程</a> <a href="http://c.biancheng.net/c/" id="link2">c语言教程</a> <a href="http://c.biancheng.net/django/" id="link3">django教程</a> <p class="vip">加入我们阅读所有教程</p> <a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a> """ #创建soup解析对象 soup = BeautifulSoup(html_doc, 'html.parser') #查找所有a标签并返回 print(soup.find_all("a")) #查找前两条a标签并返回 print(soup.find_all("a",limit=2)) #只返回两条a标签最后以列表的形式返回输出结果,如下所示:

[<a href="http://c.biancheng.net/python/" id="link1">python教程</a>, <a href="http://c.biancheng.net/c/" id="link2">c语言教程</a>, <a href="http://c.biancheng.net/django/" id="link3">django教程</a>, <a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a>] [<a href="http://c.biancheng.net/python/" id="link1">python教程</a>, <a href="http://c.biancheng.net/c/" id="link2">c语言教程</a>]

按照标签属性以及属性值查找 HTML 文档,如下所示:

print(soup.find_all("p",class_="website")) print(soup.find_all(id="link4"))输出结果:

[<p class="website">一个学习编程的网站</p>] [<a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a>]

正则表达式、列表,以及 True 也可以当做过滤条件,使用示例如下:

#列表行书查找tag标签 print(soup.find_all(['b','a'])) #正则表达式匹配id属性值 print(soup.find_all('a',id=re.compile(r'.\d'))) print(soup.find_all(id=True)) #True可以匹配任何值,下面代码会查找所有tag,并返回相应的tag名称 for tag in soup.find_all(True): print(tag.name,end=" ") #输出所有以b开始的tag标签 for tag in soup.find_all(re.compile("^b")): print(tag.name)输出结果如下:

第一个print输出: [<b>c.biancheng.net</b>, <a href="http://c.biancheng.net/python/" id="link1">python教程</a>, <a href="http://c.biancheng.net/c/" id="link2">c语言教程</a>, <a href="http://c.biancheng.net/django/" id="link3">django教程</a>, <a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a>] 第二个print输出: [<a href="http://c.biancheng.net/python/" id="link1">python教程</a>, <a href="http://c.biancheng.net/c/" id="link2">c语言教程</a>, <a href="http://c.biancheng.net/django/" id="link3">django教程</a>, <a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a>] 第三个print输出: [<a href="http://c.biancheng.net/python/" id="link1">python教程</a>, <a href="http://c.biancheng.net/c/" id="link2">c语言教程</a>, <a href="http://c.biancheng.net/django/" id="link3">django教程</a>, <a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a>] 第四个print输出: html head title body p b p a a a p a 最后一个输出: body b

BS4 为了简化代码,为 find_all() 提供了一种简化写法,如下所示:

上述两种的方法的输出结果是相同的。#简化前 soup.find_all("a") #简化后 soup("a")

2) find()

find() 方法与 find_all() 类似,不同之处在于 find_all() 会将文档中所有符合条件的结果返回,而 find() 仅返回一个符合条件的结果,所以 find() 方法没有

limit参数。使用示例如下:from bs4 import BeautifulSoup import re html_doc = """ <html><head><title>"c语言中文网"</title></head> <body> <p class="title"><b>c.biancheng.net</b></p> <p class="website">一个学习编程的网站</p> <a href="http://c.biancheng.net/python/" id="link1">python教程</a> <a href="http://c.biancheng.net/c/" id="link2">c语言教程</a> <a href="http://c.biancheng.net/django/" id="link3">django教程</a> <p class="vip">加入我们阅读所有教程</p> <a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a> """ #创建soup解析对象 soup = BeautifulSoup(html_doc, 'html.parser') #查找第一个a并直接返回结果 print(soup.find('a')) #查找title print(soup.find('title')) #匹配指定href属性的a标签 print(soup.find('a',href='http://c.biancheng.net/python/')) #根据属性值正则匹配 print(soup.find(class_=re.compile('tit'))) #attrs参数值 print(soup.find(attrs={'class':'vip'}))输出结果如下:

a标签: <a href="http://c.biancheng.net/python/" id="link1">python教程</a> 指定href属性: <a href="http://c.biancheng.net/python/" id="link1">python教程</a> title: <title>"c语言中文网"</title> 正则匹配: <p class="title"><b>c.biancheng.net</b></p> #attrs参数值 <p class="vip">加入我们阅读所有教程</p>使用 find() 时,如果没有找到查询标签会返回 None,而 find_all() 方法返回空列表。示例如下:

print(soup.find('bdi')) print(soup.find_all('audio'))输出结果如下:

None []两种写法的输出结果相同;

七、CSS选择器

BS4 支持大部分的 CSS 选择器,比如常见的标签选择器、类选择器、id 选择器,以及层级选择器。Beautiful Soup 提供了一个 select() 方法,通过向该方法中添加选择器,就可以在 HTML 文档中搜索到与之对应的内容

html_doc = """ <html><head><title>"c语言中文网"</title></head> <body> <p class="title"><b>c.biancheng.net</b></p> <p class="website">一个学习编程的网站</p> <a href="http://c.biancheng.net/python/" id="link1">python教程</a> <a href="http://c.biancheng.net/c/" id="link2">c语言教程</a> <a href="http://c.biancheng.net/django/" id="link3">django教程</a> <p class="vip">加入我们阅读所有教程</p> <a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a> <p class="introduce">介绍: <a href="http://c.biancheng.net/view/8066.html" id="link5">关于网站</a> <a href="http://c.biancheng.net/view/8092.html" id="link6">关于站长</a> </p> """ from bs4 import BeautifulSoup soup = BeautifulSoup(html_doc, 'html.parser') #根据元素标签查找 print(soup.select('title')) #根据属性选择器查找 print(soup.select('a[href]')) #根据类查找 print(soup.select('.vip')) #后代节点查找 print(soup.select('html head title')) #查找兄弟节点 print(soup.select('p + a')) #根据id选择p标签的兄弟节点 print(soup.select('p ~ #link3')) #nth-of-type(n)选择器,用于匹配同类型中的第n个同级兄弟元素 print(soup.select('p ~ a:nth-of-type(1)')) #查找子节点 print(soup.select('p > a')) print(soup.select('.introduce > #link5')) # 根据id查找 print(soup.select('#link1')) # 根据属性查找 print(soup.select('a[id="link6"]'))输出结果:

第一个输出: [<title>"c语言中文网"</title>] 第二个输出: [<a href="http://c.biancheng.net/python/" id="link1">python教程</a>, <a href="http://c.biancheng.net/c/" id="link2">c语言教程</a>, <a href="http://c.biancheng.net/django/" id="link3">django教程</a>, <a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a>, <a href="http://c.biancheng.net/view/8066.html" id="link5">关于网站</a>, <a href="http://c.biancheng.net/view/8092.html" id="link6">关于站长</a>] 第三个输出: [<p class="vip">加入我们阅读所有教程</p>] 第四个输出: [<title>"c语言中文网"</title>] 第五个输出: [<a href="http://c.biancheng.net/python/" id="link1">python教程</a>, <a href="http://vip.biancheng.net/?from=index" id="link4">成为vip</a>] 第六个输出: [<a href="http://c.biancheng.net/django/" id="link3">django教程</a>] 第七个输出: [<a href="http://c.biancheng.net/python/" id="link1">python教程</a>] 第八个输出: [<a href="http://c.biancheng.net/view/8066.html" id="link5">关于网站</a>, <a href="http://c.biancheng.net/view/8092.html" id="link6">关于站长</a>] 第九个输出: [<a href="http://c.biancheng.net/view/8066.html" id="link5">关于网站</a>] 第十个输出: [<a href="http://c.biancheng.net/python/" id="link1">python教程</a>] 第十一个输出: [<a href="http://c.biancheng.net/view/8092.html" id="link6">关于站长</a>]