文章目录

- 1 前言

- 1.1 支持向量机的介绍

- 1.2 支持向量机的应用

- 2 demo数据集演示

- 2.1 导入函数

- 2.2 构建数据集拟合

- 2.3 预测模型及可视化

- 3 实例演示分类(非SVM)

- 3.1 导入函数和数据

- 3.2 简单线性分类

- 3.3 最大间隔决定分类

- 4 实例演示分类(SVM)

- 4.1主角登场

- 4.2 软间隔

- 4.3 超平面

- 5 讨论

1 前言

1.1 支持向量机的介绍

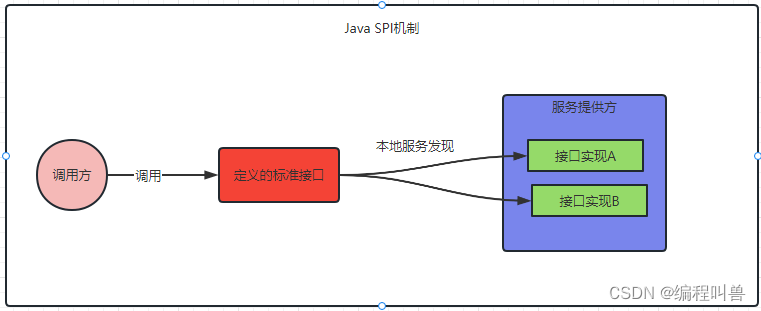

支持向量机(Support Vector Machine,SVM)是一种监督学习的分类算法。它的基本思想是找到一个能够最好地将不同类别的数据分开的超平面,同时最大化分类器的边际(margin)。SVM的训练目标是最大化间隔(margin),即支持向量到超平面的距离。

具体地,对于给定的训练集,SVM会找到一个最优的分离超平面,使得距离该超平面最近的样本点(即支持向量)到该超平面的距离最大化。SVM是一种二分类算法,但可以通过多次调用SVM实现多分类问题的解决。SVM的优化问题可以通过凸优化来求解,其中使用拉格朗日乘子法将约束优化问题转化为无约束优化问题。

优点:

-

在高维空间中表现良好:SVM通过寻找一个可以将数据分离的超平面来实现分类,这使得SVM在高维空间中表现良好。

-

可以避免过拟合:SVM在最大化边际的同时,也要尽可能地避免分类错误。这样可以有效地避免过拟合的问题。

-

可以处理非线性问题:SVM可以使用核函数将数据从原始空间映射到高维空间,从而解决非线性问题。

缺点:

-

对参数敏感:SVM的性能依赖于选择的核函数和正则化参数C。这些参数的选择对算法的性能有很大影响,但通常需要手动进行调整。

-

不适用于大规模数据集:SVM的训练时间随着数据量的增加而增加。这使得SVM不适用于大规模数据集。

-

可能受到噪声的影响:SVM对于噪声敏感,如果训练集中存在错误的标签或者异常点,可能会对分类器的性能产生负面影响。

总的来说,SVM是一种强大的分类算法,特别适用于高维空间和小数据集。但在实际应用中需要针对具体问题进行参数的调整和模型的优化。

1.2 支持向量机的应用

本篇不过多涉及原理和算法,在处理线性不可分的情况,支持向量机还是很优雅的,在上世纪90年代左右,SVM曾红极一时。常应用于:

-

图像分类和识别:SVM常被用于图像分类和识别任务中,例如人脸识别、数字识别等。

-

自然语言处理:SVM在文本分类、情感分析、文本检索等领域中得到广泛应用。

-

生物信息学:SVM在蛋白质结构预测、DNA分类等生物信息学领域中得到应用。

-

工业应用:SVM在质量控制、故障诊断、预测性维护等领域中得到广泛应用。

-

金融领域:SVM在股票预测、信用评级、欺诈检测等金融领域中应用广泛。

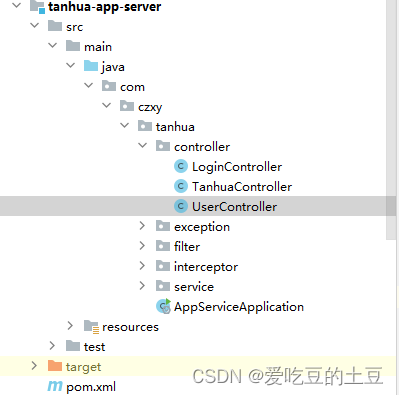

2 demo数据集演示

2.1 导入函数

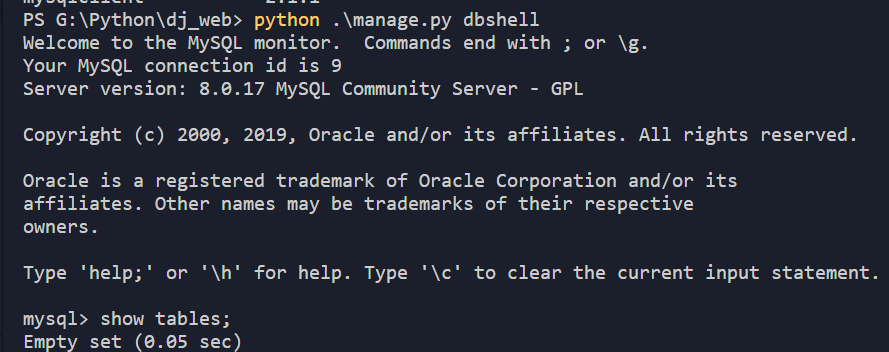

## 基础函数库和画图库

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

## 导入svm

from sklearn import svm

2.2 构建数据集拟合

## 构造数据集

x_fearures = np.array([[-1, -2], [-2, -1], [-3, -2], [1, 3], [2, 1], [3, 2]])

y_label = np.array([0, 0, 0, 1, 1, 1])

## 调用SVC模型 (支持向量机分类)

svc = svm.SVC(kernel='linear')

## 用SVM模型拟合构造的数据集

svc = svc.fit(x_fearures, y_label)

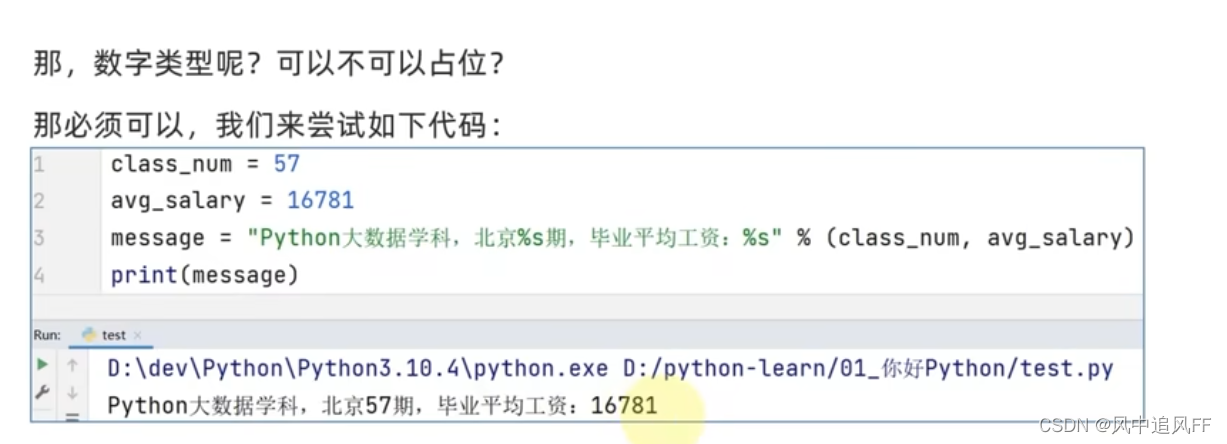

## 查看其对应模型的w

print('the weight of Logistic Regression:',svc.coef_)

## 查看其对应模型的w0

print('the intercept(w0) of Logistic Regression:',svc.intercept_)

2.3 预测模型及可视化

y_train_pred = svc.predict(x_fearures)

print('The predction result:',y_train_pred)

# 可视化

x_range = np.linspace(-3, 3)

w = svc.coef_[0]

a = -w[0] / w[1]

y_3 = a*x_range - (svc.intercept_[0]) / w[1]

# 可视化决策边界

plt.figure()

plt.scatter(x_fearures[:,0],x_fearures[:,1], c=y_label, s=50, cmap='viridis')

plt.plot(x_range, y_3, '-c')

plt.show()

这个结果区分的很明显,方便大家看和理解。

3 实例演示分类(非SVM)

这里模拟一下场景问题,在实际情况中,拿到一个二分类数据后怎么处理?

3.1 导入函数和数据

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets.samples_generator import make_blobs

%matplotlib inline

# 可视化

X, y = make_blobs(n_samples=60, centers=2, random_state=0, cluster_std=0.4)

plt.scatter(X[:, 0], X[:, 1], c=y, s=60, cmap=plt.cm.Paired)

3.2 简单线性分类

# 画散点图

X, y = make_blobs(n_samples=60, centers=2, random_state=0, cluster_std=0.4)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

x_fit = np.linspace(0, 3)

# 画函数

y_1 = 1 * x_fit + 0.8

plt.plot(x_fit, y_1, '-c')

y_2 = -0.3 * x_fit + 3

plt.plot(x_fit, y_2, '-k')

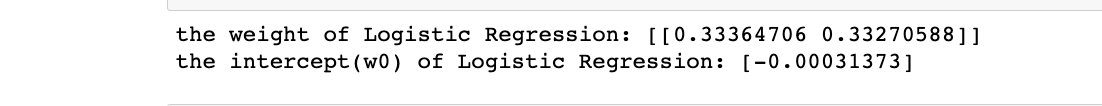

分法很多种,根据结果大家也能看到,但是,这两种分类哪种更好呢?

因此为了判断好坏,需要引入一个准则:好的分类器不仅仅是能够很好的分开已有的数据集,还能对未知数据集进行两个的划分。

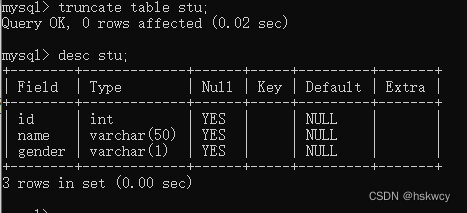

3.3 最大间隔决定分类

这里引入一个点(3, 2.8),很明显两种分类会出现两种不同的结果

因此,引入一个重要的概念:最大间隔,笔者这里类比成置信区间也可

# 画散点图

X, y = make_blobs(n_samples=60, centers=2, random_state=0, cluster_std=0.4)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

x_fit = np.linspace(0, 3)

# 画函数

y_1 = 1 * x_fit + 0.8

plt.plot(x_fit, y_1, '-c')

# 画边距

plt.fill_between(x_fit, y_1 - 0.6, y_1 + 0.6, edgecolor='none', color='#AAAAAA', alpha=0.4)

y_2 = -0.3 * x_fit + 3

plt.plot(x_fit, y_2, '-k')

plt.fill_between(x_fit, y_2 - 0.4, y_2 + 0.4, edgecolor='none', color='#AAAAAA', alpha=0.4)

蓝线的区间是大于黑线的,因此这样看好像选蓝线的分类更优

但是确定没有更大的间隔了?

4 实例演示分类(SVM)

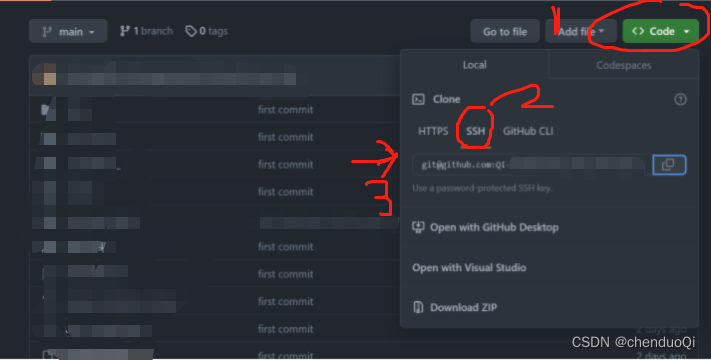

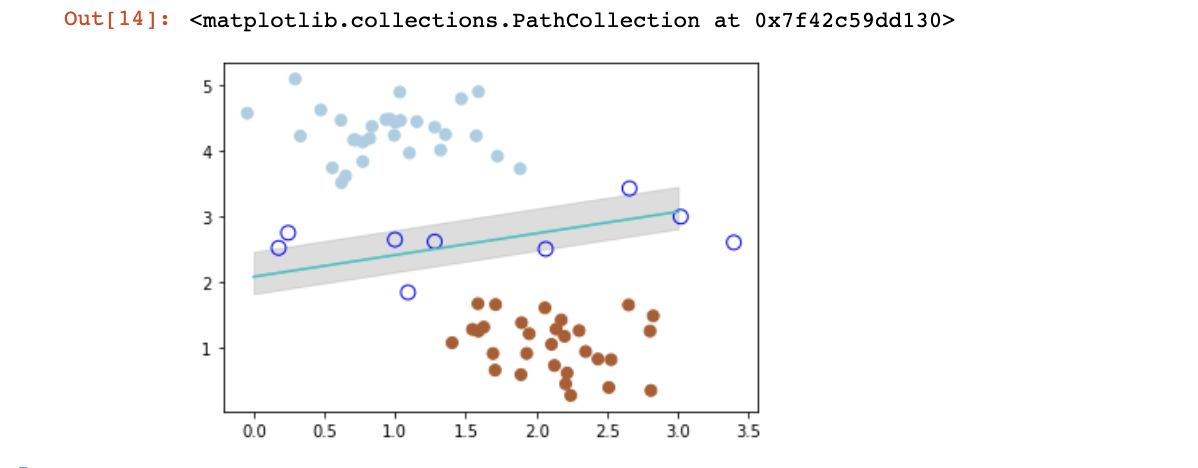

4.1主角登场

from sklearn.svm import SVC

# SVM 函数

clf = SVC(kernel='linear')

clf.fit(X, y)

# 最佳函数

w = clf.coef_[0]

a = -w[0] / w[1]

y_3 = a*x_fit - (clf.intercept_[0]) / w[1]

# 最大边距 下界

b_down = clf.support_vectors_[0]

y_down = a* x_fit + b_down[1] - a * b_down[0]

# 最大边距 上界

b_up = clf.support_vectors_[-1]

y_up = a* x_fit + b_up[1] - a * b_up[0]

# 画散点图

X, y = make_blobs(n_samples=60, centers=2, random_state=0, cluster_std=0.4)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

# 画函数

plt.plot(x_fit, y_3, '-c')

# 画边距

plt.fill_between(x_fit, y_down, y_up, edgecolor='none', color='#AAAAAA', alpha=0.4)

# 画支持向量

plt.scatter(clf.support_vectors_[:, 0], clf.support_vectors_[:, 1], edgecolor='b',

s=80, facecolors='none')

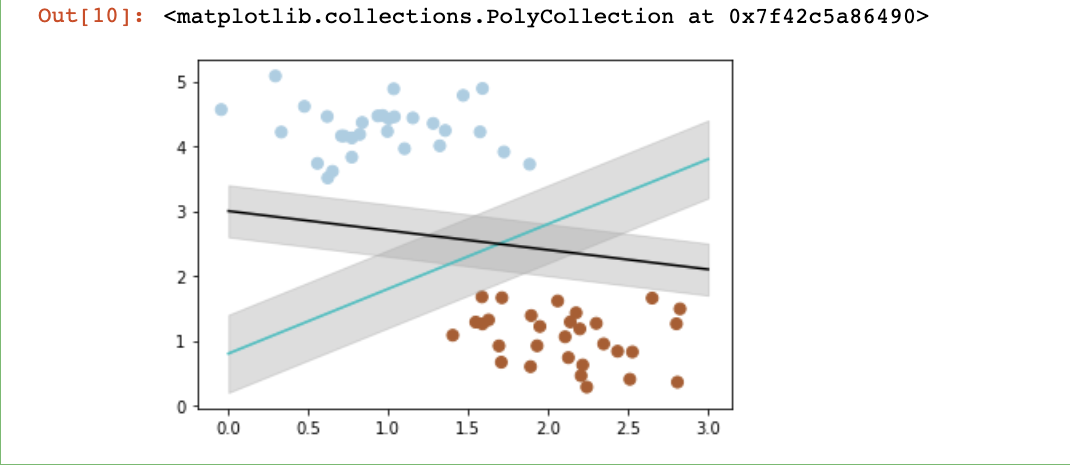

结果显而易见,且图中三个蓝色圆圈即为支持向量,支持向量机提供了在众多可能的分类器之间进行选择的原则,从而确保对未知数据集具有更高的泛化性。

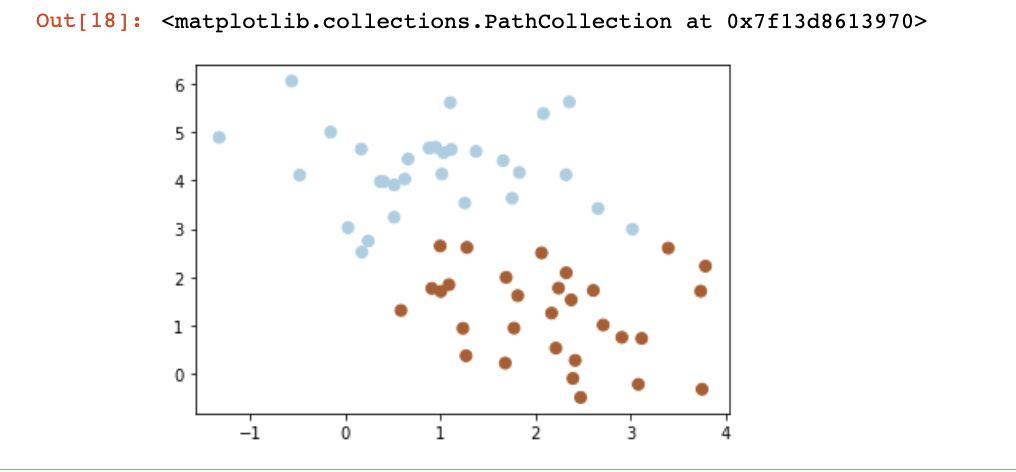

4.2 软间隔

在大多数实际情况中我们遇到的数据:

# 画散点图

X, y = make_blobs(n_samples=60, centers=2, random_state=0, cluster_std=0.9)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

因此软间隔,就是相比于硬间隔,可以容受个别变量处于间隔带中**“墙头草”,但如果没有一个原则进行约束,满足软间隔的分类器也会出现很多条。

所以需要对分错的数据进行惩罚,SVC 函数中,有一个参数 C 就是惩罚参数**。惩罚参数越小,容忍性就越大。

以c=1为例:

# 画散点图

X, y = make_blobs(n_samples=60, centers=2, random_state=0, cluster_std=0.9)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

# 惩罚参数:C=1

clf = SVC(C=1, kernel='linear')

clf.fit(X, y)

# 最佳函数

w = clf.coef_[0]

a = -w[0] / w[1]

y_3 = a*x_fit - (clf.intercept_[0]) / w[1]

# 最大边距 下界

b_down = clf.support_vectors_[0]

y_down = a* x_fit + b_down[1] - a * b_down[0]

# 最大边距 上界

b_up = clf.support_vectors_[-1]

y_up = a* x_fit + b_up[1] - a * b_up[0]

# 画散点图

X, y = make_blobs(n_samples=60, centers=2, random_state=0, cluster_std=0.4)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

# 画函数

plt.plot(x_fit, y_3, '-c')

# 画边距

plt.fill_between(x_fit, y_down, y_up, edgecolor='none', color='#AAAAAA', alpha=0.4)

# 画支持向量

plt.scatter(clf.support_vectors_[:, 0], clf.support_vectors_[:, 1], edgecolor='b',

s=80, facecolors='none')

c=0.2时,兼容性更强

X, y = make_blobs(n_samples=60, centers=2, random_state=0, cluster_std=0.9)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

# 惩罚参数:C=0.2

clf = SVC(C=0.2, kernel='linear')

clf.fit(X, y)

x_fit = np.linspace(-1.5, 4)

# 最佳函数

w = clf.coef_[0]

a = -w[0] / w[1]

y_3 = a*x_fit - (clf.intercept_[0]) / w[1]

# 最大边距 下界

b_down = clf.support_vectors_[10]

y_down = a* x_fit + b_down[1] - a * b_down[0]

# 最大边距 上界

b_up = clf.support_vectors_[1]

y_up = a* x_fit + b_up[1] - a * b_up[0]

# 画散点图

X, y = make_blobs(n_samples=60, centers=2, random_state=0, cluster_std=0.4)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

# 画函数

plt.plot(x_fit, y_3, '-c')

# 画边距

plt.fill_between(x_fit, y_down, y_up, edgecolor='none', color='#AAAAAA', alpha=0.4)

# 画支持向量

plt.scatter(clf.support_vectors_[:, 0], clf.support_vectors_[:, 1], edgecolor='b',

s=80, facecolors='none')

4.3 超平面

还有一种线性不可分的情况:

### 遇到这种数据无法分类

from sklearn.datasets import make_circles

# 画散点图

X, y = make_circles(100, factor=.1, noise=.1, random_state=2019)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

clf = SVC(kernel='linear').fit(X, y)

# 最佳函数

x_fit = np.linspace(-1.5, 1.5)

w = clf.coef_[0]

a = -w[0] / w[1]

y_3 = a*X - (clf.intercept_[0]) / w[1]

plt.plot(X, y_3, '-c')

这种情况,不难想到,直接把它立起来!映射到超平面作划分

### 将2d投放到3d超平面

# 数据映射

r = np.exp(-(X[:, 0] ** 2 + X[:, 1] ** 2))

ax = plt.subplot(projection='3d')

ax.scatter3D(X[:, 0], X[:, 1], r, c=y, s=50, cmap=plt.cm.Paired)

ax.set_xlabel('x')

ax.set_ylabel('y')

ax.set_zlabel('z')

x_1, y_1 = np.meshgrid(np.linspace(-1, 1), np.linspace(-1, 1))

z = 0.01*x_1 + 0.01*y_1 + 0.5

ax.plot_surface(x_1, y_1, z, alpha=0.3)

在 SVC 中,可以用高斯核函数来实现这以功能:kernel=‘rbf’

# 画图

X, y = make_circles(100, factor=.1, noise=.1, random_state=2019)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap=plt.cm.Paired)

clf = SVC(kernel='rbf')

clf.fit(X, y)

ax = plt.gca()

x = np.linspace(-1, 1)

y = np.linspace(-1, 1)

x_1, y_1 = np.meshgrid(x, y)

P = np.zeros_like(x_1)

for i, xi in enumerate(x):

for j, yj in enumerate(y):

P[i, j] = clf.decision_function(np.array([[xi, yj]]))

ax.contour(x_1, y_1, P, colors='k', levels=[-1, 0, 0.9], alpha=0.5,

linestyles=['--', '-', '--'])

plt.scatter(clf.support_vectors_[:, 0], clf.support_vectors_[:, 1], edgecolor='b',

s=80, facecolors='none');

5 讨论

支持向量机是笔者认为既有魅力又“来拒去留”的方法,在筛选特征基因的时候运算也不慢,效果也是挺好的。

概念性的原理,又干又硬还是要去细读理解,ChatGPT给推荐的:

- wiki:Support vector machine

- Support Vector Machines (SVM) clearly explained

- Support Vector Machines for Machine Learning