文章目录

- 1. hive 概述

- 2. hive 与传统关系型数据库的对比

- 3. hive 数据类型

- 4. hive 数据模型

- 5. hive 实战

- 5.1 创建表

- 5.2 修改表

- 5.3 清空表、删除表

- 5.4 其他命令

项目地址 https://github.com/datawhalechina/juicy-bigdata,感谢项目团队的付出。

本次主要学习 hive 相关内容。

1. hive 概述

hive 是建立在 hadoop 之上的数仓工具。它将 hadoop 上存储的结构化、半结构化数据文件映射为表,使得可以通过 HiveQL(HQL)对存储于 hadoop 上的大型数据文件进行访问与分析。

hive 本身并不存储数据,它只是提供了用户与 hadoop 系统文件之前的连接通道。其核心是将 HQL 翻译成 MapReduce 任务,然后提交至 hadoop 集群中进行执行,并给用户返回处理结果。

hive 大幅降低了普通业务人员或者说数据开发(不了解 java 编程)进行大数据分析的门槛。

hive 适合对海量数据进行离线分析,不适合对数据进行实时处理。前边学过的 HBase 适合数据的实时处理。

2. hive 与传统关系型数据库的对比

在使用方面,hive 和传统关系型数据库基本相同,由于其文件系统为 HDFS,hive 与传统关系型数据库还是由不少区别,详见下表对比情况。

| 对比内容 | Hive | 传统关系型数据库 |

|---|---|---|

| 数据存储 | HDFS | 本地文件系统 |

| 索引 | 基本不支持 | 支持复杂索引 |

| 分区 | 支持 | 支持 |

| 执行引擎 | MapReduce、Tez、Spark | 自身的执行引擎 |

| 执行延迟 | 高(T+1) | 低 |

| 扩展性 | 好 | 有限 |

| 数据规模 | 大 | 小 |

3. hive 数据类型

hive 支持以下几种数据类型:

| 大类 | 类型 |

|---|---|

| Integers(整型) | TINYINT:1字节的有符号整数; SMALLINT:2字节的有符号整数; INT:4字节的有符号整数; BIGINT:8字节的有符号整数 |

| Boolean(布尔型) | BOOLEAN:TRUE/FALSE |

| Floating point numbers(浮点型) | FLOAT:单精度浮点型; DOUBLE:双精度浮点型 |

| Fixed point numbers(定点数) | DECIMAL:用户自定义精度定点数,比如 DECIMAL(7,2) |

| String types(字符串) | STRING:指定字符集的字符序列; VARCHAR:具有最大长度限制的字符序列; CHAR:固定长度的字符序列 |

| Date and time types(日期时间类型) | TIMESTAMP:时间戳; TIMESTAMP WITH LOCAL TIME ZONE:本地时区时间戳,纳秒精度; DATE:日期类型 |

| Binary types(二进制类型) | BINARY:字节序列 |

4. hive 数据模型

自上而下,hive 分为库、表、分区、分桶 4种数据模型。

-

库

hive 数据库中,默认的 database 是 default,实际应用中一般不适用 default 数据库而是新建 database。 -

表

hive 本身并不存储数据,hive 表对应的数据都是存储在 HDFS 上,hive 表相关的元数据存储于 hive 内置的Derby(仅支持一个实例,极少使用)或者第三方的MySQL(运行多个实例同时访问)。

hive 表分为内部表和外部表。-

内部表的表创建过程和数据加载过程是分离的,加载数据过程中,数据会被移动至相应的数仓目录下(HDFS 上的 A 位置移动至 HDFS 上的 B 位置),对于 hive 内部表数据的访问都是对数仓目录进行操作。删除 hive 内部表也是真正的删除数据,要慎重哦~

-

外部表的表创建过程和数据加载过程是同一个过程,hive 外部表的创建只是在元数据里添加了映射记录,对于 hive 外部表的访问还是读取 HDFS 上的内容。删除 hive 外部表时,也只是删除了该表的元数据,而并未真正删除数据。

hive 内部表和外部表的差异总结如下:

-

| 对比内容 | 内部表 | 外部表 |

|---|---|---|

| 数据存储位置 | 内部表数据存储的位置由 hive-site.xml 中的hive.Metastore.warehouse.dir参数指定,默认情况下,表的数据存储在 HDFS的/user/hive/warehouse/数据库名.db/表名/目录下 | 外部表数据的存储位置创建表时由Location参数指定 |

| 导入数据 | 在导入数据到内部表,内部表将数据移动到自己的数据仓库目录下, 数据的生命周期由 Hive来进行管理 | 外部表不会将数据移动到自己的数据仓库目录下, 只是在元数据中存储了数据的位置 |

| 删除表 | 删除元数据(metadata)和 HDFS 数据文件 | 只删除元数据(metadata) |

| 安全性 | 低(容易误删数据) | 高 |

- 分区

hive 分区就是将数据存放于不同的目录,查询时命中分区,能避免全表扫描,提高查询效率。 - 分桶

可以在分区的基础上继续进行分桶,所谓分桶,就是将分区内数据以某个字段的hash值进行分组,将数据文件拆分为若干个小文件。优点是优化 join 查询和方便抽样查询,缺点是会生成很多小文件。

5. hive 实战

由于我的 hive 运行环境之前已经部署好了,这里不再赘述,详情可以参考 hive安装部署和管理

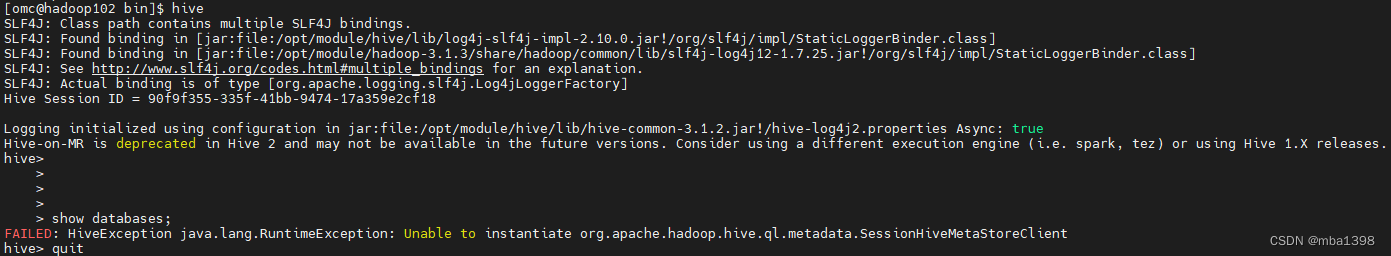

好久不用了,试了下,居然报错了

FAILED: HiveException java.lang.RuntimeException: Unable to instantiate org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient

报错的意思是说无法实例化 hive 元数据客户端,重新初始化之后也是不行。最终通过如下命令解决

cd /opt/module/hive/bin

./hive --service metastore &

./hive

该命令的含义是在后台启动了 hive 元数据服务。

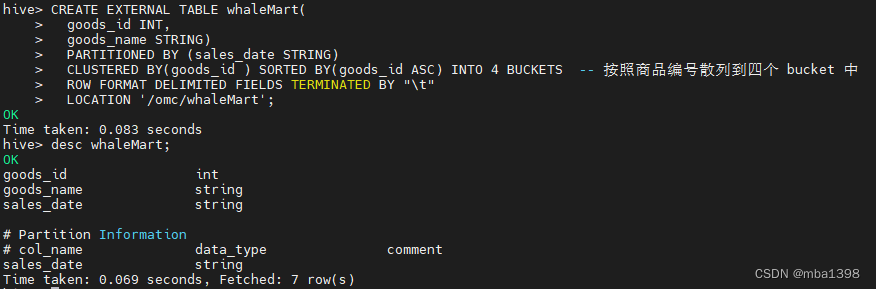

5.1 创建表

hive 创建表的语法如下,实际操作时按需选择操作符即可

CREATE [TEMPORARY] [EXTERNAL] TABLE [IF NOT EXISTS] [db_name.]table_name -- 表名

[(col_name data_type [COMMENT col_comment],

... [constraint_specification])] -- 列名 列数据类型

[COMMENT table_comment] -- 表描述

[PARTITIONED BY (col_name data_type [COMMENT col_comment], ...)] -- 分区表分区规则

[

CLUSTERED BY (col_name, col_name, ...)

[SORTED BY (col_name [ASC|DESC], ...)] INTO num_buckets BUCKETS

] -- 分桶表分桶规则

[SKEWED BY (col_name, col_name, ...) ON ((col_value, col_value, ...), (col_value, col_value, ...), ...)

[STORED AS DIRECTORIES]

] -- 指定倾斜列和值

[

[ROW FORMAT row_format]

[STORED AS file_format]

| STORED BY 'storage.handler.class.name' [WITH SERDEPROPERTIES (...)]

] -- 指定行分隔符、存储文件格式或采用自定义存储格式

[LOCATION hdfs_path] -- 指定表的存储位置

[TBLPROPERTIES (property_name=property_value, ...)] -- 指定表的属性

[AS select_statement]; -- 从查询结果创建表

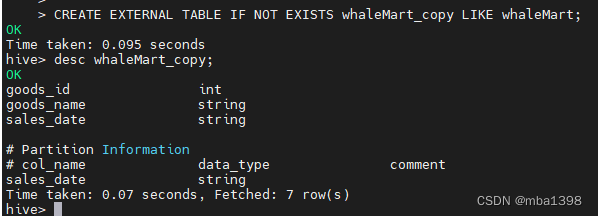

使用 create like 语句可以复制一张表的表结构

CREATE [TEMPORARY] [EXTERNAL] TABLE [IF NOT EXISTS] [db_name.]table_name -- 创建表的表名

LIKE existing_table_or_view_name -- 被复制表的表名

[LOCATION hdfs_path]; -- 存储位置

加载 HDFS 路径数据文件到表的命令如下:

-- 加载数据到 emp 表中

load data local inpath "/home/omc/emp.txt" into table emp;

5.2 修改表

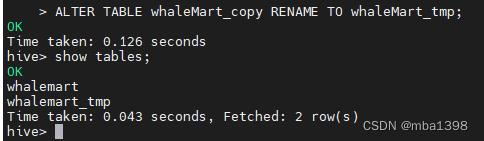

- 修改表名

ALTER TABLE table_name RENAME TO new_table_name;

ALTER TABLE whaleMart_copy RENAME TO whaleMart_tmp;

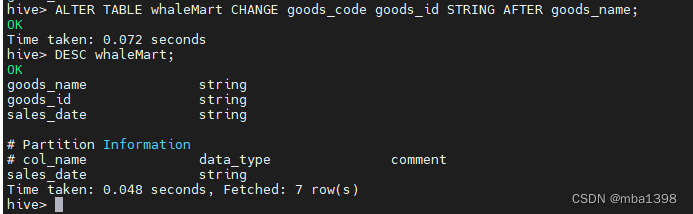

- 修改列

ALTER TABLE table_name [PARTITION partition_spec] CHANGE [COLUMN] col_old_name col_new_name column_type

[COMMENT col_comment] [FIRST|AFTER column_name] [CASCADE|RESTRICT];

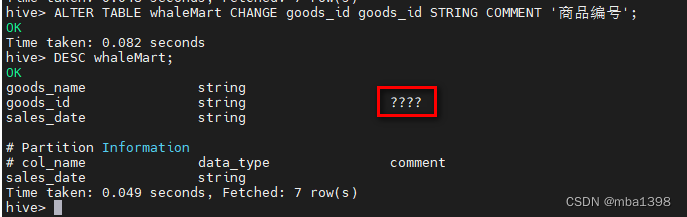

修改 whaleMart 表中的字段属性,命令如下

-- 修改字段名和类型

ALTER TABLE whaleMart CHANGE goods_id goods_code STRING;

-- 修改字段 goods_code 的名称并将其放置到 goods_name 字段后

ALTER TABLE whaleMart CHANGE goods_code goods_id STRING AFTER goods_name;

-- 为字段增加注释

ALTER TABLE whaleMart CHANGE goods_id goods_id STRING COMMENT '商品编号';

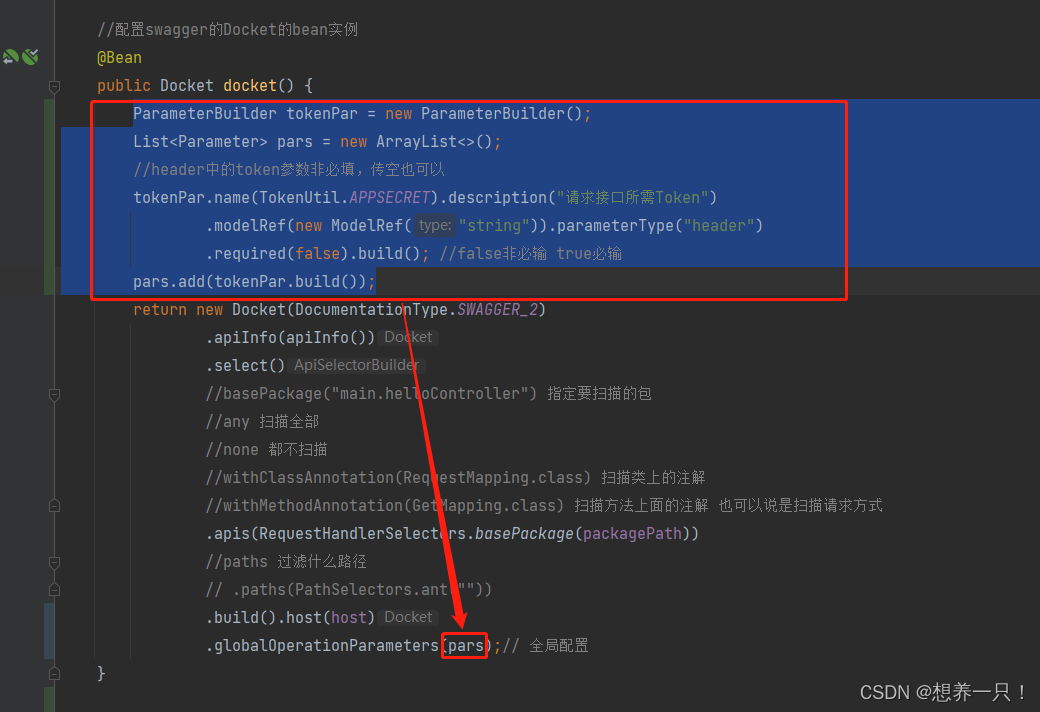

可以看到,添加的中文注释并未正常显示。这是因为 hive 元数据库创建,默认编码是 lanin1,需要登录当前 hive 运行环境的 mysql 数据库,执行如下命令:

//修改字段注释字符集

alter table COLUMNS_V2 modify column COMMENT varchar(256) character set utf8;

//修改表注释字符集

alter table TABLE_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

//修改分区注释字符集

alter table PARTITION_KEYS modify column PKEY_COMMENT varchar(4000) character set utf8;

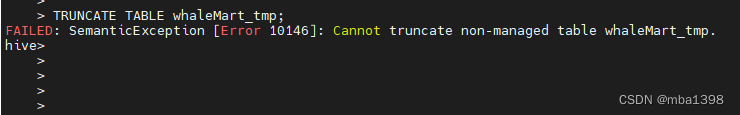

5.3 清空表、删除表

- 清空表

-- 清空整个表或表指定分区中的数据

TRUNCATE TABLE table_name [PARTITION (partition_column = partition_col_value, ...)];

需要注意的是:只有内部表才支持 TRUNCATE 命令,对外部表执行 TRUNCATE 操作时会报错。

- 删除表

DROP TABLE [IF EXISTS] table_name [PURGE];

5.4 其他命令

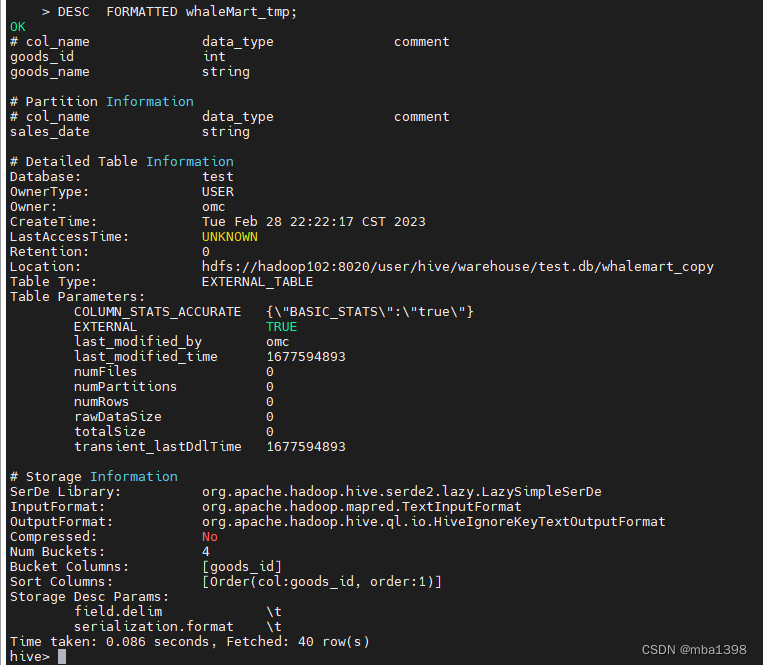

- describe 命令

DESCRIBE|Desc DATABASE [EXTENDED] db_name; -- EXTENDED 是否显示额外属性

DESCRIBE|Desc [EXTENDED|FORMATTED] table_name; -- FORMATTED 以友好的展现方式查看表详情

- show

不太常用的命令如下:

-- 查看视图列表

SHOW VIEWS

-- 查看表的分区列表

SHOW PARTITIONS table_name;

-- 查看表或者视图的创建语句

SHOW CREATE TABLE ([db_name.]table_name|view_name);

![Python虚拟环境(pipenv、venv、conda一网打尽)[通俗易懂]](https://img-blog.csdnimg.cn/395db0329e964553a87b7f18de237d79.png)