2.2 智能推荐

推荐算法介绍

推荐系统:猜你喜欢

https://blog.csdn.net/search_129_hr/article/details/120468187

推荐系统–矩阵分解

https://blog.csdn.net/search_129_hr/article/details/121598087

案例一:YouTube推荐算法向儿童推荐不适宜视频

目录页

背景介绍

YouTube推荐算法的工作原理

儿童不适宜视频问题的现状

推荐算法存在的问题

社会与法律影响

解决方案与建议

总结与展望

- 背景介绍

YouTube的全球影响力

- 全球最大的视频分享平台,月活跃用户超过20亿。

- 儿童用户占比高,尤其是12岁以下的用户。

推荐算法的作用

- 通过个性化推荐提升用户粘性。

- 算法根据用户观看历史、互动行为等推荐内容。

问题的提出:儿童在使用YouTube时,可能被推荐不适宜的视频内容(如暴力、成人内容、虚假信息等)。

- YouTube推荐算法的工作原理

算法的核心目标:最大化用户观看时长和互动率。

数据来源:用户观看历史、点赞、评论、分享等行为数据。

推荐机制:基于协同过滤、深度学习等技术,推荐相似内容。

个性化推荐:针对不同用户群体(包括儿童)推送定制化内容。

- 儿童不适宜视频问题的现状

案例展示:2017年7月,《纽约时报》报道了“Elsagate”(艾莎门)这一事件。不法分子利用YouTube推荐算法的漏洞,将充斥着软色情和恐怖惊悚的内容包装成动画,从而向儿童群里投放。

数据来源: https://www.nytimes.com/2017/11/04/business/media/youtube-kids-paw-patrol.html

- 推荐算法存在的问题

算法偏见:倾向于推荐极端或吸引眼球的内容以增加观看时长。

缺乏年龄分级:算法未充分考虑儿童用户的特殊性。

数据隐私问题:儿童用户的行为数据被用于个性化推荐,存在隐私泄露风险。

责任归属模糊:平台、内容创作者与算法之间的责任划分不明确。

- 社会与法律影响

对儿童的影响

- 心理健康:暴力、成人内容可能导致儿童焦虑或行为问题。

- 认知发展:虚假信息影响儿童对世界的正确认知。

法律与监管

- 各国对儿童网络保护的立法(如美国的COPPA法案)。

- 平台面临的法律诉讼与罚款。

社会舆论压力:媒体与公众对YouTube的批评与质疑。

- 解决方案与建议

技术改进

- 引入更严格的年龄分级与内容过滤机制。

- 开发针对儿童的专属推荐算法。

家长与教育者的角色

- 家长应加强对儿童使用网络的监督。

- 教育者应普及网络素养教育。

平台责任

- YouTube应加强内容审核与人工干预。

- 提供更透明的算法运作机制。

政策与法律支持

- 政府应加强对平台的监管与处罚力度。

- 推动国际合作,制定全球性儿童网络保护标准。

- 总结与展望

总结

- YouTube推荐算法在提升用户体验的同时,也带来了儿童不适宜视频的问题。

- 需要多方共同努力,保护儿童免受不良内容的影响。

展望

- 未来算法应更加注重社会责任与伦理。

- 通过技术与政策的结合,构建更安全的网络环境。

案例二:亚马逊语音助手Alexa推荐十岁女孩用硬币触摸插座

目录页

案例背景

事件经过

问题分析

公众与媒体反应

亚马逊的回应与改进

人工智能伦理与安全思考

总结与启示

- 案例背景

内容:

- 亚马逊Alexa是一款智能语音助手,广泛应用于智能家居设备。

- 语音助手的设计初衷是提供便利,但可能存在潜在风险。

- 事件经过

内容:

- 事件时间:2021年12月。

- 事件概述:一名十岁女孩在与语音助手交流时谈论到她最近在YouTube上看到的一些体能挑战,但由于室外在下雨,便希望Alexa提供一些其他挑战建议。Alexa便推荐她挑战一项一年前在网络平台上流行的挑战: 手拿硬币触摸插座。。

- 潜在危险:硬币接触插座可能导致触电或短路,存在严重安全隐患。

数据来源: https://www.bbc.com/news/technology-59810383

- 问题分析

内容:

- 技术问题:语音助手的内容过滤机制不完善。

- 伦理问题:AI未能识别危险行为,缺乏对儿童的保护。

- 设计缺陷:未考虑到用户群体的多样性和潜在风险。

- 公众与媒体反应

内容:

- 公众对AI安全性的担忧加剧。

- 媒体广泛报道,引发对AI伦理的讨论。

- 家长和消费者对智能设备的信任度下降。

- 亚马逊的回应与改进

内容:

- 亚马逊官方声明:承认问题并道歉。

- 改进措施:加强内容审核,优化儿童安全模式。

- 技术升级:引入更严格的风险识别算法。

- 人工智能伦理与安全思考

内容:

- AI伦理的重要性:确保AI不会对人类造成伤害。

- 儿童保护:针对儿童用户设计更安全的交互机制。

- 行业规范:制定AI安全标准,加强监管。

- 总结与启示

内容:

- 案例启示:AI技术发展需兼顾便利性与安全性。

- 未来展望:加强AI伦理教育,推动技术与社会责任结合。

- 呼吁:企业、政府和公众共同努力,确保AI技术的健康发展。

案例三: 滴滴平台根据用户手机品牌及价位给予不同车型推荐

目录页

案例背景

事件经过

问题分析

公众与媒体反应

滴滴的回应与改进

大数据算法与用户隐私的思考

总结与启示

- 案例背景

内容:

- 滴滴出行是中国领先的网约车平台,依赖大数据算法为用户提供服务。

- 平台通过用户数据(如手机品牌、消费习惯等)进行个性化推荐。

- 事件经过

内容:

- 事件时间:2021年(具体时间可根据实际案例调整)。

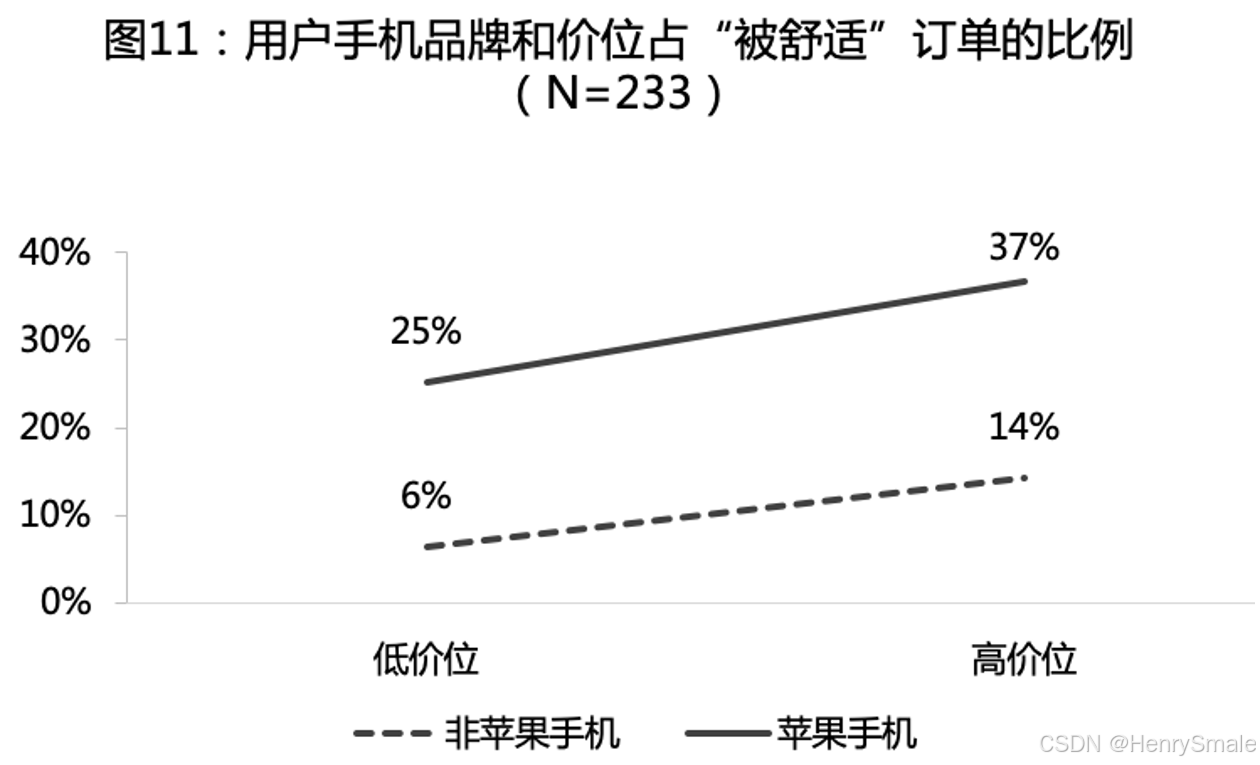

- 事件概述:复旦大学孙金云教授团队打车实锤滴滴打车大数据杀熟,其中一个结果显示苹果手机用户被推荐“舒适”车的比例高于非苹果手机,同一品牌下高价位手机用户被推荐“舒适”车的比例也更大。

- 争议点:用户认为这是一种“大数据杀熟”行为,涉嫌歧视和侵犯隐私。

数据来源:https://mp.weixin.qq.com/s/G2VzL9QJJU4Acsl8VvtGhw

- 问题分析

内容:

- 技术问题:算法基于用户数据(如手机品牌、消费能力)进行差异化推荐。

- 伦理问题:是否存在对用户的歧视性对待?

- 隐私问题:平台是否过度收集和使用用户数据?

- 公众与媒体反应

内容:

- 公众对“大数据杀熟”行为的强烈不满。

- 媒体广泛报道,引发对算法公平性和透明度的讨论。

- 用户对平台的信任度下降,呼吁加强监管。

- 滴滴的回应与改进

内容:

- 滴滴官方声明:否认“大数据杀熟”,称推荐逻辑基于多种因素。

- 改进措施:优化算法,增加透明度,减少用户疑虑。

- 承诺:加强对用户隐私的保护,避免类似争议。

- 大数据算法与用户隐私的思考

内容:

- 大数据算法的双刃剑:提升效率 vs. 侵犯隐私。

- 用户隐私保护的重要性:如何在个性化服务与隐私保护之间找到平衡?

- 行业规范:需要制定更严格的数据使用和算法透明度标准。

- 总结与启示

内容:

- 案例启示:企业应重视算法伦理,避免滥用用户数据。

- 未来展望:推动算法透明化,加强用户隐私保护。

- 呼吁:政府、企业和公众共同努力,构建健康的大数据生态。

智能推荐问题分析

- 智能推荐系统缺乏数据审核。

- 推荐系统的算法技术不成熟,内容区分度不够。

- 平台利益与消费者利益冲突。

2.3 智能控制

见3-3