在人工智能领域,大语言模型(LLM)正以前所未有的速度发展,驱动着自然语言处理、内容生成、智能客服等众多应用的革新。然而,高性能的背后往往是高昂的训练成本,动辄数百万美元的投入让许多企业和研究机构望而却步。近期,国产大模型DeepSeek-R1的横空出世,以其卓越的性能和极具竞争力的成本,打破了这一固有认知。它在MATH基准测试中,以77.5%的准确率媲美OpenAI o1模型,但训练成本却仅为其三分之一,展现出令人瞩目的“低成本、高性能”潜力。

DeepSeek-R1的成功并非偶然,而是其在技术路径上的创新和工程上的极致优化共同作用的结果。它摒弃了传统大模型训练的“暴力计算”模式,转而探索一条“精准智能”的道路,通过算法创新、革命性计算优化、分布式训练创新、数据效率突破、硬件利用率优化以及全流程成本控制六大维度,实现了训练成本的大幅降低,为AI大模型的普及应用带来了新的曙光。

一、突破性强化学习架构:告别“烧钱”的监督微调

传统大模型的训练,往往依赖于先进行大量的监督学习微调(SFT),再辅以强化学习(RL)进行策略优化。然而,DeepSeek-R1另辟蹊径,其基础模型DeepSeek-R1-Zero完全采用纯强化学习(RL)训练路径,彻底抛弃了SFT阶段。这好比传统武术先练套路(SFT),再实战(RL),而DeepSeek-R1则直接进入实战演练,在实战中不断提升技能。

为了解决纯RL训练带来的挑战,DeepSeek团队创新性地开发了群体相对策略优化(GRPO)算法。GRPO算法的核心在于让模型群体相互学习,在竞争与合作中共同进步。更令人惊叹的是,GRPO算法将内存消耗降低至传统PPO算法的三分之一,这意味着在相同的硬件条件下,可以训练更大规模的模型,或者在更少的硬件资源下完成训练,大幅降低了训练成本。

与此同时,DeepSeek-R1并没有完全放弃监督学习的优势。在迭代训练模式上,它巧妙地采用了**"SFT → RL → SFT → RL"的混合训练流程**。这种模式就像“学习-实践-学习-实践”的循环,先通过监督学习快速建立基础,再通过强化学习提升策略水平,然后再次利用监督学习巩固知识,最后再次强化学习精进技能。这种结合监督学习与强化学习双重优势的训练方式,使训练效率提升了约40%,进一步加速了模型迭代和成本控制。

二、革命性计算优化:精度“瘦身”与动态“伸缩”

计算资源是大模型训练的核心成本之一。DeepSeek-R1在计算优化方面进行了革命性的探索,从精度和序列长度两个维度入手,实现了计算效率的显著提升。

FP8混合精度训练是DeepSeek-R1降低内存占用和提升计算吞吐量的关键技术。传统的模型训练通常采用FP16(半精度浮点)或更高精度的数据类型,而DeepSeek-R1大胆地将权重存储精度降至FP8(8位浮点)。这就像将高清照片压缩成标清照片,虽然牺牲了一定的精度,但在大模型训练中,FP8精度足以保持模型性能,却能带来巨大的好处:内存占用减少50%,计算吞吐量提升30%。这意味着在相同的硬件条件下,可以训练更大的模型,或者在更短的时间内完成训练,从而降低计算成本。

动态序列长度调整则是一种更加智能的计算资源分配策略。传统的大模型训练通常采用固定长度的序列处理方式,无论输入文本的长短,都按照最长的序列长度进行计算,造成了大量的计算浪费。而DeepSeek-R1能够根据输入文本的实际长度,动态地调整计算资源分配。例如,处理短文本时,模型会自动缩短计算序列长度,减少不必要的计算。这种灵活的策略相比固定长度处理方式,能够降低20%的计算开销,有效节省了计算资源。

三、分布式训练创新:打破通信瓶颈,加速模型训练

大模型的训练往往需要数百甚至数千块GPU协同工作,分布式训练的效率至关重要。DeepSeek-R1在分布式训练架构上进行了创新,推出了DualPipe并行架构。传统流水线并行方法中,计算和通信操作往往串行执行,造成大量的“流水线气泡时间”,降低了训练效率。DualPipe架构通过巧妙地重叠计算与通信操作,将流水线气泡时间压缩至传统方法的15%以下。这就像在工厂的流水线上,工人A在处理零件的同时,工人B已经开始准备下一个零件,最大限度地减少了等待时间,提高了生产效率。

为了进一步提升通信效率,DeepSeek-R1还采用了NVLink+InfiniBand双通道传输技术,使得集群内部的GPU可以通过高速的NVLink和InfiniBand网络进行高效通信,通信效率提升了65%。这就像拓宽了高速公路,让数据传输更加畅通无阻,加速了模型训练进程。

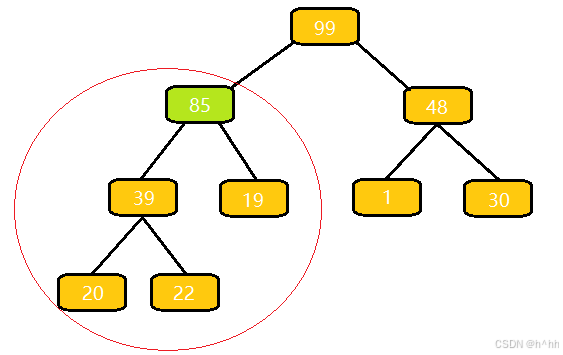

此外,DeepSeek-R1还采用了专家并行技术,并应用于6710亿参数的稀疏混合专家模型(MoE)架构。MoE架构的核心思想是“术业有专攻”,将模型分解为多个“专家”,每个专家只负责处理特定类型的数据。在DeepSeek-R1的MoE模型中,每个token(词或字)仅激活370亿参数,相比于需要激活所有参数的密集模型,计算量减少了80%。这就像一个团队,每个成员都是某个领域的专家,处理问题时,只需要调用相应的专家即可,避免了“眉毛胡子一把抓”的低效模式,大幅降低了计算成本。

四、数据效率突破:精选“优质食材”,提升模型“营养”

数据是AI模型的“粮食”,高质量的数据是训练出高性能模型的关键。DeepSeek-R1在数据效率方面也进行了突破,通过数据蒸馏技术和课程学习策略,提升了数据利用率,减少了对海量数据的依赖。

数据蒸馏技术的核心在于让模型“自主学习”,自己筛选和生成高质量的训练样本。DeepSeek-R1通过模型自主筛选生成了800k高质量训练样本,将无效数据比例从行业平均15%降至3%以下。这就像厨师精心挑选食材,剔除腐烂变质的部分,只留下最优质的部分用于烹饪,保证了菜肴的美味和营养。高质量的数据样本能够让模型学到更有价值的知识,提升训练效率。

课程学习策略则是一种循序渐进的训练方法。DeepSeek-R1采用渐进式数据复杂度训练,先用简单的数据训练模型,再逐渐引入更复杂的数据,就像学习知识一样,从基础到深入,循序渐进。这种策略使模型收敛速度提升了35%,所需训练数据量减少了40%。这意味着可以用更少的数据,更快的速度训练出性能更优的模型,降低了数据获取和处理成本。

五、硬件利用率优化:榨干GPU算力,提升训练效率

硬件资源是AI大模型训练的核心基础设施,如何最大限度地利用硬件资源,提升硬件利用率,是降低训练成本的关键。DeepSeek-R1在硬件利用率优化方面也下足了功夫。

极致工程化改造是DeepSeek团队提升硬件利用率的重要手段。他们通过自定义CUDA内核和算子融合技术,深入优化了底层计算代码,将H800 GPU的MFU(模型FLOP利用率)提升至23%,远超行业平均15%的水平。这就像汽车工程师不断优化发动机,提升燃油效率,让每一滴油都能产生更多的动力。更高的MFU意味着在相同的硬件条件下,可以完成更多的计算任务,提升训练效率。

集群级负载均衡则保证了在多GPU集群环境下,硬件资源能够得到充分利用。DeepSeek-R1在2048块H800 GPU集群上实现了98.7%的持续利用率,相较传统训练方案提升了20个百分点。这就像一个大型工厂,通过合理的生产调度,保证每个生产线都能满负荷运转,避免资源闲置,最大化生产效率。

六、全流程成本控制:创新租赁模式,降低边际成本

除了技术上的优化,DeepSeek-R1还在成本控制方面进行了创新。

租赁模式创新是DeepSeek团队降低硬件成本的重要手段。他们采用了按需GPU租赁策略,结合错峰训练调度,将硬件成本压缩至每H800小时2美元,较自建数据中心方案降低了60%。这就像企业租用云服务器,按需付费,避免了自建机房的高昂成本和维护费用。

边际成本定价则体现了DeepSeek团队的商业智慧。他们以前期5.78亿美元的研发投入为基础,将单个模型训练边际成本降至557万美元,仅为同类模型的30%。这就像大规模生产商品,将研发成本分摊到每个商品上,降低了单个商品的成本。

总结:算法创新、工程优化、数据效率的三维突破

DeepSeek-R1的低成本训练并非单一技术的突破,而是**“算法创新(贡献55%成本节省)+工程优化(30%)+数据效率(15%)”**三维突破的综合体现。它证明了AI大模型训练并非只能依赖“暴力计算”,通过精巧的算法设计、极致的工程优化和高效的数据利用,同样可以实现高性能和低成本的兼得。

DeepSeek-R1的成功,预示着AI大模型训练正从“暴力计算”向“精准智能”范式演进。随着DeepSeek技术路径的成熟和推广,AI大模型的训练成本有望进一步降低,这将加速AI技术的普及应用,让更多企业和个人能够享受到AI带来的红利,推动人工智能技术的蓬勃发展。