极限学习机 (Extreme Learning Machine, ELM) 算法详解与PyTorch实现

目录

- 极限学习机 (Extreme Learning Machine, ELM) 算法详解与PyTorch实现

-

- 1. 极限学习机 (ELM) 算法概述

-

- 1.1 单隐层前馈神经网络

- 1.2 ELM的优势

- 2. ELM的核心技术

-

- 2.1 模型定义

- 2.2 随机初始化

- 2.3 最小二乘法

- 2.4 正则化

- 3. PyTorch实现ELM

-

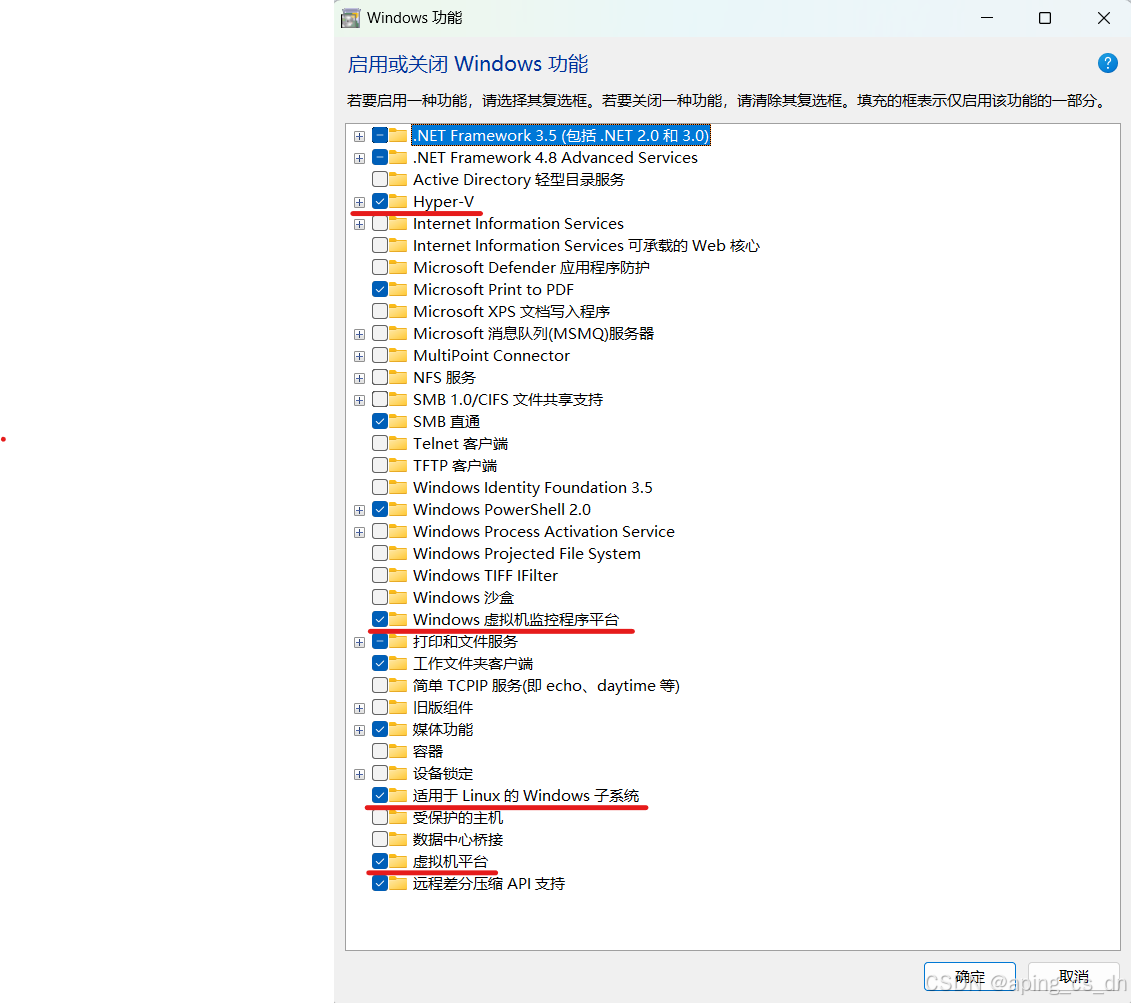

- 3.1 环境准备

- 3.2 PyTorch实现ELM

- 4. 案例一:分类任务 - MNIST数据集

-

- 4.1 数据集介绍

- 4.2 数据预处理

- 4.3 模型训练与评估

- 4.4 运行结果

- 5. 案例二:回归任务 - California Housing数据集

-

- 5.1 数据集介绍

- 5.2 数据预处理

- 5.3 模型训练与评估

- 5.4 运行结果

- 总结

1. 极限学习机 (ELM) 算法概述

极限学习机(Extreme Learning Machine, ELM)是一种单隐层前馈神经网络(SLFN),由黄广斌教授于2006年提出。ELM的核心思想是随机初始化输入层到隐层的权重和偏置,并通过最小二乘法直接计算隐层到输出层的权重。ELM具有训练速度快、泛化性能好等优点,广泛应用于分类、回归和特征学习等任务。

1.1 单隐层前馈神经网络

单隐层前馈神经网络(SLFN)由输入层、隐层和输出层组成。ELM通过随机初始化隐层参数,避免了传统神经网络中耗时的反向传播过程。

1.2 ELM的优势

- 训练速度快:ELM通过最小二乘法直接计算输出层权重,避免了迭代优化过程。

- 泛化性能好:ELM在多个数据集上表现出优异的泛化性能。

- 易于实现:ELM算法简单,易于实现和扩展。

![【C++】P2550 [AHOI2001] 彩票摇奖](https://i-blog.csdnimg.cn/direct/fc6ac6d93b4745b591bb8a8e48f86779.png#pic_right)