【大语言模型】ACL2024论文-27 Mementos:一个全面的多模态大型语言模型在图像序列推理上的基准测试

目录

文章目录

- 【大语言模型】ACL2024论文-27 Mementos:一个全面的多模态大型语言模型在图像序列推理上的基准测试

- 目录

- 文章

- 摘要

- 研究背景

- 问题与挑战

- 如何解决

- 创新点

- 算法模型

- 实验效果(包含重要数据与结论)

- 推荐阅读指数和推荐理由

- 后记

文章

Mementos: A Comprehensive Benchmark for Multimodal Large Language Model Reasoning over Image Sequences

Mementos:一个全面的多模态大型语言模型在图像序列推理上的基准测试

摘要

本文介绍了Mementos,一个旨在评估多模态大型语言模型(MLLMs)在图像序列上的顺序推理能力的新型基准测试。Mementos包含了4761个不同长度的多样化图像序列,并采用GPT-4辅助的方法来评估MLLMs的推理性能。通过对九个最新的MLLMs(包括GPT4V和Gemini)的细致评估,研究发现这些模型在准确描述给定图像序列的动态信息时存在困难,常常导致对象及其行为的幻觉/误表示。通过定量分析和案例研究,文章识别了影响MLLMs顺序图像推理的三个关键因素:对象与行为幻觉之间的相关性、共发生行为的影响以及行为幻觉的累积效应。研究结果表明,Mementos对当前的MLLMs构成了相当的挑战,揭示了MLLMs在从图像序列中推断事件能力上的重大缺陷。

研究背景

随着多模态大型语言模型(MLLMs)的出现,如GPT-4V和Gemini,这些模型在图像描述和视觉问题回答等视觉语言任务上展现出了强大的理解和生成能力。然而,现有的MLLMs在推理能力上存在不足,尤其是在处理单个图像时,容易产生幻觉现象,即模型对给定图像的描述不准确。因此,监控MLLMs的推理能力对于理解它们的能力和局限性以及在现实世界中的应用至关重要。尽管现有的基准测试主要评估每个单独图像的推理能力,但它们不足以全面评估MLLMs的推理能力,因为缺乏对时变对象行为或事件的评估。为了调查MLLMs在动态推理中的能力,本文提出了一个新的基准测试Mementos,专注于监控和解读图像序列中对象位置变化的复杂任务,并推断它们之间的行为模式和逻辑联系。

问题与挑战

当前的MLLMs在处理单个图像时已经展现出了推理能力的不足,而在处理图像序列时,这种不足变得更加明显。图像序列的理解需要模型能够处理时间变化的视觉元素,并基于这些元素解释上下文,这比静态场景的分析更具挑战性。Mementos基准测试旨在评估MLLMs在图像序列上的推理能力,特别是它们在描述图像序列中的动态信息时的准确性和可靠性。

如何解决

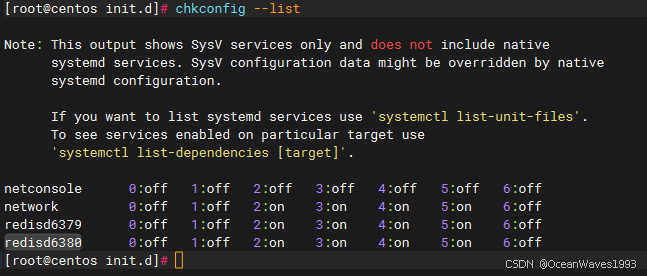

为了解决MLLMs在图像序列推理中的挑战,本文提出了Mementos基准测试,它包含4761个不同长度的图像序列,涵盖了日常生活、机器人任务和漫画风格的故事板等多样化场景。每个序列都配有人工注释的描述,包括序列中主要对象及其行为。为了评估MLLMs的推理能力,本文采用了GPT-4辅助的评估程序:在MLLM生成图像序列的描述后,使用GPT-4从AI生成的描述和人工注释的描述中提取行为和对象关键词,然后使用关键词匹配来评估行为和对象幻觉的程度。此外,为了提高评估的准确性,研究者还开发了行为和对象同义词图,以便更精确地进行关键词匹配,确保对MLLMs推理能力的全面和细致分析。

创新点

- 新型基准测试:Mementos是首个专门针对MLLMs在图像序列推理能力上的全面基准测试。

- 多样化数据集:Mementos包含来自不同领域的4761个图像序列,提供了丰富的测试场景。

- GPT-4辅助评估:采用GPT-4来提取关键词,并与人工注释进行比较,提供了一种新颖的评估方法。

- 同义词图:开发了行为和对象的同义词图,以提高关键词匹配的准确性。

- 深入分析:通过定量分析和案例研究,识别了影响MLLMs顺序图像推理的三个关键因素。

算法模型

Mementos基准测试本身不是一个算法模型,而是一个用于评估MLLMs性能的测试集。它包括图像序列和相应的人工注释描述,以及一个GPT-4辅助的评估程序。评估程序使用GPT-4从MLLM生成的描述中提取关键词,并与人工注释的关键词进行匹配,以评估MLLMs的推理能力。

实验效果(包含重要数据与结论)

实验部分评估了九个最新的MLLMs在Mementos上的表现,包括GPT-4V和Gemini。实验结果显示,所有测试的MLLMs在生成图像序列描述时都存在显著的行为和对象幻觉。例如,GPT-4V在不同领域中表现出明显的行为和对象幻觉。行为幻觉被定义为MLLMs对实体行为的错误解释或预测,而对象幻觉涉及在图像序列中对对象的错误识别或创造。值得注意的是,行为幻觉比对象幻觉更频繁,突出了MLLMs在从图像序列中推断事件能力上的重大缺陷。

实验还发现,MLLMs在图像序列推理中的能力因领域而异。例如,黑盒模型在机器人领域表现最好,而开源模型在日常生活领域表现相对较好。此外,MLLMs在理解图像序列中的对象比理解行为表现得更好,这表明当前MLLMs在自主推断给定顺序图像的行为上的能力不强,这强调了Mementos基准测试在揭示MLLMs推理能力局限性上的重要性。

推荐阅读指数和推荐理由

推荐阅读指数:★★★★☆

后记

如果您对我的博客内容感兴趣,欢迎三连击 ( **点赞、收藏和关注 **)和留下您的评论,我将持续为您带来计算机人工智能前沿技术(尤其是AI相关的大语言模型,深度学习和计算机视觉相关方向)最新学术论文及工程实践方面的内容分享,助力您更快更准更系统地了解 AI前沿技术。

![洛谷题解P1219 [USACO1.5] 八皇后 Checker Challenge](https://i-blog.csdnimg.cn/direct/4cf05122133548998d7fdc499d219661.png)