本文还有配套的精品资源,点击获取

简介:本书由黄文坚撰写,深入介绍了TensorFlow的使用方法。TensorFlow是谷歌开发的开源库,用于数值计算和机器学习,特别是在深度学习方面。书中通过丰富的实例和详细解释,引导读者学习TensorFlow的核心概念、数据流图、变量管理、模型构建、损失函数、优化器、数据集处理、模型保存和恢复、序列化处理以及一些高级话题。本书旨在帮助读者掌握TensorFlow的实战技能,包括构建和训练深度学习模型。

1. TensorFlow概述和核心概念

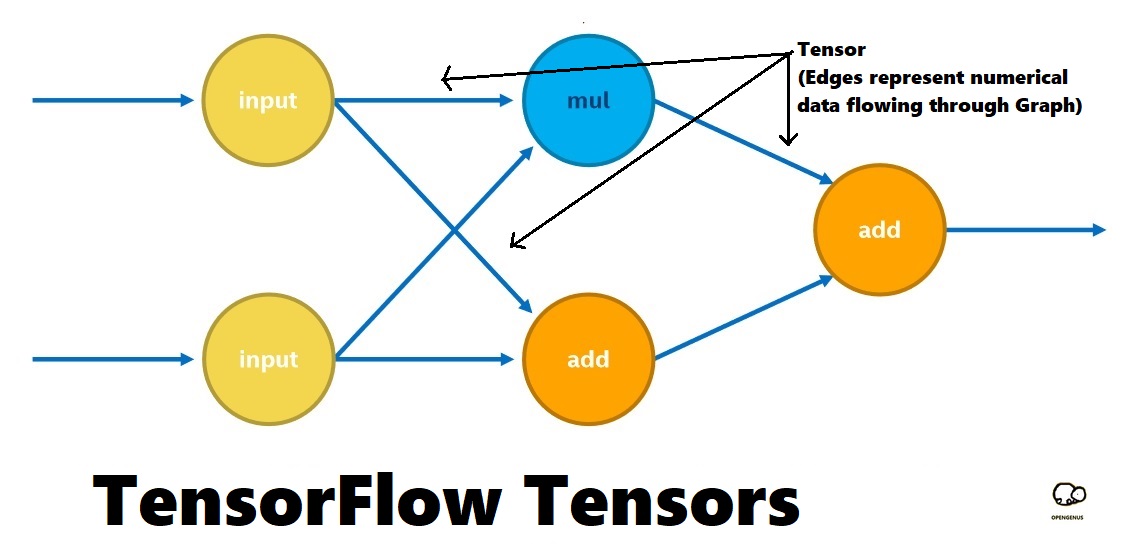

TensorFlow是谷歌大脑团队于2015年开源的一个机器学习库,以其强大的计算能力、灵活性和跨平台特性成为了业界领先的深度学习框架之一。TensorFlow的命名来源于其支持的张量(Tensor)运算和数据流图(Flow)架构,这两大核心概念是理解和使用TensorFlow的基础。

1.1 TensorFlow的历史和特点

TensorFlow的历史可追溯至谷歌的深度学习项目DistBelief,在其基础上进行了大规模重写以支持更加广泛的应用场景。作为一款开源工具,TensorFlow拥有庞大的社区支持和丰富的学习资源,其特点包括:

- 跨平台 :支持从移动设备到服务器的多种平台。

- 灵活性 :适用于不同的算法和架构,包括卷积神经网络(CNN)、循环神经网络(RNN)等。

- 可扩展性 :可以部署在多GPU和分布式系统上以提升计算性能。

1.2 TensorFlow的核心概念

TensorFlow的核心概念涵盖以下几个方面:

- 张量(Tensor) :张量可以看作是多维数组,它们是TensorFlow中数据的基本表示方式。

- 数据流图(Data Flow Graphs) :图中节点表示数学运算,而边表示在这些节点间传递的多维数组(张量)。

这些概念构成了TensorFlow的设计哲学,理解这些将为掌握TensorFlow打下坚实的基础。接下来的章节将深入探讨数据流图编程模型、变量管理、构建深度学习模型、损失函数和优化器的使用、以及模型训练、验证和测试等关键话题。

2. 数据流图编程模型

2.1 数据流图的概念与结构

2.1.1 数据流图的定义

在TensorFlow中,数据流图是一种计算图,它由一系列节点组成,每个节点表示一个操作(也称为算子),而图中的边则表示操作间传递的多维数组,也称为张量(Tensors)。TensorFlow允许开发者以图形化的方式构建复杂的机器学习模型,这些模型被分解为多个节点和边,形成了计算的流程。

数据流图不仅可视化了模型的结构,还控制了计算的执行。当你执行一个操作时,它会返回一个结果,这个结果可以被后续操作作为输入,从而实现数据在图中的流动。这种模型特别适合机器学习,因为机器学习的算法往往是由多个步骤和多个操作组合而成的复杂过程。

2.1.2 图节点(Node)与边(Edge)的含义

在数据流图中,节点(Node)是图的基本构成单位,它代表一个操作,如加法、乘法或其他特定的操作。边(Edge)是节点之间的连接,代表了数据(张量)的流向。在TensorFlow中,节点可以是输入节点、计算节点或输出节点。

每个节点有一个唯一的名称,并接受零个或多个张量作为输入,执行操作后输出零个或多个张量。输入和输出的具体内容,包括其数据类型和维度信息,被称作张量的“形状”(shape)。

2.1.3 张量(Tensor)的基本操作

张量是数据流图中数据的载体,是多维数组的一种泛化。张量在TensorFlow中不仅仅是数据,它们还是图中的边,连接着不同的节点。在实际编程中,我们可以对张量执行多种操作,比如创建、索引、切片、组合等。

例如,张量可以被初始化,也可以通过特定的操作改变形状或值。在深度学习中,通过定义一系列张量操作来构建和更新模型的参数。通过这些操作,数据在图中流动,从而完成复杂的计算任务。

2.2 图的构建与运行机制

2.2.1 构建图的基本原则

构建图时,应当遵循一些基本原则,以保证图能够被正确地执行。首先,应当明确每个节点的输入输出依赖关系,避免出现循环依赖,因为这会导致图无法执行。其次,应当合理地组织节点,使得图能够高效地运行,比如通过合并小的操作减少计算开销。

此外,对于需要重用的部分图,可以通过定义子图来实现,这有助于提高代码的可读性和重用性。最后,为了方便图的调试,应当为图中的节点和边赋予具有意义的名称,这有助于在图执行时出现问题时快速定位问题所在。

2.2.2 会话(Session)的作用与生命周期

在TensorFlow中,会话(Session)是执行图中操作的环境。它负责分配计算资源并运行图中的操作。开发者创建会话后,可以在会话环境中运行图,执行节点并将结果返回给用户。会话的生命周期包括创建、运行和关闭三个阶段。

创建会话时,TensorFlow会为该会话分配必要的资源。在会话中运行图时,TensorFlow会进行图的优化,并根据图的结构来调度任务的执行顺序。完成工作后,关闭会话是释放资源的重要步骤,应保证所有使用过的会话都被正确关闭。

2.2.3 图的运行机制及其性能优化

图的运行机制是TensorFlow的核心概念之一。在运行时,TensorFlow会根据节点之间的依赖关系,自动选择并行执行的操作,最大化计算资源的利用率。为了提高图运行的性能,开发者可以进行多种优化,包括但不限于:

- 使用控制依赖来控制操作的执行顺序。

- 合并多个小的操作到一个更大的操作中,减少调用开销。

- 使用

tf.dataAPI 来构建高效的数据管道。 - 利用

tf.function将Python函数转化为静态图,提高执行速度。

性能优化需要根据具体情况来定,开发者需要对图进行分析,找出性能瓶颈,并采取适当的优化措施。

import tensorflow as tf

# 创建一个计算图

a = tf.constant([[1.0, 2.0], [3.0, 4.0]])

b = tf.constant([[1.0, 2.0], [3.0, 4.0]])

c = tf.add(a, b)

# 创建一个会话来运行图

***pat.v1.Session() as sess:

result = sess.run(c)

print(result)

在上述代码中,我们首先定义了两个常量张量a和b,然后定义了一个加法操作c。通过创建一个会话,我们将图中的c操作运行,计算出结果并打印。

2.3 实际应用:构建简单的线性回归模型

为了更好地理解数据流图的概念与结构,我们可以构建一个简单的线性回归模型。模型的结构相对简单,但是能够说明数据流图的构建与执行机制。

import tensorflow as tf

import numpy as np

# 使用numpy生成一些模拟数据

X = np.linspace(-1, 1, 100)

Y = 0.5 * X + 0.3 + np.random.normal(0, 0.05, (100,))

# 定义占位符,用于输入数据

X_ph = ***pat.v1.placeholder(tf.float32, name="X")

Y_ph = ***pat.v1.placeholder(tf.float32, name="Y")

# 定义模型参数

W = tf.Variable(np.random.randn(), name="weight")

b = tf.Variable(np.random.randn(), name="bias")

# 定义预测模型

Y_pred = tf.multiply(X_ph, W) + b

# 定义损失函数

loss = tf.reduce_mean(tf.square(Y_ph - Y_pred))

# 定义优化器,并指定学习率

optimizer = ***pat.v1.train.GradientDescentOptimizer(learning_rate=0.01).minimize(loss)

# 创建会话来执行模型训练

***pat.v1.Session() as sess:

# 初始化所有变量

sess.run(***pat.v1.global_variables_initializer())

# 进行100次迭代训练

for step in range(100):

sess.run(optimizer, feed_dict={X_ph: X, Y_ph: Y})

if step % 10 == 0:

print(f"Step {step} loss: {sess.run(loss, feed_dict={X_ph: X, Y_ph: Y})}")

在上面的代码中,我们首先通过numpy生成了一些模拟数据用于线性回归模型的训练。接着,我们定义了占位符用于输入数据、模型参数、预测模型、损失函数和优化器。最后,在会话中执行了模型的训练过程。

通过这个例子,我们可以看到如何使用TensorFlow的数据流图来构建和执行一个完整的机器学习模型。这种模型构建方法不仅适用于简单的线性回归模型,也可以扩展到更复杂的深度学习模型中。

3. 变量创建与初始化

3.1 变量的定义和初始化方法

3.1.1 TensorFlow中变量的创建方式

在TensorFlow中,变量是模型中需要学习和更新的参数。创建变量时,需要指定初始值,该初始值可以是一个具体的数,也可以是特定的分布。以下是使用TensorFlow创建变量的基本方法:

import tensorflow as tf

# 创建一个名为'weights'的变量,初始化为1的2x3矩阵

weights = tf.Variable(tf.ones([2, 3]), name='weights')

# 创建一个名为'biases'的变量,初始化为0的1x3矩阵

biases = tf.Variable(tf.zeros([1, 3]), name='biases')

在这里, tf.Variable 是创建变量的关键函数,它的第一个参数是初始化值,后面可以跟随其他参数进行高级配置。 name 参数用于给变量命名,有助于在图中进行管理。

3.1.2 初始化变量的策略

在TensorFlow中,有几种内置的初始化方法,其中包括:

-

tf.zeros:创建全为零的变量。 -

tf.ones:创建全为一的变量。 -

tf.truncated_normal:创建正态分布的变量,但是会剪掉超出两倍标准差的值。 -

tf.constant_initializer:用指定常数值初始化变量。

此外,还可以使用 tf.global_variables_initializer() 创建一个操作(op),该操作在运行时将所有全局变量初始化为它们的初始值。通常这个操作在模型训练的开始时调用。

# 初始化所有全局变量

init_op = tf.global_variables_initializer()

# 创建会话并初始化

with tf.Session() as sess:

sess.run(init_op)

在创建了变量并指定了初始化方法之后,必须通过会话(session)来实际执行初始化操作,使变量的值被赋予并保存在内存中。

3.2 变量的保存与恢复

3.2.1 使用Saver类保存和恢复变量

在TensorFlow中, tf.train.Saver 类提供了一种方便的方式来保存和恢复模型。模型的保存不仅包括变量的值,还包括整个计算图的结构。这样做的好处是即使在模型训练中断后,也可以从上次中断的地方恢复,继续训练。

# 创建Saver对象,指定保存和恢复变量时的名称前缀

saver = tf.train.Saver()

# 保存变量到指定路径

save_path = saver.save(sess, "model.ckpt")

print("Model saved in ***" % save_path)

# 恢复变量值

saver.restore(sess, "model.ckpt")

print("Model restored.")

3.2.2 恢复变量时的注意事项

在恢复模型时需要注意的是,必须确保恢复时的计算图与保存时的计算图在结构上完全一致。在变量命名空间上也要保持一致,否则会抛出错误。此外,恢复时不需要再次初始化变量,因为Saver对象会在恢复时同时处理初始化。

为了确保一致性,可以使用 tf.train.import_meta_graph 来导入一个图的元数据文件,并恢复变量。

# 导入图的结构

saver = tf.train.import_meta_graph('model.ckpt.meta')

# 恢复变量的值

saver.restore(sess, tf.train.latest_checkpoint('./'))

3.3 变量作用域及共享机制

3.3.1 作用域的概念和使用方法

在TensorFlow中,作用域(Scope)提供了一个层次化的命名机制,用于控制变量和其他张量的命名。创建作用域可以为变量名添加前缀,这有助于区分不同的变量组,尤其是在具有复杂结构的网络中。

# 创建作用域

with tf.variable_scope("layer1"):

weights1 = tf.Variable(tf.random_normal([2, 3]), name='weights')

biases1 = tf.Variable(tf.zeros([1, 3]), name='biases')

# 创建另一个作用域

with tf.variable_scope("layer2"):

weights2 = tf.Variable(tf.random_normal([3, 2]), name='weights')

biases2 = tf.Variable(tf.zeros([1, 2]), name='biases')

使用 tf.variable_scope 可以创建一个命名空间,其中定义的所有变量都会带有这个前缀。作用域可以嵌套使用,形成更深层次的结构。

3.3.2 变量共享的场景和操作技巧

变量共享是一种常见的编程模式,在TensorFlow中可以通过 reuse 参数来实现。共享变量可以减少模型大小,提高效率,特别是在构建诸如循环神经网络(RNN)等结构时非常有用。

# 创建第一个作用域并定义变量

with tf.variable_scope("scope1") as scope:

var1 = tf.Variable(tf.zeros([1]), name='var1')

print("Var1 created:", var1)

# 通过reuse=True参数共享变量

with tf.variable_scope("scope1", reuse=True) as scope:

var2 = tf.Variable(tf.zeros([1]), name='var1')

print("Var2 created:", var2)

上述代码中,虽然 var2 和 var1 在不同的作用域块内创建,但是由于我们设置了 reuse=True ,它们实际上指向了同一个变量。这是通过 tf.AUTO_REUSE 实现的,它允许在该作用域内的任何变量被自动重用。

# 创建变量作用域

with tf.variable_scope("scope") as scope:

# 创建一些变量

v = tf.get_variable("v", [1])

scope.reuse_variables()

# 通过reuse变量再次尝试创建变量v

v1 = tf.get_variable("v", [1])

在这里, tf.get_variable 创建了一个新的变量,但是由于 reuse 已经被调用,所以 v1 实际是 v 的别名,它们共享同样的内存地址和值。

4. 构建各类深度学习模型

在深度学习领域,构建模型是实现智能算法的关键。TensorFlow提供了丰富的工具和函数库,可以用来构建复杂的神经网络结构。本章主要介绍如何在TensorFlow框架下构建不同类型的基本深度学习模型,包括前馈神经网络(FNN)、卷积神经网络(CNN)和循环神经网络(RNN)。为了实现这些模型,我们将深入探讨它们的理论基础和TensorFlow中的具体实现方法。

4.1 神经网络基础组件

在构建复杂的深度学习模型之前,理解神经网络的基础组件是非常重要的。基础组件包括层(Layer)、激活函数、卷积层、池化层等。这些组件构成了神经网络的基本架构,决定了模型的学习能力和特征提取能力。

4.1.1 层(Layer)和激活函数的理解

层是神经网络中数据流动的基本单元。在TensorFlow中,可以通过 tf.keras.layers 包含的多个类来创建不同类型的层,例如全连接层、卷积层等。

激活函数用于为神经网络引入非线性,这是处理复杂问题的关键因素之一。常用的激活函数包括ReLU、Sigmoid和Tanh等。

import tensorflow as tf

from tensorflow.keras.layers import Dense

# 创建一个全连接层

dense_layer = Dense(units=64, activation='relu')

# 输出层通常使用softmax激活函数

output_layer = Dense(units=10, activation='softmax')

在这个代码片段中, Dense 类用来创建全连接层。 units 参数定义了层的大小,即神经元的数量,而 activation 参数定义了使用的激活函数。 relu 用于隐藏层, softmax 用于输出层以进行多分类任务。

4.1.2 卷积层(Convolutional Layer)和池化层(Pooling Layer)

卷积层是CNN的核心,其作用是提取输入数据的特征。池化层主要用来降低特征的空间尺寸,减少参数数量和计算量,同时保留特征的重要信息。

from tensorflow.keras.layers import Conv2D, MaxPooling2D

# 创建一个卷积层

conv_layer = Conv2D(filters=32, kernel_size=(3, 3), activation='relu')

# 创建一个池化层

pooling_layer = MaxPooling2D(pool_size=(2, 2))

在这个例子中, Conv2D 类用来创建卷积层, filters 定义了卷积核的数量, kernel_size 定义了卷积核的大小,而 activation 再次定义了激活函数。 MaxPooling2D 类创建了一个最大池化层,其中 pool_size 定义了池化窗口的大小。

4.2 构建前馈神经网络(FNN)

4.2.1 理解前馈神经网络的结构

前馈神经网络是最简单的神经网络类型之一,它通过一系列的全连接层接收输入,并生成输出。每层的神经元只与前一层的神经元相连,信息从输入层单向流向输出层。

4.2.2 基于TensorFlow实现FNN

基于TensorFlow的API,我们可以使用 Sequential 模型来快速构建一个简单的FNN模型。

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

model = Sequential()

model.add(Dense(units=64, activation='relu', input_shape=(784,)))

model.add(Dense(units=10, activation='softmax'))

***pile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

在这段代码中,我们首先创建了一个 Sequential 模型,然后逐层添加了两个 Dense 层。第一个 Dense 层的 input_shape 参数定义了输入数据的形状。最后,我们使用 compile 方法编译了模型,并指定了优化器、损失函数和评估指标。

4.3 构建卷积神经网络(CNN)

4.3.1 CNN的理论基础

CNN通过卷积层自动并有效地从图像中提取特征,是图像识别、处理和计算机视觉问题中的主要神经网络结构。它利用空间层次结构,减少了参数的数量,加速了计算速度。

4.3.2 使用TensorFlow构建CNN模型

TensorFlow的 tf.keras 模块提供了一个简洁的API来构建和训练CNN模型。下面是一个简单的例子:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, Flatten, Dense

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

MaxPooling2D((2, 2)),

Flatten(),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

***pile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

在这个例子中, Conv2D 、 MaxPooling2D 、和 Flatten 层被顺序添加到 Sequential 模型中。卷积层和池化层被用来提取和降维图像特征,而全连接层则用来分类。这个模型适合处理图像数据。

4.4 构建循环神经网络(RNN)

4.4.1 RNN的理论基础和变体

循环神经网络(RNN)主要用于处理序列数据。与前馈网络不同,RNN具有记忆能力,能够记住之前的信息,并将其应用到当前的任务中。RNN的一个典型问题是梯度消失和梯度爆炸。为了解决这些问题,开发了多种RNN的变体,如LSTM和GRU。

4.4.2 构建RNN模型的实践操作

TensorFlow提供了 SimpleRNN 、 LSTM 和 GRU 等层来构建RNN模型。下面是一个使用 LSTM 层构建的简单RNN模型:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

model = Sequential([

LSTM(128, return_sequences=True, input_shape=(None, 512)),

LSTM(128),

Dense(512, activation='relu'),

Dense(10, activation='softmax')

])

***pile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

在这个例子中,我们使用了两个 LSTM 层来构建RNN模型。 return_sequences=True 参数确保了第一个 LSTM 层将序列返回到下一个层,而不仅仅是最后一个输出。这样的网络结构适合于处理需要时间步长信息的任务,例如语言模型和时间序列预测。

以上章节内容仅为部分展示。在实际文章中,每个章节还需包含大量深度分析、图表说明、代码执行逻辑说明等,以确保文章内容的深度和质量,满足至少2000字的一级章节、1000字的二级章节以及每个三级章节至少包含6段200字以上的内容的要求。

5. 损失函数和优化器的定义

5.1 损失函数的选择与应用

5.1.1 常见损失函数的种类和特点

在机器学习和深度学习中,损失函数是衡量模型预测值与真实值差异的重要指标,它指导模型的优化方向。以下是一些常见的损失函数类型及其特点:

- 均方误差(Mean Squared Error, MSE): 用于回归问题,衡量模型输出与真实值之间的平均平方差。

- 对数损失(Log Loss): 也称为交叉熵损失,常用于二分类问题,可以度量概率分布之间的差异。

- 交叉熵损失(Cross Entropy Loss): 用于多分类问题,它是衡量两个概率分布差异的指标。

- 0-1损失(Zero-One Loss): 用于分类问题,只有当预测完全错误时损失为1,否则为0,但因其不连续性,不常用作优化目标。

- Hinge Loss: 用于支持向量机(SVM)等二分类问题,主要用于最大化决策边界的分类器。

选择合适的损失函数至关重要,因为它直接影响模型的训练效果和性能。

5.1.2 如何选择合适的损失函数

选择合适的损失函数需要考虑问题的类型(回归或分类)、数据的分布、模型的输出类型等因素。以下是选择损失函数的一些建议:

- 对于回归问题,通常使用MSE。

- 对于二分类问题,推荐使用对数损失或交叉熵损失。

- 对于多分类问题,应该使用交叉熵损失。

- 当需要处理不平衡数据集时,可以使用加权版本的损失函数。

损失函数的选择不仅要考虑问题类型,还应考虑实际应用中的需求,比如在一些特定场景下,我们需要自定义损失函数来满足特殊需求。

5.2 优化器的原理与参数调优

5.2.1 优化器的基本工作原理

优化器是用于最小化损失函数的算法,它根据损失函数的梯度来更新模型参数,以达到最小化预测误差的目的。常见的优化算法包括:

- 梯度下降(GD): 每次迭代沿着梯度方向更新参数,更新幅度由学习率决定。

- 随机梯度下降(SGD): 与GD类似,但每次只使用一个样本或一小批样本来计算梯度,从而加快了计算速度。

- 动量(Momentum): 结合了之前的梯度信息,加快了收敛速度,并有助于在复杂空间中逃避局部最小值。

- 自适应学习率算法(如Adam, RMSprop): 动态调整学习率,有助于在训练过程中提供更加稳定的收敛。

优化器的选择很大程度上取决于具体问题、数据规模和模型复杂度。

5.2.2 常见优化器的性能比较及调参方法

不同优化器有着各自的优缺点,通常需要通过实验来确定最佳的优化器。以下是几种常见优化器性能比较和参数调优的建议:

- SGD 通常比GD收敛得快,适用于大数据集。但调参较为复杂,学习率太大容易震荡,太小则收敛速度慢。

- Momentum 在许多问题上表现良好,有助于加快收敛,尤其当存在许多曲面时。

- Adam 结合了Momentum和RMSprop的优势,适合多种问题,且通常不需要过多调整参数。

- RMSprop 是为非平稳目标设计的,对学习率的选择不如Adam敏感,适合处理数据稀疏的问题。

调参是一个反复尝试的过程,建议从一个合理的初始值开始,然后逐渐调整学习率,观察训练过程和验证集的性能,直到找到最佳参数。

5.3 自定义优化器和损失函数

5.3.1 如何在TensorFlow中自定义优化器

在TensorFlow中,你可以通过定义一个优化器类来实现自定义优化算法。以下是一个简单的自定义优化器的例子,用于实现梯度下降优化器:

import tensorflow as tf

class CustomSGD(tf.keras.optimizers.Optimizer):

def __init__(self, learning_rate=0.01, name='CustomSGD', **kwargs):

super(CustomSGD, self).__init__(name, **kwargs)

self._set_hyper('learning_rate', kwargs.get('lr', learning_rate))

def _create_slots(self, var_list):

for var in var_list:

self.add_slot(var, 'm')

@tf.function

def _resource_apply_dense(self, grad, var):

var_name = var.name

m = self.get_slot(var, 'm')

lr_t = self._get_hyper('learning_rate')

m.assign(tf.multiply(0.9, m) + tf.multiply(lr_t, grad))

var.assign_sub(tf.multiply(lr_t, m))

def get_config(self):

config = super(CustomSGD, self).get_config()

config.update({'learning_rate': self._serialize_hyperparameter('learning_rate')})

return config

5.3.2 自定义损失函数的实践案例

在TensorFlow中,自定义损失函数相对简单。你可以通过Python函数来定义损失函数,并将其传递给模型的 loss 参数。以下是一个自定义对数损失函数的例子:

import tensorflow as tf

def custom_log_loss(y_true, y_pred):

epsilon = 1e-7 # 防止log(0)

y_pred = tf.clip_by_value(y_pred, epsilon, 1 - epsilon)

loss = -tf.reduce_mean(y_true * tf.math.log(y_pred) + (1 - y_true) * tf.math.log(1 - y_pred))

return loss

# 使用自定义损失函数

***pile(optimizer='adam', loss=custom_log_loss)

在自定义损失函数时,应考虑数值稳定性、梯度的可计算性以及是否符合实际问题的需求。通过自定义这些函数,可以更精确地控制模型的训练过程,提高模型的性能。

6. 模型训练、验证与测试

6.1 模型的训练过程

6.1.1 训练循环的基本结构

在TensorFlow中,模型的训练过程主要包含以下几个步骤:定义模型结构、初始化变量、训练循环、评估模型性能。训练循环是其中的核心环节,通常包括前向传播、计算损失、反向传播和参数更新。

import tensorflow as tf

# 假设已经构建好模型和损失函数

model = build_model()

optimizer = tf.keras.optimizers.Adam()

def train_step(images, labels):

with tf.GradientTape() as tape:

predictions = model(images, training=True)

loss = compute_loss(labels, predictions)

gradients = tape.gradient(loss, model.trainable_variables)

optimizer.apply_gradients(zip(gradients, model.trainable_variables))

return loss

# 迭代训练数据

for epoch in range(num_epochs):

for (batch, (images, labels)) in enumerate(train_dataset):

loss = train_step(images, labels)

6.1.2 高效训练的技巧和方法

为了提高模型训练的效率,可以采取以下一些技巧:

- 使用Batch处理数据 :批处理可以减少内存消耗,提高计算效率。

- 梯度累积 :在内存不足的情况下,可以累积多个batch的梯度,再统一进行参数更新。

- 学习率调整 :在训练过程中动态调整学习率,如使用学习率衰减策略。

- 并行计算和GPU加速 :利用多GPU进行数据并行处理,可以显著提升训练速度。

6.2 模型的验证与超参数调优

6.2.1 验证集的作用和选择策略

验证集用于监测模型在未见过的数据上的表现,帮助我们了解模型的泛化能力,同时避免模型过拟合。选择策略通常遵循以下原则:

- 数据划分 :将训练数据划分为训练集和验证集,一般比例为8:2或7:3。

- 保持数据分布的一致性 :验证集和训练集应具有相似的数据分布。

- 交叉验证 :当数据量有限时,可以使用交叉验证方法来评估模型性能。

6.2.2 超参数调优的常见方法

超参数调优是机器学习中的重要环节,常见的方法有:

- 网格搜索 :通过穷举所有可能的参数组合来找出最佳超参数。

- 随机搜索 :随机选择参数组合,可能比网格搜索更高效。

- 贝叶斯优化 :利用概率模型来指导超参数的搜索,效率较高。

- 基于模型的优化 :使用如Hyperopt、Optuna等工具自动进行超参数调优。

6.3 模型测试与性能评估

6.3.1 测试集的重要性和测试方法

测试集用于评估模型最终的泛化能力,选择测试集的原则和验证集类似,但测试集不应该被用于模型训练过程中的任何决策,以保证评估的客观性。测试方法通常包括:

- 固定模型 :在测试集上评估的模型应当是经过验证集调优后的最终模型。

- 重复测试 :为了评估模型的稳定性,可以多次使用不同的测试集进行测试。

6.3.2 模型评估指标的选择和解读

评估指标的选择依赖于具体的任务类型,例如:

- 分类问题 :准确率、精确率、召回率、F1分数等。

- 回归问题 :均方误差(MSE)、均方根误差(RMSE)等。

- 排名问题 :精确率@k、平均精度均值(MAP)等。

评估指标的解读应结合业务需求和模型性能的实际意义进行分析。

6.4 模型的保存与加载

6.4.1 保存模型的步骤和技巧

在TensorFlow中保存模型可以通过以下步骤进行:

- 保存整个模型结构和权重 :使用

model.save()方法可以保存整个模型。 - 仅保存模型权重 :使用

model.save_weights()方法可以单独保存模型权重。

# 保存整个模型

model.save('my_model')

# 保存模型权重

model.save_weights('my_model_weights')

6.4.2 加载模型进行预测和评估

加载模型进行预测和评估通常涉及以下步骤:

- 加载整个模型 :使用

tf.keras.models.load_model()加载整个模型。 - 加载模型权重 :使用

model.load_weights()加载模型权重。

# 加载整个模型

loaded_model = tf.keras.models.load_model('my_model')

# 加载模型权重

model.load_weights('my_model_weights')

# 使用加载的模型进行预测或评估

predictions = loaded_model.predict(test_data)

在实际操作中,模型的保存和加载应确保模型结构的一致性,特别是在使用自定义层或对象时。

本文还有配套的精品资源,点击获取

简介:本书由黄文坚撰写,深入介绍了TensorFlow的使用方法。TensorFlow是谷歌开发的开源库,用于数值计算和机器学习,特别是在深度学习方面。书中通过丰富的实例和详细解释,引导读者学习TensorFlow的核心概念、数据流图、变量管理、模型构建、损失函数、优化器、数据集处理、模型保存和恢复、序列化处理以及一些高级话题。本书旨在帮助读者掌握TensorFlow的实战技能,包括构建和训练深度学习模型。

本文还有配套的精品资源,点击获取