💗💗💗欢迎来到我的博客,你将找到有关如何使用技术解决问题的文章,也会找到某个技术的学习路线。无论你是何种职业,我都希望我的博客对你有所帮助。最后不要忘记订阅我的博客以获取最新文章,也欢迎在文章下方留下你的评论和反馈。我期待着与你分享知识、互相学习和建立一个积极的社区。谢谢你的光临,让我们一起踏上这个知识之旅!

文章目录

- 🍋1. 条件随机场(CRF)概述

- 🍋1.1 CRF模型的背景

- 🍋1.2 CRF的数学表示

- 🍋2. CRF在命名实体识别中的应用

- 🍋2.1 使用CRF进行NER

- 🍋3. 主流命名实体识别框架

- 🍋3.1 BERT-CRF

- 🍋3.2 LSTM-CRF

- 🍋4. 代码实现

- 🍋4.1 数据准备

- 🍋4.2 LSTM-CRF模型

- 🍋4.3 训练与评估

- 🍋5. 使用CRF进行处理Resume数据集

- 🍋6. 总结

命名实体识别(Named Entity Recognition,简称NER)是自然语言处理中的一项重要任务,它涉及从文本中识别出具有特定意义的实体,如人名、地点、时间、机构等。为了解决NER问题,许多机器学习和深度学习模型都被提出,其中条件随机场(Conditional Random Field,简称CRF)是一种重要的模型。本文将从CRF的概念、应用领域以及在命名实体识别中的使用出发,介绍一些流行的命名实体识别框架,如BERT-CRF和LSTM-CRF,最后展示具体的代码实现。

🍋1. 条件随机场(CRF)概述

🍋1.1 CRF模型的背景

随机场(Random Fields)是一种用于建模具有一定关联性的随机变量集合的概率模型。条件随机场(CRF)是图模型的一种,它是在给定观测序列的条件下,通过学习标签序列之间的条件概率分布来进行预测。与传统的隐马尔可夫模型(HMM)不同,CRF不仅考虑当前状态的转移概率,还能够建模任意的上下文信息。

🍋1.2 CRF的数学表示

在CRF中,我们有一个观测序列X=(x1,x2,x3,…,xn)和一个标签序列Y=(y1,y2,y3,…,yn),我们的目标是计算给定观测序列 X下标签序列Y的条件概率 P(Y∣X)

CRF的核心思想是通过最大化条件概率来进行模型训练:

其中,𝑓𝑘 是特征函数,𝜆𝑘 是特征函数的权重,Z(X) 是规范化常数,确保所有可能的标签序列的概率和为1。

🍋2. CRF在命名实体识别中的应用

命名实体识别的目标是从文本中提取出具有特定含义的实体。典型的NER任务包括识别人名、地点、组织、时间等信息。在NER中,输入是一个单词序列,而输出是每个单词的类别标签。

例如,给定句子:“Steve Jobs was born in San Francisco.”,NER的目标是为每个词汇分配一个标签(例如,PER表示人名,LOC表示地点名):

Steve PER

Jobs PER

was O

born O

in O

San LOC

Francisco LOC

. O

🍋2.1 使用CRF进行NER

在命名实体识别中,CRF模型可以通过利用上下文信息来预测每个词的标签。CRF能够很好地建模标签之间的依赖关系,尤其是在标签是有序的(例如,连续的实体可能属于相同类别)时,CRF表现尤为出色。通过设计合适的特征函数,CRF能够综合考虑词本身的特征以及词之间的上下文关系,从而提高NER任务的准确率。

🍋3. 主流命名实体识别框架

🍋3.1 BERT-CRF

BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer的预训练语言模型。由于BERT能够捕捉到上下文信息,并且支持双向编码,它在多项NLP任务中都表现出色,尤其在NER任务上,BERT取得了突破性的成果。

BERT-CRF结合了BERT模型的上下文表示能力与CRF的标签依赖建模能力。BERT负责提取每个词的上下文特征,而CRF则负责建模词之间的标签依赖关系,从而进一步提高命名实体识别的效果。

BERT-CRF的实现思路:

- 使用BERT提取每个词的上下文表示。

- 将BERT的输出作为CRF模型的输入。

- 使用CRF层进行标签预测。

🍋3.2 LSTM-CRF

LSTM(Long Short-Term Memory)是一种常用的循环神经网络(RNN)模型,它在处理序列数据时具有较好的记忆能力。LSTM-CRF结合了LSTM模型的序列建模能力与CRF的标签依赖建模能力。

LSTM-CRF的实现思路:

- 使用LSTM处理输入的词序列,生成每个词的隐藏状态表示。

- 将LSTM的输出作为CRF模型的输入。

- 使用CRF层进行标签预测。

LSTM-CRF对于长距离依赖关系的建模能力较强,尤其适用于需要考虑长期上下文信息的NER任务。

🍋4. 代码实现

🍋4.1 数据准备

在实现NER模型之前,我们需要准备好数据集。这里我们假设已经有一个预处理好的NER数据集,其中每个句子的每个词都对应着一个标签。

import torch

import torch.nn as nn

from torchcrf import CRF

from torch.utils.data import DataLoader, Dataset

# 示例数据集

class NERDataset(Dataset):

def __init__(self, sentences, labels):

self.sentences = sentences

self.labels = labels

def __len__(self):

return len(self.sentences)

def __getitem__(self, idx):

return torch.tensor(self.sentences[idx]), torch.tensor(self.labels[idx])

# 假设已将数据预处理成了ID的形式

train_sentences = [[1, 2, 3], [4, 5, 6]]

train_labels = [[0, 1, 2], [0, 2, 1]]

train_data = NERDataset(train_sentences, train_labels)

train_loader = DataLoader(train_data, batch_size=2, shuffle=True)

🍋4.2 LSTM-CRF模型

LSTM-CRF模型的核心由LSTM层和CRF层构成。LSTM层负责处理输入序列的上下文信息,CRF层则处理标签之间的依赖关系。

class LSTMCRF(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim, tagset_size):

super(LSTMCRF, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.lstm = nn.LSTM(embedding_dim, hidden_dim, batch_first=True)

self.fc = nn.Linear(hidden_dim, tagset_size)

self.crf = CRF(tagset_size, batch_first=True)

def forward(self, sentences, labels=None):

embeddings = self.embedding(sentences)

lstm_out, _ = self.lstm(embeddings)

emissions = self.fc(lstm_out)

if labels is not None:

loss = -self.crf(emissions, labels)

return loss

else:

return self.crf.decode(emissions)

🍋4.3 训练与评估

训练LSTM-CRF模型时,我们需要定义损失函数和优化器。训练过程中,我们通过计算模型的损失来更新参数。

# 模型实例化

model = LSTMCRF(vocab_size=10, embedding_dim=50, hidden_dim=128, tagset_size=3)

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 训练过程

for epoch in range(10):

model.train()

total_loss = 0

for sentences, labels in train_loader:

optimizer.zero_grad()

loss = model(sentences, labels)

loss.backward()

optimizer.step()

total_loss += loss.item()

print(f'Epoch {epoch}, Loss: {total_loss / len(train_loader)}')

🍋5. 使用CRF进行处理Resume数据集

import sklearn_crfsuite

from sklearn.model_selection import train_test_split

from sklearn_crfsuite import metrics

# 读取数据并进行处理

def read_data(file_path):

sentences = []

labels = []

with open(file_path, 'r', encoding='utf-8') as f:

sentence = []

label = []

for line in f:

line = line.strip()

if line: # 非空行

word, tag = line.split() # 分割字符和标签

sentence.append(word)

label.append(tag)

else: # 空行表示一个句子的结束

if sentence:

sentences.append(sentence)

labels.append(label)

sentence = []

label = []

# 如果文件没有以空行结束,需要加上最后一个句子

if sentence:

sentences.append(sentence)

labels.append(label)

return sentences, labels

# 特征提取函数

def word2features(sentence, i):

word = sentence[i]

features = {

'word.lower()': word.lower(),

'word[-3:]': word[-3:],

'word[-2:]': word[-2:],

'is_first': i == 0,

'is_last': i == len(sentence)-1,

'prev_word': '' if i == 0 else sentence[i-1],

'next_word': '' if i == len(sentence)-1 else sentence[i+1],

}

return features

# 转换为 CRF 格式

def prepare_data(sentences, labels):

X = []

y = []

for sentence, label in zip(sentences, labels):

X.append([word2features(sentence, i) for i in range(len(sentence))])

y.append(label)

return X, y

# 读取文件

train_sentences, train_labels = read_data('./data/ResumeNER/demo.train.char.bmes')

dev_sentences, dev_labels = read_data('./data/ResumeNER/demo.dev.char.bmes')

test_sentences, test_labels = read_data('./data/ResumeNER/demo.test.char.bmes')

# 准备特征

X_train, y_train = prepare_data(train_sentences, train_labels)

X_dev, y_dev = prepare_data(dev_sentences, dev_labels)

X_test, y_test = prepare_data(test_sentences, test_labels)

# 训练 CRF 模型

crf = sklearn_crfsuite.CRF(

algorithm='lbfgs',

c1=0.1, c2=0.1,

max_iterations=100,

all_possible_transitions=True

)

crf.fit(X_train, y_train)

# 评估模型

y_pred = crf.predict(X_test)

print(metrics.flat_classification_report(y_test, y_pred))

# 输出 CRF 模型的特征权重

for (label, label_id) in crf.classes_:

print(f'{label}: {crf.state_features_[(label_id, "word.lower()")]}')

运行结果

综合评估:

准确率(Accuracy):

你的模型总体的准确率是 0.61,即模型在所有 371 个样本中,正确分类的比例是 61%。

Macro Average:

这是所有类别的 精确率、召回率 和 F1 值 的简单平均,不考虑类别的样本量。

Precision:0.33

Recall:0.23

F1-score:0.24

这些数值表示,虽然模型在一些标签上表现不错(如 O 标签),但在大部分标签上性能较差,尤其是 B-EDU, B-NAME 等标签的精确率和召回率都为 0。

Weighted Average:

这是考虑类别的样本量后得到的加权平均,给更多样本量大的类别更多权重。

Precision:0.68

Recall:0.61

F1-score:0.58

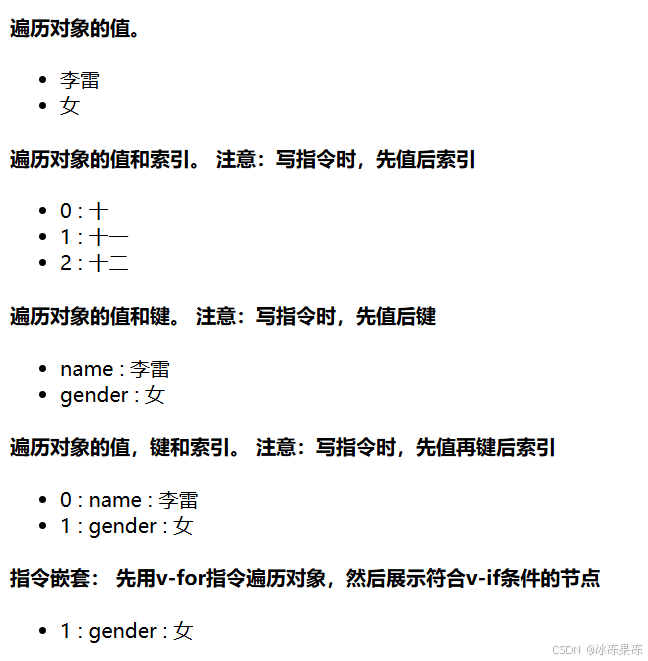

加权平均数值较高,意味着模型在大样本量类别(如 O 标签)上的表现较好,模型更多地倾向于在这些常见类别上做出正确预测。当然如果我们想更好的预测,还是要使用一些主流的模型,例如BERT-BILSTM-CRF等架构,或者参考下图,一些作者提出的模型,数值都是比较高的了,NLP在进步,NER更在进步,数值在一点点的逼近100%

🍋6. 总结

条件随机场(CRF)是一种强大的序列建模方法,能够捕捉标签之间的依赖关系。在命名实体识别(NER)任务中,CRF能够通过建模词汇之间的关系,提高模型的性能。结合BERT或LSTM等深度学习模型,CRF在NER任务中的表现更加优秀。通过BERT-CRF和LSTM-CRF的实现,本文展示了如何将CRF与现代深度学习方法结合,从而提升命名实体识别的效果。

在实际应用中,NER模型需要根据具体任务的需求选择合适的框架和特征,例如是否需要考虑长距离依赖、是否有大量上下文信息等。在未来,我们可以进一步探索如何利用更加复杂的模型和特征来优化NER任务的性能。

挑战与创造都是很痛苦的,但是很充实。