使用 Funboost 分布式函数调度爬取视频

- 1. 安装依赖

- 2. 使用 Funboost 配置分布式爬虫

- 创建 Funboost 配置文件

- 配置爬虫任务

- 保存视频和图片

- 启动爬虫

- 3. 处理并存储数据

- 4. 免责声明

1. 安装依赖

首先,我们需要安装一些必要的依赖。你可以使用 pip 来安装它们:

pip install requests beautifulsoup4 funboost

requests: 用来发送 HTTP 请求。beautifulsoup4: 用来解析 HTML 页面。funboost: 分布式函数调度框架。

2. 使用 Funboost 配置分布式爬虫

在 Funboost 中,我们可以使用任务调度框架来分配和管理爬虫任务。下面的示例将演示如何使用 Funboost 来进行视频爬取。

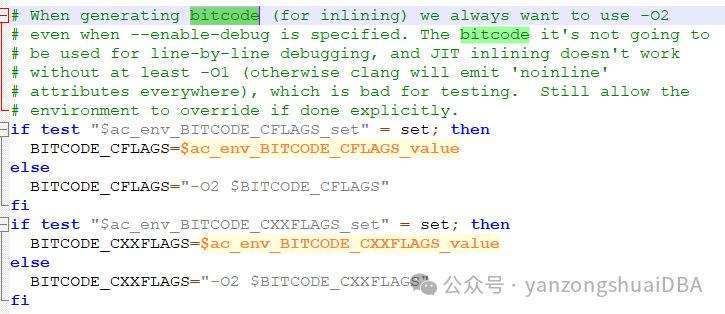

创建 Funboost 配置文件

首先,创建一个 Python 文件 config.py,用来配置 Funboost:

# config.py

from funboost import Funboost

# 初始化 Funboost 配置

funboost = Funboost(project="douyin_beauty_crawler", debug=True)

# 配置爬取任务队列

funboost.set_queue("video_queue", max_jobs=5)

funboost.set_queue("image_queue", max_jobs=10)

这里的 project="douyin_beauty_crawler" 是指定项目名称,video_queue 和 image_queue 是我们用来存储视频和图片的任务队列。

配置爬虫任务

我们需要创建两个任务,一个用来爬取视频,另一个用来爬取图片。每个任务都会由 Funboost 分布式框架调度执行。

# crawler.py

import requests

from bs4 import BeautifulSoup

from funboost import FunboostTask

import os

# 视频爬取任务

@FunboostTask(queue="video_queue")

def fetch_video_data(page_number: int):

base_url = "https://www.douyin.com/beauty"

# 获取视频页面 HTML

response = requests.get(f"{base_url}?page={page_number}")

if response.status_code != 200:

print(f"Failed to retrieve page {page_number}")

return

# 解析 HTML

soup = BeautifulSoup(response.text, "html.parser")

# 提取视频 URL

video_elements = soup.find_all("a", class_="video-link")

video_urls = [el.get("href") for el in video_elements if el.get("href")]

# 打印爬取的视频 URL

for video_url in video_urls:

print(f"Found video URL: {video_url}")

return video_urls

# 图片爬取任务

@FunboostTask(queue="image_queue")

def fetch_image_data(page_number: int):

base_url = "https://www.douyin.com/beauty"

# 获取抖音页面 HTML

response = requests.get(f"{base_url}?page={page_number}")

if response.status_code != 200:

print(f"Failed to retrieve page {page_number}")

return

# 解析 HTML

soup = BeautifulSoup(response.text, "html.parser")

# 提取图片 URL

image_elements = soup.find_all("img", class_="image-class")

image_urls = [img.get("src") for img in image_elements if img.get("src")]

# 打印爬取的图片 URL

for img_url in image_urls:

print(f"Found image URL: {img_url}")

return image_urls

解释:

@FunboostTask(queue="video_queue"):标记该函数为一个任务,并指定该任务使用的视频队列进行调度。requests.get():发送 HTTP 请求获取页面内容。BeautifulSoup:解析 HTML,提取视频和图片的 URL。video_elements和image_elements:通过BeautifulSoup查找视频和图片标签。

保存视频和图片

为了保存视频和图片,我们可以使用 requests 下载内容:

# 下载视频

def download_video(video_url: str, save_path: str):

response = requests.get(video_url, stream=True)

with open(save_path, "wb") as f:

for chunk in response.iter_content(chunk_size=1024):

if chunk:

f.write(chunk)

# 下载图片

def download_image(image_url: str, save_path: str):

response = requests.get(image_url, stream=True)

with open(save_path, "wb") as f:

for chunk in response.iter_content(chunk_size=1024):

if chunk:

f.write(chunk)

启动爬虫

为了启动爬虫并调度任务,我们需要在主程序中调用:

# main.py

from funboost import Funboost

from crawler import fetch_video_data, fetch_image_data

# 初始化 Funboost 配置

funboost = Funboost(project="douyin_beauty_crawler", debug=True)

# 启动任务调度

if __name__ == "__main__":

# 触发视频爬取任务

funboost.add(fetch_video_data, page_number=1)

# 触发图片爬取任务

funboost.add(fetch_image_data, page_number=1)

# 启动任务调度

funboost.run()

解释:

funboost.add():将爬取任务添加到任务队列中,并传递参数。funboost.run():启动 Funboost 调度器,开始执行任务。

3. 处理并存储数据

为了更好地管理爬取的数据,我们可以将视频和图片保存到本地文件夹中:

# 下载并保存视频和图片

def save_media(media_urls, media_type="image"):

for idx, url in enumerate(media_urls):

file_extension = "mp4" if media_type == "video" else "jpg"

save_path = f"{media_type}_{idx + 1}.{file_extension}"

if media_type == "video":

download_video(url, save_path)

else:

download_image(url, save_path)

print(f"Saved {media_type} to {save_path}")

# 在爬取视频和图片后调用保存函数

video_urls = fetch_video_data(page_number=1)

save_media(video_urls, media_type="video")

image_urls = fetch_image_data(page_number=1)

save_media(image_urls, media_type="image")

解释:

save_media():根据 URL 列表下载并保存视频或图片。download_video()和download_image():将视频和图片分别保存到本地文件系统。

4. 免责声明

记住,爬虫要遵守相关网站的 robots.txt 和法律法规,避免对网站造成负担。

- 内容准确性:本博客中的所有信息和内容仅供参考之用。尽管作者尽力确保所提供的信息准确无误,但不对其准确性、完整性或适用性作出任何明示或暗示的保证。作者不对因依赖或使用本博客内容而导致的任何直接或间接损失或损害负责。

- 版权声明:本博客中的所有内容,包括文字、图片和代码,均为作者原创或引用自公开的资源。若涉及到版权问题或引用的内容不符合版权规定,请及时联系作者以做出相应的处理。未经授权,禁止以任何形式复制、转载或商业使用本博客内容。

- 个人观点: 本博客中的观点和见解仅代表作者个人的观点,并不代表 CSDN或其他机构的观点。作者在博客中分享的技术知识和经验基于个人的学习和实践,读者在应用这些信息时需自行判断和承担风险。

- 法律责任:作者不对因使用本博客中的信息而产生的任何法律责任或纠纷承担责任。读者在依赖本博客内容时应自行进行充分的验证,并遵守相关的法律法规。

- 网站链接:本博客可能包含指向其他网站的链接,这些链接仅为方便读者而提供。作者不对这些网站的内容、准确性或可靠性负责。访问这些链接时,读者需自行承担风险。

- 技术变更: 由于技术和信息更新的速度,本博客中的技术信息和建议可能会有所变化。作者不对因技术变更或信息更新造成的任何问题或损失负责。

- 联系信息: 如果您对本博客内容有任何疑问或建议,欢迎通过私信作者沟通。作者会尽力解答您的问题并做出适当的修正。

推荐阅读:《Python 爬虫入门级教程之爬取小说》,《python爬虫–爬取电商商品及对其销量进行分析》