模糊神经网络学习方法探讨

一、引言

模糊神经网络作为一种融合了模糊逻辑和神经网络优势的智能模型,在处理复杂的、具有模糊性和不确定性的系统中表现出卓越的性能。然而,其有效性在很大程度上依赖于合适的学习方法。这些学习方法不仅要考虑神经网络的参数调整,还要兼顾模糊逻辑部分的优化,以适应模糊数据和规则的处理。本文将深入探讨模糊神经网络的各种学习方法,包括其原理、实现步骤和相关的代码示例。

二、模糊神经网络基础

(一)结构回顾

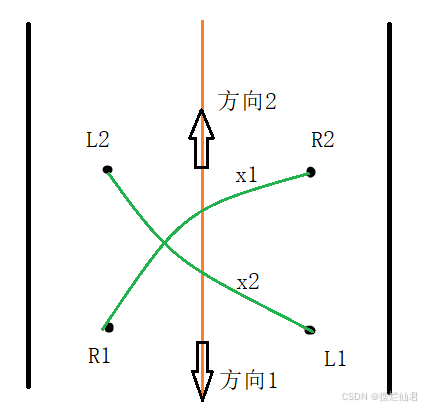

模糊神经网络一般由模糊化层、模糊规则层、解模糊化层以及神经网络的连接权重和神经元结构组成。模糊化层将清晰的输入数据转化为模糊信息,通过隶属度函数将输入值映射到不同的模糊集合。模糊规则层基于模糊逻辑规则进行推理,这些规则通常以“IF - THEN”的形式表示,例如“IF x1 is A1 AND x2 is A2 THEN y is B”,其中 x1、x2 是输入变量,A1、A2 是输入模糊集,y 是输出变量,B 是输出模糊集。解模糊化层则将模糊推理的结果转化为清晰的输出值,常用方法有重心法、最大隶属度法等。

(二)学习目标

模糊神经网络学习的主要目标是调整网络中的参数,包括模糊化层的隶属度函数参数、模糊规则的权重以及神经网络连接权重等,使得网络的输出能够准确地逼近目标输出或者满足特定的性能指标。这涉及到最小化输出误差、优化模糊规则以更好地适应数据中的模糊关系以及提高网络的泛化能力。

三、基于梯度下降的学习方法

(一)基本原理

- 误差计算

基于梯度下降的方法以误差函数为基础,常见的误差函数如均方误差(MSE)。对于给定的训练数据集{(x1, y1), (x2, y2),…, (xn, yn)},其中 xi 是输入向量,yi 是对应的目标输出,网络输出为 ŷi。均方误差定义为:

M S E = 1 n ∑ i = 1 n ( y i − y ^ i ) 2 MSE = \frac{1}{n}\sum_{i = 1}^{n}(y_{i}-\hat{y}_{i})^{2} MSE=n1∑i=1n(yi−y^i)2

- 梯度计算与参数更新

通过计算误差函数对网络中各个参数的梯度,来确定参数更新的方向。对于神经网络部分的权重 w,根据链式法则计算梯度:

∂ M S E ∂ w = ∑ i = 1 n ( y i − y ^ i ) ∂ y ^ i ∂ w \frac{\partial MSE}{\partial w}=\sum_{i = 1}^{n}(y_{i}-\hat{y}_{i})\frac{\partial \hat{y}_{i}}{\partial w} ∂w∂MSE=∑i=1n(yi−y^i)∂w∂y^i

然后按照以下公式更新权重:

w n e w = w o l d − η ∂ M S E ∂ w w_{new}=w_{old}-\eta\frac{\partial MSE}{\partial w} wnew=wold−η∂w∂MSE

其中,η是学习率。对于模糊部分,如隶属度函数的参数(假设为 a、b、c 等),同样计算误差对这些参数的梯度并更新。例如,对于三角模糊化函数:

μ ( x ) = { x − a b − a , a ≤ x ≤ b c − x c − b , b < x ≤ c 0 , otherwise \mu(x)=\begin{cases} \frac{x - a}{b - a}, & a\leq x\leq b\\ \frac{c - x}{c - b}, & b<x\leq c\\ 0, & \text{otherwise} \end{cases} μ(x)=⎩ ⎨ ⎧b−ax−a,c−bc−x,0,a≤x≤bb<x≤cotherwise

计算 ∂ M S E ∂ a \frac{\partial MSE}{\partial a} ∂a∂MSE、 ∂ M S E ∂ b \frac{\partial MSE}{\partial b} ∂b∂MSE、 ∂ M S E ∂ c \frac{\partial MSE}{\partial c} ∂c∂MSE等,并更新相应参数。

(二)代码示例(以简单的模糊神经网络为例)

import numpy as np

# 三角模糊化函数

def triangular_fuzzification(x, a, b, c):

if a <= x <= b:

return (x - a) / (b - a)

elif b < x <= c:

return (c - x) / (c - b)

return 0

# 假设一个简单的模糊神经网络,具有一个输入,一个输出,和简单的模糊规则和神经网络结构

# 网络输出函数(这里简化)

def network_output(x, membership_params, weights):

mu_x = triangular_fuzzification(x, membership_params[0], membership_params[1], membership_params[2])

return mu_x * weights[0]

# 均方误差计算

def mse(y_true, y_pred):

return np.mean((y_true - y_pred) ** 2)

# 基于梯度下降的训练函数

def train_gradient_descent(x_data, y_data, membership_params, weights, learning_rate, epochs):

for epoch in range(epochs):

y_pred = [network_output(x, membership_params, weights) for x in x_data]

error = mse(np.array(y_data), np.array(y_pred))

# 计算输出对权重的梯度(这里简单示例)

d_weights = np.sum([(y_data[i] - y_pred[i]) * triangular_fuzzification(x_data[i], membership_params[0], membership_params[1], membership_params[2]) for i in range(len(x_data))])

weights = weights + learning_rate * d_weights

# 计算误差对隶属度函数参数的梯度(这里仅示意对a的计算,b和c类似)

d_a = np.sum([(y_data[i] - y_pred[i]) * (-1 / (membership_params[1] - membership_params[0])) * weights[0] for i in range(len(x_data))])

membership_params[0] = membership_params[0] + learning_rate * d_a

# 类似地更新b和c

print(f'Epoch {epoch}: Error = {error}')

return membership_params, weights

四、混合学习算法

(一)以 ANFIS(自适应神经模糊推理系统)为例

- 原理

ANFIS 是一种典型的模糊神经网络,其混合学习算法结合了最小二乘法和梯度下降法。在训练的前向过程中,首先通过输入数据计算各层的输出,包括模糊化后的隶属度值、模糊规则的激发强度等。在反向传播过程中,分为两个阶段。- 第一阶段:使用梯度下降法更新前提参数(如隶属度函数的参数)。这是因为这些参数对模糊化和模糊规则的形成有直接影响,通过梯度下降可以逐步调整它们以减小误差。

- 第二阶段:固定前提参数,使用最小二乘法计算结论参数(例如在 Sugeno 型模糊规则中,结论部分的系数)。最小二乘法可以有效地找到使输出与目标输出之间误差平方和最小的参数值。

- 代码示例(简化的 ANFIS 训练代码)

import numpy as np

# 假设输入数据和目标输出(这里简单示例)

input_data = np.array([[1, 2], [3, 4], [5, 6]])

target_output = np.array([3, 7, 11])

# 模糊集参数初始化(这里简单示例)

membership_params = {

'input1': {'low': [0, 2], 'high': [3, 5]},

'input2': {'low': [1, 3], 'high': [4, 6]}

}

# 梯度下降更新参数函数(简化)

def update_parameters_gradient_descent(input_data, target_output, membership_params, learning_rate):

for i in range(len(input_data)):

x1, x2 = input_data[i]

t = target_output[i]

# 模糊化输入

mu_x1_low = triangular_fuzzification(x1, membership_params['input1']['low'][0], membership_params['input1']['low'][1])

mu_x1_high = triangular_fuzzification(x1, membership_params['input1']['high'][0], membership_params['input1']['high'][1])

mu_x2_low = triangular_fuzzification(x2, membership_params['input2']['low'][0], membership_params['input2']['low'][1])

mu_x2_high = triangular_fuzzification(x2, membership_params['input2']['high'][0], membership_params['input2']['high'][1])

# 计算规则激发强度(这里仅两条规则示例)

alpha1 = min(mu_x1_low, mu_x2_low)

alpha2 = min(mu_x1_high, mu_x2_high)

# 计算输出(简单示例,类似 Sugeno 模型)

y = (alpha1 * 1 + alpha2 * 2) / (alpha1 + alpha2)

# 计算误差

error = t - y

# 这里仅简单示意更新参数,实际更复杂

if mu_x1_low > 0:

membership_params['input1']['low'][0] += learning_rate * error * (x1 - membership_params['input1']['low'][0]) / (membership_params['input1']['low'][1] - membership_params['input1']['low'][0])

membership_params['input1']['low'][1] += learning_rate * error * (membership_params['input1']['low'][1] - x1) / (membership_params['input1']['low'][1] - membership_params['input1']['low'][0])

# 类似地更新其他参数

return membership_params

# 使用最小二乘法更新结论参数(这里简化示例)

def update_conclusion_parameters_least_squares(input_data, target_output, membership_params):

# 构建矩阵和向量用于最小二乘法(这里简化过程)

A = []

b = []

for i in range(len(input_data)):

x1, x2 = input_data[i]

mu_x1_low = triangular_fuzzification(x1, membership_params['input1']['low'][0], membership_params['input1']['low'][1])

mu_x1_high = triangular_fuzzification(x1, membership_params['input1']['high'][0], membership_params['input1']['high'][1])

mu_x2_low = triangular_fuzzification(x2, membership_params['input2']['low'][0], membership_params['input2']['low'][1])

mu_x2_high = triangular_fuzzification(x2, membership_params['input2']['high'][0], membership_params['input2']['high'][1])

alpha1 = min(mu_x1_low, mu_x2_low)

alpha2 = min(mu_x1_high, mu_x2_high)

A.append([alpha1, alpha2])

b.append(target_output[i])

A = np.array(A)

b = np.array(b)

# 使用最小二乘法求解(这里使用 np.linalg.lstsq)

conclusion_params, _, _, _ = np.linalg.lstsq(A, b, rcond=None)

return conclusion_params

# 完整的 ANFIS 训练过程(简化)

def train_ANFIS(input_data, target_output, membership_params, learning_rate, epochs):

for epoch in range(epochs):

membership_params = update_parameters_gradient_descent(input_data, target_output, membership_params, learning_rate)

conclusion_params = update_conclusion_parameters_least_squares(input_data, target_output, membership_params)

print(f'Epoch {epoch} completed')

return membership_params, conclusion_params

五、聚类方法辅助学习

(一)聚类用于模糊规则生成和初始化

- 原理

聚类算法可以用于分析输入输出数据的分布,从而帮助确定模糊规则和模糊集。例如,模糊 C - 均值聚类算法可以将输入数据划分为不同的簇,每个簇可以对应一条模糊规则或一个模糊集。通过这种方式,可以自动地从数据中提取模糊信息,减少对专家知识的依赖。在初始化阶段,根据聚类结果设置隶属度函数的参数和模糊规则的初始权重。 - 代码示例(使用模糊 C - 均值聚类初始化模糊神经网络)

import numpy as np

from scipy.cluster.vq import kmeans2

# 假设输入数据(这里简单示例)

input_data = np.array([[1, 2], [1.2, 2.3], [3, 4], [3.2, 4.1], [5, 6], [5.3, 6.2]])

# 使用模糊 C - 均值聚类(这里使用 kmeans2 近似实现)

centroids, labels = kmeans2(input_data, 3)

# 根据聚类结果初始化模糊集参数(这里简单示例,假设三角模糊化)

membership_params = []

for i in range(len(centroids)):

cluster_data = input_data[labels == i]

min_values = np.min(cluster_data, axis=0)

max_values = np.max(cluster_data, axis=0)

center = centroids[i]

membership_params.append([min_values[0], center[0], max_values[0], min_values[1], center[1], max_values[1]])

# 初始化模糊规则权重(这里简单设为相等)

rule_weights = np.ones(len(membership_params)) / len(membership_params)

print("Membership parameters:", membership_params)

print("Rule weights:", rule_weights)

六、进化算法在模糊神经网络学习中的应用

(一)遗传算法

- 原理

遗传算法将模糊神经网络的参数编码为染色体,通过选择、交叉和变异等遗传操作来搜索最优的参数组合。首先,随机生成初始种群,每个个体代表一组网络参数。然后,根据适应度函数(如网络输出与目标输出的误差)评估每个个体的优劣。选择操作根据适应度选择优秀的个体进行繁殖,交叉操作交换两个个体的部分基因,变异操作则对个体的某些基因进行随机改变。通过多代的进化,种群逐渐向最优参数靠近。 - 代码示例(简单遗传算法用于模糊神经网络参数优化)

import numpy as np

import random

# 假设模糊神经网络参数(这里简化,包括隶属度函数参数和权重)

parameter_size = 10

population_size = 20

# 生成初始种群(随机参数值)

population = np.random.rand(population_size, parameter_size)

# 适应度函数(这里简单使用均方误差)

def fitness_function(parameters, x_data, y_data):

# 这里假设根据参数构建模糊神经网络并计算输出,然后返回误差

return mse(y_data, [network_output(x, parameters[:3], parameters[3:]) for x in x_data])

# 选择操作(简单的轮盘赌选择)

def selection(population, x_data, y_data):

fitness_scores = [1 / fitness_function(ind, x_data, y_data) for ind in population]

total_fitness = sum(fitness_scores)

probabilities = [score / total_fitness for score in fitness_scores]

selected_indices = np.random.choice(len(population), size=len(population), p=probabilities)

return population[selected_indices]

# 交叉操作(单点交叉)

def crossover(parent1, parent2):

crossover_point = random.randint(1, len(parent1) - 1)

child1 = np.concatenate((parent1[:crossover_point], parent2[crossover_point:]))

child2 = np.concatenate((parent2[:crossover_point], parent1[crossover_point:]))

return child1, child2

# 变异操作(简单的随机变异)

def mutation(individual, mutation_rate):

for i in range(len(individual)):

if random.random() < mutation_rate:

individual[i] = np.random.rand()

return individual

# 遗传算法训练过程(简化)

def train_genetic_algorithm(x_data, y_data, generations, mutation_rate):

for generation in range(generations):

population = selection(population, x_data, y_data)

new_population = []

for i in range(0, population_size, 2):

parent1 = population[i]

parent2 = population[i + 1]

child1, child2 = crossover(parent1, parent2)

child1 = mutation(child1, mutation_rate)

child2 = mutation(child2, mutation_rate)

new_population.extend([child1, child2])

population = np.array(new_population)

print(f'Generation {generation}: Best fitness = {1 / max([fitness_function(ind, x_data, y_data) for ind in population])}')

return population[np.argmin([fitness_function(ind, x_data, y_data) for ind in population])]

七、不同学习方法的比较与应用选择

(一)学习效率

基于梯度下降的方法在参数更新上相对简单直接,但对于复杂的模糊神经网络结构和大规模数据,可能收敛速度较慢且容易陷入局部最优解。混合学习算法(如 ANFIS 的方法)结合了不同方法的优势,在一定程度上可以提高学习效率,特别是在处理具有明确模糊规则结构的问题时。聚类方法在初始化阶段可以快速地从数据中提取模糊信息,但后续可能需要与其他学习方法结合进一步优化参数。进化算法在全局搜索能力上有优势,但计算复杂度较高,尤其是对于大规模的参数空间。

(二)对模糊信息的处理能力

梯度下降方法可以通过调整隶属度函数参数来处理模糊信息,但对于模糊规则的生成和调整可能不够灵活。混合学习算法在模糊规则的处理上更为灵活,能够同时优化前提和结论部分的参数。聚类方法直接从数据中挖掘模糊规则和模糊集,对数据中的模糊结构有较好的适应性。进化算法可以在较广的参数空间中搜索适合模糊信息处理的参数组合,但可能需要更多的计算资源来保证对模糊信息的准确处理。

(三)应用场景选择

对于需要快速收敛且问题结构相对简单、模糊规则相对明确的应用场景,混合学习算法(如 ANFIS)可能是较好的选择。当对初始模糊规则和模糊集没有先验知识时,聚类方法可以作为一种有效的初始化手段。对于复杂的、具有多个局部最优解

![[JAVA]MyBatis框架—如何获取SqlSession对象实现数据交互(基础篇)](https://i-blog.csdnimg.cn/direct/f7e079c1c18b4f75b59cf4c31002c1e5.png)

![[2024最新] java八股文实用版(附带原理)---java集合篇](https://i-blog.csdnimg.cn/direct/d5f8f45922f1435eb8a6281bfa865672.png)