基本信息

原文链接:[2202.11132] Bag Graph: Multiple Instance Learning using Bayesian Graph Neural Networks

方法概括:用图(贝叶斯GNN框架)来建模袋之间的相互作用,并使用图神经网络(gnn)来促进端到端学习。

具体方法

将基于深度学习的MIL模型应用于每个包中的实例以生成集合表示。然后使用贝叶斯图神经网络将这些表示聚合起来,为每个袋子提供最终的标签。

1.MIL结构

MIL框架由两个模块组成。(1)对包中的实例进行特征提取 (2)池化层:对包中的实例进行聚合,得到包的特征

包表示为使用GNN进行聚合,其目的是利用图结构指定的关系。

2.贝叶斯图网络

在许多基于图的学习问题中,观察到的图是由有噪声的数据构建的,或者是基于启发式和/或不完善的建模假设得出的。因此,观察到的图可能不能代表其节点上数据之间真正的潜在关系。

在贝叶斯图网络中,我们的输入是节点的特征(也就是包的特征),我们的预期是使得预测未知数据集得到的后验分布接近已知数据集的分布。

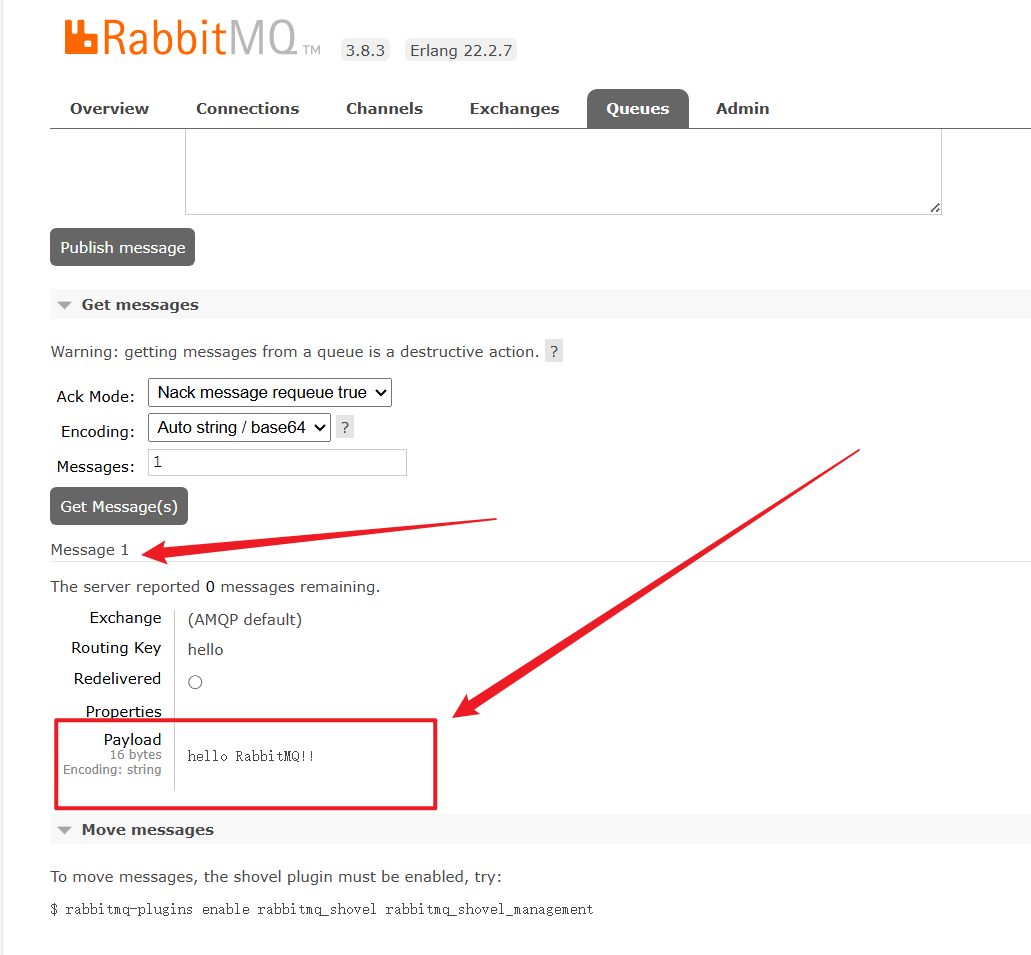

算法流程如下:

(1)输入:包特征,标签,观察到的图 输出:后验概率

(2)训练一个基础模型,来学习z(包级表示矩阵)的表示,并计算距离矩阵D

![]()

(3)

使用MAP优化图

其中A_s是指对称邻接矩阵,超参数α和β控制的尺度和稀疏度

(4)假设p(W)为W的高斯先验分布,用一个合适的损失函数去训练与GNN结合起来的MIL模型,去得到最佳的模型参数和W

(5)模型参数不变,计算提取的包的特征Z_v

(6)对GNN模型权重采用MC dropout去采样 得到W_s

(7)计算

实验

1.数据集

5个MIL基准数据集、20个newsgroups语料库中的文本数据集和2016年美国大选数据进行了分类实验

2.设置

- 考虑使用池(rFF+pool) (Zaheer et al 2017)作为基础模型的逐行前馈架构。我们为这个架构配备了深度监督(Wang et al . 2018)。

- 10倍交叉验证。

- 一旦体系结构和其他超参数(如学习率、训练epoch数和权值衰减)固定,只用GCN层替换基本模型的最后一个线性层,形成GCN变体。提出的贝叶斯方法使用相同的体系结构。该方法确保GCN和BGCN变体具有与基本模型相同的可学习参数数量、相同的超参数和相似的训练复杂度。

- GCN和BGCN变体之间的唯一区别是GCN使用观察到的图,而贝叶斯方法从数据中估计到的图。

- 用启发式方法来创建观察到的图。使用一个简单的k近邻方法,基于从基本模型获得的嵌入之间的欧几里得距离。在相邻嵌入的节点之间添加边,每个节点向其最近的k个邻居添加一条边。

3.Baselines

实例空间方法:mi-SVM and MI-SVM (Andrews,Tsochantaridis, and Hofmann 2002), EM-DD (Zhang andGoldman 2001), MI-VLAD and mi-FV (Wei, Wu, and Zhou2017).

包空间方法:mi- kernel (Gartner et al . 2002), mi- Graph (Zhou, Sun, and Li, 2009)。

嵌入空间方法(这些方法使用神经网络和注意力来学习袋子的嵌入):mi-Net和mi-Net (Wang et al . 2018),注意力神经网络和门控注意力神经网络(Ilse, Tomczak, and Welling 2018)

3.实验结果