1.归一化流与扩散模型

自一化流(Normalizing Flow)是生成模型,通过将易于处理的分布进行变换以队对高维数据进行建模。归一化流可以将简单的概率分布转化为极其复杂的分布,并用于强化学习、变分推理等领域。

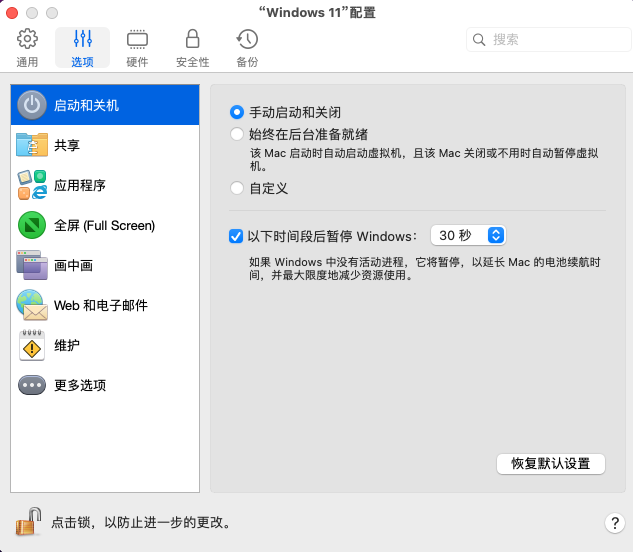

现有的归一化流是基于变量替换公式构建的,其中连续时间归一化流的轨迹由微分方程公式化。具体来说,连续归一化流通过如下微分方程对原始数据进行变换:

![]()

与连续时间类似,归一化流允许通过变量替换公式计算对数似然,然而,双射的要求限制了在实际应用中或理论研究中的对复杂数据的建模。有几项工作试图放宽这种双射要求。例如,DifFlow引入了一种生成建模算法,基于归一化流的想法,DifFlow 使用了归一化流来直接学习扩散模型中的原本需要人工设置的漂移系数。这使它拥有了归一化流和扩散模型的优点。因此相比归一化流,DiFlow产生的分布边界更清晰,并且可以学习更一般的分布,而与扩散模型相比,其离散化步骤更少所以采样速度更快。另一项工作,隐式非线性扩散模型(Implicit Nonlinear Diffusion Model,INDM)采用了类似LSGM 的设计,先使用归一化流将原始数据映射到潜在空间中,然后在空间中进行扩散。利用伊藤公式,可以证明INDM实际上是使用了由归一化流学习的非线性SDE来对数据进行扰动和恢复的。进一步分析,INDM的ELBO可转化为归一化流的损失与分解分数匹配的求和,使模型被高校训练。实验结果表明INDM可以提高采样速度,并且提高模型的似然值。

2.自回归模型与扩散模型

自回归模型(Autoregressive Model,ARM)通过将数据的联合分布分解为条件的乘积来对数据进行建模。使用概率链式法则,随机向量x1:t的对数似然可以写为:

其中x<t是x1:t的缩写,深度学习的最新进展促进了各种数据模式,例如,图像、音频和文本。自回归模型(ARM) 通过使用单个神经网络提供生成能力。采样这些模型需要与数据维度相同数量的网络调用虽然ARM。虽然ARM是有效密度估计器,但抽样是一个连续的、耗时的过程(尤其对于高维数据更是如此)。另一方面,自回归扩散模型(ARDM)能够生成任意顺序的数据,包括与顺序无关的自回归模型和离散扩散模型。与传统ARDM 表征上使用因果掩码的方法不同,ARDM使用了一个有效的训练目标来使其适用于高维数据,其灵感来自扩散概率模型(DPM)。此外,ARDM的生成过程与具有吸收态的离散扩散模型是相似的。在测试阶段,扩散模型与ARDM能够并行生成数据,使其可以应用于一系列的生成任务。

3.基于能量的模型与扩散模型

基于能量的模型(Energy-Based Model,EBM)可以被视作一种生成式的判别器,其可以从未标记的输入数据中学习。让x~pdata(x)表示一个训练样例,p(x)表示一个概率密度函数,旨在逼近Pdata(x)。基于能量的模型定义为:

其中z=

exp(f

(x))dx是归一化系数,对于高维度数据是难以解析计算的。对于图象数据,

f(x)。Salimans等人通过较约束分数模型和基于能量的模型对数据分布的分数进行建模,最终发现了约束分模型即基于能量的模型。当二者使用了可比较的模型结构时,在使用基于能量的橡(EBM)时可以和无约束模型得到一样好的表现。

尽管EBM具有许多理想的特性,但在高维数据建模方面仍然存在两个挑战。首先,对于最大化似然学习得到的EBM,通常需要使用MCMC方法来从模型中生成样本。这使得计算成本可能非常高。其次,以往经验表明,通过非收敛的MCMC方学习到的能量势能不稳定,来自长期马尔可夫链的样本与观察到的样本有显著不同。在一项研究中,Gao等人提出了一种扩散恢复似然法,即在扩散模型逆过程中使用一系列条件 EBM学习样本分布。在这一系列条件EBM中,每一个条件EBM 都接受上一个条件EBM 产生的噪声强度较高的样本,并对接受的样本进行去噪,以产生声强度较低的样本。条件EBM p(x|x~)是通过恢复似然训练的,即在给定高噪声样本后,使用低噪声数据x的条件似然值作为目标函数,其目的是在给定更高噪声的噪声数据的情况下,最大化特定低噪声水平下数据的条件概率。条件EBM可以较好地最大化恢复似然,这是因为原数据的分布可能是多模态的,而在给定加噪样本后,原数据的条件概率会比原数据的边际似更容易处理。例如,从条件分布抽样比从边际分布中抽样容易得多。当每次加入的噪声强度足够小时,条件EBM的条件似然函数将接近高斯分布。这意味着扩散恢复似然中逐个条件 EMB的采样近似于扩散模型逆过程中逐次对样本去噪。同时 Gao 等人还证明了,当每次加入的噪声强度足够小时,扩散恢复似然的最大似然训练与 ScoreSDE的分数匹配训练是近似的,并进一步建立了基于能量的模型与扩散模型的关系。扩散恢复似然可以生成高质量的样本,并且来自长期MCMC方法的样本仍然类似于真实图像。