Neurips 23

推荐指数: #paper/⭐⭐⭐

领域:图异常检测

胡言乱语:

neurips 的benchmark模块的文章总能给人一些启发性的理解,这篇的insight真有意思。个人感兴趣的地方会加粗。此外,这篇文章和腾讯AIlab合作,有腾讯背书

文章的背景

缺陷

- 缺乏有监督GAD benchmark

-

- 缺乏树集成与GNN之间的比较研究

-

- 缺乏对大数据集的探索

-

发现

-

- 有邻居聚合的数集成比大部分模型的性能都好

-

- 大部分的标准数据集都不适合GAD task

-

- 针对GAD进行针对性设计的GNN需要超参微调才能取得满意的性能

-

我们的贡献

-

- 提出了GADBench

10.2. 使用公平和严格的比较方法

- 提出了GADBench

相关工作

GAD的简介

GAD其实可以视为二分类问题。但是,仍然有下列的挑战:

- 异常节点通常是整个数据集的一小部分,这会导致数据的不平衡问题。

-

- 异常节点通常展现强异配性,这就需要对于传播函数的改造

-

- 异常节点倾向于掩盖其特征和链接,通过模仿图中的正常模式来无缝混合

-

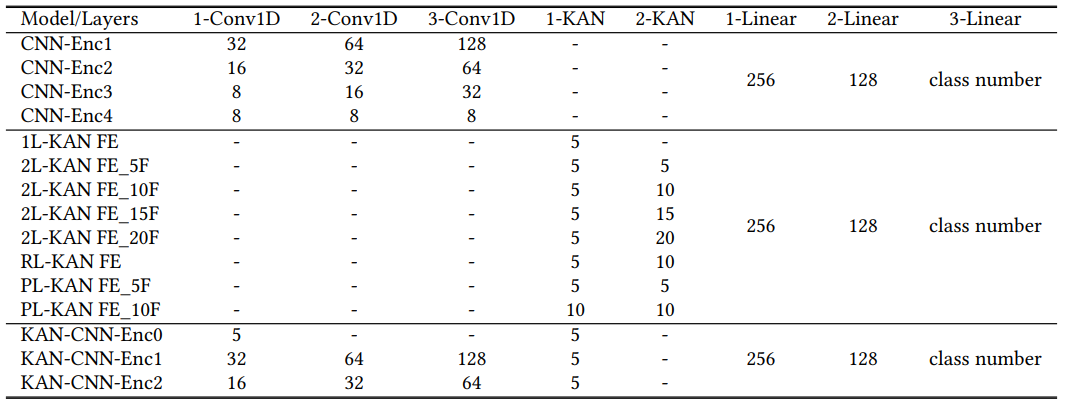

本文涉及的方法:

- 标准GNN即常见的GNN,

-

specializedGNN

- specialized GNN通常需要专门的设计。

- 重点提及一下光谱GNN,光谱GNN提供了一个新的观点,将图形异常与高频频谱分布联系起来例如,BWGNN 应用Beta内核通过灵活且局部化的带通过滤器来管理较高频率的异常。AMNet 捕获低频和高频信号,自适应地积分不同频率的信号。

10.### 有邻居集合的树集成

h v i ( l ) = Aggregate { h v j ( l − 1 ) ∣ v i ∈ Neighbor ( v j ) } Score ( v i ) = TreeEnsemble ( [ h v i 0 ∣ ∣ h v i 1 ∣ ∣ ⋯ ∣ ∣ h v i L ] ) . \begin{aligned} \boldsymbol{h}_{v_i}^{(l)}& =\text{Aggregate}\{\boldsymbol{h}_{v_j}^{(l-1)}|v_i\in\text{Neighbor}(v_j)\} \\ \operatorname{Score}(v_i)& =\text{TreeEnsemble}([\boldsymbol{h}_{v_i}^0||\boldsymbol{h}_{v_i}^1||\cdots||\boldsymbol{h}_{v_i}^L]). \end{aligned} hvi(l)Score(vi)=Aggregate{hvj(l−1)∣vi∈Neighbor(vj)}=TreeEnsemble([hvi0∣∣hvi1∣∣⋯∣∣hviL]).

AGGRATE可以是任何聚合函数,比如mean,max,polling。

在GADBench中,我们利用Random Forest和XGboost实例化两个具有邻居聚合的新树集成基线,称为RF-Shape和XGB-Shape。

数据集介绍

分割

全监督场景,我们一般使用4/2/4的划分,具体的划分见数据集介绍。对于半监督场景,在先前的研究中,经常采取1%或者5%,然而,因为图数目的变化,固定碧梨的训练模型可能导致训练集规模的据他差异。因此我们队所有的训练集进行标准化:一共100个标签,20异常标签,80正常节点。

Insight

带有邻居聚合的树聚集成有着超强的性能

大部分标准GNN都不适合GAD

但是,有一个例外:GraphSage展现了优越的性能,甚至有时可以和专门设计的GNN比较。个人认为,GraphSAGE可以捕获自己和邻居的不同(GraphSAGE在聚合中将自身节点和邻居节点拼接在一起,这就意味着可以收货自己与周围节点的异同信息,这是其他标准GNN所不具备得

专门设计的GNN需要复杂的调参才可以取得满意的性能

异构图的增强可能只在部分数据集上起作用

如图所示,异构图只在Yelp上有增强效果,在Amazon上比不过同配图

聚合层数对于数集成的影响

为什么决策树的性能会更好?

异常实例往往会形成多个分散的集群,并与正常实例相结合,这些实例属于RF-Shape和XGB-Shape的感性偏差类别,有利于复杂且不相交的决策边界。相比之下,由于GNN通常使用MLP作为最终层,因此它们往往会生成简单且连续的决策边界,这使得GNN在一些具有挑战性的GAD数据集上表现不佳。其实就是insights:用简单的MLP不行,得设计的更复杂。但是,异常检测脱胎与图神经网络,其比较本质上就是比较嵌入的良好程度,个人觉得GNN后接更复杂的分类损失,也可以取得像树集成类似的效果

分析数据集的影响

如数据集简介所示,所示,在GADB的10个数据集中,有3个数据集纯粹使用文本嵌入作为节点特征,而在其余7个数据集中,节点特征包含各种信息,例如数字、分类和时间特征的组合。值得注意的是,对于依赖于基于文本的特征的数据集–即Reddit、weibo和Question–GNN展示了与包括树集成在内的其他方法相比具有竞争力的性能。这可以归因于文本嵌入的性质:它们通常表示高维特征空间中的低维流形,其中维度往往高度相关。GNN可以同时处理所有这些维度,而单个决策树可能只考虑功能列的有限子集。相反,在其他7个具有低相关性的不同特征类型(例如,性别和年龄信息)的数据集中,具有邻居聚集的树集成通常表现出更好的性能。