计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-10-09

目录

文章目录

- 计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-10-09

- 目录

- 1. Can LLMs plan paths with extra hints from solvers?

- 摘要

- 创新点

- 算法模型

- 实验效果

- 重要数据与结论

- 推荐阅读指数

- 2. Scalable and Accurate Graph Reasoning with LLM-based Multi-Agents

- 摘要

- 创新点

- 算法模型

- 实验效果

- 重要数据与结论

- 推荐阅读指数

- 3. Navigating the Digital World as Humans Do: Universal Visual Grounding for GUI Agents

- 摘要

- 创新点

- 算法模型

- 实验效果

- 重要数据与结论

- 推荐阅读指数

- 4. Performance Evaluation of Tokenizers in Large Language Models for the Assamese Language

- 摘要

- 创新点

- 算法模型

- 实验效果

- 重要数据与结论

- 推荐阅读指数

- 5. Realtime, multimodal invasive ventilation risk monitoring using language models and BoXHED

- 摘要

- 创新点

- 算法模型

- 实验效果

- 重要数据与结论

- 推荐阅读指数

- 后记

1. Can LLMs plan paths with extra hints from solvers?

Authors: Erik Wu and Sayan Mitra

https://arxiv.org/abs/2410.05045

大型语言模型(LLMs)能否借助求解器的额外提示规划路径?

摘要

本文探索了通过集成求解器生成的反馈来增强大型语言模型(LLMs)在解决经典机器人规划任务中的表现的方法。研究了四种不同的反馈策略,包括视觉反馈,并利用微调技术,评估了三种不同的LLMs在10个标准和100个随机生成的规划问题上的表现。结果表明,求解器生成的反馈提高了LLMs解决中等难度问题的能力,但更难的问题仍然难以解决。研究详细分析了不同提示策略的效果以及评估的LLMs的不同规划倾向。

创新点

- 集成求解器反馈:将求解器生成的反馈集成到LLMs中,以增强其解决规划问题的能力。

- 多种反馈策略:探索了包括视觉反馈在内的四种不同的反馈策略。

- 微调技术:使用微调技术来提升LLMs在路径规划任务上的表现。

- 开源软件框架:提供了一个开源的软件框架,用于评估LLMs,该框架可以连接不同的LLM APIs,并使用SMT求解器生成闭环提示。

算法模型

- LLMs:使用了三种不同的大型语言模型,包括GPT-4o、Gemini Pro 1.5和Claude 3.5 Sonnet。

- 反馈策略:包括碰撞提示、自由空间提示、正确前缀提示和图像提示。

- 微调:对LLMs进行微调以提高其在路径规划任务上的表现。

实验效果

- 碰撞提示:仅使用碰撞提示,LLMs能够一致地解决中等难度的问题。

- 组合提示:结合碰撞提示、自由空间提示和正确前缀提示,LLMs在大多数手工制作的问题上表现更好,但在螺旋问题上表现下降。

- 图像提示:图像提示并没有提高LLMs的路径规划性能。

- 微调效果:微调显著提高了GPT-4o在路径规划任务上的成功率和解决方案的最优性。

重要数据与结论

- 成功案例:在涉及1、2和3个障碍的问题上,Claude 3.5 Sonnet的成功率稳定在90%。

- 困难案例:在需要25段路径和回溯的最困难问题上,即使在最大提示信息的帮助下,LLMs也几乎从未找到解决方案。

- 微调改进:GPT4o在“盒子”问题上的成功率从50%提高到100%,在“对角墙”问题上从0%提高到30%。

推荐阅读指数

★★★★☆

推荐理由:这篇文章提供了对大型语言模型在复杂规划任务中应用的深入分析,特别是在集成求解器反馈和微调方面的创新方法

2. Scalable and Accurate Graph Reasoning with LLM-based Multi-Agents

Authors: Yuwei Hu, Runlin Lei, Xinyi Huang, Zhewei Wei, Yongchao Liu

https://arxiv.org/abs/2410.05130

可扩展且准确的图形推理:基于LLM的多智能体

摘要

近期研究探索了使用大型语言模型(LLMs)来处理复杂的图形推理任务。然而,由于图形结构的复杂性以及LLMs在处理长文本时的固有限制,目前的方法在小规模图形和简单任务上也常常无法达到满意的准确性。为了应对这些挑战,我们介绍了一个无需微调的框架——GraphAgent-Reasoner,它利用多智能体协作策略进行明确和精确的图形推理。受分布式图形计算理论的启发,我们的框架将图形问题分解成更小的、以节点为中心的任务,这些任务在多个智能体之间分配。智能体协作解决整体问题,显著减少了单个LLM处理的信息量和复杂性,从而提高了图形推理的准确性。通过简单地增加智能体的数量,GraphAgent-Reasoner可以有效地扩展到包含1000多个节点的更大图形。在GraphInstruct数据集上评估时,我们的框架在多项式时间内的图形推理任务上展示了接近完美的准确性,显著优于现有的最佳模型,包括闭源和微调后的开源变体。我们的框架还展示了处理例如网页重要性分析等实际图形推理应用的能力。

创新点

- 多智能体协作策略:提出了一种新型的多智能体框架,无需微调,可以处理更复杂和大规模的图形推理任务。

- 分布式计算理论:将图形问题分解成更小的、以节点为中心的任务,通过多智能体分布式处理。

- 显著的准确性提升:在标准数据集上展示出接近完美的准确性。

- 可扩展性:框架能够通过增加智能体数量来处理更大规模的图形。

算法模型

- GraphAgent-Reasoner (GAR):基于多智能体协作的框架,由一个主LLM和多个代理智能体组成,每个节点分配一个智能体。

- 分布式算法执行:智能体独立维护状态和邻居数据,并根据主LLM的指令与相邻智能体通信。

- 算法建立:提出了一个统一的分布式解决方案框架,包括状态、消息、初始化、发送、更新和终止等核心组件。

实验效果

- GraphInstruct数据集:在多项式时间内的图形推理任务上,GAR表现出接近完美的准确性,显著优于其他模型。

- 大规模图形:GAR在包含1000个节点的图形上维持高准确性,展现了卓越的可扩展性。

- 真实世界应用:在网页重要性分析的案例研究中,GAR正确地应用了PageRank算法来识别最重要的节点。

重要数据与结论

- 实验1:GAR在GraphInstruct数据集上的表现几乎完美,特别是在处理时间复杂度较高的任务时,大大提升了性能。

- 实验2:GAR在大规模图形上的表现稳定,即使在节点数量增加时,也能保持高性能。

- 实验3:在真实世界的图形推理场景中,GAR能够正确识别和应用相关的图形算法来解决问题。

推荐阅读指数

★★★★☆

推荐理由:这篇文章提出了一种新颖的多智能体框架,用于处理复杂的图形推理任务,具有显著的准确性和可扩展性。对于从事人工智能、自然语言处理和图形计算的研究者来说,值得一读。

3. Navigating the Digital World as Humans Do: Universal Visual Grounding for GUI Agents

Authors: Boyu Gou, Ruohan Wang, Boyuan Zheng, Yanan Xie, Cheng Chang, Yiheng Shu, Huan Sun, Yu Su

https://arxiv.org/abs/2410.05243

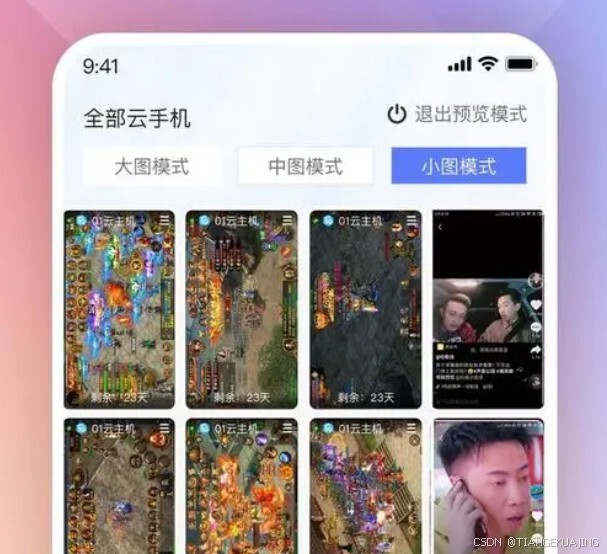

像人类一样导航数字世界:用于GUI代理的通用视觉定位

摘要

多模态大型语言模型(MLLMs)正在转变图形用户界面(GUI)代理的能力,促进它们从受控模拟转变为跨不同平台的复杂真实世界应用。然而,这些代理的有效性取决于它们定位能力的稳健性。当前的GUI代理主要使用基于文本的表示,如HTML或可访问性树,尽管它们很有用,但通常会引入噪声、不完整性,并增加计算开销。在本文中,我们提倡GUI代理应像人类一样,完全通过视觉感知环境,并直接在GUI上进行像素级操作。关键在于视觉定位模型,它能准确将GUI元素的多样化指代表达式映射到GUI上的坐标。我们展示了一个简单的方法,包括基于网络的合成数据和对LLaVA架构的轻微调整,这对于训练这样的视觉定位模型出奇地有效。我们收集了迄今为止最大的GUI视觉定位数据集,包含1.3M屏幕截图上的10M GUI元素及其指代表达式,并使用它来训练UGround,一个强大的通用视觉定位模型,用于GUI代理。在六个基准测试(涵盖定位、离线代理和在线代理三个类别)上的实证结果表明,1) UGround在GUI代理的视觉定位模型方面大幅度超越现有模型,绝对提升高达20%;2) 配备UGround的代理超越了现有的最先进代理,尽管现有代理使用了额外的基于文本的输入,而我们的代理仅使用视觉感知。这些结果为像人类一样导航数字世界的GUI代理的可行性和前景提供了有力支持。

创新点

- 提出GUI代理的人类化体现:完全通过视觉感知环境并直接在GUI上进行像素级操作。

- 无需微调的框架:提出了一个通用框架SeeAct-V,用于构建此类代理。

- 大规模合成数据集:收集了迄今为止最大的GUI视觉定位数据集。

- 强大的视觉定位模型UGround:在多个基准测试中显示出卓越的性能。

算法模型

- SeeAct-V框架:一个两阶段的框架,包括规划和视觉定位,不依赖HTML或可访问性树。

- UGround模型:基于LLaVA架构调整,用于GUI视觉定位。

- 数据合成策略:利用网页数据合成了高质量的训练数据集。

实验效果

- ScreenSpot基准测试:UGround在标准设置和代理设置下均优于现有模型。

- 离线代理评估:在Multimodal-Mind2Web、AndroidControl和OmniACT基准测试中,SeeAct-V框架的表现超越了使用额外文本输入的现有最先进方法。

- 在线代理评估:在Mind2Web-Live和AndroidWorld基准测试中,UGround同样展现出色的表现。

重要数据与结论

- ScreenSpot:UGround在定位准确性上平均提高了20%。

- Multimodal-Mind2Web:SeeAct-V在元素准确性上达到了44.8%,优于现有方法。

- AndroidControl:在步准确率方面,SeeAct-V达到了46.2%,优于现有方法。

- OmniACT:在动作分数方面,SeeAct-V达到了31.1,优于现有方法。

推荐阅读指数

★★★★☆

推荐理由:这篇文章提出了一种新的GUI代理框架和视觉定位模型,能够在没有额外文本输入的情况下,通过视觉感知来执行复杂的GUI任务。

4. Performance Evaluation of Tokenizers in Large Language Models for the Assamese Language

Authors: Sagar Tamang and Dibya Jyoti Bora

https://arxiv.org/abs/2410.03718

针对印度阿萨姆语的大型语言模型中分词器的性能评估

摘要

分词器的训练对于深度学习模型的性能至关重要。本研究旨在了解在印度阿萨姆语中,五种最新(SOTA)大型语言模型(LLMs)的分词器性能。这项研究对于理解低资源语言(如阿萨姆语)的多语言支持非常重要。研究结果显示,Two AI的SUTRA分词器表现最佳,平均归一化序列长度(NSL)值为0.45,其次是Open AI的GPT-4o分词器,平均NSL值为0.54,然后是Gemma 2、Meta Llama 3.1和Mistral Large Instruct 2407,平均NSL值分别为0.82、1.4和1.48。

创新点

- 针对低资源语言的分词器性能评估:专注于印度阿萨姆语这一低资源语言,填补了该领域的研究空白。

- 多模型比较:对比了五种不同的SOTA大型语言模型的分词器性能。

- 建立评估标准:采用词汇量、平均归一化序列长度(NSL)和分词数量作为评估分词器性能的标准。

算法模型

- WordPiece和Byte Pair Encoding (BPE):典型的基于Transformer的LLMs采用的分词方法。

- SUTRA:由Two AI开发的多语言大型语言模型架构,有效分离了核心概念理解与语言特定处理。

- GPT-4o:由Open AI开发的大型语言模型。

- Gemma 2:谷歌开发的语言模型。

- Meta Llama 3.1:Meta开发的大型语言模型。

- Mistral Large Instruct 2407:Mistral AI开发的大型语言模型。

实验效果

- SUTRA分词器:平均NSL值为0.45,生成16个token。

- GPT-4o分词器:平均NSL值为0.54,生成19个token。

- Gemma 2分词器:平均NSL值为0.82,生成29个token。

- Meta Llama 3.1分词器:平均NSL值为1.4,生成49个token。

- Mistral Large Instruct 2407分词器:平均NSL值为1.48,生成52个token。

重要数据与结论

- 最佳表现:SUTRA分词器在阿萨姆语上表现最佳,这表明其多语言处理能力在该语言上表现良好。

- 性能差异:Mistral Large Instruct 2407分词器表现最差,可能由于其词汇量限制导致。

- 分词器特性:GPT-4o和Llama 3.1分词器可能使用Unicode处理孟加拉语-阿萨姆语脚本,而其他模型生成的token则显示了孟加拉语-阿萨姆语脚本。

推荐阅读指数

★★★★☆

推荐理由:这篇文章针对低资源语言(阿萨姆语)的分词器性能进行了深入的比较研究,为理解多语言模型在处理低资源语言时的挑战和机遇提供了有价值的见解。研究方法严谨,结果分析详尽,对于自然语言处理领域的研究人员和实践者来说,这是一篇值得一读的研究。

5. Realtime, multimodal invasive ventilation risk monitoring using language models and BoXHED

Authors: Arash Pakbin, Aaron Su, Donald K.K. Lee, Bobak J. Mortazavi

https://arxiv.org/abs/2410.03725

使用语言模型和BoXHED进行实时多模态有创通气风险监测

摘要

目标:在重症监护病房(ICU)中实时监测有创通气(iV)对于确保及时干预和改善患者预后至关重要。然而,传统方法通常只依赖表格数据,忽略了临床笔记中的有价值信息。在本研究中,我们提出了一种创新方法,通过使用语言模型进行文本摘要,将临床笔记纳入监测流程,以增强iV风险监测。结果:我们在所有报告的iV风险监测指标中取得了优越的性能,即AUROC为0.86,AUC-PR为0.35,AUCt高达0.86。我们还展示了我们的方法在标记某些时间桶的iV时提供了更多的提前时间。结论:我们的研究强调了将临床笔记和语言模型整合到实时iV风险监测中的潜力,为ICU环境中改善患者护理和知情临床决策铺平了道路。

创新点

- 多模态数据融合:将临床文本笔记和表格时间序列数据结合,提供更全面的数据分析。

- 使用语言模型:利用Clinical-T5模型对临床笔记进行编码,生成嵌入向量,以提取文本信息。

- 实时风险监测:开发了BoXHEDMM系统,该系统能够实时估计iV事件的风险,并随着新数据的可用性不断更新风险估计。

算法模型

- BoXHED2.0:一种可扩展的树增强风险估计器,专为处理生存分析中的时变数据而设计。

- Clinical-T5:在MIMIC III和MIMIC IV数据集上预训练的文本到文本转换器(T5)模型的变体,用于从临床笔记中生成嵌入。

实验效果

- AUROC:0.86

- AUC-PR:0.35

- AUCt:0.86

- 提前时间:在24至48小时的时间窗口内,BoXHEDMM在标记iV方面显示出明显优势。

重要数据与结论

- BoXHEDMM:在所有评估指标上均优于现有技术。

- 笔记嵌入维度:2维嵌入在预测iV风险方面表现最佳。

- 临床笔记:与表格数据相比,临床笔记在风险监测中提供的信息较少,但与表格数据结合使用时,可以提高风险预测的准确性。

推荐阅读指数

★★★★☆

推荐理由:这篇文章提出了一种结合临床文本和表格数据进行实时风险监测的新方法,对于希望了解如何利用自然语言处理技术改善临床决策支持系统的研究人员和医疗专业人员来说,这是一篇非常有价值的研究。

后记

如果您对我的博客内容感兴趣,欢迎三连击(点赞,关注和评论),我将持续为您带来计算机人工智能前沿技术(尤其是AI相关的大语言模型,深度学习,计算机视觉相关方向)最新学术论文及工程实践方面的内容分享,助力您更快更准更系统地了解 AI前沿技术。