Mamba 是一种状态空间模型(State Space Model, SSM)的特例,作为医学图像分析中模板驱动深度学习方法的替代方案,正日益受到关注。尽管 transformer 是强大的架构,但它也存在一些缺陷,例如计算复杂度为平方级且难以高效处理长距离依赖。这一限制影响了在医学成像中分析大型复杂数据集的能力,因为这些数据集存在大量的空间和时间关系。相比之下,Mamba 具有显著优势,使其非常适合医学图像分析。Mamba 具有线性时间复杂度,这比 transformer 大大改进了性能。在序列建模任务中,其计算复杂度随着输入序列长度线性增长。Mamba 无需注意力机制即可处理更长的序列,从而实现更快的推理速度并减少内存需求。此外,Mamba 在融合多模态数据方面表现出色,从而提高了诊断准确性和患者的治疗效果。

本文的结构设计让读者能够逐步了解 Mamba 在医学成像中的能力。我们首先清晰地定义了与 SSM 和概念模型相关的概念,包括 S4、S5 和 S6。随后我们探讨了 Mamba 架构,包括纯 Mamba、U-Net 变体以及 Mamba 与卷积网络、transformer 和图神经网络(GNN)相结合的混合模型。后续部分则涵盖了 Mamba 的优化、弱监督与自监督学习、扫描机制等技术,以及各种任务中应用的详细分析。我们还提供了可用数据集的概述和一些关于 Mamba 在不同领域的有效性实验结果。此外,本文详细介绍了 Mamba 的挑战与局限性,以及其他有趣的方面和可能的未来发展方向。最后一节解释了 Mamba 在医学成像中的重要性,并提供了其使用及改进措施的分析和结论。

本综述旨在展示 Mamba 在克服医学成像现有障碍方面的变革潜力,同时为该领域的创新进展铺平道路。有关医学领域中应用的 Mamba 架构的全面列表,可在 GitHub 上查看。

https://www.zhuanzhi.ai/paper/ce3e2342b4bc89671df490e8f69db528

1 引言

在过去的几十年中,机器学习 [111] 和深度学习 [114] 的应用使医学领域取得了显著进步。卷积神经网络(CNN)等初始神经网络架构 [82] 在提升图像分割 [74]、分类 [79, 106] 和目标检测 [81] 方面发挥了关键作用。医学图像复杂多样,但 CNN 能够在二维平面上分析三维结构,因此在生物医学图像计算中特别适用于图像分割 [108]、肿瘤检测 [17]、器官分割 [160] 和疾病诊断成像 [16]。CNN 广泛应用于医学成像任务,包括分割、分类和重建。然而,其在处理序列数据或需要长程依赖的多任务时表现不足。例如,在医学图像分割领域,CNN 可能无法如预期般表现良好,因为它们难以建模图像及其部分之间的超分辨率相互依赖关系。

一些 CNN 的缺点通过 transformer 架构 [107, 124] 得到缓解,这类技术在序列数据处理和长程依赖方面表现更优。然而,transformer 也存在一些不足。主要问题是计算注意力的规模随着序列长度呈平方增长,因此在处理非常长的序列时会导致高昂的计算成本。此外,通常需要更多的资源和数据,这在资源受限的环境中(如医学领域)是一个难题。针对传统 CNN 和 transformer 的不足,许多研究探索了可以有效表示长序列及其复杂依赖关系的不同模型。近年来,状态空间模型(SSM)[47] 引起了广泛关注,Mamba [45] 模型便是其中之一。Mamba 旨在解决现代深度学习技术中的相关问题。它利用选择性状态空间来快速处理长序列,结合多种模式,并支持高效的分辨率和实用性。Mamba 的架构整合了选择性扫描机制和硬件感知算法,从而在中间结果的存储和计算方面实现高效率。这样使得 Mamba 在一些需要长程依赖和高复杂度的任务(如医学图像分割 [128, 134, 138]、分类 [44, 99, 150]、合成、配准和重建 [62, 83, 162])中表现优异。

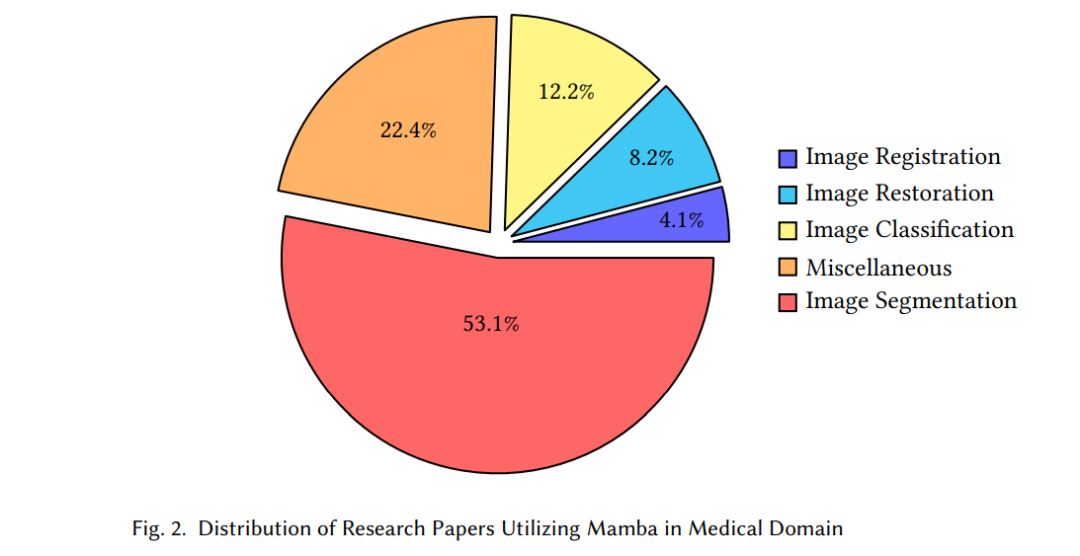

Mamba 在生物医学领域表现出色,特别是在生物医学成像、基因组学和临床记录处理领域。因此,该模型在涉及长程和多模态数据的任务中表现出色,能够捕获信息单元之间的微妙关系和依赖性。图 1 展示了 Mamba 随时间演变的时间线,从 HiPPO [46] 和线性状态空间层(LSSL)[49]、S4 [47]、对角状态空间(DSS)[51]、S4D [48]、S5 [113]、S4ND [100]、Hungry Hungry Hippos(H3)[42] 到 Mamba [45]。其中还包括随着模型演进产生的 Mamba 变体。图 2 所示的饼图展示了使用 Mamba 框架在医学领域各项任务中的研究论文分布,分为五个部分,每个部分代表特定任务及其在总论文数中的比例。此外,图 3 展示了 2023 年 12 月至 2024 年 9 月期间 Mamba 在医学领域相关出版物数量的波动,研究活动在 2024 年 3 月和 4 月明显激增。

目前有几篇关于 Mamba 的综述性论文。然而,这些论文可能做了以下之一的选择——要么 [101, 104] 广泛覆盖框架,要么仅限于视觉领域的应用 [87, 140, 153]。值得注意的是,只有 [56] 对 Mamba 在医学领域的应用进行了评审。然而,我们的综述论文比 [56] 更为全面和详细。特别是,本文重点分析了医学数据集等公共资源,并提供了一些关于 Mamba 在医学实践中应用的实验数据,包括在医疗环境中 Mamba 可用的各种资源和干预措施。此外,我们还包括了 Mamba 架构在医学图像分析领域的最新研究和发展。我们以一种便于读者理解的结构组织了本文,帮助他们认识 Mamba 在医学领域的组织框架,包括其优势、劣势和前景。

在本综述中,我们关注医学领域内 Mamba 状态空间模型的使用、方法和问题。我们提供了该研究方向的现状概述,重点讨论了 Mamba 模型的优缺点及其未来前景。本文余下部分的结构如下:第 2 节讨论了与 SSM 相关的关键术语,第 3.1 节介绍了不同的 Mamba 架构。第 3.3 节讨论了若干 Mamba 优化,第 3.4 节解释了弱监督、半监督、自监督、对比学习和多模态学习等技术。第 3.2 节讨论了 Mamba 中的不同扫描机制,第 3.5 节介绍了各个领域中的应用。数据集概述见第 4 节。第 5 节讨论了展示 Mamba 在不同任务中表现的实验结果。第 6 节解释了 Mamba 的局限性和新兴领域,最后在第 7 节中提出了未来发展方向并总结了本文的研究。

2. SSM 的核心概念

在深度学习领域,transformer 在计算机视觉(CV)和自然语言处理(NLP)任务中占据主导地位。transformer 中的自注意力机制 [124] 通过生成查询、键和值向量的注意力矩阵,大大提升了对这些模态的理解。虽然注意力矩阵有其优势,但其计算复杂度为平方级。最近的一些进展,例如 Dao 等人提出的 FlashAttention [20, 21] 和线性注意力 [72],通过降低计算复杂度解决了这一问题。例如,在线性注意力中,键向量与值向量相乘,而非查询向量,并用相似度函数代替了 softmax 函数。Gu 等人开发的 Mamba [45] 进一步缓解了这一问题,将平方时间复杂度转化为线性时间复杂度,并以递归方式实现。Mamba 是第一个在无注意力机制下达到强大 transformer 表现的模型。Mamba 的核心概念及其从 SSM 的推导将在后续部分详细解释。

3 使用 Mamba 进行医学图像分析

在本节中,我们将分类与 Mamba 架构相关的文献,探讨增强其性能的优化方法,并讨论各种扩展其功能的技术和适配。此外,我们还将研究 Mamba 相关的扫描技术,最后展示其在医学领域中的多样化和深远影响的应用。

3.1 Mamba 架构

在本节中,我们将探讨并讨论 Mamba 的架构布局,首先介绍基础的纯 Mamba 设计及其通过 U-Net 变体的演变。然后,我们将转向混合架构领域,在该领域中,Mamba 被巧妙地与其他强大技术相结合,以实现更高的性能并应对复杂任务。

3.2 扫描

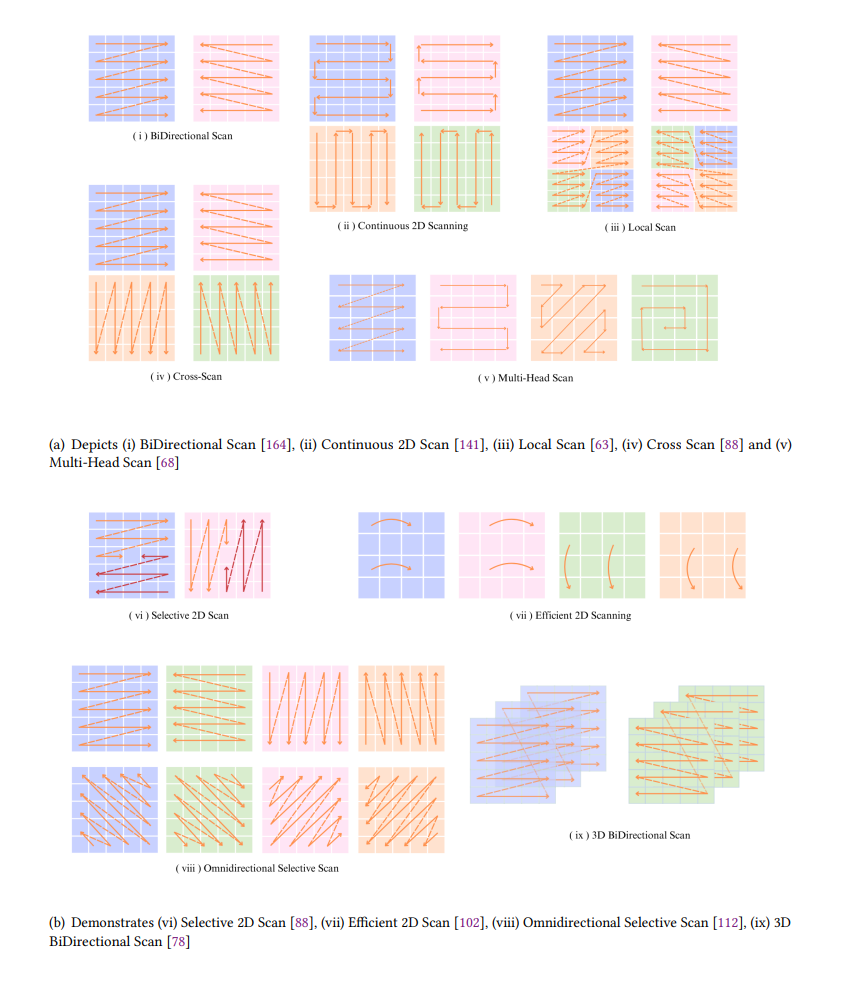

注意力机制,尤其是自注意力机制,具有平方级的时间复杂度,导致计算成本随序列长度呈平方增长。相比之下,扫描操作通常具有线性时间复杂度,因此在处理长序列时效率更高。扫描操作涉及计算一个数组(如前缀和),其中每个值由之前计算的值和当前输入决定。类似地,SSM 的递归形式可以视为一种扫描操作。扫描是 Mamba 的一个关键组件,特别是在处理多维输入时。Mamba 模型中扫描机制的选择至关重要,因为它提高了效率并提供了重要的信息。图 15 以可视化的形式展示了 Mamba 架构中采用的各种扫描机制,该可视化突显了集成到 Mamba 模型中的多种扫描方法的多样性。表 1 总结了各种扫描机制及其相关模型。

3.3 Mamba 优化

本节讨论了专注于轻量化、高效化及优化模型架构的研究论文。

3.3.1 轻量化与高效性

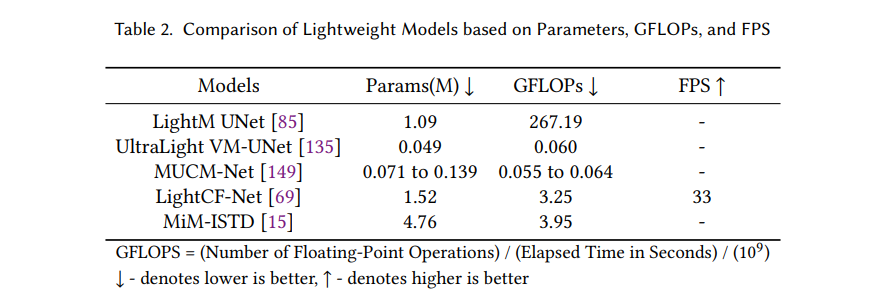

轻量化和高效模型设计旨在保持良好性能的前提下,使模型更小、速度更快且资源占用更少。表 2 基于每秒千亿次浮点运算(GFLOPs)、参数数量以及每秒帧数(FPS)比较了上述轻量化模型,这些指标分别对每个模型的计算效率、复杂性和速度进行了详细评估。

Liao 等人提出的轻量 Mamba UNet(LightM UNet)[85] 将 Mamba 与 UNet 架构相结合,形成轻量框架,以应对实际医疗环境中的计算挑战。该模型中提出的残差视觉 Mamba(RVM)层改进了 SSM,用纯 Mamba 方式从图像中提取深度语义特征。LightM-UNet 仅使用 1.09M 个参数和 267.19 GFLOPs,就能超越现有的最先进方法。Wu 等人引入了超轻量视觉 Mamba UNet(UltraLight VM-UNet)[135],这是一个轻量化视觉 Mamba 模型。通过并行视觉 Mamba(PVM)方法在保持处理通道数量恒定的同时,低计算复杂度下实现了高性能。PVM 主要由结合残差连接和调整因子的 Mamba 组成,使传统 Mamba 捕获远程空间关系而无需增加额外参数和计算复杂度。在三个公开皮肤病变数据集上进行的对比分析中,UltraLight VM-UNet 仅使用 0.049M 参数和 0.060 GFLOPs,即实现了有竞争力的性能。UltraLight VM-UNet 的参数数量比 LightM-UNet 减少了 87.84%。

Yuan 等人提出的 MUCM-Net [149] 是一个高效模型,将 Mamba 状态空间模型与 UCM-Net 架构结合,以改进分割和特征学习。该模型将 Mamba-UCM 优化为移动设备部署,提供高精度并具有最低的计算需求(约 0.055–0.064 GFLOPs 和 0.071–0.139M 参数)。Ji 等人提出的 LightCF-Net [69] 是一种新颖且高效的轻量化架构,作为一种实时息肉分割的远程上下文融合网络。该模型开发了新的 FAEncoder 模块,将大核注意力(LKA)与通道注意力机制结合,用于提取息肉的深度表示特征并揭示长程关系。此外,将新型视觉注意力 Mamba 模块(VAM)集成到跳跃连接中,以从编码器提取的特征中捕获广泛的上下文依赖关系,优先处理关键信息并通过注意力机制减轻背景噪声干扰。该模型在四个息肉分割数据集上的评估展示了其相对于领先轻量化息肉分割网络的运行效率和分割精度。尽管该方法在分割任务中表现良好,但医疗环境的复杂性和训练过程中标注数据的限制构成了挑战,使其难以完全满足医学应用的需求。该模型具有 1.52M 参数,运行于 3.25 GFLOPs,帧率为 33 FPS。

Chen 等人提出了用于红外小目标检测(ISTD)的 MiM-ISTD [15]。该模型利用 Mamba 有效捕获数据中的局部和全局信息,从而在低计算成本下保证更高的效率。在 NUAA-ISTD 和 IRSTD-1k 数据集上的实验中,MiM-ISTD 在准确性和效率方面均优于其他相关方法。MiM-ISTD 比当前最先进方法快十倍,在高分辨率图像测试中减少了 73.4% 的 GPU 内存使用。

3.4 技术和适配

本节探讨 Mamba 架构的各种技术和适配方法,如弱监督、半监督和自监督方法。这些方法适用于数据标注缺失、部分存在或不一致的场景,旨在提升模型从非结构化、不完整或半结构化数据中学习的能力。

3.4.1 弱监督学习

弱监督学习(Weakly Supervised Learning, WSL)使用少量准确标注的数据和大量具有不完整标注的数据。与需要每个数据的详细标签不同,这种方法可以处理带有噪声和部分标签的数据。Wang 等人提出的 WeakMamba-UNet [130] 是一种 WSL 策略,结合了三种不同的架构,但均采用对称的编码器-解码器网络。该网络包括基于 CNN 的 U-Net(擅长捕捉局部特征)、基于 Swin Transformer 的 SwinUNet(擅长理解全局上下文)以及 VMamba 基的 Mamba-UNet(高效捕捉长程依赖)。该 WSL 框架使用多视角交叉监督学习方法进行基于涂鸦标注的医学图像分割。引入了部分交叉熵损失,在网络训练期间仅利用涂鸦标注,总体损失由涂鸦标注的部分交叉熵损失和密集伪标签 dice 系数损失组成。该网络在 MRI 心脏数据集 [9] 的分割任务中表现出色,精度达到了 99.63%。

3.4.2 半监督学习

半监督学习在训练期间使用少量标注数据和大量未标注数据。Ma 等人提出的 Semi-Mamba-UNet [92] 是一种集成了 Mamba 分割网络的半监督学习框架,结合了 Mamba-UNet 和 U-Net 的互补优势,分别利用标注和大量未标注数据。该框架提出了像素级对比学习策略,以增加从一对投影器中学习特征的能力。通过伪标签训练另一个网络,采用像素级交叉监督学习策略。总体损失包括监督损失、自监督对比损失和半监督损失。在 ACDC MRI 心脏数据集 [9] 上测试该模型时,使用 5% 标注数据时,dice 系数达 0.8386,准确率为 0.9936,敏感性为 0.7992,特异性为 0.9483,Hausdorff 距离(HD)为 6.2139,平均表面距离(ASD)为 1.6406。当使用 10% 标注数据训练时,模型性能提升,dice 系数达 0.9114,准确率为 0.9964,敏感性为 0.9146,特异性为 0.9821,HD 为 3.9124,ASD 为 1.1698。

3.4.3 自监督学习

自监督学习通过创建自身标签从未标注数据中学习,而非依赖外部手工标注的标签。Nasiri 等人提出的 Vim4Path [99] 使用 Caron 等人的 DINO [10] 中的 Vision Mamba 进行表征学习,旨在将 ViM 用于 SSL。DINO 是一种著名的自监督学习框架,通过教师-学生架构中的自蒸馏实现自监督,两个网络架构相同但参数不同。研究比较了在 Camelyon16 数据集上基准测试的两个架构在切片级和块级分类任务中的表现。Lu 等人提出的 CLAM 框架 [90] 利用基于注意力的多实例学习实现切片级分类,识别最能指示切片级标签的子区域。该方法使模型专注于最相关特征,而无需详细注释。Zhou 等人提出了 MGI [163],一种新的多模态模型,使用基因和图像数据。该方法在预训练过程中使用自监督对比学习策略,使视觉编码器和基因编码器在配对的基因和图像数据上对齐,使视觉编码器从基因角度学习相关特征。该过程接着是一个轻量化的多模态注意力融合解码器,用于整合图像和基因数据。使用 Mamba 提取基因数据的特征,解决了以往编码器在捕捉长基因序列的长程依赖关系中遇到的问题。Tang 等人提出的 MambaMIM [116] 是一种基于 3D-UNet 的自监督学习架构,结合 3D 稀疏卷积与 Mamba 块,并引入选择性结构状态空间序列插值(S6T),在解码器块之前通过线性层处理插值序列。

对比学习是自监督学习中的一种技术,通过比较数据样本对来学习表征。Yang 等人提出的对比掩码 Vim 自动编码器(CMViM)[142] 是一种高效的 3D 多模态数据表征学习方法,用于重建 3D 掩码多模态数据。该方法通过引入跨模态对比学习机制对齐多模态表征,以有效捕捉 3D 医学数据中的长程依赖关系。CMViM 在阿尔茨海默症诊断中表现优于其他先进方法。

3.4.4 多模态学习

Xie 等人提出了类似 U-Net 的架构 Fusion Mamba [137],设计用于编码多模态图像并解码它们。Fusion Mamba 中的编码器部分集成了动态视觉状态空间(DVSS)模块,使用了高效状态空间模块(ESSM),包括高效二维选择性扫描(ES2D)和高效通道注意力(ECA)[129]。ECA 利用自适应平均池化和一维卷积层及 sigmoid 激活函数,使 SSM 有效学习通道表征。DVSS 输出通过可学习描述卷积(LDC)残差添加到输入上,允许 SSM 捕获每种模态中的纹理特征。动态特征融合模块(DFFM)用于在不同模态之间融合特征。DFFM 包含动态特征增强模块(DFEM),进行粗粒度融合,之后通过跨模态融合 Mamba 模块(CMFM)处理。解码器包含补丁扩展块和两个 DVSS 块,DFFM 的组合特征作为解码器的跳跃连接。最后,通过每种图像模态获得融合图像。

Zhou 等人提出的 MGI [163] 是一种用于对齐图像和基因模态的多模态方法,采用类似 CLIP [105] 的预训练方式。Mamba 编码器用于图像和基因数据,跨模态嵌入之间应用对比损失生成类似 CLIP 的矩阵。在注意力集成模块中,模块之间的对齐通过基因模态的自注意力块、基因到图像的注意力块、MLP 层及图像到基因的注意力块实现。

Fang 等人提出的 GFE-Mamba [39] 采用多阶段训练策略,首先训练 3D GAN 将 MRI 图像转换为 PET 图像,然后将 MRI 和 PET 的潜在表示与表格数据拼接,并通过线性层或嵌入层送入 Mamba 分类器。MRI 和 PET 潜在空间与 Mamba 表征之间的像素级双交叉注意力操作,进一步用于最终分类。

3.5 各医学领域的应用

在本节中,我们探讨了基于 Mamba 的模型在一系列医学任务中的应用,包括分割、分类、配准和恢复等。我们还通过医学成像中的其他应用展示了其多功能性。每个小节首先概述任务,然后讨论在这些领域中应用 Mamba 基模型的相关研究论文。

3.5.1 医学图像分割

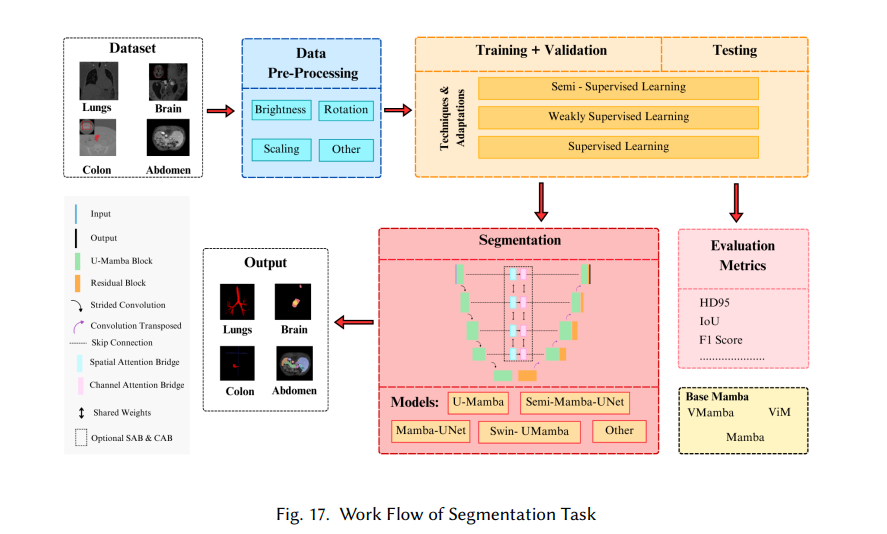

医学图像分割是一种用于识别和提取医学图像中特定感兴趣区域(ROI)的技术,如肿瘤、病变、组织或器官。其目标是将图像划分为具有相似特征的区域,包括颜色、纹理、亮度和对比度。表 3 概述了分割模型的参数、描述及代码的可用性。图 17 展示了 Mamba 基模型在医学图像分割任务中的工作流程。

3.5.2 医学图像分类

医学图像分类是指将图像分为不同类别,例如区分良性和恶性病变,或识别不同类型的疾病。图 20 展示了基于 Mamba 的模型在医学图像分类任务中的工作流程。表 4 总结了分类模型及其参数,附有描述和代码可用性的信息。

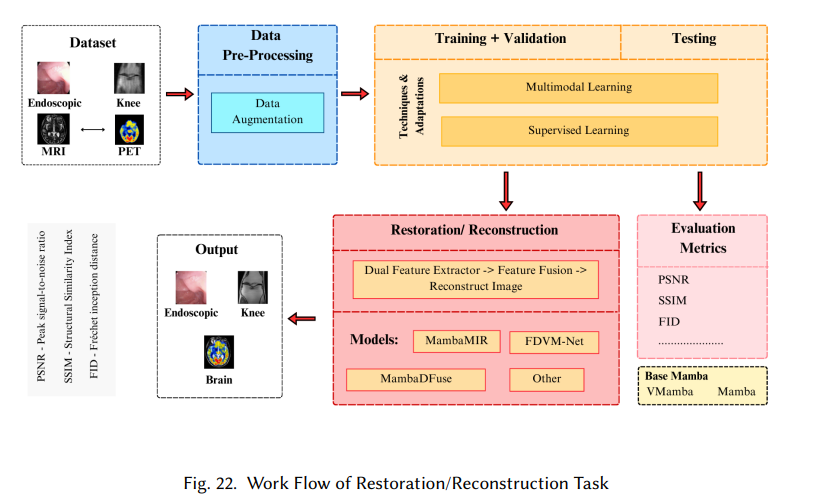

3.5.3 医学图像恢复/重建

恢复(Restoration)是医学成像中的一种应用,用于改善因噪声、低分辨率和模糊等因素而受损或失真的图像质量。重建(Reconstruction)是一种将原始医学数据转换为目标图像的数学过程。表 5 概述了应用于医学图像恢复/重建的基于 Mamba 的模型,包括参数、描述及代码可用性。图 22 展示了基于 Mamba 的模型在医学图像恢复/重建任务中的工作流程。

如何系统的去学习大模型LLM ?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

事实上,抢你饭碗的不是AI,而是会利用AI的人。

继科大讯飞、阿里、华为等巨头公司发布AI产品后,很多中小企业也陆续进场!超高年薪,挖掘AI大模型人才! 如今大厂老板们,也更倾向于会AI的人,普通程序员,还有应对的机会吗?

与其焦虑……

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高。

针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)👈

一、LLM大模型经典书籍

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套LLM大模型报告合集

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、LLM大模型系列视频教程

四、LLM大模型开源教程(LLaLA/Meta/chatglm/chatgpt)

LLM大模型学习路线 ↓

阶段1:AI大模型时代的基础理解

-

目标:了解AI大模型的基本概念、发展历程和核心原理。

-

内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

- L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

-

目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

-

内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

- L2.2 Prompt框架

- L2.3 流水线工程

- L2.4 总结与展望

阶段3:AI大模型应用架构实践

-

目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

-

内容:

- L3.1 Agent模型框架

- L3.2 MetaGPT

- L3.3 ChatGLM

- L3.4 LLAMA

- L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

-

目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

-

内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

这份 LLM大模型资料 包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)👈

![[ESP32]ESP-IDF使用组件添加U8g2图形库](https://img-blog.csdnimg.cn/img_convert/aca4f55492aba2f44abd8c451dcc34dd.png)