距ChatGPT3.5发布已近一年,大模型狂热开始逐步降温:GPU禁运及长期烧钱的事实,让国内的大模型企业,不得不加速商业化考量。

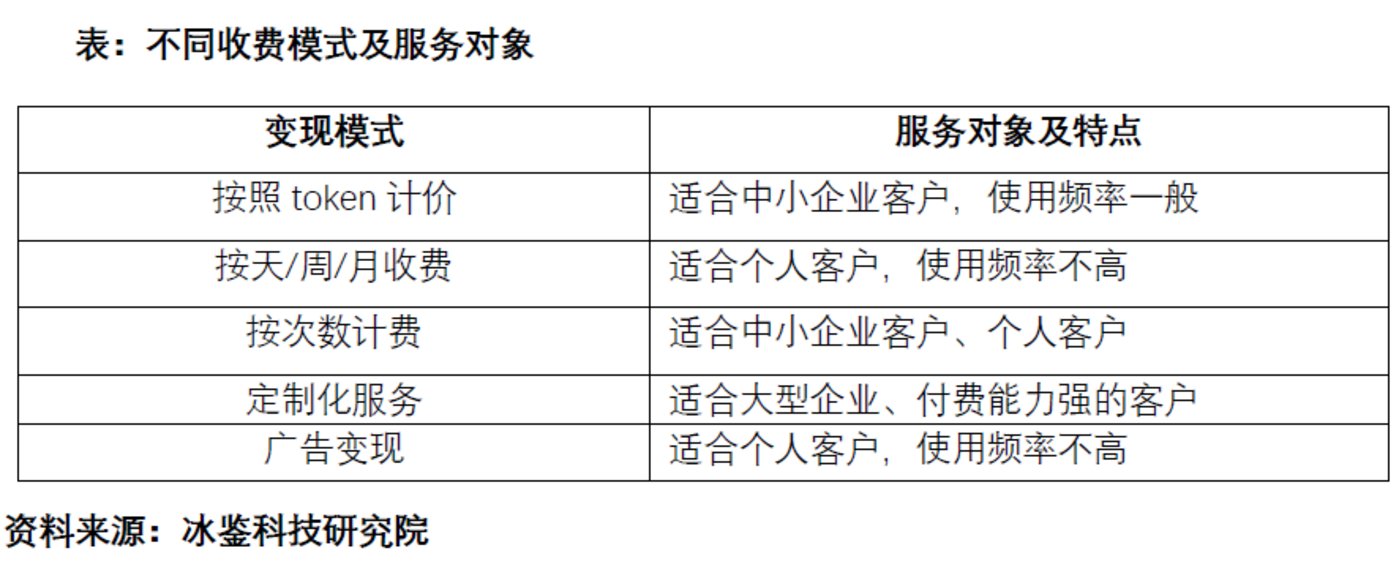

目前,大模型的B端应用已经出现各种定价方法,包括按照时间段收费、按调用量收费以及各种包含硬件的一站式解决方案。其中,按照调用量定价的大模型又可以分为token计费以及按照查询次数收费。

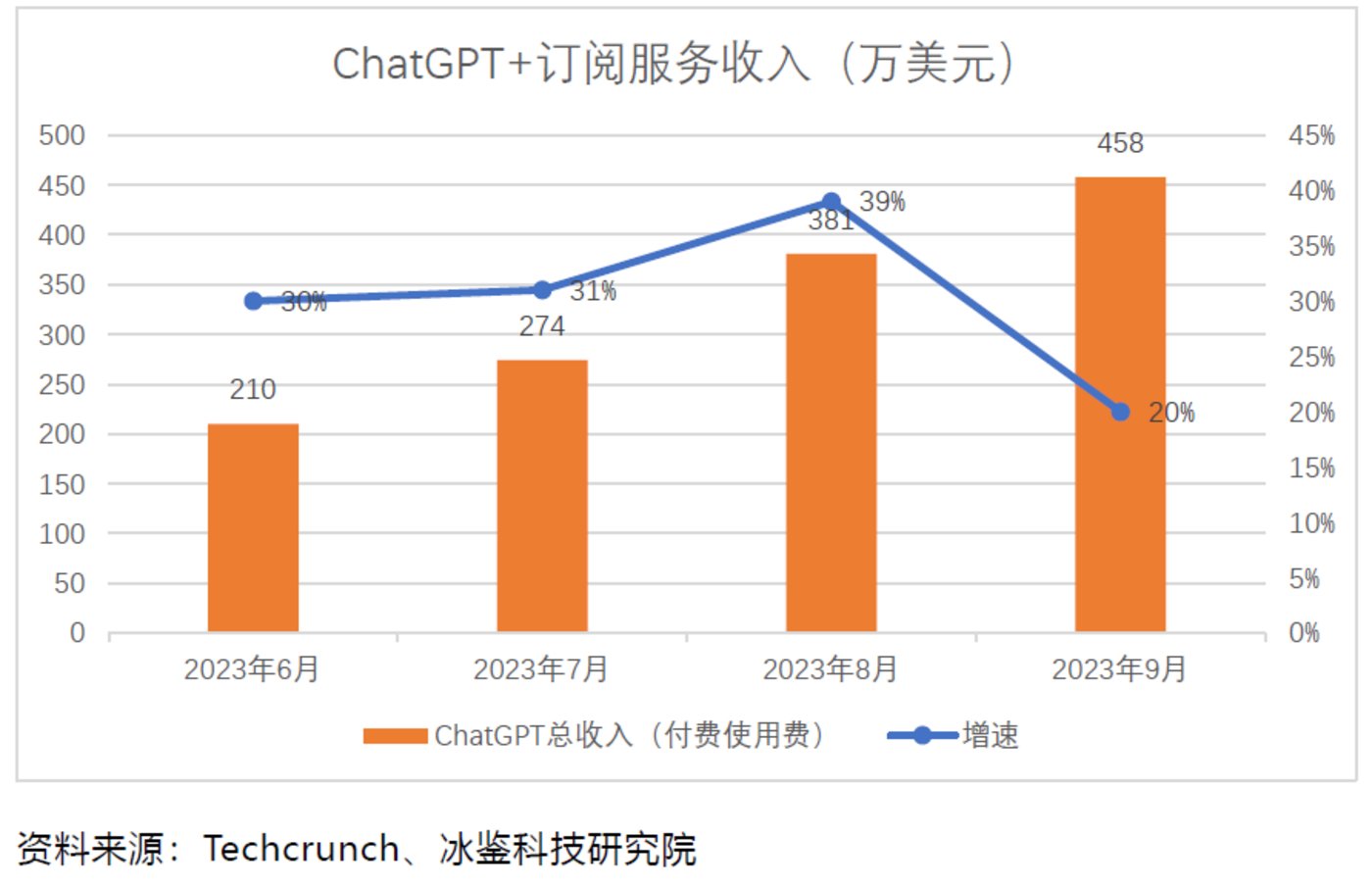

与此同时,国外的大模型先行者实现收入激增,比如微软,每月大模型应用的收入已经达到数千万人民币,并且保持20%以上的月均增速。OpenAI公司收入增长也超出预期。The Information援引知情人士报道,按照OpenAI目前的营收增速,这家公司有望在未来12个月内通过销售AI软件和算力产生超过10亿美元的收入,高于该公司此前对股东报告的收入预测。

不过,国内大模型的商业化之路比国外同行要慢半拍,在模仿后者的商业化道路上可能荆棘遍地。

ChatGPT可以针对C端客户收取月费,但国内大模型想向C端收费绝非易事。先做大C端用户规模,再向广告主收费是互联网企业的不二法门;至于要求苛刻的B端客户,大模型厂商能否说服他们付费,并形成稳定的SaaS订阅收入模式,还有很长的路要走。

按token收费

目前,通用大模型平台偏爱按token计费,但国内国外的token标准并没有统一,国内一些大模型平台1 token等于1个汉字,一些平台理解为1.5个汉字,还有1.8个汉字。除此之外,各家收费计算口径也不一样,以千tokens计价,价差最高达上百倍,每1000 tokens收费在0.008元至0.876元人民币之间。

1、 什么是token?

Token是用来计量大模型输入、输出的基本单位,也可以直观的理解为“字”或“词”。但是目前并没有统一计量标准,各家大模型平台根据自己的偏好“随意”定义。如腾讯1token≈1.8个汉字,通义千问、千帆大模型等1token=1个汉字,对于英文文本来说,1个token通常对应3至4个字母。市场急需统一口径。

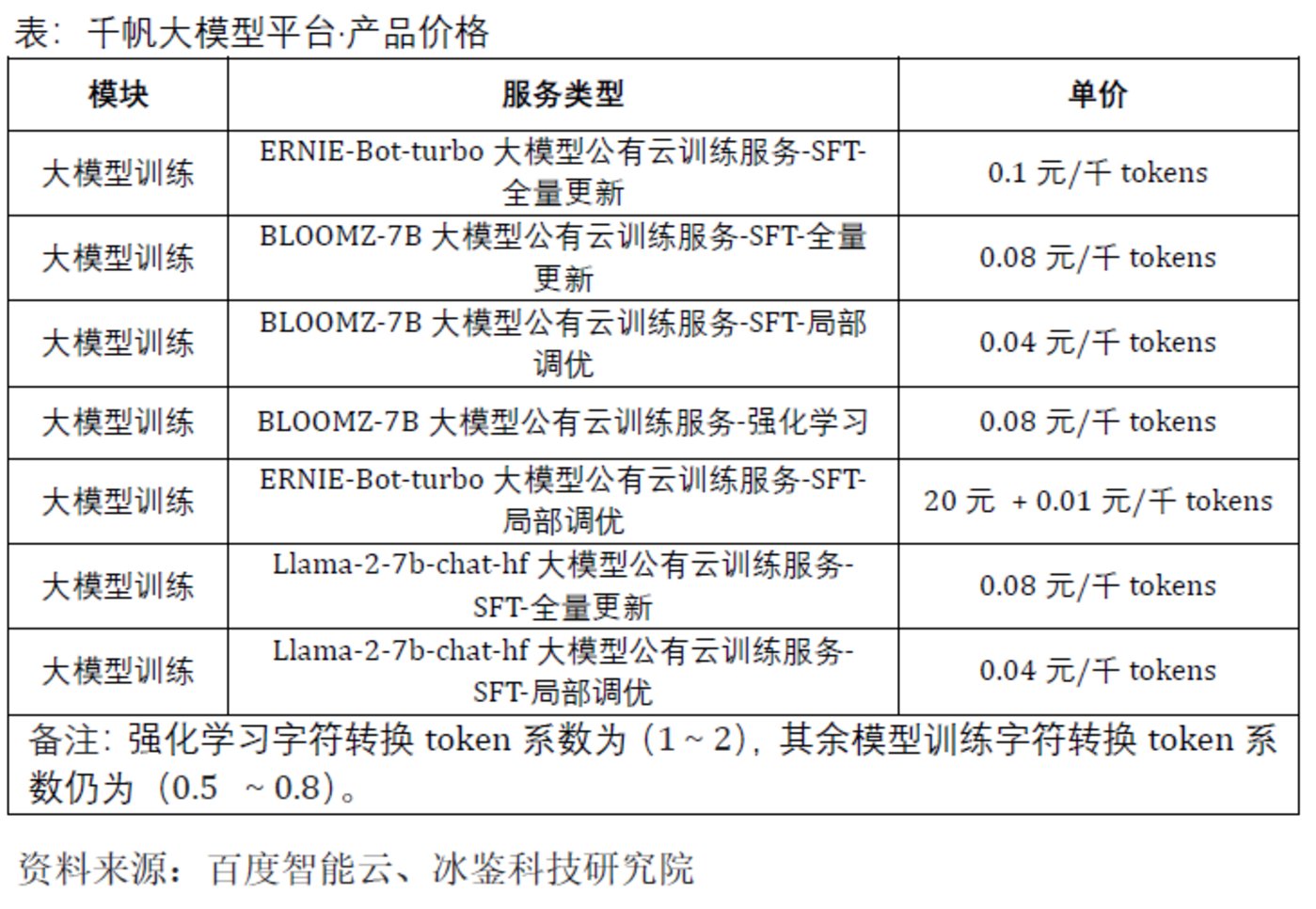

具体计价时,大模型按照tokens计量,且服务输入和服务输出均收费。目前,ChatGPT对输入和输出收取不同费用,而国内的大模型输入和输出收取费用一样。如千帆大模型对收费解释如下:

1.2 tokens计价

各家企业的大模型tokens计价五花八门,同一家企业也推出不同大模型,收费也不尽相同。此外,同一个产品不同时间段使用,收费还不一样。如百川智能的大模型Baichuan 53B,其00:00 ~ 8:00收费为0.01元/千 tokens,而8:00 ~ 24:00收费为0.02元/千 tokens 。

具体来讲,科大讯飞目前对外开放了星火大模型V1.5、V2.0和V3.0等三个版本,其刊例价分别为0.18元/万tokens、0.36元/万tokens、0.36元/万tokens。目前针对个人客户可以免费试用200万tokens,针对企业客户可以免费试用500万tokens。就企业客户而言,科大讯飞为每个版本的大模型各推出了四个收费套餐,其中V3.0和V2.0版本价格相同,且是V1.5的两倍,具体价格如下表:

腾讯混元大模型提供 API 接入方式,采用后付费日结模式:为每个在白名单中的已实名腾讯云企业账号提供累计10万 tokens 的免费调用额度;以资源包的形式发放到腾讯云账号中,优先扣除。在免费额度用完后,按如下价格进行计费:

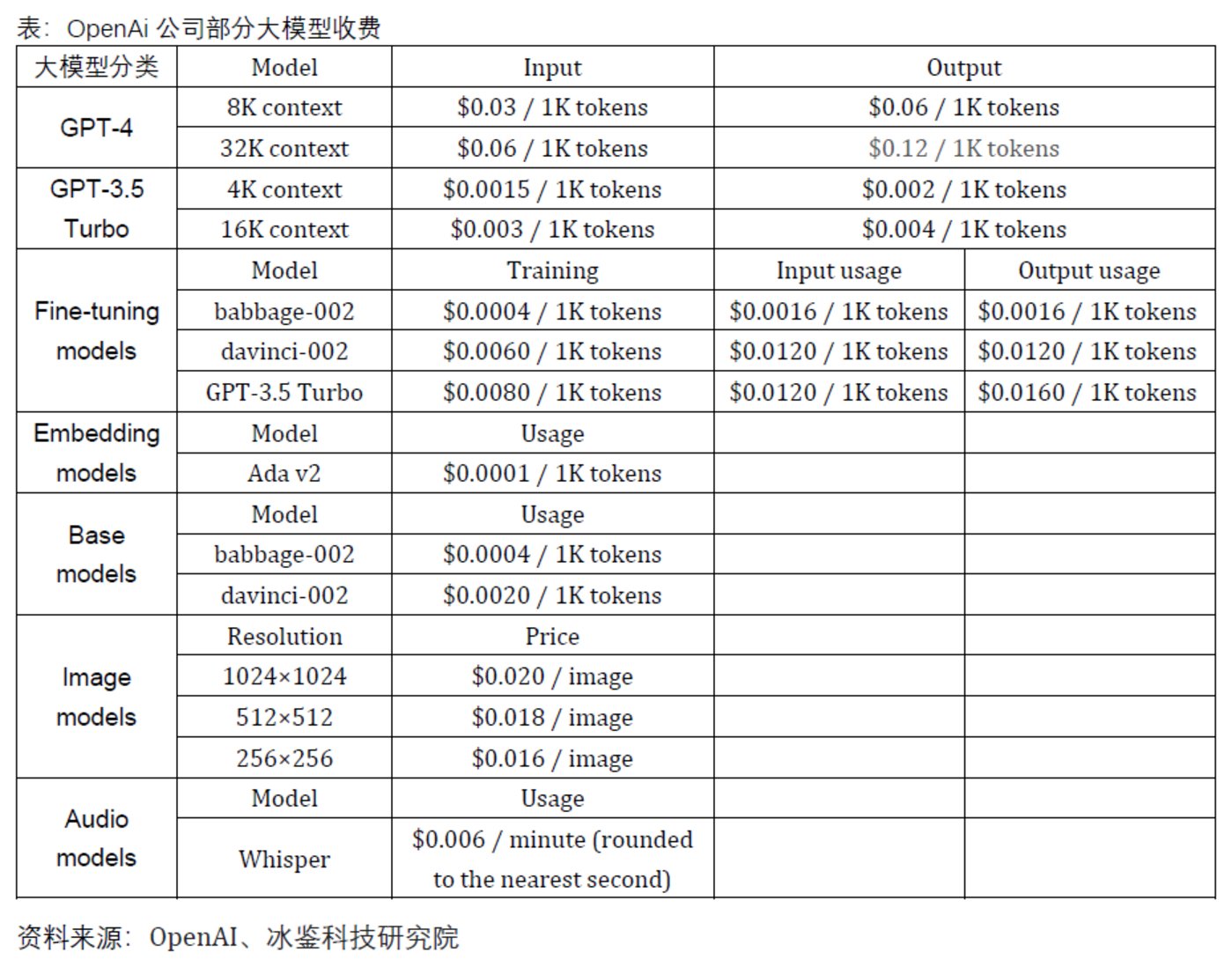

OpenAI推出了多款商业化大模型,分别是GPT-4、GPT-3.5 Turbo,Fine-tuning models、Embedding models等。OpenAI公司各大模型定价相差较大,其中GPT-4-32k context输出服务收费最贵,每1000 token收费0.12美元,折合成人民币0.876元。

国内国外大模型定价相差百倍,文心一言和通义千问(qwen-turbo)仅0.008元/1k token。

按照tokens计算,各家公司部分大模型的输入和输出计价如下图:

按月收费

除了按照token计费,一些AI助手按月收费。如微软开发的AI编程工具GitHub Copilot,目前已经拥有150万用户。针对个人客户,GitHub Copilot收费是每月10美元,或者每年100美元;针对企业客户,对应收费是19美元/月。按照微软最新财报,互联网巨头通过大模型,带动周边业务,如office,搜索引擎bing,云业务Azure等营收大幅增长,也是一种商业化的模式。

除此之外,OpenAI公司推出的ChatGPT,针对客户也有按月付费的服务,目前为每人每月20美元。除此之外,OpenAI通过客户注册账户使用的企业电子邮箱统计分析发现,已经有80%的世界五百强企业员工开始使用ChatGPT进行工作。

另据Techcrunch报道,相关数据显示,9月ChatGPT在iOS和安卓应用端的下载量达到1560万次,单月总收入458万美元。

11月1日,文心一言推出会员模式,单月购买59.9元/月,连续包月定价49.9元/月,开通会员后,付费会员可以使用文心大模型 4.0。此外,文心一言联合会员——“文心一言会员+文心一格白银会员”定价99元/月,白银会员享有AI编辑改图修图等更多权益。

不过,按月收费的模式在C端用户方面成本高企,即使微软也依然亏损严重。今年头几个月,微软在这个项目上平均每个用户每月亏损超过 20 美元,一些用户造成的损失高达 80 美元。不过, GitHub Copilot的整体收入在持续增加。

收取广告费

令人意外的是,ChatGPT的知名度虽然最高,但在软件商店中并不是收入规模最大的人工智能应用,而是一款名为 Ask AI 的竞品。

根据App Store中该应用介绍——Ask AI旨在简化用户的工作并扩展知识,提供精确的答案来帮助用户完成任务。

该应用不仅收取每周4.99美元订阅费用,还因为下载量巨大,已经超过2500万次,吸引了商家投放广告,每月获得数百万美元收入。据Appfigures 的数据显示,Ask AI的订阅和广告累计收入超过1600万美元。按月计算,从 今年5月份的 648 万美元上升到了8月份的 655万美元,9 月份略有下降,至 551 万美元,但这一数字仍高于 ChatGPT 在软件商店的收入。因此,只要下载量或者使用量足够大,未来广告收入也将成为大模型商业化的主要收入来源。

另据 Data.ai App IQ 统计,截至 2023 年 8 月,iOS App Store 与 Google Play 已累计发布超 1000 款生成式 AI功能应用,全球总下载量已突破 8 亿次。其中,一款名叫Artimind的以生成 AI 图片为主要功能的全新应用,已获得近 150 万安装量。

国内,也有一些类似的产品推出,未来也可能实现广告收入,如科大讯飞的基于大模型的产品讯飞星火上线首日 14 小时用户突破 100 万,迅速登上 AppStore 免费总排行榜第一。

按调用次数收费

与按照token计价略有不同,一些大模型产品按照调用次数收费。

在2023年钉钉生态大会上,钉钉将大模型商业化与钉钉现有服务融合,落地应用场景的商业化方案是按照调用次数收费。具体来看,在钉钉专业版年费9800元基础上,增加1万元即可获得20万次大模型调用额度;增加2万元即可获得45万次大模型调用额度,相当于一次调用平均5分钱左右。

除此之外,Ask AI等大模型产品针对C端客户也推出了按需购买的服务。

定制化 “软件+硬件”服务

对于大型企事业单位,如银行、保险、信托公司、高校等,偏爱大模型企业提供定制化服务或者一站式服务。服务内容不仅包括大模型系统,还包括服务器等硬件产品等一站式解决方案。如近期清华大学准备花费700万元,公开采购大模型系统教学实践平台。该采购不仅包括大模型系统,还包括24台服务器(GPU的FP32计算精度≥80TFLOPS),4台服务器(GPU的FP32计算精度≥35TFLOPS),1台可编程交换机。山东商业职业技术学院云计算产业学院发布大模型技术赋能中心采购项目,预算116.466万元,也要求提供相关硬件产品。

与此同时,市面上一些企业也发布了人工智能一站式解决方案,如华为发布FusionCubeA3000训/推超融合一体机。该产品支持两种商业模式:昇腾一站式方案和第三方GPU一站式方案,除了自研OceanStorA300高性能存储节点外,其余GPU服务器、交换机、AI平台软件向伙伴开放,为大模型伙伴提供开箱即用的部署体验,实现一站式交付。

总结与展望

烧钱如流水,大模型的商业变现显得更为急切,但是与巨大的投入成本相比,当前的收入能否覆盖各项成本支出仍未可知。

冰鉴科技研究院认为,在产品定价方面,大模型企业针对C端客户的产品按月收费,针对B端客户,按照调用量(token、次数)计价可能是明智的选择。虽然C端客户付费意愿不强,但只要用户量足够大,大模型公司就可以从广告主处获得补偿,类似Ask AI。企业客户由于工作需求,付费能力更强,日常使用调用量较大,按照调用量收费才能更好的覆盖成本。除此之外,由于大型企业拥有更强的付费能力,为银行、大型央企、国企、上市公司等提供定制化、一站式服务,可以为大模型企业带来更多收入。比如目前一些大型银行在公布大模型采购服务时,服务内容就不仅包括AI软件与模型开发服务,还包括大模型GPU服务器、GPU专用存储服务器、IB交换机等硬件采购。

不过,红杉资本的文章《Generative AI’s Act Two》提到,当前生成式AI客户参与度较低。与一些消费公司拥有60%-65%的日活或者月活相比,生成式AI应用程序的中位数仅仅14%,这意味着用户还没有在生成式人工智能产品中找到足够的价值来每天使用它们。因此,大模型平台必须进一步优化产品,让生成式AI结果更加满足用户需求。

展望未来,训练成本、芯片采购成本不断攀升,严重阻碍大模型升级迭代,而占比最大的是AI芯片成本,如何降低芯片成本成为大模型企业的当务之急!

据伯恩斯坦分析师Stacy Rasgon分析,如果ChatGPT的查询规模增长到谷歌搜索的十分之一,OpenAI的 GPU采购成本高达480亿美元,另外,还需要每年支付160亿美元芯片运维成本。

面对巨额成本,除了等待芯片价格下降外,大模型企业也在想办法制造芯片,如OpenAI不仅考虑自研芯片,还投资了3家芯片公司,其中包括美国算力芯片公司Cerebras。这家公司造出了世界最大的芯片,拥有1.2万个晶体管、面积大过ipad。

国内的大模型企业面临的压力尤甚。

随着美国不断收紧AI芯片出口,不仅面临着芯片难买、还面临着价格飞涨的窘境。10月17日,美国商务部工业与安全局(BIS)进一步收紧对尖端人工智能芯片的出口管制,严格限制英伟达和其他芯片制造商向中国销售高性能半导体。根据新规受到管制的英伟达芯片涉及 A100、A800、H100、H800、L40,甚至包括RTX4090。

与此同时,相关芯片存货价格翻倍式上涨,A800、H100等每台已经涨到150万以上,RTX 4090显卡价格更是从原本的1.5万元飙升至3万元以上,其他芯片更是有价无市。芯片等价格飞涨导致国内大模型企业研发支出成倍增长,企业盈利状况不断恶化。科大讯飞今年三季度归属于上市公司股东的净利润同比下降81.86%,其表示主要原因系公司在通用人工智能认知大模型等方面坚定投入。

种种不利条件,导致刚起步的国内大模型企业在与国外同行竞争时,面临着算力不足,大模型优化升级滞后,从而引起客户付费意愿不足的窘境。

本文链接:大模型商业化模式详解:烧钱之后如何挣钱? - AI新智界