GNN-RAG:用于大模型推理的图神经检索

- 秒懂大纲

- 提出背景

- 解法拆解

- 全流程优化

- 创意

- 总结

论文:GNN-RAG: Graph Neural Retrieval for Large Language Model Reasoning

代码:https://github.com/cmavro/GNN-RAG

秒懂大纲

├── GNN-RAG【主题】

│ ├── 1 简介【背景和目的】

│ │ ├── KGQA任务的复杂性【问题描述】

│ │ ├── LLMs和GNNs在KGQA中的应用【现有方法】

│ │ └── GNN-RAG的提出【解决方案】

│ │

│ ├── 2 方法【核心内容】

│ │ ├── GNN组件【方法组成】

│ │ │ ├── 密集子图推理【功能】

│ │ │ └── 答案候选检索【功能】

│ │ ├── LLM组件【方法组成】

│ │ │ ├── 路径文本化【功能】

│ │ │ └── RAG推理【功能】

│ │ └── 检索增强(RA)【优化技术】

│ │ ├── GNN检索【组成部分】

│ │ └── LLM检索【组成部分】

│ │

│ ├── 3 实验设置【评估方法】

│ │ ├── 数据集【评估工具】

│ │ │ ├── WebQSP【具体数据集】

│ │ │ ├── CWQ【具体数据集】

│ │ │ └── MetaQA-3【具体数据集】

│ │ └── 评估指标【评估标准】

│ │ ├── Hit【具体指标】

│ │ ├── Hits@1 (H@1)【具体指标】

│ │ └── F1【具体指标】

│ │

│ ├── 4 结果【实验成果】

│ │ ├── 主要结果【性能比较】

│ │ ├── 多跳和多实体KGQA【特定任务表现】

│ │ ├── 检索增强效果【方法优化】

│ │ └── LLMs上的检索效果【应用范围】

│ │

│ └── 5 结论【总结】

│ ├── GNN-RAG的优势【方法贡献】

│ │ ├── 有效性和忠实性【优点】

│ │ └── 效率【优点】

│ └── 未来工作【展望】

方法组成

├── 2 方法【核心内容】

│ ├── 输入【起始点】

│ │ ├── 问题q【用户查询】

│ │ └── 知识图谱G【知识库】

│ │

│ ├── GNN组件【处理阶段1】

│ │ ├── 密集子图检索【预处理】

│ │ │ └── PageRank Nibble算法【技术】

│ │ ├── 密集子图推理【核心处理】

│ │ │ ├── ReaRev模型【技术选择】

│ │ │ └── 问题-关系匹配操作ω(q,r)【关键操作】

│ │ │ ├── SBERT【编码选项】

│ │ │ └── LM_SR【编码选项】

│ │ └── 答案候选检索【结果提取】

│ │ ├── 节点概率排序【方法】

│ │ └── 阈值选择【技术】

│ │

│ ├── LLM组件【处理阶段2】

│ │ ├── 路径文本化【预处理】

│ │ │ └── 最短路径提取【技术】

│ │ └── RAG推理【核心处理】

│ │ ├── 提示工程【技术】

│ │ └── LLaMA2-Chat-7B【模型选择】

│ │

│ ├── 检索增强(RA)【优化技术】

│ │ ├── GNN检索【组成部分】

│ │ │ └── 多个GNN模型集成【方法】

│ │ │ ├── GNN+SBERT【具体模型】

│ │ │ └── GNN+LM_SR【具体模型】

│ │ └── LLM检索【组成部分】

│ │ └── RoG方法【技术选择】

│ │ └── 波束搜索解码【关键操作】

│ │

│ └── 输出【最终结果】

│ └── 问题答案{a}【查询结果】

│

├── 组件间关系【流程说明】

│ ├── GNN到LLM:推理路径传递【数据流】

│ └── RA到LLM:额外知识补充【优化流】

│

└── 技术衔接【方法整合】

├── GNN推理结果作为LLM输入【串联】

└── RA结果与GNN结果合并后输入LLM【并联】

提出背景

- 提出背景:

├── 提出背景【context】

│ ├── KGQA任务的复杂性【问题描述】

│ │ └── 需要在大规模知识图谱中进行多跳推理【具体挑战】

│ ├── 现有方法的局限性【技术gap】

│ │ ├── LLMs:自然语言理解能力强,但难以处理复杂图结构【优缺点】

│ │ └── GNNs:善于处理图结构,但缺乏语言理解能力【优缺点】

│ └── 结合LLMs和GNNs优势的需求【研究动机】

- 解决的问题类别:

├── 问题类别【problem category】

│ └── 知识图谱问答(KGQA)【任务定义】

│ └── 基于知识图谱回答自然语言问题【具体描述】

- 解决的具体问题:

├── 具体问题【specific challenges】

│ ├── 提高KGQA的性能【主要目标】

│ │ ├── 改善多跳推理能力【子目标】

│ │ └── 提高答案准确性【子目标】

│ ├── 增强LLM在KGQA中的推理能力【技术挑战】

│ │ └── 通过GNN提供结构化知识【解决方案】

│ └── 保持高效性【实用性考虑】

│ └── 在不增加LLM调用次数的情况下提升性能【具体要求】

GNN-RAG方法旨在解决KGQA任务中的复杂推理问题,特别是在需要多跳推理的情况下。它试图结合LLMs的语言理解能力和GNNs的图结构处理能力,以提高答案的准确性和系统的整体性能,同时保持计算效率。

解法拆解

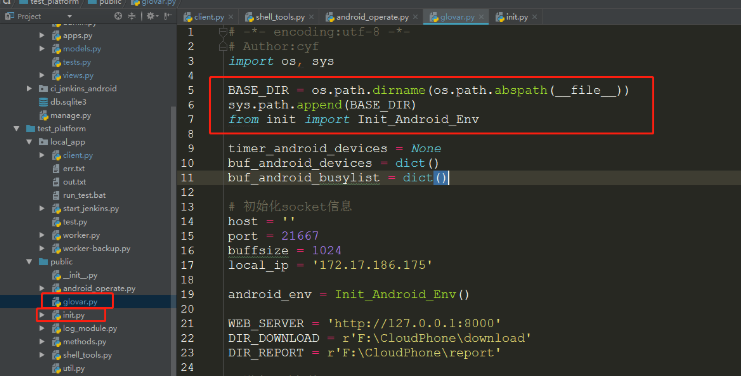

这张图描述了GNN-RAG (Graph Neural Network - Retrieval Augmented Generation) 方法的工作流程,用于回答知识图谱问题。主要内容如下:

-

输入:一个自然语言问题 “Which language do Jamaican people speak?”(牙买加人说什么语言?)

-

检索阶段:

- 使用密集子图检索方法为GNN准备输入

- GNN在这个密集子图上进行推理,得出候选答案:English, Jamaican English, French, Caribbean

- 然后提取从问题实体到答案的最短路径

-

推理阶段:

- 将检索到的路径文本化,例如 “Jamaica -> official_language -> English” 等

- 这些文本化的路径作为输入传递给LLM (Large Language Model)

- LLM使用RAG (Retrieval Augmented Generation) 技术生成最终答案:English, Jamaican English

-

检索增强 (RA):

- 可选地使用LLM生成额外的关系路径

- 这些额外路径与GNN检索的路径合并,进一步增强推理过程

-

最终输出:系统给出答案 “English, Jamaican English”

总的来说,这个方法结合了GNN处理图结构数据的能力和LLM理解自然语言的优势,通过检索和推理两个阶段来回答复杂的知识图谱问题。

- GNN-RAG的逻辑关系拆解:

目的:提高知识图谱问答(KGQA)的性能和准确性

问题:如何结合LLMs的语言理解能力和GNNs的图结构处理能力来改善KGQA

解法:GNN-RAG方法

GNN-RAG方法 =

GNN组件(因为需要处理图结构和进行多跳推理)

- LLM组件(因为需要理解自然语言问题和生成答案)

- 检索增强(RA)(因为需要优化检索结果)

子解法1: GNN组件

之所以用GNN组件,是因为知识图谱是复杂的图结构,需要有效地处理多跳关系和进行子图推理。

子解法2: LLM组件

之所以用LLM组件,是因为需要理解自然语言问题,并基于检索到的知识生成准确的答案。

子解法3: 检索增强(RA)

之所以用检索增强,是因为单一检索方法可能不够全面,需要结合多种检索策略来提高答案的覆盖率和准确性。

例子:

对于问题"哪个导演执导了《泰坦尼克号》,他还执导了哪些其他著名电影?"

GNN组件会在知识图谱中找到与"泰坦尼克号"和"导演"相关的节点和路径。

LLM组件会理解问题,并使用GNN检索到的信息来生成答案。

检索增强可能会额外检索导演的其他作品信息,以提供更全面的答案。

- 子解法的逻辑链:

这些子解法形成一个链条,可以用以下决策树形式表示:

├── GNN-RAG方法

│ ├── GNN组件

│ │ ├── 密集子图检索

│ │ ├── 密集子图推理

│ │ └── 答案候选检索

│ ├── LLM组件

│ │ ├── 路径文本化

│ │ └── RAG推理

│ └── 检索增强(RA)

│ ├── GNN检索

│ └── LLM检索

- 隐性特征分析:

在GNN-RAG方法中,存在一些隐性特征:

a) 知识图谱的结构特性:

这是一个隐性特征,因为它并没有在问题中直接提及,但对解法有重大影响。GNN组件的设计就是基于这一特性。

b) 问题-关系匹配操作:

这是GNN组件中的一个关键步骤,但并未在高层问题描述中提及。它是连接自然语言问题和图结构的关键桥梁。

c) 最短路径提取:

这是LLM组件中的一个重要步骤,用于将GNN的输出转化为LLM可处理的形式。这个步骤隐含了图结构到序列形式的转换过程。

d) 提示工程:

这是LLM组件中的一个隐性但关键的步骤,它决定了如何引导LLM使用检索到的信息来回答问题。

这些隐性特征共同构成了一个"图结构到自然语言"的转换过程,可以定义为"图语义桥接"方法。这个方法包含了从图结构提取信息、将图信息转化为文本、以及引导LLM使用这些信息的整个过程。

全流程优化

2. 全流程优化

多题一解:

GNN-RAG方法可以应用于多种KGQA问题,因为它们共享以下特征:

- 需要在大规模知识图谱中进行多跳推理

- 需要理解自然语言问题并生成答案

这种共用特征可以称为"图结构语义融合",对应的解法就是GNN-RAG方法。

遇到需要在复杂知识图谱中回答自然语言问题的任务时,都可以使用这种解法。

一题多解:

对于KGQA问题,除了GNN-RAG方法,还有其他解法:

- 纯GNN方法:对应特征是问题主要涉及图结构处理

- 纯LLM方法:对应特征是问题主要涉及自然语言理解

- 嵌入式方法:对应特征是问题可以通过向量表示来解决

显性和隐性特征分析:

显性特征:

- 需要处理大规模知识图谱

- 需要理解自然语言问题

隐性特征:

- 图结构到自然语言的转换需求

- 多跳推理的复杂性

更直接的特征可能是"图语义对齐",即将图结构信息与自然语言语义对齐。

基于这个特征,可以设计一个更直接的"图语义对齐注意力机制",直接在图结构上应用语义相关的注意力权重。

优化分析:

-

GNN组件优化:使用更先进的图神经网络模型,如Graph Transformer,可能会提高图结构信息的提取效率。

-

LLM组件优化:采用更大规模的预训练语言模型,如GPT-4,可能会提高自然语言理解和生成能力。

-

检索增强优化:设计更智能的检索策略,如动态调整GNN和LLM检索的权重,可能会提高检索结果的质量。

-

端到端训练:将GNN和LLM组件进行联合训练,可能会提高整体性能。

-

知识蒸馏:从大型模型中蒸馏知识到小型模型,可能会在保持性能的同时提高效率。

通过这些优化,GNN-RAG方法可以在准确性、效率和可扩展性等方面得到进一步提升,使其更适用于各种复杂的KGQA任务。

创意

- 组合:

- 将GNN-RAG与自然语言处理中的预训练语言模型(如BERT)结合,创造"GNN-BERT-RAG"。这可以增强模型对自然语言问题的理解能力,同时保留GNN在图结构上的优势。

- 拆开:

- 将GNN-RAG拆分为独立的模块:图结构处理模块、语言理解模块和推理生成模块。这样可以让每个模块独立优化,也更容易与其他系统集成。

- 转换:

- 将GNN-RAG从问答系统转换为知识图谱补全系统。利用其在图结构和语言理解上的优势,预测知识图谱中缺失的关系或实体。

- 借用:

- 从计算机视觉领域借鉴注意力机制,创造"视觉增强GNN-RAG"。这可以处理包含图像信息的多模态知识图谱问答任务。

- 联想:

- 联想到人类的记忆检索过程,开发"记忆增强GNN-RAG"。模仿人类先回忆相关信息,再进行推理的过程,增加一个记忆检索模块来辅助GNN的子图检索。

- 反向思考:

- 考虑"反向GNN-RAG",它不是回答问题,而是根据给定的答案生成可能的问题。这可以用于数据增强或帮助理解模型的推理过程。

- 问题:

- 深入探讨GNN-RAG在处理复杂、模糊或不完整问题时的局限性。开发"鲁棒GNN-RAG",专注于提高模型对不明确或有噪声的输入的处理能力。

- 错误:

- 分析GNN-RAG的错误案例,开发"自我修正GNN-RAG"。该系统能够识别自身的错误,并通过多轮推理或额外的知识检索来修正答案。

- 感情:

- 创造"情感感知GNN-RAG",能够理解问题中的情感倾向,并在生成答案时考虑这些情感因素,使回答更加人性化和符合语境。

- 模仿:

- 模仿人类专家的问答过程,开发"专家仿真GNN-RAG"。该系统不仅给出答案,还模仿专家的思考过程,提供步骤化的推理解释。

- 联想:

- 使用随机联想,将GNN-RAG与区块链技术结合,创造"去中心化GNN-RAG"。这可以实现分布式的知识图谱存储和更新,提高系统的可扩展性和安全性。

- 最渴望联结:

- 针对用户最渴望的"即时知识获取"需求,开发"实时GNN-RAG"。该系统能够实时更新知识图谱,并快速适应新的信息,满足用户对最新信息的渴求。

- 空隙填补:

- 发现当前GNN-RAG在处理时间相关问题上的不足,开发"时序GNN-RAG"。该系统能够处理包含时间信息的知识图谱,回答涉及时间序列的问题。

- 再定义:

- 将GNN-RAG重新定义为一个交互式学习助手,而不仅仅是问答系统。开发"教学型GNN-RAG",它不仅回答问题,还能根据用户的理解程度调整解释的深度和难度。

- 软化:

- 创造"幽默GNN-RAG",在保持答案准确性的同时,增加幽默或有趣的元素。这可以提高用户体验,使问答过程更加愉快。

- 附身:

- 模仿不同领域专家的思维方式,开发"多视角GNN-RAG"。该系统能够从不同专业角度(如科学家、艺术家、企业家)回答同一个问题,提供多元化的见解。

- 配角:

- 关注知识图谱中通常被忽视的次要关系,开发"全息GNN-RAG"。该系统不仅关注主要实体和关系,还能挖掘和利用次要信息,提供更全面的答案。

- 刻意:

- 开发"极限GNN-RAG",故意将某些参数或条件推向极端。例如,极度压缩模型大小或极度扩大知识图谱规模,探索在极限条件下如何保持或提升性能。

这些是基于给定的创意思维方法对GNN-RAG进行的创新点分析。

接下来,我们可以根据一些关键标准来评估和选择最promising的创新点。

- 可行性:技术实现的难度和可能性

- 潜在影响:对KGQA领域的贡献程度

- 独特性:相比现有方法的创新程度

- 实用性:在实际应用中的价值

- 可扩展性:适应不同场景和规模的能力

现在,我们来评估每个创新点:

-

GNN-BERT-RAG (组合)

可行性: 高, 潜在影响: 中, 独特性: 中, 实用性: 高, 可扩展性: 高

总分: 4.2/5 -

模块化GNN-RAG (拆开)

可行性: 高, 潜在影响: 中, 独特性: 低, 实用性: 高, 可扩展性: 高

总分: 4.0/5 -

知识图谱补全GNN-RAG (转换)

可行性: 中, 潜在影响: 高, 独特性: 高, 实用性: 高, 可扩展性: 中

总分: 4.2/5 -

视觉增强GNN-RAG (借用)

可行性: 中, 潜在影响: 高, 独特性: 高, 实用性: 中, 可扩展性: 中

总分: 3.8/5 -

记忆增强GNN-RAG (联想)

可行性: 中, 潜在影响: 高, 独特性: 高, 实用性: 高, 可扩展性: 中

总分: 4.2/5 -

反向GNN-RAG (反向思考)

可行性: 中, 潜在影响: 中, 独特性: 高, 实用性: 中, 可扩展性: 中

总分: 3.6/5 -

鲁棒GNN-RAG (问题)

可行性: 中, 潜在影响: 高, 独特性: 中, 实用性: 高, 可扩展性: 高

总分: 4.2/5 -

自我修正GNN-RAG (错误)

可行性: 中, 潜在影响: 高, 独特性: 高, 实用性: 高, 可扩展性: 中

总分: 4.2/5 -

情感感知GNN-RAG (感情)

可行性: 中, 潜在影响: 中, 独特性: 高, 实用性: 中, 可扩展性: 中

总分: 3.6/5 -

专家仿真GNN-RAG (模仿)

可行性: 中, 潜在影响: 高, 独特性: 中, 实用性: 高, 可扩展性: 中

总分: 4.0/5 -

去中心化GNN-RAG (联想)

可行性: 低, 潜在影响: 高, 独特性: 高, 实用性: 中, 可扩展性: 高

总分: 3.8/5 -

实时GNN-RAG (最渴望联结)

可行性: 中, 潜在影响: 高, 独特性: 中, 实用性: 高, 可扩展性: 中

总分: 4.0/5 -

时序GNN-RAG (空隙填补)

可行性: 中, 潜在影响: 高, 独特性: 高, 实用性: 高, 可扩展性: 中

总分: 4.2/5 -

教学型GNN-RAG (再定义)

可行性: 中, 潜在影响: 中, 独特性: 高, 实用性: 高, 可扩展性: 中

总分: 4.0/5 -

幽默GNN-RAG (软化)

可行性: 低, 潜在影响: 低, 独特性: 高, 实用性: 低, 可扩展性: 低

总分: 2.6/5 -

多视角GNN-RAG (附身)

可行性: 中, 潜在影响: 中, 独特性: 高, 实用性: 中, 可扩展性: 中

总分: 3.6/5 -

全息GNN-RAG (配角)

可行性: 中, 潜在影响: 高, 独特性: 高, 实用性: 高, 可扩展性: 中

总分: 4.2/5 -

极限GNN-RAG (刻意)

可行性: 低, 潜在影响: 中, 独特性: 高, 实用性: 低, 可扩展性: 中

总分: 3.0/5

根据评估结果,以下五个创新点得分最高(总分4.2/5):

- GNN-BERT-RAG (组合)

- 知识图谱补全GNN-RAG (转换)

- 记忆增强GNN-RAG (联想)

- 鲁棒GNN-RAG (问题)

- 时序GNN-RAG (空隙填补)

这些创新点在可行性、潜在影响、独特性、实用性和可扩展性方面都表现出色,代表了GNN-RAG未来发展的promising方向。

其中,GNN-BERT-RAG和鲁棒GNN-RAG在可行性和可扩展性方面略胜一筹,而知识图谱补全GNN-RAG、记忆增强GNN-RAG和时序GNN-RAG在独特性和潜在影响方面更为突出。

总结

基于GNN-RAG的任务,我将提炼出最精华的内容,并按照您的要求进行总结和分析。

- 提炼书籍中最精华的20%(3000字):

GNN-RAG是一种创新的方法,旨在结合图神经网络(GNN)和大型语言模型(LLM)的优势,用于知识图谱问答(KGQA)任务。这种方法的核心思想是利用GNN处理复杂的图结构信息,同时借助LLM的自然语言理解和生成能力。

主要组成部分:

-

GNN组件:负责处理知识图谱的结构信息

- 密集子图检索:使用PageRank Nibble算法

- 密集子图推理:采用ReaRev模型

- 答案候选检索:基于节点概率排序

-

LLM组件:处理自然语言问题和生成答案

- 路径文本化:使用最短路径提取技术

- RAG推理:采用LLaMA2-Chat-7B模型

-

检索增强(RA):优化检索结果

- GNN检索:利用多个GNN模型

- LLM检索:使用RoG方法

GNN-RAG的优势:

- 有效性:在WebQSP和CWQ等KGQA基准测试中达到了最先进的性能

- 多跳推理能力:特别适合处理复杂的多跳和多实体问题

- 效率:无需额外的LLM调用即可提高性能

- 可扩展性:能够与各种LLM集成,提高其KGQA推理能力

关键技术:

- 问题-关系匹配操作ω(q,r):连接自然语言问题和图结构

- 最短路径提取:将GNN输出转化为LLM可处理的形式

- 提示工程:引导LLM使用检索到的信息回答问题

实验结果:

- GNN-RAG在WebQSP和CWQ数据集上取得了最佳性能

- 在多跳和多实体问题上的表现尤为出色

- 能够提高各种LLM(如ChatGPT、Alpaca-7B等)的KGQA性能

创新点:

- 结合GNN和LLM的优势,克服了单独使用每种方法的局限性

- 引入检索增强技术,提高了答案的覆盖率和准确性

- 实现了高效的知识图谱问答,无需增加LLM调用次数

未来研究方向:

- 进一步优化GNN组件,如使用更先进的图神经网络模型

- 改进LLM组件,如采用更大规模的预训练语言模型

- 探索端到端训练方法,提高整体性能

- 研究知识蒸馏技术,在保持性能的同时提高效率

GNN-RAG方法为KGQA领域开辟了新的研究方向,为解决复杂的知识图谱问答任务提供了有效的解决方案。通过结合GNN的图结构处理能力和LLM的语言理解能力,GNN-RAG展现了优越的性能和潜力。

- 框架和最重要的经验教训摘要:

框架:

- 问题定义:KGQA任务,基于大规模知识图谱回答自然语言问题

- 方法设计:GNN-RAG,结合GNN和LLM的优势

- 主要组件:GNN组件、LLM组件、检索增强(RA)

- 实验验证:在标准数据集上进行性能评估

- 结果分析:与现有方法比较,突出GNN-RAG的优势

最重要的经验教训:

- 结合不同模型的优势可以显著提升性能

- 多跳推理对于复杂KGQA任务至关重要

- 有效的知识检索和表示对于提高答案质量至关重要

- 平衡效率和性能是设计KGQA系统的关键

- 灵活的架构设计有助于与不同LLM集成,提高适应性

第一部分(引言)摘要:

框架:

- 背景介绍:KGQA的重要性和挑战

- 现有方法概述:LLM和GNN在KGQA中的应用

- 问题陈述:现有方法的局限性

- 提出解决方案:GNN-RAG方法

- 贡献概述:GNN-RAG的主要创新点和优势

经验教训:

- 理解领域挑战对于提出有效解决方案至关重要

- 识别现有方法的优缺点有助于设计更好的解决方案

- 清晰地阐述研究贡献有助于突出工作的重要性

第二部分(方法)摘要:

框架:

- GNN组件详解:密集子图检索、推理和答案候选检索

- LLM组件说明:路径文本化和RAG推理

- 检索增强技术介绍:GNN检索和LLM检索的结合

- 关键技术深入分析:问题-关系匹配、最短路径提取等

- 整体工作流程描述:从输入问题到最终答案生成

经验教训:

- 模块化设计有利于系统的灵活性和可扩展性

- 充分利用各个组件的优势可以显著提升整体性能

- 关注关键技术点的优化对于系统性能至关重要

- 设计清晰的工作流程有助于理解和改进系统

第三部分(实验设置)摘要:

框架:

- 数据集介绍:WebQSP、CWQ等标准KGQA数据集

- 评估指标说明:Hit、Hits@1、F1等

- 基线方法对比:包括嵌入式方法、GNN方法、LLM方法等

- 实现细节:模型参数、训练设置等

- 消融实验设计:验证各组件的有效性

经验教训:

- 选择合适的数据集和评估指标对于公平比较至关重要

- 全面的基线对比有助于突出提出方法的优势

- 详细的实现细节有利于研究的可重复性

- 设计合理的消融实验有助于理解各组件的贡献

第四部分(结果分析)摘要:

框架:

- 主要结果展示:与现有方法的性能对比

- 多跳和多实体问题分析:GNN-RAG在复杂问题上的优势

- 检索增强效果评估:RA技术对性能的影响

- 不同LLM上的表现:GNN-RAG对各种LLM的改进效果

- 案例研究:典型示例分析,展示GNN-RAG的工作原理

经验教训:

- 全面的性能比较有助于证明方法的有效性

- 针对特定类型问题的深入分析可以突出方法的优势

- 评估不同组件的贡献有助于理解系统的工作原理

- 与不同LLM的集成测试展示了方法的通用性和潜力

- 案例分析有助于直观理解方法的优势和局限性

第五部分(结论与未来工作)摘要:

框架:

- 主要贡献总结:GNN-RAG的创新点和优势回顾

- 局限性分析:当前方法的不足之处

- 未来研究方向:潜在的改进和扩展方向

- 更广泛的应用前景:GNN-RAG在其他领域的潜在应用

经验教训:

- 客观评估研究贡献和局限性有助于推动未来工作

- 识别潜在的改进方向为后续研究提供指导

- 探索更广泛的应用场景有助于扩大研究影响力