1.ETL选型前言

市面上ETL工具国内外加起来估计得有30种之多,其中近20款工具都花时间试用过,现在把试用后总结出来的经验分享一下,目前很多企业在选择ETL工具时不知道怎么选择适合自己的工具也不可能一款一款的去试用,试用成本非常高,而且不同企业数据量,对数据质量的要求,技术开发人员的水平都不一样,所以在选择时往往比较迷茫,没有开发实力的企业希望选择一款无代码简单拖拉就能完成数据清洗的ETL工具,但有开发力量的企业又希望选择一款具有二次扩展能力的ETL工具可以实现个性化的定制加快任务开发效率,企业在第一次选择ETL工具时只需要试用完下面三款就可以了,因为这三款代表了目前市场上最好的ETL工具和解决方案,如果这三款不行再去找那些小众的ETL工具去试用,下面简单介绍一下这三款工具,感兴趣的可以自己去下载试用,都有免费社区版本的。

2.第一款使用最广泛-Kettle

Kettle,作为ETL(Extract, Transform, Load)领域使用最广的ETL工具,无疑是众多企业在进行数据集成与分析时必须要考虑的工具之一,其强大的功能和广泛的应用场景,使得寻找具备Kettle运维技能的工程师对企业而言并非难事。作为一款源自国外的免费开源ETL工具,Kettle不仅推动了数据处理的便捷性,还以其独特的优势在业界赢得了广泛的认可,其实国内很多大数据公司的ETL工具都是在kettle上面进行包装后进行售卖的。

优点分析:

-

直观易用的图形化界面:Kettle通过其直观的拖放式图形界面,极大地简化了数据集成流程的设计过程。这种可视化开发方式不仅降低了技术门槛,使得非专业开发人员也能快速上手,还显著提高了开发效率,让数据流转更加顺畅。

-

功能全面的转换组件:内置了丰富的转换步骤和功能模块,能够覆盖从数据清洗、过滤、转换到合并等全方位的数据处理需求。无论是简单的字符串操作、日期格式化,还是复杂的聚合计算、条件逻辑判断,Kettle都能轻松应对,满足各类复杂的数据转换场景。

缺点分析:

-

Kettle的学习曲线非常陡峭:尽管Kettle的图形化界面降低了使用门槛,但其背后蕴含的数据处理逻辑和概念对于初学者而言仍需一定时间来掌握。特别是在处理复杂的数据转换任务时,用户需要具备一定的数据处理和编程基础,以便更有效地利用Kettle的强大功能。

-

文档资源有限:相较于部分国内ETL工具,Kettle在国内的中文文档和社区支持相对匮乏。这在一定程度上增加了用户在学习和使用过程中遇到问题时自我解决的难度,需要用户具备更强的自学能力和研究精神。

-

实时数据处理能力受限:Kettle原生并不直接支持CDC(Change Data Capture)实时数据采集功能,这意味着在需要实时传输大量数据的场景下,用户可能需要通过增加任务调度频率(如每分钟执行一次)来模拟实时效果。然而,这种方法在高数据量的生产环境中可能会给系统带来较大的压力,影响整体性能和稳定性。因此,在追求实时性的项目中,可能需要考虑结合其他技术或工具来弥补这一不足。

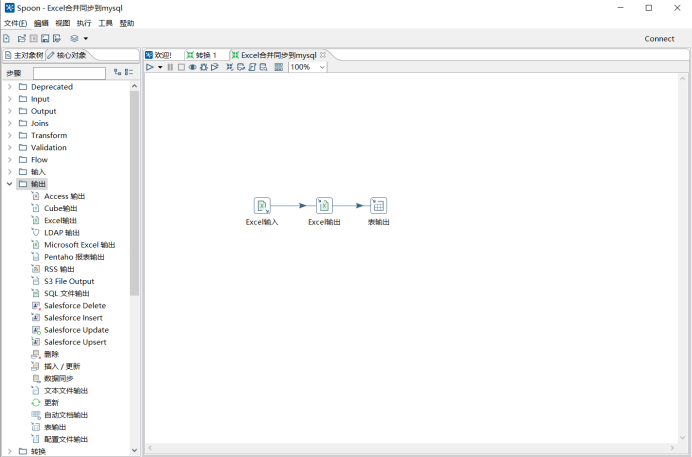

系统安装后界面如下:

(作为开源软件,可以直接从官方网站下载Kettle)

3.第二款国内对标kettle的ETLCloud

ETLCloud可以说是国内第一款在功能上可以对标kettle的ETL工具了,其在功能设计和使用体验上避免了很多kettle的缺点,同时也进行了大量的创新使得ETL的使用门槛更低了,在功能易用性上也比kettle要易于使用。ETLCloud,作为一款集实时数据同步、离线数据处理及流程全面监控于一体的国产数据集成平台,不仅展现了强大的技术实力,还以其易用性和本土化优势在众多国外ETL工具中脱颖而出。该平台分为社区版和商业收费版,其中社区版免费开放可以免费下载使用。

优点解析:

-

国产数据源支持:ETLCloud能够无缝对接多种国产数据源,通用协议、消息队列、文件、平台系统等,如果有国产数据库使用ETLCloud要比kettle好很多。

-

支持CDC实时数据采集是最大的亮点:ETLCloud内置了CDC实时数据采集能力,这个是很多ETL工具不具备的。

-

WEB可视化配置界面:ETLCloud通过WEB平台提供了直观易用的可视化配置界面,大大降低了数据集成流程的设计难度。同时,统一的运维平台使得运维管理更加便捷高效,提升了整体的数据处理能力。

-

丰富的社区资源与技术支持:作为本土化自研的数据集成产品,ETLCloud在社区中拥有庞大的用户群体和全面的技术文档。此外,其组件市场还提供了丰富的插件和工具,帮助用户快速实现与SASS应用的集成,进一步拓宽了数据应用的边界。

缺点探讨:

-

功能限制于社区版:虽然社区版免费且功能强大,但仍有部分高级功能需要升级到企业版才能使用。这可能会对一些有特定需求的企业用户造成一定的限制。

-

社区版本不支持二次定制开发,社区版本不能像kettle,datax一样进行个性化二次开发。

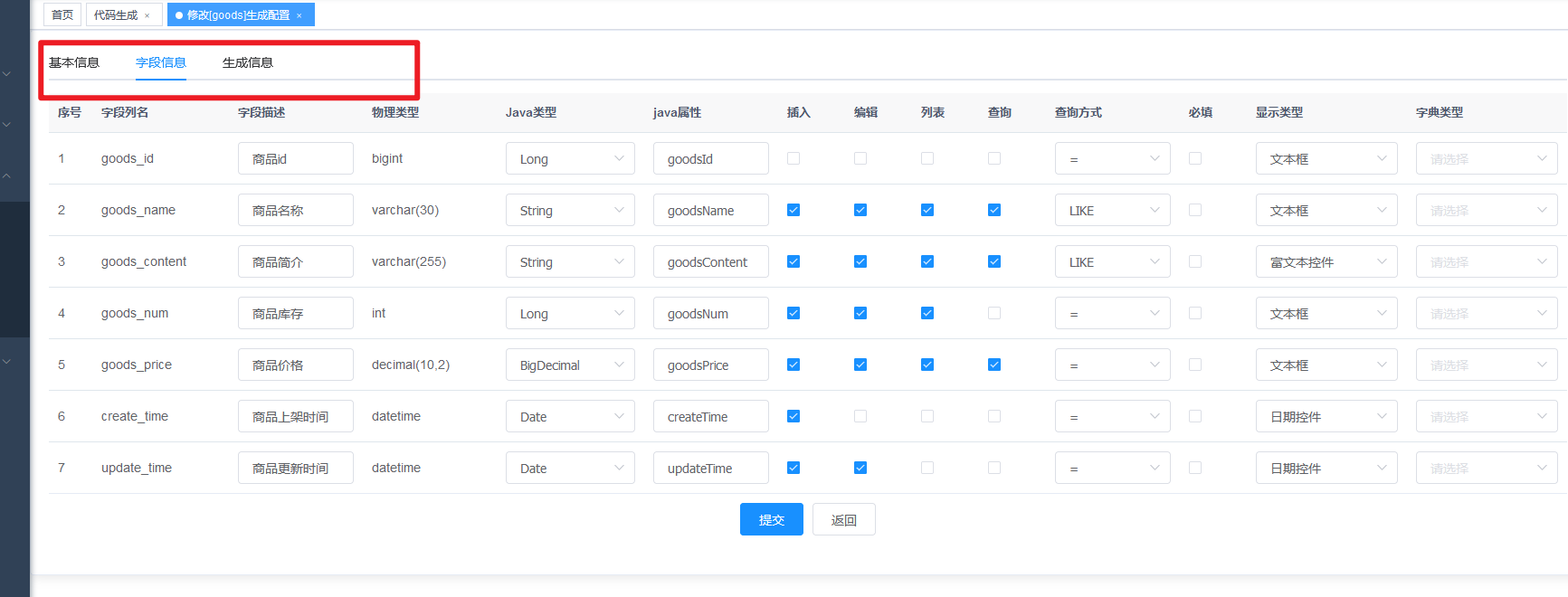

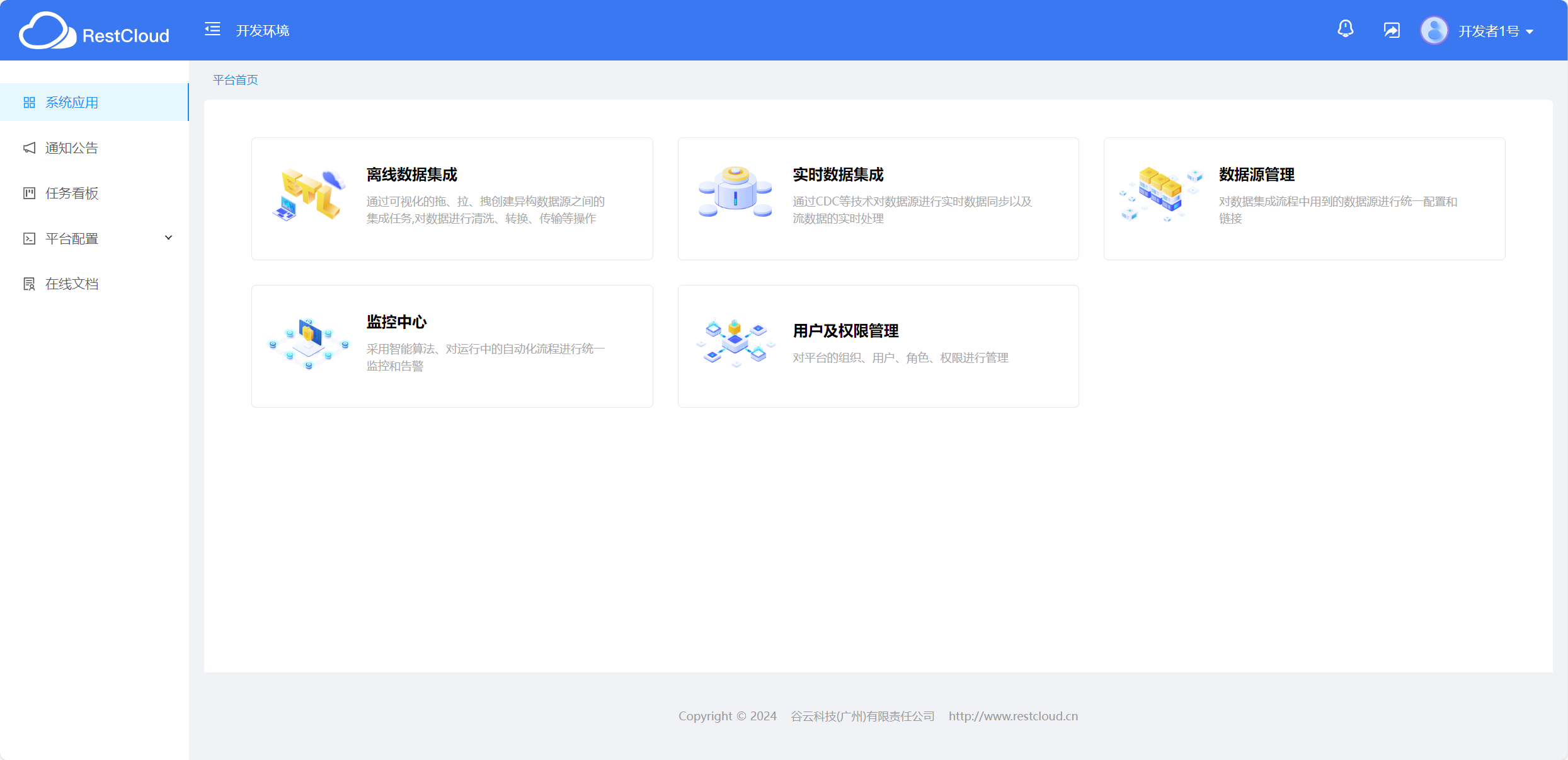

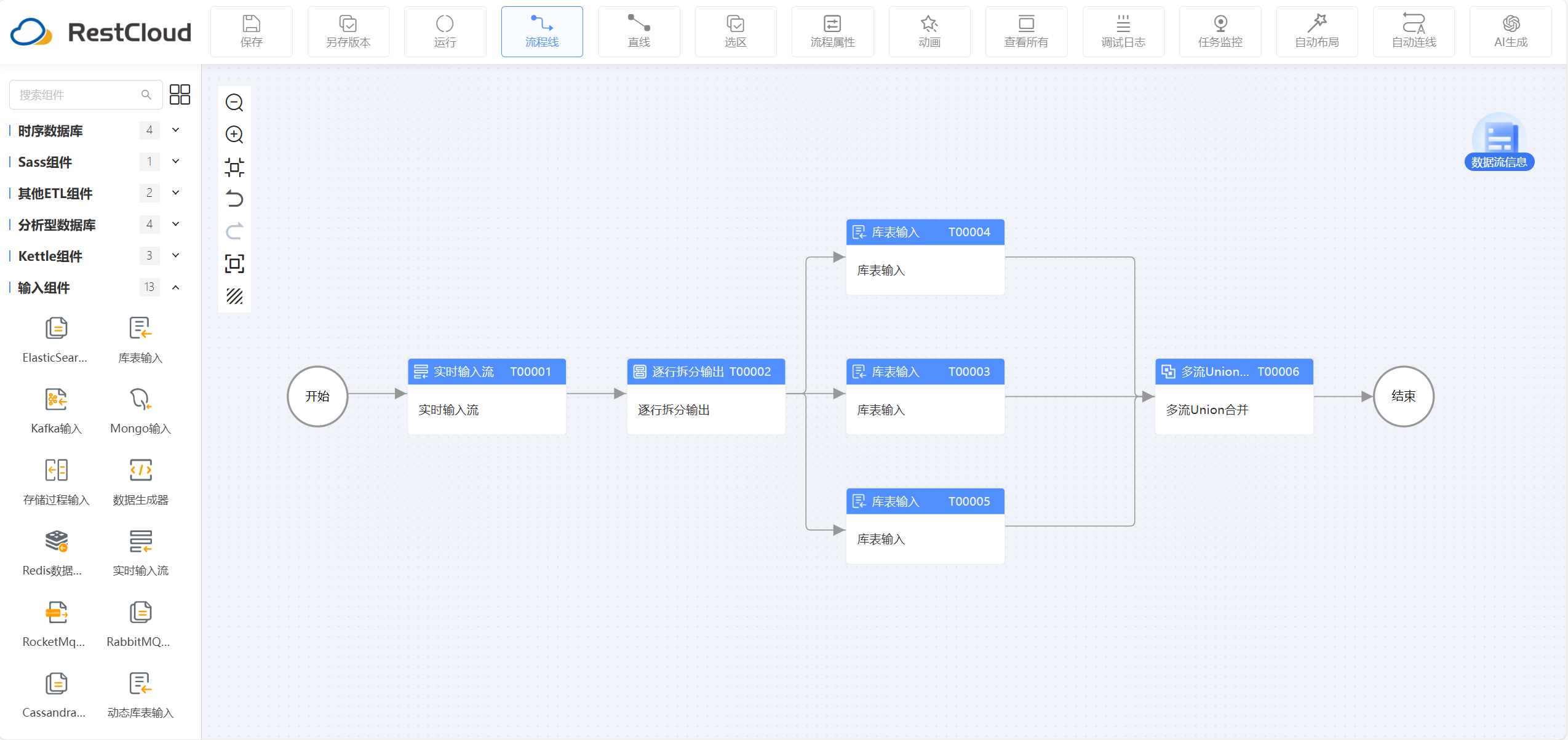

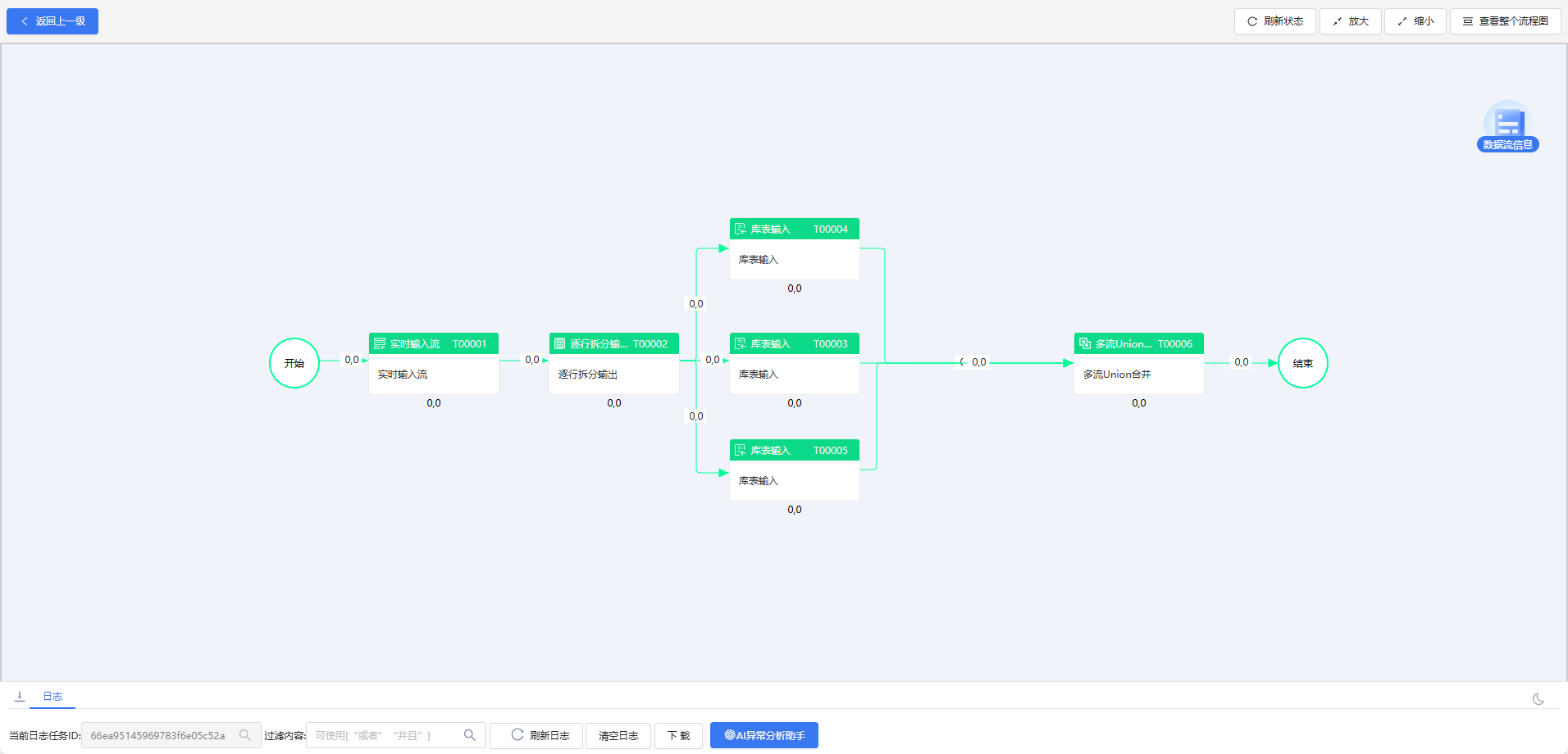

免费社区版本下载安装运行后界面如下:

流程设计界面

任务监控运行界面

4.第三款阿里开源的DataX

DataX严格来说是ELT而不是ETL,这里之所以把它放在ETL里面来推荐是因为很多企业只需要使用ELT就可以了,阿里商用的DataWorks其内核也是基于DataX来进行改造的,所以DataX针对有开发实力的技术人员是非常值得考虑的一款可扩展的ETL工具。

DataX作为一个大数据的ETL工具(ELT工具),除了提供数据快速复制搬迁功能之外,还提供了丰富数据转换的功能,能提供稳定高效的数据同步功能,下面是我对他的优缺点分析。

优点:

-

任务配置非常方便,使用json描述任务即可。

-

支持高速数据传输,适用于大规模数据处理场景。

-

运行稳定,数据传输速度快,可以高度定制进行二次开发。

缺点:

-

DataX是以脚本的方式执行任务的,需要完全吃透源码才可以调用,学习成本高。

-

缺少用户友好的界面,需要编写脚本进行配置,可视化监控和数据追踪能力不够完善,运维成本相对高。

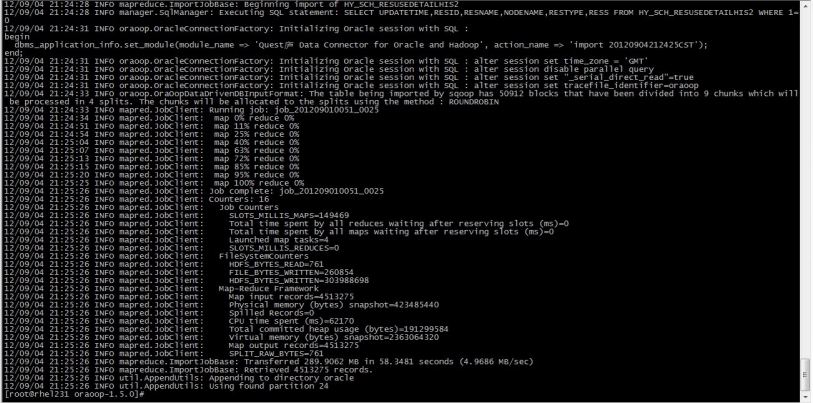

使用界面图:

5.选型经验总结:

-

如果想要数据清洗、转换功能强大的ETL只能选Kettle和ETLCloud;

-

如果只是做简单的大数据量传输的ELT首选DataX;

-

如果是软件企业想在上面做二次开发首选Kettle和DataX;

-

如果企业只想使用一款简单易用功能强大的ETL首选ETLCloud;

-

如果需要具备CDC实时数据集成功能保能选ETLCloud;

-

如果使用的是国产数据库为主的场景首选ETLCloud;

-

如果企业的业务主要是在国外则建议选国外的ETL工具使用SaaS版本就可以了,无需安装;

-

其实一个企业也可以几种工具共用,因为不同的场景使用不同的工具也很正常,前提条件是技术人员能够掌控这些工具的运维知识。