2024 半导体分析洞察:AI 硬件基础设施篇

一、引言

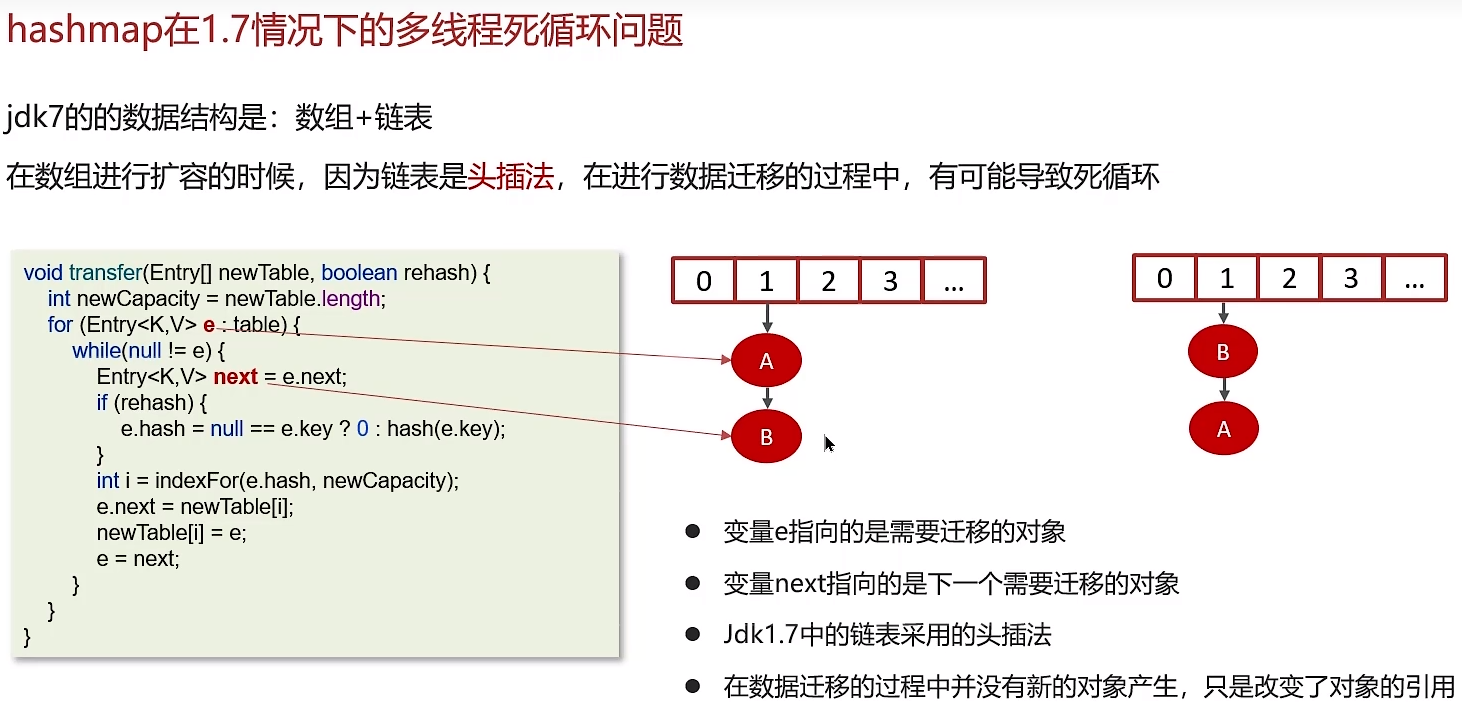

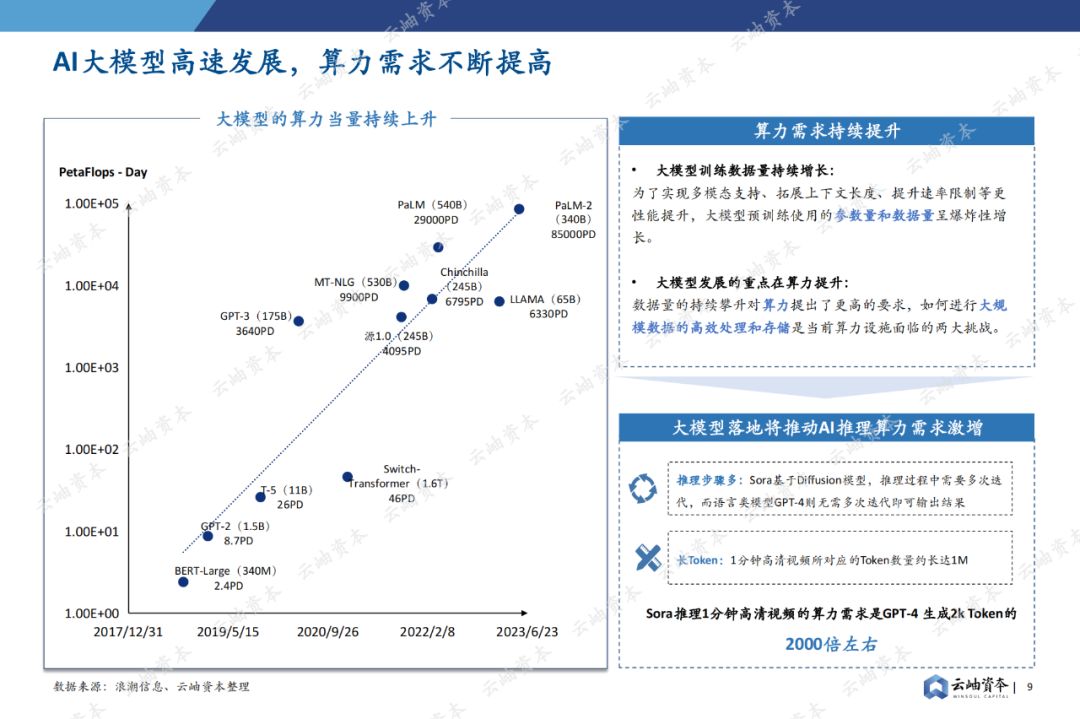

随着人工智能(AI)技术的飞速发展,AI 硬件基础设施在整个 AI 生态系统中的地位日益凸显。半导体作为 AI 硬件基础设施的核心组成部分,正面临着前所未有的机遇和挑战。2024 年,半导体在 AI 硬件基础设施方面展现出了多维度的发展态势,从芯片架构创新到制程工艺演进,从硬件加速技术到能效优化,各个方面都深刻影响着 AI 应用的发展和部署。

二、AI 芯片架构创新

(一)通用 GPU 架构的持续演进

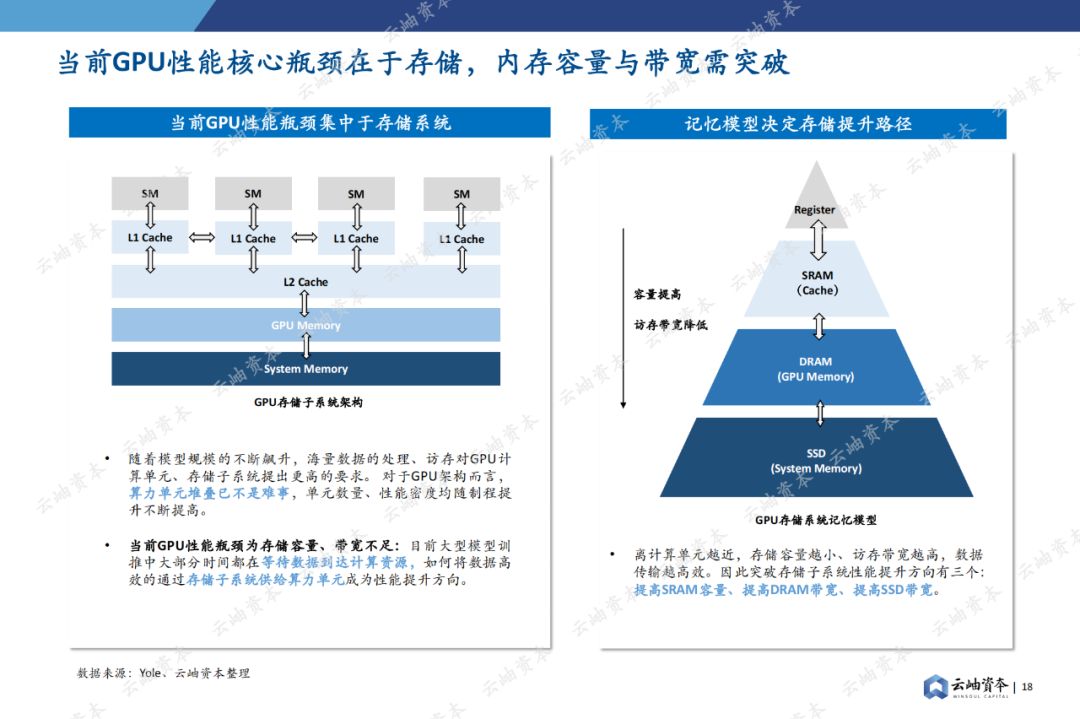

架构优化目标

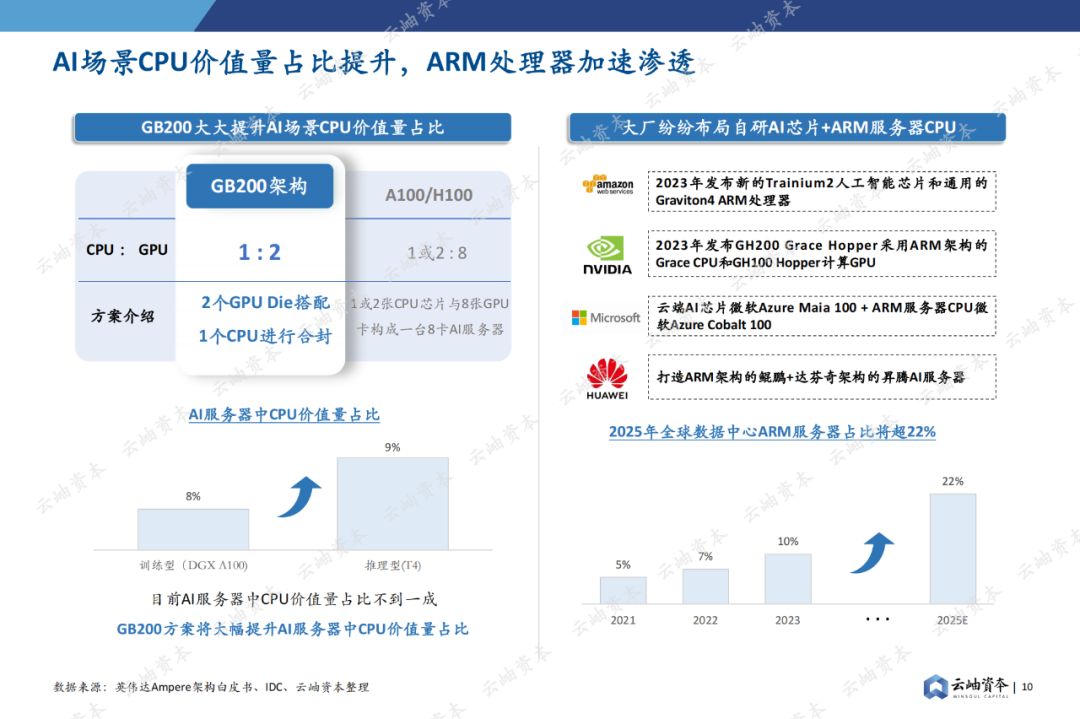

在 2024 年,通用 GPU(图形处理单元)在 AI 硬件基础设施中仍然占据重要地位。英伟达等主要厂商继续对 GPU 架构进行优化,以更好地满足 AI 计算需求。其优化目标主要集中在提高浮点运算性能、增强并行处理能力和优化内存访问效率等方面。

例如,新架构通过增加更多的 CUDA 核心数量、改进核心的运算逻辑以及优化核心之间的通信机制,来提升浮点运算速度。在并行处理方面,采用更高效的多线程调度算法,使得 GPU 能够同时处理更多的 AI 任务,如在大规模神经网络训练中的前向传播和反向传播计算。

对 AI 应用的支持

对于深度学习中的卷积神经网络(CNN)和循环神经网络(RNN),新的 GPU 架构提供了专门的计算优化。在图像识别、语音识别等领域,优化后的 GPU 能够加速模型的训练和推理过程。

以医疗影像分析为例,GPU 的高性能计算能力使得基于深度学习的疾病诊断模型能够在更短的时间内处理大量的影像数据,提高诊断效率和准确性。

(二)专用 AI 芯片架构的崛起

TPU 及类似架构

谷歌的 TPU(张量处理单元)及其类似的专用 AI 芯片架构在 2024 年得到了更广泛的应用和发展。TPU 架构专为处理张量运算而设计,这是深度学习计算中的核心运算类型。

与传统的 GPU 和 CPU 相比,TPU 具有更高的能效比。其架构特点包括高度定制化的矩阵乘法单元、优化的数据存储和传输机制以及专门针对深度学习算法的指令集。例如,在大规模语言模型的训练中,TPU 能够以较低的功耗完成大量的矩阵乘法运算,加速模型收敛速度。

神经形态芯片

神经形态芯片是一种模仿生物神经网络结构和功能的芯片。在 2024 年,这类芯片在某些特定的 AI 应用场景下开始崭露头角。

神经形态芯片的神经元和突触结构能够实现类似于生物大脑的信息处理方式。例如,在传感器网络中的边缘 AI 应用场景,如智能家居中的环境监测系统,神经形态芯片可以高效地处理来自多个传感器的实时数据,根据环境变化做出快速反应,同时消耗较少的能量。

三、半导体制程工艺演进

(一)先进制程的发展与挑战

3 纳米及以下制程

2024 年,半导体行业继续向 3 纳米及以下制程工艺进军。这些先进制程工艺能够在更小的芯片面积上集成更多的晶体管,从而提高芯片的性能和功能密度。

然而,3 纳米及以下制程面临着诸多挑战。例如,随着制程的缩小,量子隧穿效应等物理现象变得更加显著,导致晶体管漏电问题加剧。此外,制造工艺的复杂性和成本也大幅增加,需要更先进的光刻技术、更高纯度的材料以及更严格的制造环境控制。

制程工艺对 AI 芯片性能的影响

先进制程工艺对 AI 芯片性能有着直接的提升作用。更小的晶体管尺寸意味着更低的功耗和更高的工作频率,这对于 AI 芯片在处理大规模数据和复杂计算时至关重要。

例如,采用 3 纳米制程的 AI 芯片在相同功耗下能够提供更高的计算能力,使得深度神经网络的训练和推理能够在更短的时间内完成。这在数据中心的 AI 计算任务中,如大规模图像分类和自然语言处理任务的模型训练,能够显著提高效率。

(二)制程工艺的异构集成趋势

不同制程工艺的组合应用

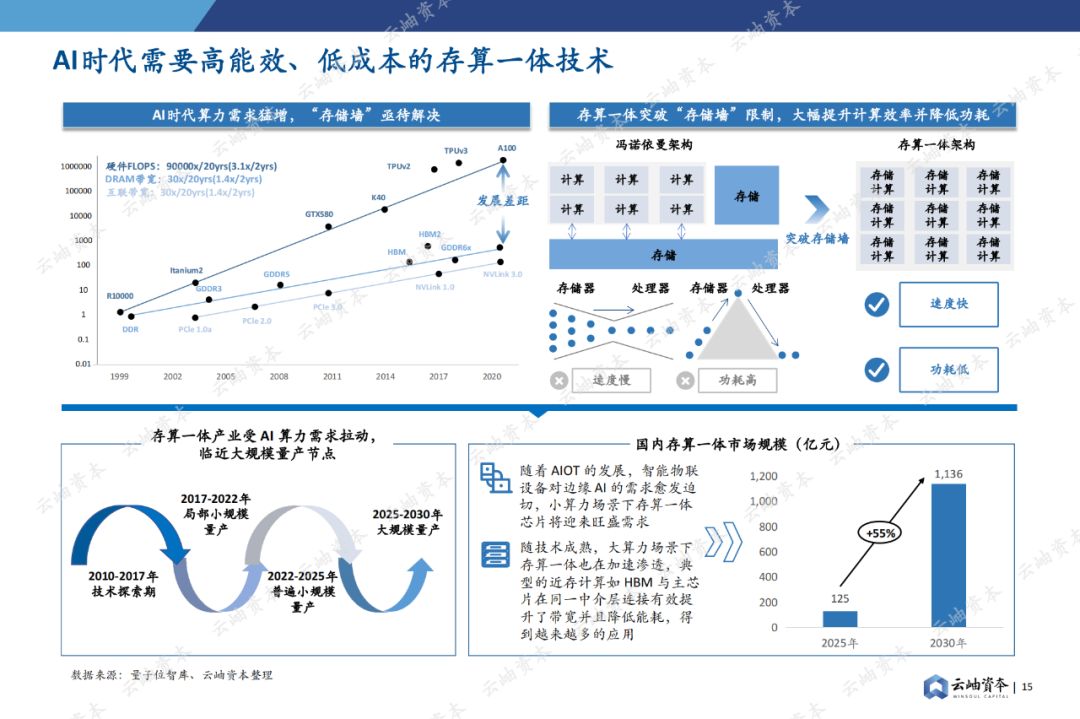

在 2024 年,异构集成成为半导体制程工艺的一个重要趋势。通过将不同制程工艺的芯片或模块集成在一起,可以充分发挥各自的优势。

例如,将采用先进制程工艺(如 3 纳米)制造的高性能计算核心与采用较成熟制程工艺(如 7 纳米)制造的存储模块集成在一个封装内。这样既可以利用先进制程核心的高性能计算能力,又可以利用成熟制程存储模块的高容量和稳定性,实现整体性能的提升。

异构集成在 AI 硬件中的优势

在 AI 硬件基础设施中,异构集成具有显著的优势。AI 计算通常需要大量的数据存储和快速的数据访问,异构集成可以优化芯片内部的存储层次结构。

例如,将高速缓存(Cache)和主存储器(DRAM)通过异构集成技术进行优化组合,可以减少数据访问延迟,提高 AI 芯片的整体能效。同时,异构集成还可以实现不同功能芯片(如 AI 计算芯片和通信芯片)之间的高效协同工作,提升 AI 系统在分布式计算和边缘计算场景下的性能。

四、AI 硬件加速技术

(一)硬件加速算法的发展

针对深度学习算法的优化

在 2024 年,针对深度学习算法的硬件加速算法不断发展。例如,对于卷积神经网络中的卷积层计算,新的硬件加速算法采用了快速傅里叶变换(FFT)等数学方法进行优化。

通过将卷积运算转化为频域的乘法运算,可以大大减少计算量。这种算法优化在 AI 硬件基础设施中的实现,能够显著提高 AI 芯片在图像识别、目标检测等应用中的计算效率。

稀疏计算加速技术

稀疏计算是指利用神经网络中存在大量稀疏连接的特点进行计算加速的技术。在 2024 年,稀疏计算加速技术得到了进一步的改进。

研究人员通过设计专门的硬件电路来识别和跳过神经网络中的零值权重,从而减少不必要的计算。这种技术在大型语言模型等具有稀疏性的神经网络中应用时,可以有效提高计算速度,降低能耗。

(二)硬件加速器的多样化

FPGA 在 AI 硬件加速中的应用

FPGA(现场可编程门阵列)在 2024 年仍然是 AI 硬件加速的重要选择之一。FPGA 的可编程性使其能够根据不同的 AI 应用需求进行定制化配置。

在工业自动化领域的 AI 应用中,如机器人视觉系统,FPGA 可以根据具体的图像处理算法进行编程,实现高速的图像特征提取和目标识别。与传统的 GPU 和专用 AI 芯片相比,FPGA 在灵活性和低延迟方面具有独特的优势。

ASIC 与其他加速器的协同工作

ASIC(专用集成电路)作为专门为特定 AI 应用设计的芯片,在 2024 年与其他加速器协同工作的模式逐渐发展起来。例如,在智能安防系统中,将 ASIC 芯片用于视频流中的目标检测等基本任务,而将 GPU 或 FPGA 用于更复杂的行为分析等任务。

这种协同工作模式可以充分发挥不同加速器的优势,提高整个 AI 系统的性能和效率,同时降低成本。

五、AI 硬件基础设施的能效优化

(一)能效比提升的重要性

数据中心的能耗挑战

在 2024 年,随着 AI 应用在数据中心的大规模部署,数据中心的能耗问题日益突出。AI 计算需要大量的电力支持,尤其是在大规模神经网络的训练过程中。

据统计,数据中心的能耗成本在运营成本中占据相当大的比例。提高 AI 硬件基础设施的能效比,对于降低数据中心的运营成本、减少对环境的影响以及实现可持续发展具有重要意义。

移动和边缘 AI 设备的续航需求

在移动和边缘 AI 设备方面,如智能手机、物联网传感器等,能效优化也是至关重要的。这些设备通常依靠电池供电,有限的电池容量限制了设备的使用时间。

例如,在智能手机中的 AI 语音助手应用,如果 AI 硬件的能效较低,将导致电池续航时间大幅缩短,影响用户体验。因此,提高 AI 硬件的能效比可以延长移动和边缘 AI 设备的续航时间,提高其市场竞争力。

(二)能效优化技术措施

动态电压和频率缩放(DVFS)

2024 年,动态电压和频率缩放技术在 AI 硬件基础设施中得到了更广泛的应用。DVFS 技术通过根据芯片的负载情况动态调整电压和频率,来降低功耗。

在 AI 芯片处于低负载状态(如在进行简单的推理任务时),可以降低电压和频率,从而减少功耗。而在高负载状态(如大规模神经网络训练时),则可以提高电压和频率以满足性能要求。这种动态调整可以在保证性能的前提下,有效降低芯片的平均功耗。

新型低功耗电路设计

新型低功耗电路设计是提高 AI 硬件能效的另一个重要方面。在 2024 年,研究人员开发了多种低功耗电路技术,如采用新型的晶体管结构和逻辑电路。

例如,一些基于隧道场效应晶体管(TFET)的电路设计,与传统的 CMOS 晶体管相比,具有更低的亚阈值摆幅,能够在低电压下实现高效的电流控制,从而降低电路功耗。这种低功耗电路设计在 AI 芯片的各个模块,如计算单元、存储单元等中得到应用,提高了整个 AI 芯片的能效比。

六、AI 硬件基础设施的安全性

(一)硬件安全威胁

硬件漏洞与攻击

在 2024 年,AI 硬件基础设施面临着多种硬件漏洞与攻击的威胁。例如,侧信道攻击可以通过分析芯片在运行过程中的功耗、电磁辐射等物理信息,获取芯片内部的敏感数据,如加密密钥等。

另外,硬件木马也是一种潜在的威胁。恶意攻击者可能在芯片制造过程中植入硬件木马,在特定条件下激活,从而篡改芯片的运行逻辑,导致 AI 系统出现错误的计算结果或泄露敏感信息。

供应链安全风险

随着全球半导体供应链的日益复杂,供应链安全风险对 AI 硬件基础设施的安全构成了挑战。在 2024 年,部分关键半导体原材料和零部件的供应可能受到地缘政治、贸易摩擦等因素的影响。

此外,在芯片的设计、制造、封装和测试等环节中,如果某个环节的安全性得不到保障,就可能导致芯片被植入恶意代码或存在安全漏洞,从而影响 AI 硬件基础设施的安全性。

(二)安全防护措施

硬件安全设计技术

为了应对硬件安全威胁,2024 年的 AI 硬件基础设施采用了多种硬件安全设计技术。例如,采用物理不可克隆函数(PUF)技术,利用芯片制造过程中的工艺偏差生成唯一的标识符,用于芯片的身份认证和加密密钥生成。

同时,采用硬件隔离技术,将 AI 芯片中的敏感区域(如存储加密密钥的区域)与其他区域进行物理隔离,防止恶意攻击获取敏感信息。这些硬件安全设计技术从芯片的底层结构上提高了 AI 硬件基础设施的安全性。

安全供应链管理

在供应链管理方面,2024 年的企业更加重视安全供应链的构建。通过与可靠的供应商建立长期合作关系,对原材料和零部件进行严格的安全检测和认证,确保芯片制造过程中的各个环节安全可靠。

例如,在芯片的封装和测试环节,采用安全的封装技术防止芯片被篡改,并对测试设备和环境进行安全监控,防止恶意代码注入等安全风险。

七、AI 硬件基础设施的市场格局与发展趋势

(一)主要厂商竞争态势

英伟达的市场主导地位与竞争压力

在 2024 年,英伟达仍然在 AI 硬件基础设施市场占据主导地位,其 GPU 产品在数据中心、自动驾驶、科研等众多领域广泛应用。然而,英伟达也面临着来自其他厂商的竞争压力。

一方面,AMD 等竞争对手不断推出性能与英伟达 GPU 相当但价格更具竞争力的产品。另一方面,谷歌等拥有自己专用 AI 芯片(如 TPU)的厂商,在特定的 AI 应用场景(如谷歌云服务中的深度学习任务)下,对英伟达的市场份额构成了一定的挑战。

新兴厂商的崛起与差异化竞争

2024 年,一些新兴厂商开始在 AI 硬件基础设施市场崛起。这些新兴厂商通过差异化竞争策略来抢占市场份额。例如,一些专注于边缘 AI 硬件的厂商,推出了针对物联网应用的低功耗、小型化的 AI 芯片。

这些芯片在智能家居、工业物联网等领域具有独特的优势,能够满足这些领域对成本、功耗和尺寸的严格要求,与传统的大型 AI 硬件厂商形成了差异化竞争。

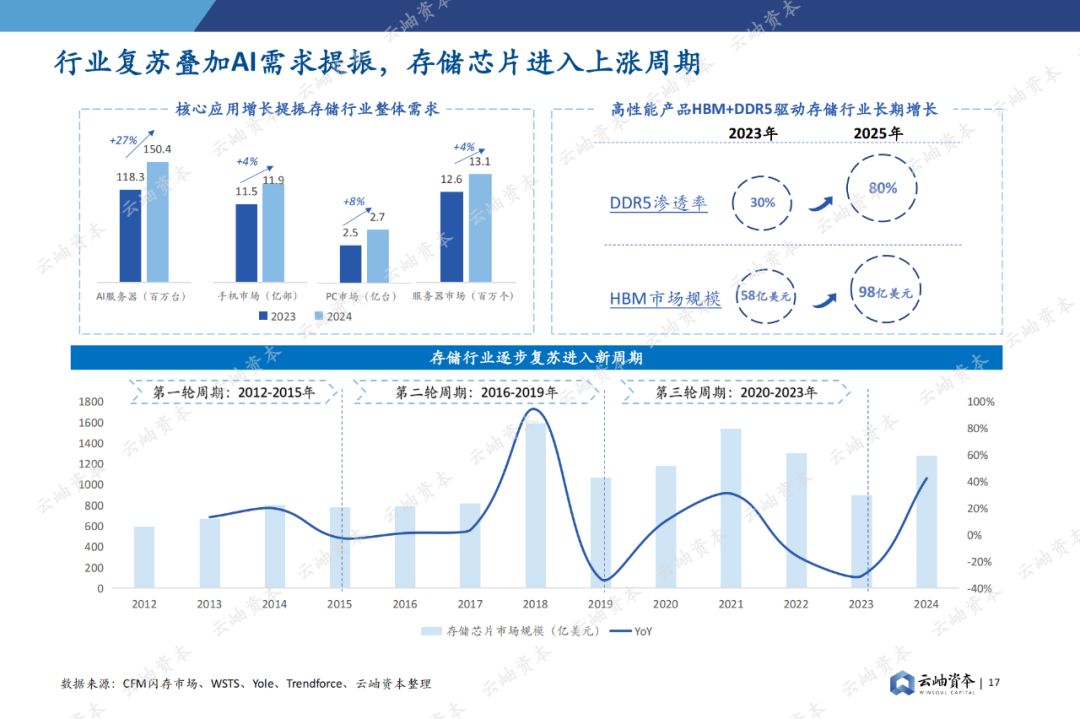

(二)市场发展趋势

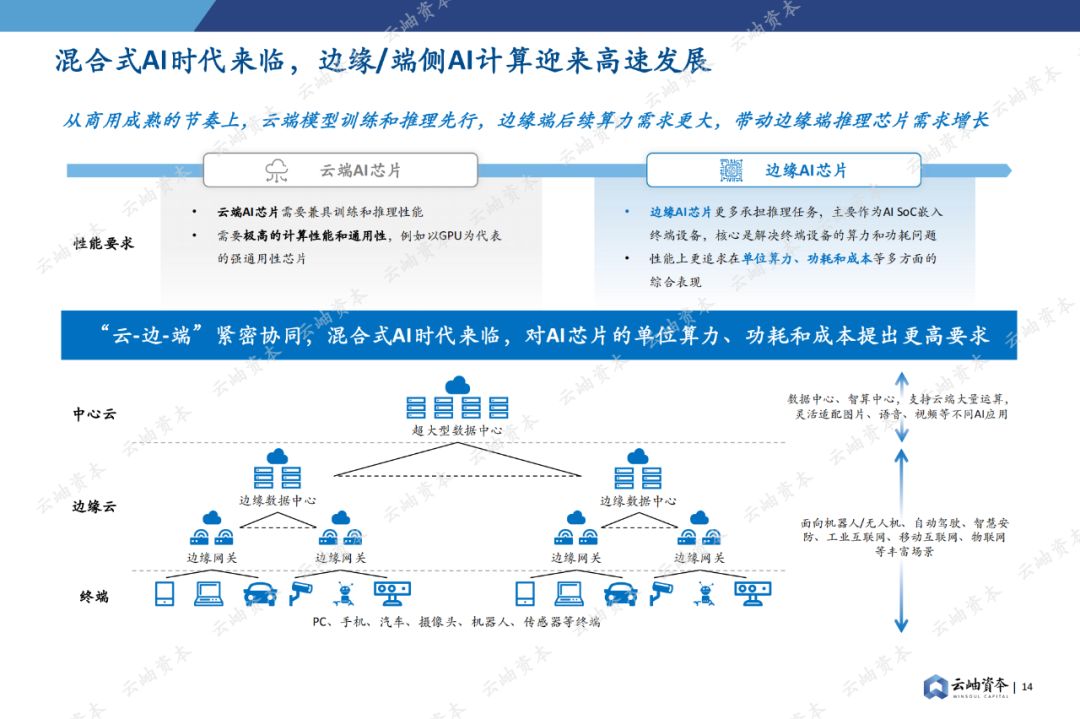

边缘计算与 AI 硬件的融合

在 2024 年,边缘计算与 AI 硬件的融合趋势愈发明显。随着物联网的发展,越来越多的 AI 应用需要在边缘设备上运行,如智能摄像头、工业机器人等。

这就要求 AI 硬件基础设施具备低功耗、小尺寸、高可靠性等特点。为了满足这些需求,芯片厂商开始推出专门为边缘计算设计的 AI 芯片,这些芯片集成了 AI 计算、传感器接口、通信等多种功能,推动了边缘计算与 AI 技术的协同发展。

AI 硬件的开源与协作趋势

2024 年,AI 硬件的开源与协作趋势也在逐渐兴起。一些开源的 AI 硬件项目开始出现,如开源的 AI 芯片设计框架等。

通过开源和协作,不同的研究机构和企业可以共享资源、共同开发,加速 AI 硬件的创新速度。同时,开源也有助于降低 AI 硬件的开发成本,使得更多的中小企业能够参与到 AI 硬件的研发中来,促进 AI 硬件基础设施市场的多元化发展。

八、结论

2024 年的半导体在 AI 硬件基础设施方面呈现出多方面的发展态势。从芯片架构创新到制程工艺演进,从硬件加速技术到能效优化,再到安全性提升和市场格局的变化,各个方面都在不断推动着 AI 技术的发展和应用的拓展。随着 AI 技术的持续进步,半导体作为 AI 硬件基础设施的核心将不断面临新的挑战和机遇,未来的发展将更加注重性能、能效、安全等多方面的综合优化,以满足不同领域 AI 应用的需求。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-