-

信息

阅读目的:李娟子老师团队,了解模型中的知识评测的工作

白雨时1*、嘉豪英2*、曹义心2、吕新1、何玉泽1,

王笑之1 、于吉凡1 、曾凯生1 、小易佳3 ,

Haozhe Lyu 4张嘉荫1李娟子1 , Lei Hou 1 凶

1清华大学,北京,中国2新加坡管理大学,新加坡

3美国加州大学洛杉矶分校

4北京邮电大学,北京,中国

期刊:Advances in Neural Information Processing Systems

-

汇总(解决问题、创新点、难点、还能改进、启发)

| 问题、挑战、创新点、贡献 | 提出的方法 | 指标 | 结论 | 剩余挑战和未来工作 | 数据集 |

| 问题与挑战:目前已建立了许多基准来评估基础模型在开放式问答方面的性能,这是对模型以类似于人类的方式理解和生成语言的能力的综合测试。这些工作大多集中在提出新的数据集上,但是,我们在以前的基准测试管道中看到了两个主要问题,即测试泄漏(测试样本的答案可能已经被看到,因此性能被高估了)和评估自动化(评估机器生成的文本 贡献:提出了一种新的基准测试框架,即语言模型作为考官,根据其知识制定问题并以无参考的方式评估答案。这种方法有很强的拓展性。未来依靠人工标注数据集进行训练,还可能出现数据重叠问题 创新点:提出“考官”的方法,以及三种语言模型作为考官的策略 | 在本文中,我们提出了一种新的基准测试框架,即语言模型作为考官,其中LM充当知识渊博的考官,根据其知识制定问题并以无参考的方式评估答案。我们的框架允许毫不费力的扩展性,因为可以采用各种 LM 作为审查员,并且可以根据更多样化的触发主题不断更新问题。为了进行更全面和公平的评估,我们设计了三种策略:(1)我们指示LM审查员在多个领域提出问题,以探索广泛的收购,并提出后续问题以进行更深入的评估。(2) 在评估时,考官将评分和排名测量相结合,提供可靠的结果,因为它与人工注释密切相关。(3)我们还提出了一种分散的同行审查方法,以解决单个审查员的偏见。 | 李克特量表评分e Likert scale scoring [16,17,41]和两两比较 [38,41]。为了我们的基准测试,我们结合了李克特量表评分和两两比较的变体,即排名。 李克特量表评分作为一种绝对的评估测量,其中评估者根据预定义的维度给给定的反应分配分数。我们在我们的数据集上建立了四个不同的维度: (1)准确性。这就评估了所提供的回答准确回答问题的程度。(2)一致性。这就评估了响应的逻辑结构和组织,以及非专业人士可以理解响应的程度。(3)实际情况。这就检查了回答是否包含事实的不准确。(4)全面性。这衡量了回答是否包含问题的多个方面,从而提供了一个彻底的答案。每个维度的得分都是1到3分,从最差到最好。我们还要求评估者根据前4个维度的分数,提供一个从1分到5分的总体分数。这个分数是衡量答案整体质量的一个指标。 另一方面,两两比较作为一种相对的评价方法,往往比评分更有辨别力。在这个过程中,评估 者得到两个回答,任务是确定哪一个更好,考虑到他们的准确性、连贯性、事实性和全面性。 考虑到有n个参赛选手模型,我们实现了一个合并排序算法来对n个响应进行排序,包括O(nlogn)两两比较。 |

| 出了语言模型作为检验者来解决开放式QA基准测试中的困难。我们构建了 LMExaxQA数据集,旨在探索对知识更全面和分层的理解。该数据集配备了一个可靠的语言模型检查器,我们使用它来对几个广泛使用的基础模型进行基准测试。为了确保一个公平的评估过 程,我们设计了一个同行评审管道。这种方法有助于减轻可能因依赖单一考官而产生的潜在偏 见。扩展我们的基准测试框架,以合并更多特定于领域的语言模型,甚至视觉语言模型,可能会提供更全面的评估。 | 1.评估过程中的潜在偏差,本文只评估了风格偏好,他们也可能存在其他方面的偏见,如激进的偏见或性别偏见 。在未来的工作中认识到这些偏差是至关重要的,因为它们可能会影响并反映在评估结果中。 2.强大的基础模型太少,对同行评估产生了限制。 | Our data and benchmarking results are available at: LMExamQA. |

| 模型结构 |

-

内容

摘要

已经建立了许多基准来评估基础模型在开放式问题回答方面的性能,这是对模型以类似于人类的方式理解和生成语言的能力的全面测试。这些工作大多集中在提出新的数据集上,然而,我们在以前的基准测试管道中看到了两个主要问题,即测试泄漏和评估自动化。在本文中,我们提出了一个新的基准测试框架 ,语言模型作为一个考官,其中LM作为一个知识渊博的考官,根据其知识制定问题,并以无参考的方式评估回答。我们的框架允许毫不费力地具有可扩展性 ,因为各种lm可以作为考官被采用,并且问题可以不断更新,给定更多样化的 触发主题。为了进行更全面和公平的评估,我们设计了三种策略: (1)我们指 导LM审查员在多个领域产生问题,以探索广泛的收购,并提出后续问题,以进行更深入的评估。(2)在评估后,审查员结合了评分和排名的测量值,提供了 一个可靠的结果,因为它与人类的注释紧密一致。(3)此外,我们提出了一种 分散的同行检验方法来解决单一考官的偏见。我们的数据和基准测试结果可以 available at: http://lmexam.xlore.cn.

1介绍

最近,许多大型基础模型[1],如ChatGPT [2]、LLaMA [3]和PaLM [4],已经出现了令人印象深 刻的通用智能,并帮助了全球数十亿用户。对于不同用户的问题,他们可以生成一个类似人的 回答。然而,答案并不总是值得信赖的。g., 幻觉[5]。为了了解基础模型的优缺点, [6,7,8,9,10]建立了各种基准。 然而,我们看到现有的基准测试方法存在两个主要障碍,如下所述。(1)检测泄漏情况。随着预训练中涉及的任务和语料库的增加,测试样本的答案可能已经被看到,因此性能被高估了。(2) Evaluation automation.

评估机器生成的文本是一个长期存在的挑战。因此,研究人员经常将这些任务转化为多项选择的问题,以简化定量分析。这显然与真实的场景相反——因为用户-机器通信大多是开放式的问题回答(QA)或自由形式的QA [11]。另一方面,由于存在大量有效的“好”答案,因此不可能定义一个或几个基本真理,从而实现基于相似性的匹配 量(e。g., 精确匹配,ROUGE-L [12],和BERTScore [13])无效的[11,14,15]。因此,最近的 研究目标是一个训练有素的评估者语言模型(LM),以无参考的方式[16,17,18]来评估答案的 质量。然而,使用LM作为评估者也提出了一个问题:如果评估者在评估过程中产生幻觉并做出错误的判断怎么办?

作为一种尝试,我们的试点研究利用GPT-4 [19]来评估LLaMA [3]对自然问题[20]的正确性,其中100个判断中有18个是不正确的(案例见附录a)。我们将其主要原因归因于评价者本身对这些问题的知识不足。一个简单的解决方案是使用LM不仅作为一个评估者来评估回答,而且作为一个知识渊博的审查员来制定问题,这保证了对判断的全面理解。而且,它通过定期生成新的问题来自然地解决测试泄漏问题。然而,依赖一个集中的审查员很难被认为是公平的,特别是 在评估审查员本身时——一个有自己律师的人对他的客户有一个傻瓜。

在本文中,我们提出了一个新的基准测试框架,Language-Model-as-an-Examiner,,以评估当前的基础模型 ,减轻上述问题。在这里,语言模型作为一个知识渊博的考官,根据其内在的知识提出问题, 并根据他们的回答来评估其他人。我们设计了三种策略来减轻潜在的偏见:

增加了知识的广度和深度。在广度方面,根据预定义的分类法,我们选择尽可能多的不同的领域来生成问题。在深度方面,为了深入探究特定子领域内的模型,我们提出了一个多回合的 设置,其中评估者模仿面试者,基于受访者模型之前的回答提出更复杂的后续问题。我们发布了我们的数据集,即LMExaxQA,它是使用GPT-4 [19]作为考官构建的。

可靠的评估测量。我们探索了两个评价指标,即 Likert scalescoring 和 Ranking,提供了一个更全面的评价结果。这两个指标的结果都与人类注释密切相关,显著优于之前的所有指标。

同行审查机制。为了避免由单一模型作为审查者所产生的潜在偏差,我们提出了一个分散的评估设置,其中所有参与的模型都被邀请为相互检查和相互评估。

在实验中,我们的基准测试管道在8个流行的基础模型上取得了富有成效的结果。我们还证明, 同行考试可以产生一组更多样化的问题来进行知识探索,并平衡来自个体评估者模型的偏见, 最终导致一个更公平的评估结果。

*相等贡献 第37届神经信息处理系统会议(NeurIPS 2023)跟踪数据集和基准测试。

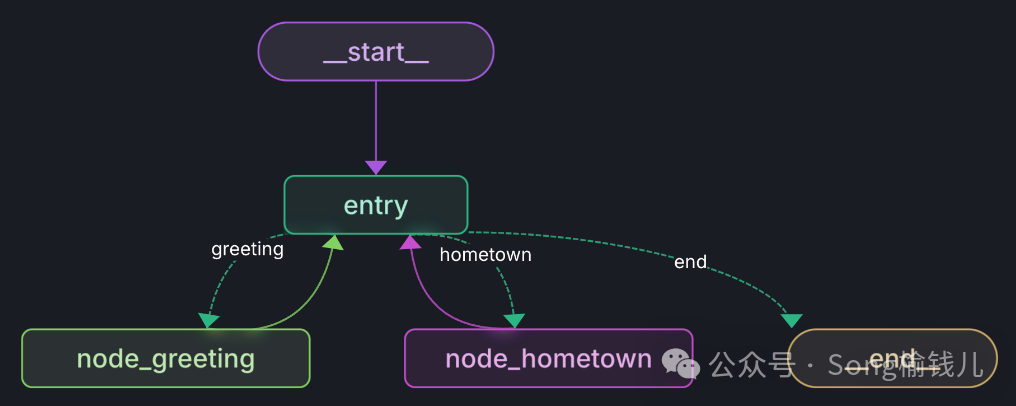

图1:我们的基准测试方法的概述。左边显示了语言模型的使用。考官从不同的领域生成问题, 允许它通过后续问题(FQs)来探索全面的理解(知识广度)和深度的专业化(知识深度)。然后,它根据对主题的理解对其他模型的反应进行评分和排名,提供可靠的评估。正确的部分展示了同行考试,这是一种新的分散的方法,提供了更公平的评估结果,与运行一个LM考官相比,它可能需要更高的运行多个LM考官的工作量。

2相关工作

基础模型的基准测试。由于这是真实场景中用户-机器交互的最自然的设置,因此已经提出了各种基准测试来评估开放式问题回答的基础模型。一些突出的基准包括MS MARCO [21],SQuAD [22,23],自然问题[20],Web问题[24]和OpenBookQA [25]。另一方面,存在的具有长期QA特征的数据集数量有限。其中一个被广泛认可的例子是ELI5 [26],它包含了需要冗长的描述性和解释性答案的问题。这些基准测试的一个显著限制是它们依赖于人工管理和注释,这在本质上限制了它们的可伸缩性。相比之下,我们的方法利用lm来构建数据集,提供了轻松的可扩展性的优势。

自动化NLG评估。为了评估机器生成的对问题的回答,已经采用了几个自动指标,包括F1分数、 精确匹配(EM)、BLEU [27]、ROUGE [12]和METEOR [28]。然而,每个指标都有自己的缺点,导致测试的[14,29,30]和实际性能[14,29,30]之间存在很大的差异。

为了解决这些问题,在NLG评估[31,32,33,34]中使用了训练有素的lm。以前的一种主流方法是reference-based,,它们使用LM推导出候选方法和参考方法之间的相似性。这类中一些突出的指标包括movore[35]、BERTScore[13]。这些度量的是分布相似性,而不是词汇重叠[36](metrics measure the distributional similarity rather than lexicaloverlap [36]),使它们适合于需要更灵活生成的上下文。最近的研究表明,大型语言模型(lms),如ChatGPT [2],可以以无参考的方式进行NLG评估。他们可以根据特定的评估方面对一个候选文本进行评级(或对两个候选文本进行比较评估),在总结和故事生成[42,43]等任务中显示出与人类评估的高度相关 性。在这些研究中,评价主要集中在词汇质量方面,如生成的文本的连贯性和流畅性。然而,他们评估QA响应中关键方面的能力,包括事实的正确性和信息的全面性,仍然不确定。此外, 一个单一的评估者不可避免地会给评估[17]带来偏见。我们的工作旨在通过解决这些问题,不仅利用LM作为一个评估者evaluator,而且作为一个审查员 examiner,通过自我生成的问题来评估其他模型的性能 ,并部署多个LM审查员来确保平衡的评估。

3方法

在本节中,我们将讨论作为审查员的语言模型中的方法,包括LMExaxQA数据集的构建、评估度量设计和同行检查管道。

3.1数据集建设

面向知识广度的问题生成。我们使用一个语言模型(LM)作为一个审查员,在不同的领域产生 多样化和高质量的问题。为了确保知识

的广泛覆盖范围,我们选择了谷歌的趋势类别作为域分类法,并从中随机选择n个域。对于每个域,我们提示LM生成m个不同的问题。我们设计的提示 符(如附录B所示)是为了确保生成的问题具有三个基本特征:多样化的问题形式、不同的认知水平,最重要的是,确保LM对它所提出的问题周围的知识有一个全面的理解。图2显示了基于疑 问词的问题形式的分布,以及问题域的分布。根据Bloom的分类法[44],我们根据其要求的认知水平将问题分为3类,从低到高,即知识记忆、知识理解和知识分析:

知识记忆。这种级别的问题需要识别或回忆某些实体和属性,如一个人、位置或时间。

知识理解。这些问题涉及到展示对特定实例或概念的理解,如“什么是什么”、“为什么 ”和“如何做”。

知识分析。这类问题需要更高级的认知技能,他们通常会质疑一个给定主题的影响、比较,优点和缺点。

通过采用GPT-4将LMExaxQA和以前的开放式QA数据集中的问题分为三个层次,我们得到了表1中 所示的3个认知水平的分布,并给出了每种类型的问题的一个示例。与以往的数据集相比, LMExaxQA在这3个层次上实现了更平衡的分布,从而提供了一种量化基础模型在每个认知水平上的熟练程度的方法。此外,LMExaxQA包含了更高的认知水平的问题,特别是在分析水平,表明了更高水平的挑战。

为了证明LM审查员作为这些问题的评估者的可靠性,我们使用它来提供一个基本真实的答案, 通过使用如下prompt “准确和完整地回答问题,而不提供额外的细节。” 经过人类专家对随机选择的100个问题进行的评估,LM提供的答案显示出100%的准确率,从而证明了对它产生的问题的掌握。

面向知识深度的多轮后续问题生成。为了进一步深入探讨该模型对一个主题的理解,我们开发 了一个涉及多轮后续询问的评估程序,并从访谈过程中获得灵感。我们利用LM审查员构建了一 系列的后续询问(提示见附录B)。这些后续问题是专门为更深入地研究上一轮的模型答案中的 概念而定制的。由于后续问题依赖于模型生成的答案,我们只对正确回答的问题提出后续问题 (由LM考官确定),并计算后续一轮中正确回答的比例。我们将总回合数限制为k,以尽量减少在较长的会话中可能发生的主题偏差。请注意,我们只向受访者模型提供 follow-up question作为输入, 而不是参与“考试历史”4,因为大多数模型都不能进行多轮对话。 我们展示一个关于Flan-T5 [48]的一个 follow-up question的示例:

3.2评价指标

几种常用的方法来促进lm中的类人评估,其中突出的是李克特量表评分e Likert scale scoring [16,17,41]和两两比较 [38,41]。为了我们的基准测试,我们结合了李克特量表评分和两两比较的变体,即排名。

李克特量表评分作为一种绝对的评估测量,其中评估者根据预定义的维度给给定的反应分配分数。我们在我们的数据集上建立了四个不同的维度:

(1)准确性。这就评估了所提供的回答准确回答问题的程度。

(2)一致性。这就评估了响应的逻辑结构和组织,以及非专业人士可以理解响应的程度。

(3)实际情况。这就检查了回答是否包含事实的不准确。

(4)全面性。这衡量了回答是否包含问题的多个方面,从而提供了一个彻底的答案。

每个维度的得分都是1到3分,从最差到最好。我们还要求评估者根据前4个维度的分数,提供一个从1分到5分的总体分数。这个分数是衡量答案整体质量的一个指标。

另一方面,两两比较作为一种相对的评价方法,往往比评分更有辨别力。在这个过程中,评估 者得到两个回答,任务是确定哪一个更好,考虑到他们的准确性、连贯性、事实性和全面性。

考虑到有n个参赛选手模型,我们实现了一个合并排序算法来对n个响应进行排序,包括O(nlogn)两两比较。

3.3分散评价:同行评审

我们引入了一种新的分散方法,该方法包含多个模型作为审查员,即同行检查(如图1的正确部 分所示),因为仅依赖一个集中的模型作为审查员,为基准测试过程引入了以下潜在缺陷。

(1) 生成问题的覆盖:考官可能对某些领域的知识没有全面的理解。因此,审查员可能难以提出详 细检查这些领域的问题,这反过来又使产生的问题的范围不够充分。

(2)评价过程中的潜在偏差 :模型本身在评价过程中可能存在偏差。这种偏见可以表现为对某些类型的反应的偏好,或对与反应质量无关的观点的倾向,如反应的长度或语言风格。例如,[17]表明GPT-4 [19]比人类编写的摘要更喜欢ChatGPT [2]摘要。这种偏见可能会导致不公平的排名评估结果。

为了减轻这些问题,在同行考试中,每个模型都被分别分配了一个考官的角色。作为考官,他们负责提出问题和评估其他模型提供的答案。然后,我们通过投票结合每个模型的评价结果,得到最终的结果。这种方法利用了所有模型的集体专业知识和不同的视角来提高问题的覆盖范围,并确保更公平的评估。

4实验

为了证明我们的语言模型作为审查者框架的有效性,我们首先使用GPT-4 [19]作为审查者进行集中评估,因为它展示了对知识[9,49,50]的广泛理解和精确的判断能力[16,17]。在同行考试中,我们还聘请了Claude(克劳德-即时)[51],ChatGPT[2],Bard[52],和Vicuna-13B [38] 作为LM考官。

4.1度量评价

为了验证我们的基于评分和比较的评估方法的可靠性,我们进行了度量评估。我们对机器生成的响应进行人工评估。这些评估使用1-5李克特量表对总体分数进行量化,我们让注释者根据他们的整体质量对每个问题的不同回答进行排名。我们从LMExaxQA收集了100个问题的300个注释。对于每个问题,我们随机选择3个模型回答,获得3个评分注释和3个成对比较结果。

对于李克特评分,我们计算了自动指标和人类专家给出的总分数之间的斯皮尔曼的ρ和肯德尔的τ;Spearman’s ρ and Kendall’s τ

对于排名,我们根据人类标记的比较结果,计算自动指标提供的两两比较的准确性。然后,我们将LM检查者GPT-4 [19]与之前的自动指标进行了比较,包括 ROUGE-1,ROUGE-2,ROUGE-L [12],BLEU [27], BERTScore [13] (F1), 并在表2中报告了它们与人类判断的相关性。我们观察到,与之前的指标相比,使用GPT-4 [19]作为检查者,其与人类注释的相关性要高得多。更深刻的是,GPT-4的两两比较与人类的一致性超过85%。

4.2集中基准测试结果

实验设置。我们以GPT-4 [19]为审查员,进行了一个集中的基准测试。按照第3节的方法,我们使用GPT-4构建LMExaxQA数据集,其中我们为每个域设置n个=1000个域和m = 10个问题,总共得到10,000个问题。我们在我们的LMExaxQA数据集上评估了8个流行的和开放获取的基础模型,包括BLOOMZ(176B模型)[53]、Flan-T5(XXL模型,11B)[54]、Flan-UL2(20B)[54]、GLM130B [55]、LLaMA(13B模型和65B模型)[3]、Vicuna13B [38]和ChatGPT [2]。这些模型根据它们的训练程序进行分类:它们是否经历了监督微调(SFT)。前6个模型的训练没有使用SFT ,而最后两个模型都经过了微调。对于没有SFT的模型,我们评估他们的0镜头和5镜头的性能。在生成过程中,对于检查者和主题模型,我们将温度设置为0,以获得再现性。关于重现我们的结果的更多细节见附录C.2.

单轮问答的知识广度QA。表3给出了LMExaxQA上每个模型的完整答案的百分比。满分答案被定义为总分得分为5分的回答,并报告每类回答的比例。此外,图3提供了一个雷达图,描述了模型在5个维度上的平均得分; 5 Flan-T5和Flan-UL2是经过指令微调的,但它们缺乏对更真实的场景数据的微调。我们还对8个模型进行了排名评估(我们只显示了没有SFT的模型的少镜头性能)。在图4中,我 们通过获胜率热图((i,j)条目表示模型i与模型j)中获胜的分数以及每个模型对所有其他模型的平均获胜率来可视化排名结果。我们总结了我们的主要发现。

1.LMExaxQA的标度定律。LLaMA-65B在所有问题类别上都显著优于LLaMA-13B,符合LMs [4,56] 的尺度律。

2 . 少镜头会导致对更高的认知水平的问题有更实质性的改善。对于没有SFT的模型,我们观察 到5次射击样本在记忆、理解和分析类型问题上的平均相对改进分别提高为17%、123%和206%。 这意味着该模型可能拥有足够的知识来回答更高层次的问题(例如,区分两个概念)。然而, 它可能缺乏从记忆中检索知识的能力,并无法构建适当的语言来形成答案。很少有镜头的例子 提供了关于如何回答这些问题的演示。

3.SFT提供什么?我们注意到LLaMA-13B和Vicuna-13B之间的巨大性能差距(Vicuna13B在 LLaMA13B上进行了微调,带有70k用户共享的ChatGPT对话),主要是在后两种问题上。这一结 果表明,SFT主要在调整LM的任务适应反应中起着至关重要的作用,而不是丰富模型的知识—— 特别是在需要更复杂答案的更高级别的问题的背景下。

4 . LLM可以提供事实上正确和连贯的响应,但很难获得更复杂的准确答案。雷达情节显示,所有模型在真实性和连贯性方面得分相对较高(超过80/100),但不同的模型在全面性方面各不相同,即,回复是否涉及问题的各个方面.

5.排名结果解释。包括Vicuna和ChatGPT在内的微调模型在分数方面展示了近乎完美的性能(表3)。在我们的数据集中,排名被证明是一种更有洞察力的评估方法。例如,获胜率热图4显示,Chat-GPT以68%的获胜率优于Vicuna-13 B,这表明这两种模型产生的响应质量存在显着差异。基于排名或比较的评估很少用于QA评估,我们鼓励研究界采用更深思熟虑的评估技术,在开放式QA上对更先进的基础模型进行基准测试

针对知识深度的多轮QA。为了进行多轮QA,我们在第一轮的满分答案中随机选择1000个问答。然后,我们让考官GPT-4生成第二轮问题,并要求考生模型回答第二轮问题。由于API使用的高成本,我们将轮数限制在k = 2。评价结果见表3的最后一列。我们观察到,排除ChatGPT和Vicuna- 13B,所有考生模型在第二轮的表现都显著下降。这表明,虽然这些模型最初表现出了强大的理解和知识库,但当面对更复杂的问题时,它们的性能会恶化,这突出了在QA期间进行更深入的评估,以彻底评估模型的能力的重要性。我们在附录C.2中提供了更多关于实验结果的见解。

4.3对等检验结果

在同行评审过程中,我们选择了四种著名的模型,包括ChatGPT [2],Claude [51],Vicuna13B [38],Bard [52],它们是根据它们生成问题和评估NLG质量的能力精心挑选的。每个模型都被分配了一个考官角色,根据给定的20个域,摆出100个问题,并评估其余3种模型的响应。我们在表4中显示了评分结果,在图5中显示了两两比较的结果(更多的实验细节见附录C.3)。我们观察到的总体排名,从最高到最低,如下:Claude, ChatGPT, Bard, and Vicuna-13B. 。有趣的是,这与使用Elo评级系统[57]从流行的排行榜上获得的排名相一致。我们的方法是不同的,因为我们使用lm作为评估者,而不是人类的法官。

4.4Bias Analysis: Centralized vs Decentralized

我们在一个集中的检查中确定了两个潜在的偏差:一个源于模型产生的问题中固有的偏差,另 一个源于模型的评估过程。

产生的问题中的偏见。为了分析生成的问题中的偏差,我们使用t-SNE来可视化三个数据集的问题分布:LMExaxQA、自然问题[20]和SQuAD2.0 [23]。使用OpenAI文本嵌入模型,text-embedding-ada-002 [58],将这些问题被编码为1536维向量。如图6的左图所示,我们在 每个数据集上随机选择1000个问题,并可视化它们各自的t-SNE嵌入。通过嵌入可视化,我们观 察到我们的LMAxaxQA数据集中的问题与以前的数据集中的问题相比表现出更均匀的分布。此外 ,我们利用4个不同的lm来跨20个域生成问题,并在图6的右面板中描述了它们各自的问题嵌入 。正如我们所期望的,同一域领域内的问题聚集在一起。更值得注意的是,由不同模型产生的 问题在域簇的中心区域周围表现出不同的分布,这表明在由单个LM产生的问题中存在潜在的偏差。这一观察结果促使我们采用同行检验,该检验利用多个模型来产生多样化和全面的问题。

评价中的偏差。为了探究评估过程中潜在的偏差,我们设计了一个偏差检测实验来测试集中检 验员GPT-4是否表现出对特定语言风格的偏好。这是通过让GPT-4比较一对相同的反应来实现的 6由于Bard和Claude无法访问API,我们限制了问题的总数。虽然内容不同,但其语言风格不同。具体来说,我们使用ChatGPT来重新表达来自Vicuna13B的响应。为了确保转述后的质量等价性,我们要求人类注释者选择100个重写的响应,以反映原始

响应的质量。然后,我们将这些对呈现给GPT-4以进行比较评估,它们各自的获胜率结果如图7 中的“GPT-4”栏所示。结果表明,GPT-4倾向于由ChatGPT改写的反应,这表明在评估过程中可 能偏向于ChatGPT风格的反应。

为了调查在集中检查中观察到的偏差是否可以通过同行检查来减轻,我们合并了两个模型,即 Bard [52]和Claude [51]。我们指导这些模型来比较这两个响应,并在图7中显示了结果。结果 表明,不同的模型具有不同的偏好。作为一种解决方案,将它们结合在一个精确的框架中,可以平衡它们的个人偏见(最右边的条),并导致一个更公平的评估过程。

为了调查在集中检查中观察到的偏差是否可以通过同行检查来减轻,我们合并了两个模型,即 Bard [52]和Claude [51]。我们指导这些模型来比较这两个响应,并在图7中显示了结果。结果 表明,不同的模型具有不同的偏好。作为一种解决方案,将它们结合在一个精确的框架中,可以平衡它们的个人偏见(最右边的条),并导致一个更公平的评估过程。

5.4测量由模型生成的问题中的数据泄漏

在我们的框架中使用模型生成的问题可能会保留数据泄漏的风险,因为模型生成的内容(例如 ,生成的问题)可能会复制它们在训练前所看到的内容。一些研究已经直接和间接地证明了llm 能够生成创造性的内容,而不仅仅是复制。例如,GPT-2论文[59]中的实验显示,GPT-2的输出 和WebText测试集文章的精确完成率之间的中位数8克重叠率仅为2.6%。此外,自我指导[60]和 羊驼[61]等一系列研究表明,使用lm生成的指令进行微调模型可以显著提高其性能。这表明, 在适当的提示下,lm能够生成创造性的内容,而不是复制在培训过程中遇到的文本。

尽管如此,我们提供了LM在LMAxaxQA数据集上产生的问题中潜在数据泄漏的分析。验证LLM在训练过程中是否遇到过类似问题的理想方法是调查其训练数据。然而,大多数语言模型的训练数 据,通常大小为几tb,是不能公开访问的。

因此,我们研究了两个主要的训练数据来源——web 数据和公共数据集。考虑到web数据,我们对LMExaxQA随机抽取的100个问题进行谷歌搜索,检索最相似的web查询。

对于公共数据集,我们研究了Flan集合[62],它包含1836个任务和1500万 个实例,在llm的指令微调中被广泛使用。对于LMExaxQA中的每个问题,我们对来自Flan集合的输入实现了BM25搜索。随后,我们计算问题和检索到的查询之间的ROUGE-L分数。我们发现,lm 生成的问题和从网络和Flan收集到的顶级数据之间的平均ROUGE-L得分分别为0.293和0.046。这两个数据源的相似性得分都较低,这意味着模型生成的大多数问题都没有出现在这两个数据源中。

我们还展示了3个随机问题以及从web数据中检索到的相应查询。我们可以看到,该模型比 它们在训练前看到的数据,为其生成的问题添加了更多的限定词和限定词,从训练前的数据中记忆和复述显然不足以回答这些更精确、更复杂的问题。

此外,人工收集的固定数据集无法适应未来的场景,即使用更多的预训练数据,甚至包括与现有数据集重叠的数据。通过我们的方法,数据集中的重叠问题可以通过更复杂的提示工程来重新生成数据集,从而无缝地解决数据集中的重叠问题。

5结论

在本文中,我们提出了语言模型作为检验者来解决开放式QA基准测试中的困难。我们构建了 LMExaxQA数据集,旨在探索对知识更全面和分层的理解。该数据集配备了一个可靠的语言模型检查器,我们使用它来对几个广泛使用的基础模型进行基准测试。为了确保一个公平的评估过 程,我们设计了一个同行评审管道。这种方法有助于减轻可能因依赖单一考官而产生的潜在偏 见。扩展我们的基准测试框架,以合并更多特定于领域的语言模型,甚至视觉语言模型,可能会提供更全面的评估。

6限制

我们提出的框架,尽管为基准测试基础模型提供了一个更精简的方法,但它并非没有缺点。我 们总结为两个限制。

首先是评估过程中的潜在偏差。正如我们在本文中所阐述的,不同的模型 对不同的语言风格有不同的偏好。他们也可能存在其他方面的偏见,如激进的偏见或性别偏见 。在未来的工作中认识到这些偏差是至关重要的,因为它们可能会影响并反映在评估结果中。

另一个限制是,在现有的基础模型之间缺乏强大的评估能力,以促进大规模的同行审查。在我 们的工作中,我们只确定了四个当前可访问的模型,它们证明了评估机器生成的文本所需的能 力。我们预见,在不久的将来,更强大的基础模型的出现将授权同行审查方法,使更复杂和广泛的评估。

伦理考虑。使用像GPT-4这样的大型语言模型创建QA数据集涉及到几个伦理考虑。以下是一些需要考虑的考虑因素:

数据隐私:由于llm生成的内容可能包含个人信息,因此确保数据的匿名性和保护敏感的个人信息至关重要。我们在LMAxaxQA数据集中没有观察到这样的信息泄漏。

错误信息和有害内容:必须确保LLM生成的数据集不包含或鼓励错误信息、仇恨言论或任何形式 的有害内容。对LMExaxQA数据集的严格审查使我们确信这些内容不会出现。

公平和偏见:大型语言模型,可能会无意中继承和放大训练数据中存在的社会偏见。正如我们在之前的限制中所说明的那样,大量努力识别和减轻这种偏见是很重要的。

致谢

清华大学郭强研究所(2019GQB0003)、清华大学倡议科研计划和NSFC青年项目(62006136)资 助。我们优雅地感谢所有匿名的审稿人提出的深刻建议。

-

资源

对应论文已上传到csdn