文章目录

- 一、神经网络的非线性激活是什么

- 二、非线性激活常用函数

- 三、非线性激活的实际演示

一、神经网络的非线性激活是什么

神经网络的非线性激活函数的主要作用是引入非线性变换,从而使网络能够学习和逼近复杂的函数关系。在神经网络中,线性变换(如矩阵乘法)能够将输入数据映射到不同的空间,但是如果仅使用线性变换,网络无法学习到数据的复杂模式或非线性关系。加入非线性激活函数后,网络能够通过层叠多个非线性层,学习复杂的函数映射,从而提高模型的表达能力。

二、非线性激活常用函数

nn.ReLU

nn.ReLU 是 PyTorch 框架中的一个激活函数,用于构建神经网络模型。ReLU 是“Rectified Linear Unit”的缩写,即“修正线性单元”。

当Input小于0的时候,Output会自动折算为0。当Input大于0的时候,Output会正常输出。

nn.Sigmoid

该函数会根据上面的公式来计算output,从而得到输出的值。

三、非线性激活的实际演示

代码self.relu1 = ReLU()括号中填入的值要求是inplace(如下图),我将简单阐述一下inplace的值选择是True或者False会导致的不同

当值是True时,-1会像上面nn.ReLU内容中会折算成0,但是输出的地方就会有所不同。

当为True时,Input输出为0,也就是结果直接给了Input

当为False时,Input的值不会发生改变,而是用了一个新的Output的值来继承这个-1

用矩阵来进行演示nn.ReLU:

import torch

from torch import nn

from torch.nn import ReLU

input = torch.tensor([[1, -0.5],

[-1, 3]])

output = torch.reshape(input, (-1, 1, 2, 2))

print(output.shape)

class Sen(nn.Module):

def __init__(self):

super(Sen, self).__init__()

self.relu1 = ReLU()

def forward(self,input):

output = self.relu1(input)

return output

sen = Sen()

output = sen(input)

print(output)

运算结果:

可以看到,当输出input = torch.tensor([[1, -0.5], [-1, 3]])时候,小于-1的值全部会被折算为0

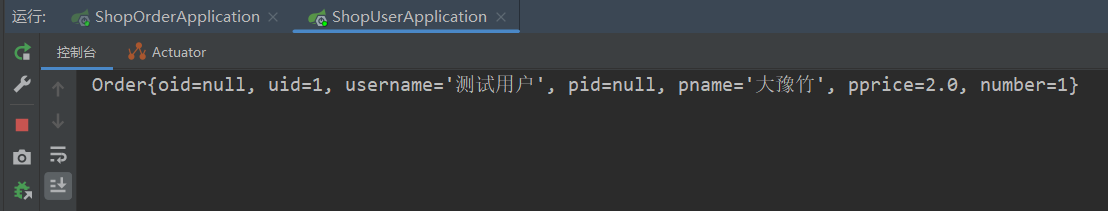

因为nn.ReLU对图片的处理效果不是特别的明显,所以我们采用另外一个函数nn.Sigmoid来进行非线性激活的展示

代码:

import torch

import torchvision.datasets

from torch import nn

from torch.nn import ReLU, Sigmoid

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

dataset = torchvision.datasets.CIFAR10("../data", train=False, download=True,transform=torchvision.transforms.ToTensor())

dataloader = DataLoader(dataset, batch_size=64)

class Sen(nn.Module):

def __init__(self):

super(Sen, self).__init__()

self.relu1 = ReLU()

self.sigmoid1 = Sigmoid()

def forward(self,input):

output = self.relu1(input)

return output

sen = Sen()

writer = SummaryWriter('./logs_relu')

step = 0

for data in dataloader:

imgs, targets = data

writer.add_images("input", imgs, global_step=step)

output = sen(imgs)

writer.add_images("output", output, step)

step += 1

writer.close()

运行结果:

![[产品管理-4]:NPDP新产品开发 - 2 - 战略 - 制定企业经营战略目标的结构化方法与工具](https://i-blog.csdnimg.cn/direct/473b4ab77b2945019c2f4c4150a9f316.png)