问题描述:

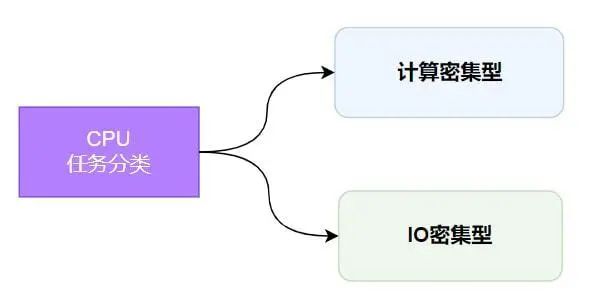

在python中,有一个函数,其功能是进行某种计算,需要传入一些参数,计算完成后传回结果,调用其一次大概要1s的时间,现在需要通过for循环调用其350次,保存每次调用结果(可能是合并成一个列表),这个过程大概需要半小时左右,如何加速该代码?

方法:

为了加速在Python中重复调用一个计算密集型函数的过程,可以采用以下策略:

-

多线程或多进程:使用concurrent.futures模块中的ThreadPoolExecutor或ProcessPoolExecutor来并行化函数调用。

-

函数优化:检查函数内部是否有优化空间,比如减少不必要的计算或改进算法。

-

缓存结果:如果函数在相同的参数上被多次调用,可以使用functools.lru_cache来缓存结果。

-

向量化操作:如果可能,使用NumPy等库来向量化计算,这样可以一次性处理多个数据点。

-

使用更快的库:如果函数内部使用了特定的库,可以尝试寻找更快的替代库。

-

编译成C扩展:将关键函数编译成C扩展可以显著提高执行速度。

-

使用JIT编译器:使用Numba等JIT编译器来加速Python代码。

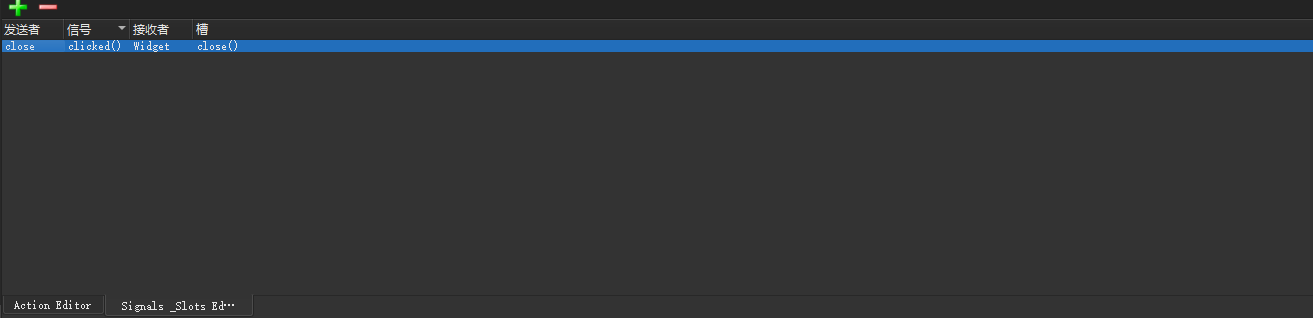

代码实现:

以下是一个示例代码,它展示了如何使用ProcessPoolExecutor来并行执行函数调用,并将结果合并成一个列表:

from concurrent.futures import ProcessPoolExecutorimport time# 假设这是你要调用的计算密集型函数def compute_something(param):time.sleep(1) # 模拟计算过程return param * 2 # 模拟计算结果# 主函数def main():start_time = time.time()# 参数列表params = [i for i in range(350)]# 结果列表results = []# 使用ProcessPoolExecutor创建进程池with ProcessPoolExecutor() as executor:# 使用executor.map并行执行函数results = list(executor.map(compute_something, params))end_time = time.time()print(f"Total time taken: {end_time - start_time} seconds")print(f"Results: {results[:10]}") # 打印前10个结果作为示例if __name__ == "__main__":main()

在这个代码中,我们使用了ProcessPoolExecutor的map方法来并行执行函数。map方法会自动处理任务的分配和结果的收集,只需要提供一个函数和迭代器(如列表)。这个例子中,我们传入了参数列表params,并且map方法会返回一个结果迭代器。我们使用list()函数将结果转换为列表。

请注意,ProcessPoolExecutor默认会使用所有可用的CPU核心,但是可以根据你的系统资源和函数的特性来调整它。可以通过ProcessPoolExecutor的构造函数中的max_workers参数来设置进程池的大小。

输出如下:

Total time taken: 88.77804517745972 secondsResults: [0, 2, 4, 6, 8, 10, 12, 14, 16, 18]

结果表明,程序加速效果明显,加速前需要350s,加速后只要88s左右。