本文回顾了五本探讨大型语言模型 (LLM) 和生成式人工智能等快速发展领域的关键书籍,为这些变革性技术提供了重要见解。

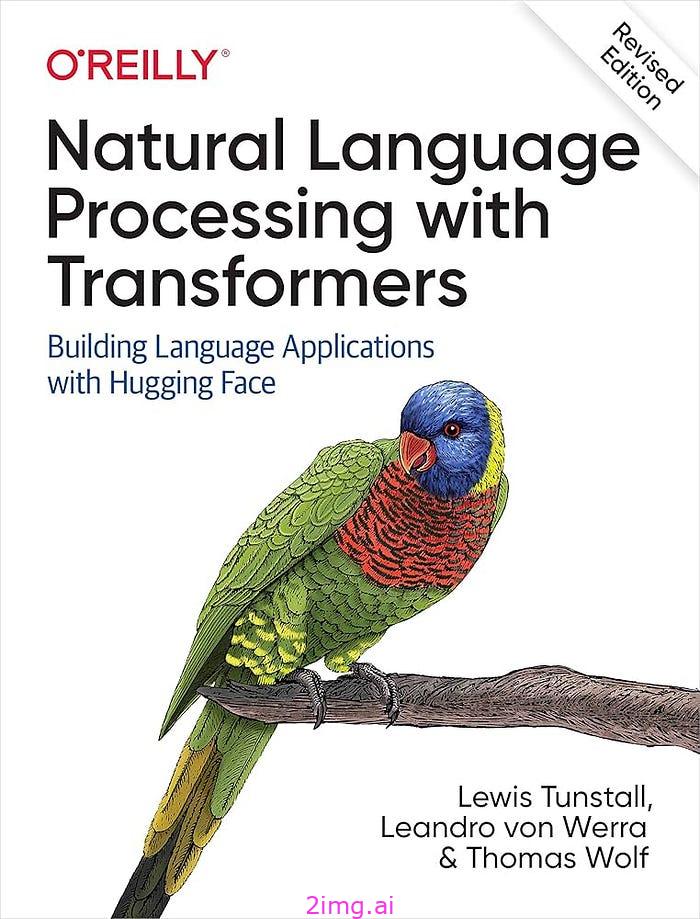

《NLP with Transformers》向读者介绍了用于自然语言处理的 Transformer 架构,并提供了使用 Hugging Face 进行文本分类等任务的实用指导。Sebastian Raschka 的《从头开始构建大型语言模型》提供了构建 LLM 的全面指南,从数据准备到微调。

Jay Alammar 和 Maarten Grootendorst 撰写的《动手操作大型语言模型》为 Python 开发人员提供了实用工具,重点关注语义搜索和快速工程等应用程序。Chris Fregly 及其团队撰写的《AWS 上的生成式 AI》揭开了生成式 AI 与业务集成的神秘面纱,强调了在 AWS 上进行模型选择和部署。

Christopher Brousseau 和 Matthew Sharp 合著的《LLMs in Production》提供了在现实场景中部署 LLM 的策略,强调了扩展 AI 系统的挑战。这些书籍共同为从业者提供了在当今数字环境中发挥 LLM 和生成式 AI 潜力所需的知识和工具。

1. 使用 Transformer 进行 NLP

第一本书是非常重要的书《NLP with Transformers》。自 2017 年推出以来,Transformers 已迅速成为在各种自然语言处理任务中实现最先进成果的主导架构。

如果您是数据科学家或程序员,这本实用的书(现已全彩色修订)将向您展示如何使用基于 Python 的深度学习库 Hugging Face Transformers 来训练和扩展这些大型模型。

Transformers 已被用来撰写逼真的新闻报道、改进 Google 搜索查询,甚至创建讲老套笑话的聊天机器人。在本指南中,Hugging Face Transformers 的创建者 Lewis Tunstall、Leandro von Werra 和 Thomas Wolf 等人以实践的方式教您 Transformers 的工作原理以及如何将其集成到您的应用程序中。您将很快了解它们可以帮助您解决的各种任务。

- 为核心 NLP 任务(例如文本分类、命名实体识别和问答)构建、调试和优化 Transformer 模型

- 了解如何使用 transformer 进行跨语言迁移学习

- 在标记数据稀缺的现实场景中应用 transformer

- 使用提炼、修剪和量化等技术使变压器模型高效部署

![[QCTF2018]X-man-A face1](https://i-blog.csdnimg.cn/direct/71ca48d7bdfe4adda43a573906f1425a.png)