1.什么是InternVL

InternVL 是一种用于多模态任务的深度学习模型,旨在处理和理解多种类型的数据输入,如图像和文本。它结合了视觉和语言模型,能够执行复杂的跨模态任务,比如图文匹配、图像描述生成等。

2.InternVL模型介绍

对于InternVL这个模型来说,它的vision模块就是一个微调过的ViT,llm模块是一个InternLM的模型。对于视觉模块来说,它的特殊之处在Dynamic High Resolution。

ViT(Vision Transformer)是一种基于Transformer架构的图像分类模型

3.Dynamic High Resolution

动态高分辨率,为了让ViT模型能够尽可能获取到更细节的图像信息,提高视觉特征的表达能力。对于输入的图片,首先resize成448的倍数,然后按照预定义的尺寸比例从图片上crop对应的区域。细节如图所示。

4.Pixel Shuffle

Pixel Shuffle在超分任务中是一个常见的操作,PyTorch中有官方实现,即nn.PixelShuffle(upscale_factor) 该类的作用就是将一个tensor中的元素值进行重排列,假设tensor维度为[B, C, H, W], PixelShuffle操作不仅可以改变tensor的通道数,也会改变特征图的大小。

5.InternVL 部署微调实践

**目标:**让InternVL-2B生成文生图提示词

过程:

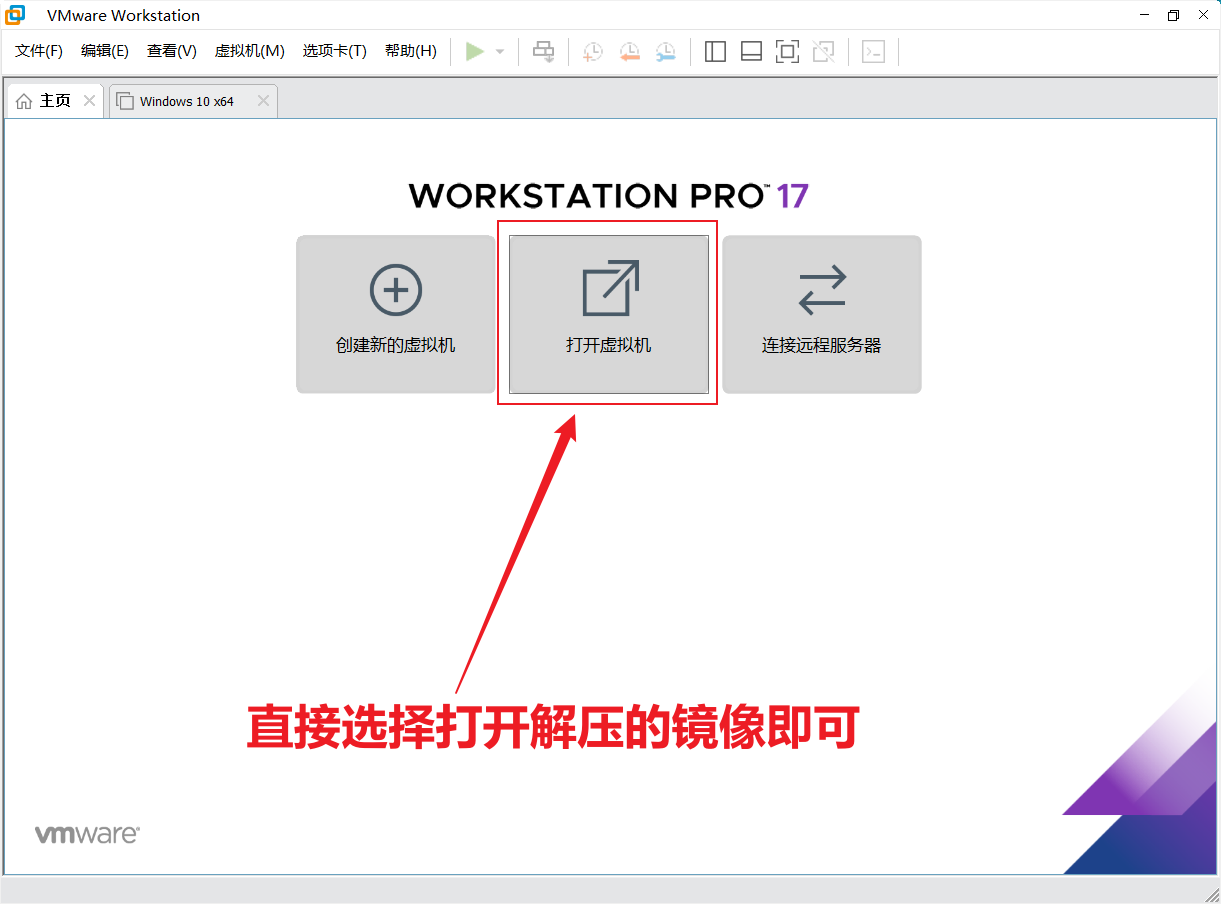

- 准备InternVL模型

cd /root

mkdir -p model

cp 模型

cp -r /root/share/new_models/OpenGVLab/InternVL2-2B /root/model/

- 配置虚拟环境

conda create --name xtuner python=3.10 -y

# 激活虚拟环境(注意:后续的所有操作都需要在这个虚拟环境中进行)

conda activate xtuner

# 安装一些必要的库

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=12.1 -c pytorch -c nvidia -y

# 安装其他依赖

apt install libaio-dev

pip install transformers==4.39.3

pip install streamlit==1.36.0

- 配置完torchvision等依赖后,还需要安装Xtuner

# 创建一个目录,用来存放源代码

mkdir -p /root/InternLM/code

cd /root/InternLM/code

git clone -b v0.1.23 https://github.com/InternLM/XTuner

- 安装Xtuner的依赖

cd /root/InternLM/code/XTuner

pip install -e '.[deepspeed]'

- 安装LMDeploy,帮助部署项目

pip install lmdeploy==0.5.3

xtuner version

xtuner help

- 准备微调数据集

数据集我们从官网下载下来并进行去重,只保留中文数据等操作。并制作成XTuner需要的形式。并已在share里,我们一起从share里挪出数据集。

## 首先让我们安装一下需要的包【timm(PyTorch Image Models)是一个基于PyTorch的图像模型库,提供了许多流行的图像分类模型的预训练权重,包括ResNet等。Pillow是对图像进行增强】

pip install datasets matplotlib Pillow timm

## 让我们把已经准备好的数据集挪出来

cp -r /root/share/new_models/datasets/CLoT_cn_2000 /root/InternLM/datasets/

- 推理图片得到内容

之后我们使用lmdeploy自带的pipeline工具进行开箱即用的推理流程,首先我们新建一个文件:

touch /root/InternLM/code/test_lmdeploy.py

cd /root/InternLM/code/

from lmdeploy import pipeline

from lmdeploy.vl import load_image

pipe = pipeline('/root/model/InternVL2-2B')

image = load_image('/root/InternLM/007aPnLRgy1hb39z0im50j30ci0el0wm.jpg')

response = pipe(('请你根据这张图片,讲一个脑洞大开的梗', image))

print(response.text)

- 微调InternVL2B

配置参数:

#######################################################################

# PART 1 Settings #

#######################################################################

# Model

# 模型地址

path = '/root/model/InternVL2-2B'

# Data

# 数据地址

data_root = '/root/data/'

# data_path = data_root + 'LLaVA-Instruct-150K/llava_v1_5_mix665k.json'

data_path = '/root/data/screenshot_od/layout_ocr_multi.json'

image_folder = data_root + 'screenshot_od/images'

prompt_template = PROMPT_TEMPLATE.internlm2_chat

# 模型最大输出长度

max_length = 8192

# Scheduler & Optimizer

#每张卡上的batch size大小

batch_size = 8 # per_device

# 梯度累积大小

accumulative_counts = 2

# dataloader数量

dataloader_num_workers = 4

# epoch大小

max_epochs = 1

# 优化器类型

optim_type = AdamW

# official 1024 -> 4e-5

lr = 1e-6

betas = (0.9, 0.999)

weight_decay = 0.05

max_norm = 1 # grad clip

warmup_ratio = 0.03

# Save

save_steps = 1000

save_total_limit = 1 # Maximum checkpoints to keep (-1 means unlimited)

…

开始训练:

batchSize=4,在半卡A100 80G上完成微调

NPROC_PER_NODE=1 xtuner train /root/InternLM/code/XTuner/xtuner/configs/internvl/v2/internvl_v2_internlm2_2b_qlora_finetune.py --work-dir /root/InternLM/work_dir/internvl_ft_run_8_filter --deepspeed deepspeed_zero1

- 然后进行权重合并

python3 xtuner/configs/internvl/v1_5/convert_to_official.py xtuner/configs/internvl/v2/internvl_v2_internlm2_5_8b_qlora_finetune.py /root/InternLM/work_dir/internvl_ft_run_8_filter/iter_6000.pth /root/InternLM/InternVL2-2B/

6.微调后的效果

from lmdeploy import pipeline

from lmdeploy.vl import load_image

#pipe = pipeline('/root/model/InternVL2-2B')

pipe = pipeline('/root/InternLM/InternVL2-2B')

image = load_image('/root/InternLM/256321723775630_.pic.jpg')

for i in range(20):

response = pipe(('请你根据这张图片,讲一个脑洞大开的梗', image))

print(response.text)

[WARNING] gemm_config.in is not found; using default GEMM algo

被穿了外套

被粘住了无法逃脱的猫猫

被子和被子同时醒来

“哥哥,你别闹了!我刚刚只是迷路而已!”

被强行拉去体验打蚊子大赛

被粘住了,别过来!

被猫爪抓伤了

已经不是第一次了,果然还是不行啊!

....