作者主页:https://louiszengcn.github.io/

论文标题:

Realistic Surgical Image Dataset Generation Based On 3D Gaussian Splatting

导读:

近年来,随着AI技术的飞速发展,数据量的增加为数据驱动的神经网络提供了更强大的训练基础,推动了各行各业的进步。如何在有限的数据集上进行扩展,增强现有数据,生成更丰富的样本,从而训练出更为优秀的模型,成为了这些领域的研究热点。

而NeRF和3DGS等新兴技术的出现,为实现这一目标提供了新的可能。本文展示了如何利用3DGS技术,从有限的图像中合成新的数据集,生成多视角图像,并支持场景内容的灵活编辑,结果表明研究者可以轻松更换场景中的物体和背景,同时自动生成准确的物体标注数据。©️【深蓝AI】

1. 引言

计算机视觉技术为AI的发展带来了极大的便利。先进的目标检测、追踪和定位技术能够为AI系统提供更精确的环境感知信息,使得AI在各个领域中能够更加准确地感知外部环境,并将这些信息纳入决策过程,从而做出更优的决策和规划。然而,当前的计算机视觉技术大多依赖于监督学习,这意味着它们对数据集的规模和质量有很高的依赖性。在某些缺乏高质量标注数据的场景中,有限的数据量往往使基于学习的方法在训练和监督上面临挑战。医疗图像处理领域,尤其是外科手术领域,就是一个典型的高质量数据匮乏的场景。由于数据的记录和获取难度大,且标注成本高,这一领域的数据集非常稀缺。因此,本篇文章聚焦于医疗领域,旨在解决这一领域的数据集匮乏问题。

以往的研究尝试通过从真实世界图像中生成人工手术图像来应对数据不足的挑战。使用游戏引擎提供了一种可扩展且无噪声的解决方案,但其局限在于无法准确再现真实的表面特性和纹理。生成神经网络则可以通过在手术环境中训练,生成包含手术器械的全合成数据集。然而,这种方法也存在一些局限性:生成图像中的器械位置和姿态是固定且不可编辑的;每个不同的场景都需要重新训练整个网络,缺乏可扩展性;此外,数据集的标注仍然是一个耗时且复杂的任务,目前只有少数方法能够提供相应的标注信息。

NeRF通过从已知位置拍摄的照片构建场景的隐式3D模型,从而能够从新的、未见过的视角渲染2D图像,生成多样化的图像数据集。与生成神经网络相比,基于NeRF的方法在图像质量和数据集多样性方面表现更为优越,能够从多个视角生成2D图像。然而,由于NeRF使用的是隐式表达方式,因此无法实现对场景的编辑,限制了图像数据集生成的灵活性。此外,隐式表达方式也使得NeRF生成的图像数据无法携带显式的标注信息,因此,这样的输出并不适合直接用于神经网络训练。

3DGS是一种新兴的视角合成技术,它能够以显式的方式表达场景,并实现高质量的图像渲染,能够从一系列图像中恢复出细致逼真的3D场景。3DGS强调显式表示和高质量的实时渲染,能够从新的视角生成精确且真实的2D图像。凭借这些优势,3DGS成为了解决数据匮乏问题的潜在解决方案。

本篇文章基于3DGS,提出了一种方法,能够在不同场景中生成包含各种前后景的图像数据集。该方法支持场景编辑,可以灵活替换场景中的前后景物体,从而生成全新的场景并进行新视角渲染。同时,该方法还能为指定的物体生成精确的标注信息,从而增强数据集的多样性。

主要贡献总结如下:

●将3DGS技术应用于医学图像处理领域,成功实现了有难度的医学手术图像数据集的生成,为解决该领域数据集匮乏的问题提供了一种全新的方法途径。

●提出了一种精确编辑3DGS场景的技术,使得生成场景中的前后景物体可以灵活排列组合,并能够调整物体的姿态和位置,从而大大丰富了生成图像数据集的多样性。

●该方法能够自动生成精确的标注信息,与图像数据集一同输出,大幅减少了人工标注的工作量。

●通过图像质量实验与神经网络训练实验,验证了该方法生成的图像数据集的高质量,并展示了其在神经网络训练中的巨大潜力。

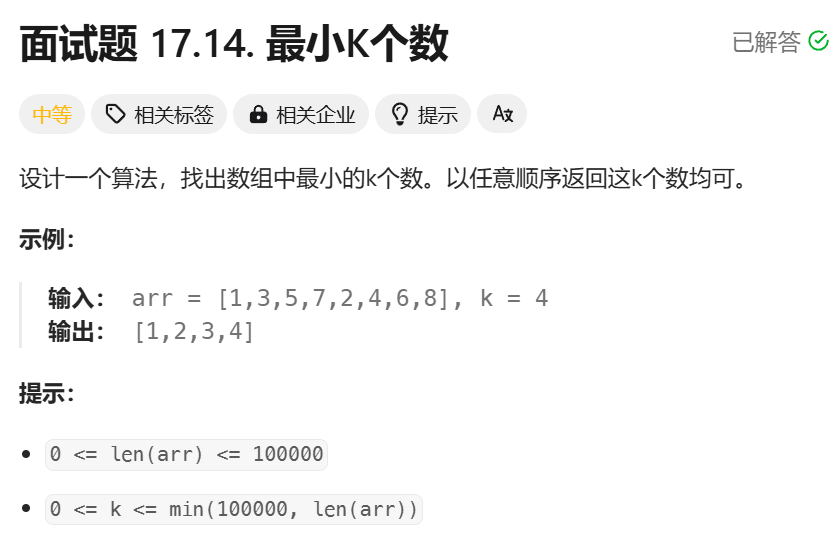

2. 具体方法与实现

如图1所示:该方法的训练过程分为两个部分,分别为前景和后景的训练。这种划分方式契合了计算机视觉领域中监督图像的基本组成逻辑,从而能够更好地支持后续的场景编辑和标注数据的生成。第一条路径主要训练图像中的前景物体,第二条路径则专注于图像背景的训练。两条路径的结果都是生成对应的3DGS表示。随后,通过将前景物体的3DGS进行分割并与后景进行融合,可以生成新的场景。我们在文中还详细介绍了场景编辑以及自动标注生成的具体实现细节。本文将首先介绍这两条主要的训练路径,并在其中穿插相关技术细节,以保证方法介绍的连贯性和易读性。

■2.1 前后景3DGS训练

该过程的主要目的是生成前景和后景的3DGS模型,基本遵循3DGS的标准训练流程。首先,使用相机对前景和背景的物体进行扫描,并将扫描结果按照帧截取成连续的图像序列。随后,利用结构从运动(SFM)技术(如Colmap)对这些连续图像进行初始化,生成稀疏的场景点云分布,再以此点云分布初始化3DGS。经过一段时间的迭代和训练后,即可得到前景和后景的3DGS模型。

■2.2 高斯提取与标记

在获得前景和后景的高斯模型后,下一步是进行高斯模型的提取与标记。这一步主要针对前景的高斯模型进行处理。由于在训练前景高斯模型时,模型中往往会包含一些背景信息,例如在图1中,前景包含了手术器械以及其背景。然而,我们的目标是将手术器械的高斯模型单独提取出来,以便将其与新的背景融合,实现前后景的合成。

为了实现这一目标,第一步需要将前景物体的高斯模型从背景中提取出来。我们采用了一种非常巧妙的方法来实现这一提取过程,即利用高斯分布的几何关系。3DGS本质上是三维空间中的高斯分布,因此它保留了空间坐标位置的固有属性,这意味着在高斯建模后,这些属性能够保持其原始的空间几何关系。

如图2所示,如果在采样前景时采取圆周采样的方式,并将物体与背景相隔一定距离放置,以前景物体为圆心,让相机围绕前景物体进行圆周运动,那么在高斯建模后,这些几何关系依然保留。圆心处的高斯分布对应的是我们需要的物体高斯,而圆周上的高斯分布则对应背景信息。利用这一几何关系,我们可以通过聚类保留圆心处的高斯,过滤掉圆周上的高斯,从而巧妙地提取出属于物体的高斯模型。

提取出的物体高斯模型还可以进行特异性的标注,使得在后续的场景融合中,通过查找这些标注,可以精确定位属于物体的高斯模型,并对其进行编辑和其他操作。这样,不仅实现了高斯模型的提取,还为后续的场景生成和编辑提供了精确的基础。

■2.3 高斯编辑与融合

在完成高斯提取之后,下一步是进行必要的高斯编辑与融合。由于三维空间中高斯分布的特性,不同高斯之间的简单加法操作不会影响它们的分布和表达,因此可以直接将提取出的前景高斯与背景高斯进行融合。不过,为了确保融合的效果,需要保证尺度的一致性。尺度的一致性可以通过相机标定来实现,并在高斯初始化时通过对点云进行空间变换来完成。

对于每一个高斯,其有四个属性,分别是,其中决定高斯形状的主要是(空间位置)(旋转关系) (尺度即大小),因此如果想要实现高斯的编辑,只需要对这三个变量进行修改即可,传统的3DGS难以实现高斯编辑的原因在于很难精确找到对应物体的高斯进行修改,且一旦进行编辑,通常需要重新调整整个场景。然而,在本方法中,我们通过前一步的高斯提取和标记,成功实现了对场景中特定物体的高斯标记。因此,只需修改这些标记高斯的属性,就可以实现对特定物体的精确编辑,而无需影响整个场景的其他部分。这种方法不仅使高斯编辑更加灵活和精确,同时也为场景的个性化调整和多样化生成提供了极大的便利。

■2.4 标注自动生成

这一过程可以通过图3清晰地展示:在完成前景和背景的融合以及针对性的编辑之后,下一步就是将其渲染,生成对应的图像数据集。然而,我们还希望在渲染过程中能够自动获得对应的标注信息,例如用于分割的二维掩码(mask)和用于检测的边界框(Bounding Box)。我们采用了一种非常巧妙的方法,使得在3DGS渲染的过程中可以一次性生成二维掩码和边界框。

由于在2.2步骤中,前景物体的高斯已经被提取和标记,因此在渲染时,可以选择只渲染这部分标记的高斯。如果只渲染这部分高斯,其余没有高斯分布的背景区域将默认渲染为黑色。这意味着最终得到的图像中,只有标记的部分会显示颜色,而其余部分都是黑色。如果从RGB通道上来看,标记部分的RGB值为非零,而其余黑色部分的RGB值都为零。因此,可以通过对图像的RGB值进行阈值限定,将RGB不为零的区域作为掩码区域,而将其余部分作为背景区域,这样就可以快速获得每张图像的二维掩码。

在获得掩码之后,我们将图像转换为简单的二值图,其中被掩码覆盖的区域值为1,背景区域值为0,然后计算值为1的区域的最大外接矩形,从而获得用于检测的边界框(Bounding Box)。由于3DGS的渲染是实时的,并且这些计算都只是简单的数值操作,因此这一自动标注渲染过程不会影响整体的渲染速度,依旧能够保持非常快的处理效率。

3. 实验效果

由于本方法的主要目的是生成图像数据集,因此评估生成图像的质量以及这些图像和对应的标注能否直接用于训练神经网络显得至关重要。为此,我们将该方法应用于难度最高的医疗领域,具体来说,通过采用真实的离体器官作为背景(数据记录平台如图4所示),从这两个角度进行了实验。值得注意的是,由于会议论文的篇幅限制,通常不允许我们进行过于详细的实验展示。因此,从期刊论文读者的角度来看,本文的实验可能显得略为不足,这也是大多数会议投稿常常会收到reviewer关于实验部分comment的原因之一。相信有过会议投稿经验的读者对此深有体会。如何在有限的篇幅中尽可能充分地评估方法,也是值得持续参考和学习的一点。接下来,我们一起来看看本文的图像质量评估实验。

图5展示了我们在图像生成训练实验中的数值对比结果,图6则展示了可视化的结果。从数值对比表格来看,我们的方法在性能上明显优于基于NeRF的方法。此外,从可视化结果来看,生成图像与GT图像的吻合度非常高。这里需要说明一下,这个可视化实验是通过将生成图像与GT图像叠加,并将不吻合的部分进行高亮处理来展示的。从图6最后的叠加图可以看出,高亮部分非常少,基本不影响整体图像的观感——这对于训练神经网络来说是至关重要的。

图7展示了我们在神经网络训练中的结果。我们采用了目标检测领域的经典模型YOLOv5作为基础模型,分别使用手动标注的GT图像和本文方法生成的图像进行训练。GT图像采用的是手动标注,而生成的图像则使用自动生成的标注。从结果来看,两者训练出来的网络性能极其相似,这表明本文方法生成的图像能够很好地直接用于神经网络的训练,作为“饲料”。同时,这也证明了本文方法在自动标注数据上的准确性,能够有效替代人工标注。

4. 总结

我们提出了一种基于3DGS的数据集生成方法,该方法支持前景和背景的自由编辑、场景的替换以及标注数据的自动生成。实验结果表明,该方法能够生成高质量的图像数据,并且这些图像可以直接用于训练神经网络,其效果与使用GT图像训练神经网络的效果非常接近。

©️【深蓝AI】

本文为一作独家授权编译于【深蓝AI】,如需转载请移步🫱深蓝AI·赋能自动驾驶+机器人+AI