RACL: 对抗鲁棒网络架构

论文链接:https://arxiv.org/abs/2009.00902v2

Abstract

深度神经网络(DNN)容易受到对抗性攻击。现有的方法致力于开发各种鲁棒训练策略或正则化来更新神经网络的权值。但除了权重之外,网络中的整体结构和信息流是由网络架构明确决定的,这一点尚未被探索。因此,本文旨在从体系结构的角度提高网络的对抗鲁棒性。我们探讨了对抗鲁棒性、Lipschitz常数和结构参数之间的关系,并表明对结构参数进行适当的约束可以降低Lipschitz常数,从而进一步提高鲁棒性。体系结构参数的重要性可能因操作或连接而异。我们通过单变量对数正态分布近似整个网络的Lipschitz常数,其均值和方差与结构参数有关。该置信度可通过建立基于累积函数的分布参数约束来实现。与各种NAS算法搜索的对抗性训练网络架构以及高效的人为设计模型相比,我们的算法在不同数据集的各种攻击下,经验地在所有模型中获得了最佳性能。

1 INTRODUCTION

深度神经网络(DNN)在图像分类[1],[2],[3],目标检测[4],机器翻译[5],[6]等各种应用中表现出了显著的性能。然而,最近的研究[7]、[8]、[9]、[10]、[11]表明,DNN容易受到对抗性样本的影响,对抗性样本可以欺骗网络,仅通过输入数据的扰动就做出错误的预测,从而导致安全问题。为了应对对抗样本的威胁,现有的大部分工作都集中在鲁棒训练上,通过馈送攻击方法(例如FGSM)生成的对抗样本来优化鲁棒DNN的权重。虽然训练后的网络对各种攻击都表现出良好的鲁棒性,但在优化过程中,这些网络的结构是固定的,这限制了对抗鲁棒性的提高。由人类专家设计的高效架构,如AlexNet和ResNet[3],[12],表明深度神经网络的性能受网络架构的影响。最近的NAS研究也强调了架构的影响。因此,我们问一个简单的问题:

网络能否通过鲁棒架构初始化,进一步获得对抗鲁棒性?

最近的一项研究表明,不同的架构往往具有不同水平的对抗性鲁棒性[13]。因此,鲁棒网络架构的设计对鲁棒性的提高至关重要。然而,由于大量的时间成本和人力,设计一个鲁棒的神经体系结构可能相当昂贵,并且对抗性鲁棒性和体系结构之间的直接关系仍未被探索,因此问题仍然存在。

为了降低发现卓越鲁棒网络架构的成本,我们使用了NAS算法,该算法在预定义的搜索空间内自动发现理想的架构。近年来,NAS研究取得了显著进展,包括基于RL的方法[14]、[15]、[16]和基于梯度的方法[17]、[18]、[19]、[20]。特别是,DARTS[17]引入了一种可微的架构优化方法,通过形成一个加权的操作和来代替离散的架构选择,在离散的搜索空间上进行连续的松弛,从而大大减少了搜索预算。

虽然NAS框架提供了一种有效的方法来自动发现具有定制目标的优秀网络架构,但标准的对抗训练在生成对抗样本时需要大量的成本,这大大降低了搜索效率。因此,我们试图通过探索Lipschitz常数对对抗鲁棒性的影响以及结构参数对Lipschitz常数的影响,通过引入Lipschitz约束来消除对抗训练的内最大值,从而进一步加速结构的优化。在本文中,我们提出通过在NAS框架下建立对抗鲁棒性与Lipschitz常数之间的联系来探索网络结构与对抗鲁棒性之间的关系。

此外,前人也对可微NAS算法的不稳定性进行了探讨[21]。现有的可微分NAS算法用于利用体系结构参数来采样优越的体系结构,其中体系结构参数的所有元素都被“平等对待”进行选择,而不探索它们的差异。例如,同一单元格中的两个节点可能具有不同程度的选择操作自由度,但它们只被分配可训练参数,并在搜索后应用argmax进行选择,这大大降低了采样架构的可靠性,并提出了对架构参数置信学习的需求。因此,我们建议从可训练分布中采样架构参数,而不是直接初始化它们。

我们提出的具有置信学习的对抗鲁棒网络架构搜索(RACL)算法从NAS框架下整个神经网络的Lipschitz常数的近似值开始,推导出了Lipschitz常量与架构参数之间的关系。我们进一步提出从对数正态分布中采样建筑参数。利用对数正态分布的性质,我们证明了整个网络的Lipschitz常数可以用另一种与结构参数相关的均值和方差的对数正态分布来近似,从而可以将约束以累积函数的形式表示出来,从而实现对结构的Lipschitz约束。通过一系列不同设置下的实验,我们的算法实现了高效的鲁棒架构搜索,与其他NAS算法和最先进的模型相比,RACL经验性地实现了优越的对抗鲁棒性。

2 RELATED WORK

为了了解目前的工作,我们回顾了一些相关的文献,包括对抗性攻击,防御方法和网络架构搜索。

2.1 对抗性攻击

Szegedy等人首先揭示了对抗性样本,这表明神经网络容易受到对抗性攻击[22]。给定一个固定的输入,通过利用模型梯度与输入的w.r.t,可以很容易地找到一个极大地改变预测输出的扰动。大量的技术已经被引入,以有效的方式产生强大的对抗性样本。对抗性攻击一般分为白盒案例[9]、[23]、[24]、[25]和黑盒案例[26]、[27]、[28]、[29]两类。白盒案例使攻击者能够完全访问网络。Goodfellow等人通过对输入进行一步梯度攻击,提出了一种高效的攻击方法FGSM[9]。Kurakin等人[30]首先提出了一种迭代攻击方法I-FGSM,以取代基于一步梯度的攻击,从而获得更强大的攻击。Dong等人建议将动量集成到I-FGSM中,以获得更稳定的更新,并提高生成的对抗样本的可转移性。Mardry引入了一种强攻击,即投影梯度下降(Projected Gradient Descent, PGD),目前被广泛应用于鲁棒性学习[31]。PGD攻击利用网络的局部一阶信息,实现了较高的攻击成功率。以前的工作也研究了普遍对抗性扰动[32]。相反,模型体系结构和参数不可访问的黑盒攻击相对较弱。然而,黑盒攻击更符合实际情况,因此受到了越来越多的关注。Madry等人研究了对抗性攻击的可转移性现象,结果表明生成的对抗性样本在另一个网络上也能取得较高的攻击成功率[31]。除了基于传输的黑盒攻击外,还引入了一些基于查询的攻击,攻击者只能查询模型的输出[28],[33]。Yan等[34]提出在基于传输的攻击和基于查询的攻击之间架起桥梁,以实现更高效的黑箱攻击。除了针对分类任务的攻击外,对抗性攻击还被应用于其他任务,如检测和分割[35],[36]。

2.2 攻击防御机制

由于攻击方法呈指数级增长,近年来人们越来越关注通过提高对抗鲁棒性来解决神经网络脆弱性的防御方法。以前的工作提出了各种防御机制。梯度Masking方法通过隐藏梯度信息来迷惑攻击者[37],[38],但不能防御基于近似梯度的攻击[39]。对抗示例检测是另一个旨在发现对抗示例并拒绝它们的流[40],[41]。Feinman等提出了基于预测方差随机化Dropout分类器来识别对抗样本的方法[42]。防御机制的主流是鲁棒优化,进一步优化网络以达到对抗鲁棒性。在训练阶段自然引入对抗性训练来防御攻击,将对抗性样本输入训练阶段,形成最小-最大博弈,内最大值生成对抗性样本,使分类损失最大化,外最小优化模型参数,使损失最小化。不同的攻击策略被应用于生成对抗性训练的对抗性示例,如PGD攻击[31]和FGSM攻击[23]。除了标准的对抗性训练外,还提出了不同的变体。Miyato等人提出了不带标签信息的虚拟对抗训练方法,该方法定义了对抗方向[43]。Shafahi等人引入了一种有效的对抗性训练,该训练循环了梯度信息[44]。Zhang等人提出将预测误差分解为分类误差和边界误差,并给出了一个严密的上界[45]。Pang等[46]引入了自适应多样性促进(ADP),提高了集成模型的对抗鲁棒性。引入了一些正则化方法来防御攻击。[47]、[48]提出约束网络的Lipschitz常数来提高对抗鲁棒性。Mustafa等人引入了一种有效的约束,迫使每个类的特征位于一个凸多面体内,并与其他类的特征分离[49]。

2.3 网络架构搜索

尽管已经提出了大量的方法来防御对抗性样本,但大多数方法都集中在基于不同策略的权重优化上,而忽略了体系结构的影响。近年来,网络架构搜索以其优越的性能受到越来越多的关注。早期的NAS方法严重依赖宏搜索,直接搜索整个网络[14],[50]。为了提高效率,更多的NAS方法采用微搜索空间,搜索单元而不是整个网络,并且将单元串联堆叠以组成整个网络[51],[52]。Yang等在所有架构共享参数的超网络上提出了一种高效的连续进化方法,提高了搜索效率[53]。近年来,引入了可微搜索算法DARTS,通过对搜索空间的松弛来提高搜索速度,形成一个混合操作的超网络,实现可微架构搜索[17]。Dong等人使用Gumbel Softmax在超网上引入了一个可微分采样器,提高了搜索效率[18]。Xu等人提出采用通道采样加速搜索,并加入边缘归一化来稳定搜索阶段[19]。最近,NAS被应用到不同的领域,包括对抗鲁棒性。郭等实证证明了不同架构具有不同程度的鲁棒性,并提出了特征流引导搜索来发现鲁棒网络架构[13]。Chen等人提出了一种改进传统强盗算法的ABanditNAS,在扩大的搜索空间下搜索架构,以更好地防御对抗性攻击[54]。NAS对对抗鲁棒性的一个关注是计算成本,因为对抗训练和超网络优化都可能很耗时。Kotyan等人[55]研究了在更广泛的搜索空间中潜在的鲁棒架构,包括密集层和卷积层之间的连接和连接,并证明存在鲁棒架构,可以在对抗示例上实现固有的准确性。与[55]不同的是,我们的目标是通过研究Lipschitz约束与架构的对抗鲁棒性之间的联系,在不需要昂贵的对抗训练的情况下,在当前流行的搜索空间基准中发现鲁棒架构[17] [18]。

3 METHODOLOGY

在本节中,我们介绍了基于置信学习的鲁棒架构搜索(RACL)算法。与现有防御方法只关注权重优化不同,我们通过探索鲁棒性、结构和Lipschitz常数之间的关系,重点研究了结构对对抗鲁棒性的影响。进一步涉及置信学习,形成对体系结构参数的Lipschitz约束。采用本文提出的算法,搜索到的结构对对抗样本具有更强的防御能力。

3.1 初步

给定输入

x

∈

R

D

x\in\mathbb{R}^D

x∈RD和带注释的标签向量

y

∈

R

M

y\in\mathbb{R}^M

y∈RM,其中

M

M

M是类的总数,神经网络

H

\mathcal{H}

H将扰动输入

x

~

=

x

+

δ

\tilde{x}=x+\delta

x~=x+δ映射到标签向量

y

^

=

H

~

(

x

~

;

W

,

A

)

\hat{y}=\tilde{\mathcal{H}}(\tilde{x};W,\mathcal{A})

y^=H~(x~;W,A)。网络架构用

A

\mathcal{A}

A表示,其过滤器权值用

W

W

W表示。对抗性攻击的目标是通过使分类损失最大化来找到导致错误预测的扰动输入

x

~

\tilde{x}

x~。

x

~

=

a

r

g

m

a

x

x

~

:

∥

x

~

−

x

∥

p

⩽

ϵ

L

C

E

(

H

(

x

~

;

W

,

A

)

,

y

)

,

(1)

\tilde{x}=\underset{\tilde{x}:\|\tilde{x}-x\|_{p}\leqslant\epsilon}{\mathrm{argmax}}\mathcal{L}_{CE}(\mathcal{H}(\tilde{x};W,\mathcal{A}),y), \tag{1}

x~=x~:∥x~−x∥p⩽ϵargmaxLCE(H(x~;W,A),y),(1)

其中

L

C

E

(

y

^

,

y

)

=

−

∑

i

=

1

M

y

(

i

)

l

o

g

(

y

^

(

i

)

)

\mathcal{L}_{CE}(\hat{y},y) = -\sum_{i=1}^{M}y^{(i)}log(\hat{y}^{(i)})

LCE(y^,y)=−∑i=1My(i)log(y^(i)),扰动受其

l

p

l_{p}

lp范数约束。人们提出了各种强大的攻击方法,并显示出很高的攻击成功率,如快速梯度符号法(FGSM)[22]和投影梯度下降法(PGD)[31]。为了防御这些攻击,对每层的权矩阵进行正则化,形成一个lipschitz约束的网络,已被证明有利于对抗鲁棒性[47],[48]。

设

F

=

L

∘

H

\mathcal{F} = \mathcal{L}\circ\mathcal{H}

F=L∘H为输入到分类损失的映射,一次对抗性攻击后的损失差可以有界为:

∥

F

(

x

+

δ

,

y

;

W

,

A

)

−

F

(

x

,

y

;

W

,

A

)

∥

⩽

λ

F

∥

δ

∥

,

(2)

\|\mathcal{F}(x+\delta,y;W,\mathcal{A})-\mathcal{F}(x,y;W,\mathcal{A})\|\leqslant\lambda_{\mathcal{F}}\|\delta\|, \tag{2}

∥F(x+δ,y;W,A)−F(x,y;W,A)∥⩽λF∥δ∥,(2)

其中

λ

F

\lambda_{\mathcal{F}}

λF是函数

F

\mathcal{F}

F关于

∥

.

∥

p

\|.\|_p

∥.∥p的利普希茨常数。与

∥

δ

∥

p

⩽

ϵ

\|\delta\|_p\leqslant\epsilon

∥δ∥p⩽ϵ一起,扰动输入下的泛化误差有界为:

E

x

∼

D

[

F

(

x

~

)

]

⩽

E

x

∼

D

[

F

(

x

)

]

+

E

x

∼

D

[

max

∥

x

~

−

x

∥

⩽

ϵ

∣

F

(

x

~

)

−

F

(

x

)

∣

]

⩽

E

x

∼

D

[

F

(

x

)

]

+

λ

F

⋅

ϵ

,

(3)

\begin{aligned}\mathbb{E}_{x\sim\mathcal{D}}[\mathcal{F}(\tilde{x})]&\leqslant\mathbb{E}_{x\sim\mathcal{D}}[\mathcal{F}(x)]+\mathbb{E}_{x\sim\mathcal{D}}[\max_{\|\tilde{x}-x\|\leqslant\epsilon}|\mathcal{F}(\tilde{x})-\mathcal{F}(x)|]\\&\leqslant\mathbb{E}_{x\sim\mathcal{D}}[\mathcal{F}(x)]+\lambda_{\mathcal{F}}\cdot\epsilon,\end{aligned} \tag{3}

Ex∼D[F(x~)]⩽Ex∼D[F(x)]+Ex∼D[∥x~−x∥⩽ϵmax∣F(x~)−F(x)∣]⩽Ex∼D[F(x)]+λF⋅ϵ,(3)

这表明神经网络可以用较小的利普希茨常数来防御对抗性示例。虽然在给定网络条件下很难求出精确的Lipschitz常数

λ

F

\lambda_{\mathcal{F}}

λF,但我们可以对Lipschitz常数的下界和上界分别施加约束,分别记为

λ

F

‾

\underline{\lambda_{\mathcal{F}}}

λF和

λ

F

‾

\overline{\lambda_{\mathcal{F}}}

λF。因此,网络架构的对抗鲁棒公式可以写成:

min

A

,

W

E

[

F

(

x

,

y

;

W

,

A

)

]

s

.

t

.

λ

F

∗

‾

⩽

λ

F

⩽

λ

F

∗

‾

,

(4)

\min_{\mathcal{A},W}\mathbb{E}[\mathcal{F}(x,y;W,\mathcal{A})]\:s.t.\:\underline{\lambda_{\mathcal{F}}^{*}}\leqslant\lambda_{\mathcal{F}}\leqslant\overline{\lambda_{\mathcal{F}}^{*}}, \tag{4}

A,WminE[F(x,y;W,A)]s.t.λF∗⩽λF⩽λF∗,(4)

其中

λ

F

∗

‾

\underline{\lambda_{\mathcal{F}}^{*}}

λF∗和

λ

F

∗

‾

\overline{\lambda_{\mathcal{F}}^{*}}

λF∗是Lipschitz常数的最优下界和上界。现有的工作通常考虑公式(4)中固定的网络架构

A

\mathcal{A}

A,并将重点放在优化网络权值以提高鲁棒性上,忽略了架构的影响。最近的研究强调了架构的重要性。Liu等人进行了深入的实验,实证证明一些修剪技术的更好的权衡主要来自于架构本身[56]。提升NAS算法涉及架构优化,以在小模型尺寸下获得更好的性能[17],[19]。因此,我们有动机研究网络架构对对抗鲁棒性的影响。

3.2 网络架构中的Lipschitz约束

离散架构A由连接和操作共同决定,这就产生了巨大的搜索空间。可微分体系结构搜索算法通过对体系结构表示的持续松弛提供了一种有效的解决方案[17],[57],[58]。在可微的NAS框架内,我们将整个神经网络分解为单元。每个单元

I

I

I是一个有向无环图(DAG),由

n

n

n个节点的有序序列组成,其中每个节点表示一个潜在表示,该潜在表示由前两个潜在表示和每个边

(

i

,

j

)

(i,j)

(i,j)表示在预定义的搜索空间

O

\mathcal{O}

O中对

I

(

i

)

I^ {(i)}

I(i)进行变换的操作

o

\mathcal{o}

o。接下来[19],引入衡量操作的体系结构参数α和衡量输入流的体系结构参数

β

β

β,形成带有加权输入的操作混合体。中间节点计算为:

I

(

j

)

=

∑

i

<

j

β

(

i

,

j

)

∑

o

∈

O

α

o

(

i

,

j

)

⋅

o

(

I

(

i

)

)

,

(5)

I^{(j)}=\sum_{i<j}\beta^{(i,j)}\sum_{o\in\mathcal{O}}\alpha_{o}^{(i,j)}\cdot o(I^{(i)}), \tag{5}

I(j)=i<j∑β(i,j)o∈O∑αo(i,j)⋅o(I(i)),(5)

其中

I

(

0

)

I^{(0)}

I(0)和

I

(

1

)

I^{(1)}

I(1)固定为搜索阶段的输入节点,最后一个节点由之前的中间节点

I

=

∪

i

=

2

n

−

1

I

(

i

)

I=\cup_{i=2}^{n-1}I^{(i)}

I=∪i=2n−1I(i)按通道串联而成,作为单元的输出。

整个神经网络是通过两种不同类型的单元构建的,包括正常单元,其中所有操作的步长都是1,而约简单元,其中连接到两个输入的操作的步长都是2。将正常单元和约简单元串联堆叠,整个神经网络可以形成 H = I 1 ∘ I 2 ∘ ⋯ ∘ I N ∘ C \mathcal{H}=I_1\circ I_2\circ\cdots\circ I_N\circ\mathcal{C} H=I1∘I2∘⋯∘IN∘C,其中 N N N表示单元数, C C C表示分类器。之后[19],在搜索阶段之后,操作 o o o以最大值 β ( i , j ) α o ( i , j ) \beta^{(i,j)}\alpha_{o}^{(i,j)} β(i,j)αo(i,j)对每条边 ( i , j ) (i,j) (i,j)选择,并选择每个节点 j j j与其两个前例 i < j i<j i<j且最大 β ( i , j ) α o ( i , j ) \beta^(i,j)\alpha_o^{(i,j)} β(i,j)αo(i,j)的连接,以便从超网络中采样离散的优越架构。

我们现在探索结构参数

α

,

β

\alpha,{\beta}

α,β和网络的Lipschitz常数之间的关系。由于整个神经网络是通过将单元按顺序堆叠而构建的

[

I

1

,

I

2

,

.

.

.

,

I

N

]

[I_{1},I_{2},...,I_{N}]

[I1,I2,...,IN], 公式2可进一步分解为:

∥

F

(

x

~

)

−

F

(

x

)

∥

⩽

λ

l

∥

H

(

x

~

)

−

H

(

x

)

∥

⩽

λ

l

λ

C

∥

I

N

(

x

~

)

−

I

N

(

x

)

∥

⩽

λ

l

λ

C

λ

(

I

N

)

∥

I

N

−

1

(

x

~

)

−

I

N

−

1

(

x

)

∥

,

(6)

\begin{aligned} \|\mathcal{F}(\tilde{x})-\mathcal{F}(x)\|& \leqslant\lambda_{l}\|\mathcal{H}(\tilde{x})-\mathcal{H}(x)\| \\ &\leqslant\lambda_{l}\lambda_{\mathcal{C}}\|I_{N}(\tilde{x})-I_{N}(x)\| \\ &\leqslant\lambda_{l}\lambda_{\mathcal C}\lambda(I_{N})\|I_{N-1}(\tilde{x})-I_{N-1}(x)\|, \end{aligned} \tag{6}

∥F(x~)−F(x)∥⩽λl∥H(x~)−H(x)∥⩽λlλC∥IN(x~)−IN(x)∥⩽λlλCλ(IN)∥IN−1(x~)−IN−1(x)∥,(6)

其中

λ

l

,

λ

C

\lambda_{l},\lambda_{C}

λl,λC和

λ

(

I

N

)

\lambda(I_{N})

λ(IN)分别为损失函数、分类器和单元

I

N

I_N

IN的Lipschitz常数。通过将

∥

I

N

−

1

(

x

~

)

−

I

N

−

1

(

x

)

∥

\|I_{N-1}(\tilde{x})-I_{N-1}(x)\|

∥IN−1(x~)−IN−1(x)∥以其先前单元格的格式重写,直到单元格的输入成为

I

1

i

I_1^{\mathrm{~i}}

I1 i的图像,并考虑

∥

I

1

(

x

~

)

−

I

1

(

x

)

∥

⩽

λ

(

I

1

)

∥

x

~

−

x

∥

=

λ

(

I

1

)

∥

δ

∥

\|I_{1}(\tilde{x})-I_{1}(x)\|\leqslant\lambda(I_{1})\|\tilde{x}-x\|=\lambda(I_{1})\|\delta\|

∥I1(x~)−I1(x)∥⩽λ(I1)∥x~−x∥=λ(I1)∥δ∥,公式6可以递归展开并重写为:

∥

F

(

x

~

)

−

F

(

x

)

∥

⩽

λ

F

∥

δ

∥

⩽

∥

δ

∥

λ

l

λ

C

∏

k

N

λ

(

I

k

)

.

(7)

\|\mathcal{F}(\tilde{x})-\mathcal{F}(x)\|\leqslant\lambda_{\mathcal{F}}\|\delta\|\leqslant\|\delta\|\lambda_{l}\lambda_{\mathcal{C}}\prod_{k}^{N}\lambda(I_{k}). \tag{7}

∥F(x~)−F(x)∥⩽λF∥δ∥⩽∥δ∥λlλCk∏Nλ(Ik).(7)

很明显,对抗鲁棒性可以由单元的Lipschitz常数限定。公式7还表明,微扰的影响随单元数量呈指数增长,这进一步突出了单元设计的影响。

由于公式7中的

λ

l

λ_l

λl和

λ

c

λ_c

λc与架构无关,我们接下来将重点讨论

λ

(

I

k

)

λ(I_k)

λ(Ik)。根据公式5中定义的操作混合,节点

I

k

(

j

)

I^{(j)}_k

Ik(j)在扰动下的变化可以写成前面节点

I

k

(

j

)

I^{(j)}_k

Ik(j)的形式。为了简化符号,我们省略了下标

k

k

k对于每个节点,我们有:

∥

I

(

j

)

(

x

~

)

−

I

(

j

)

(

x

)

∥

⩽

∑

i

<

j

β

(

i

,

j

)

λ

(

i

,

j

)

∥

I

(

i

)

(

x

~

)

−

I

(

i

)

(

x

)

∥

,

s

.

t

.

λ

(

i

,

j

)

⩽

∑

o

∈

O

α

o

(

i

,

j

)

λ

o

,

(8)

\begin{aligned}&\|I^{(j)}(\tilde{x})-I^{(j)}(x)\|\leqslant\sum_{i<j}\beta^{(i,j)}\lambda^{(i,j)}\|I^{(i)}(\tilde{x})-I^{(i)}(x)\|,\\&s.t. \lambda^{(i,j)}\leqslant\sum_{o\in\mathcal{O}}\alpha_{o}^{(i,j)}\lambda_{o},\end{aligned} \tag{8}

∥I(j)(x~)−I(j)(x)∥⩽i<j∑β(i,j)λ(i,j)∥I(i)(x~)−I(i)(x)∥,s.t.λ(i,j)⩽o∈O∑αo(i,j)λo,(8)

其中

λ

(

i

,

j

)

\lambda^{(i,j)}

λ(i,j)表示节点

i

i

i到j变换的Lipschitz常数,

λ

o

\lambda_o

λo表示操作

o

o

o的Lipschitz常数。同样,我们可以通过将

∥

I

(

i

)

(

x

~

)

−

I

(

i

)

(

x

)

∥

\|I^{(i)}(\tilde{x})-I^{(i)}(x)\|

∥I(i)(x~)−I(i)(x)∥重写为其前一个节点的格式,对整个单元递归展开公式8,得到:

λ

(

I

(

j

)

)

⩽

∑

i

<

j

β

(

i

,

j

)

∑

o

∈

O

α

o

(

i

,

j

)

λ

o

.

(9)

\lambda(I^{(j)})\leqslant\sum_{i<j}\beta^{(i,j)}\sum_{o\in\mathcal{O}}\alpha_{o}^{(i,j)}\lambda_{o}. \tag{9}

λ(I(j))⩽i<j∑β(i,j)o∈O∑αo(i,j)λo.(9)

将公式7中的

λ

(

I

k

)

\lambda(I_k)

λ(Ik)替换为公式9中的,并将

λ

l

\lambda_l

λl和

λ

C

\lambda_{\mathcal{C}}

λC作为统一常数

C

C

C,则Lipschitz常数

λ

F

\lambda_{\mathcal{F}}

λF以中间节点的Lipschitz常数的乘积为界:

λ

F

⩽

C

∏

k

N

λ

(

I

k

)

⩽

C

∏

k

N

∏

j

n

λ

(

I

(

j

)

)

⩽

C

∏

k

N

∏

j

n

∑

i

<

j

β

(

i

,

j

)

∑

o

∈

O

α

o

(

i

,

j

)

λ

o

.

(10)

\lambda_{\mathcal{F}}\leqslant C\prod_{k}^{N}\lambda(I_{k})\leqslant C\prod_{k}^{N}\prod_{j}^{n}\lambda(I^{(j)})\\\leqslant C\prod_{k}^{N}\prod_{j}^{n}\sum_{i<j}\beta^{(i,j)}\sum_{o\in\mathcal{O}}\alpha_{o}^{(i,j)}\lambda_{o}. \tag{10}

λF⩽Ck∏Nλ(Ik)⩽Ck∏Nj∏nλ(I(j))⩽Ck∏Nj∏ni<j∑β(i,j)o∈O∑αo(i,j)λo.(10)

根据定义,无卷积层操作的Lipschitz常数可以总结为:(1).平均池化:S−0.5,其中S表示池化层的步长;(2).最大池化:1,(3).identity连接:1,(4). Zeroize: 0。对于深度可分离卷积和扩展深度可分离卷积的其余操作,我们关注

L

2

L_2

L2有界扰动,根据谱范数的定义,这些操作的Lipschitz常数是其权矩阵

λ

^

2

o

=

∥

W

o

∥

2

\hat{\lambda}_{2}^{o}=\|W^{o}\|_{2}

λ^2o=∥Wo∥2的谱范数,这也是

W

W

W的最大奇异值,标记为

Λ

1

\Lambda_1

Λ1。然而,通过梯度下降直接计算

Λ

1

\Lambda_{1}

Λ1是不现实的。为了实现Lipschitz常数的可微优化,我们使用幂次迭代方法,该方法可用于

Λ

1

\Lambda_{1}

Λ1的有效逼近[59]。请注意,尽管扰动是

L

2

L_2

L2有界的,但也可以实现对

L

∞

L_\infty

L∞的鲁棒性,如[60]所述。

3.3 置信架构采样

结构由参数 α α α和 β β β决定,它们进一步影响网络的Lipschitz常数,如公式10所示。现有NAS算法用于将它们初始化为可训练的参数,而无需深入分析。然而,这些操作或连接的权重自然可能具有不同的重要性和自由度。例如,第一个节点和其中一个中间节点的连接在最终选择时可能具有不同的自由度,但在NAS框架中,它们被简单地赋予具有相同置信度的值以进行优化,并以最大值进行采样。因此,以前的体系结构参数很难满足这一要求。相反,我们建议通过将架构参数视为在架构搜索期间从分布中采样的变量来探索架构参数的置信度。图2展示了置信学习的优势。对于每一个架构参数,以前的可微NAS算法是充分利用训练值的,如图2左图所示,而我们的算法是充分利用参数的置信度,如图2右图所示。直观上,由于搜索空间大,架构优化具有很大的不确定性。但是现有的NAS绝对信任所有的架构参数,而不区分它们的置信度。从分布的角度取 α α α和 β β β,对方差进行优化,以表示对值的置信度。RACL倾向于开发高置信度的操作,并通过研究低置信度的操作来探索更多潜在的好路径。因此,可以很好地探索和利用整个搜索空间。

对于分布,朴素选择可以是多元正态分布。然而,根据公式10中的Lipschitz常数形式,该分布的采样值需要为正,因为 λ F \lambda_{\mathcal{F}} λF总是正的,分布的负值会使约束失效。因此,我们转向对数正态分布 L N \mathcal{LN} LN,因为它保证了正采样值。注意随机变量是对数正态分布 L N ( μ , Σ ) \mathcal{LN}(\mu,\Sigma) LN(μ,Σ),如果它的对数为正态分布 N ( μ , Σ ) \mathcal{N}(\mu,\Sigma) N(μ,Σ)。为简单起见,下面的均值和方差表示对数的均值和方差。最重要的是,它有几个很好的性质,包括多个独立的 L N 1 , … , n \mathcal{LN}_{1,\ldots,n} LN1,…,n的加权和可以用另一个 L N \mathcal{LN} LN近似,多个独立的 L N 1 , … , n \mathcal{L}\mathcal{N}_{1,\ldots,n} LN1,…,n的乘积可以归纳为 L N 1 , . . . , n \mathcal{LN}_1,...,n LN1,...,n的和的参数为 μ \mu μ和 Σ {\Sigma} Σ。因此,我们建议从多元对数正态分布中采样 α \alpha α,记为 L N ( μ α , Σ α ) \mathcal{LN}(\mu^\alpha,\Sigma^\alpha) LN(μα,Σα),有平均值 μ α ∈ R d \mu^\alpha\in\mathbb{R}^d μα∈Rd和协方差矩阵 Σ α ∈ R d × d \Sigma^\alpha\in\mathbb{R}^{d\times d} Σα∈Rd×d,有对角标准差 σ α ∈ R d \sigma^\alpha\in\mathbb{R}^d σα∈Rd,其中 d d d表示 α \alpha α的维数。同样,我们从 L N ( μ β , Σ β ) \mathcal{LN}(\mu^{\beta},\Sigma^{\beta}) LN(μβ,Σβ)采样 β β β。

回到Lipschitz常数, α \alpha α上的多元对数正态分布可以看作是多个对数正态分布变量的加权和,因此基于操作混合 ∑ o ∈ O α o ( i , j ) λ o \sum_{o\in\mathcal{O}}\alpha_{o}^{(i,j)}\lambda_{o} ∑o∈Oαo(i,j)λo,在边的Lipschitz常数上界上推导出单变量对数正态分布。请注意, λ o \lambda_o λo在这里被视为常数,因为在优化架构参数时权重是固定的。本文提出的Lipschitz置信约束如图1所示。虽然其概率密度函数没有封闭的表达式,但其分布可以用对数正态分布的性质近似表示为:

属性1。如果对数正态变量 X ∼ L N ( μ , σ 2 ) X\sim\mathcal{LN}(\mu,\sigma^{2}) X∼LN(μ,σ2)乘以常数 a , a X ∼ L N ( μ + l n ( a ) , σ 2 ) a, aX\sim \mathcal{LN}( \mu + ln( a) , \sigma ^{2}) a,aX∼LN(μ+ln(a),σ2)。

属性2。若有多个独立对数正态变量,记为 X ˙ 1 , X 2 , . . . , X n \dot{X} _{1}, X_{2}, . . . , X_{n} X˙1,X2,...,Xn相乘, X 1 X 2 ⋯ X n ∼ L N ( ∑ i = 1 n μ i , ∑ i = 1 n σ i 2 ) X_1X_{2}\cdots X_{n}\sim\mathcal{LN}(\sum_{i=1}^{n}\mu_{i},\sum_{i=1}^{n}\sigma_{i}^{2}) X1X2⋯Xn∼LN(∑i=1nμi,∑i=1nσi2);

下面[61],对数正态分布的和可以用另一个对数正态分布近似表示如下:

命题1。若有多个独立对数正态变量,记为 X ˉ 1 , X 2 , . . . , X n \bar{X}_{1},X_{2},...,X_{n} Xˉ1,X2,...,Xn相加,则和 Z = ∑ i = 1 n X i Z=\sum_{i=1}^nX_i Z=∑i=1nXi可以用另一个对数正态分布 L N ( μ Z , σ Z 2 ) \mathcal{LN}( \mu _{Z}, \sigma _{Z}^{2}) LN(μZ,σZ2)和方差 σ Z 2 = l n [ ∑ e ( 2 ( μ i ) + σ i 2 ) ( e ( σ i ) 2 − 1 ) ( ∑ e ( μ i + σ i 2 / 2 ) ) 2 + 1 ] ) \sigma _{Z}^{2}= ln[ \frac {\sum e^{( 2( \mu _{i}) + \sigma _{i}^{2})}( e^{( \sigma _{i}) ^{2}}- 1) }{( \sum e^{( \mu _{i}+ \sigma _{i}^{2}/ 2) }) ^{2}} + 1]) σZ2=ln[(∑e(μi+σi2/2))2∑e(2(μi)+σi2)(e(σi)2−1)+1])和平均 μ Z \mu _{Z} μZ = l n [ ∑ e ( μ i + σ i 2 / 2 ) ] − σ Z 2 ln[\sum e^{(\mu_i+\sigma_i^2/2)}]-\frac{\sigma_Z}{2} ln[∑e(μi+σi2/2)]−2σZ。

因此,在公式8中,

∑

o

∈

O

α

o

(

i

,

j

)

λ

o

\sum_{o\in\mathcal{O}}\alpha_{o}^{(i,j)}\lambda_{o}

∑o∈Oαo(i,j)λo的分布可以看作是多个独立对数正态分布的加权和,可以用这些性质和命题1来近似。同理,在公式9中,

∑

i

<

j

β

(

i

,

j

)

∑

o

∈

O

α

o

(

i

,

j

)

λ

o

\sum_{i<j}\beta^{(i,j)}\sum_{o\in\mathcal{O}}\alpha_{o}^{(i,j)}\lambda_{o}

∑i<jβ(i,j)∑o∈Oαo(i,j)λo可以看作是两个独立对数正态分布的多个乘积的和,也可以近似。根据对数正态分布的性质,可以近似求得整个网络的Lipschitz常数上界,

λ

(

i

,

j

)

‾

=

∑

o

∈

O

α

o

(

i

,

j

)

λ

o

∼

L

N

(

l

n

[

∑

o

e

(

μ

o

α

′

+

(

σ

o

α

)

2

/

2

)

]

−

σ

I

(

i

,

j

)

2

2

,

σ

I

(

i

,

j

)

2

)

,

σ

I

(

i

,

j

)

2

=

l

n

[

∑

o

e

(

2

(

μ

o

α

)

+

(

σ

o

α

)

2

)

(

e

(

σ

o

α

)

2

−

1

)

(

∑

o

e

(

μ

o

α

′

)

+

(

σ

o

α

)

2

/

2

)

)

2

+

1

]

)

,

μ

o

α

′

=

μ

o

α

+

l

n

(

λ

o

)

(11)

\begin{aligned} &\overline{{\lambda^{(i,j)}}}=\sum_{o\in\mathcal{O}}\alpha_{o}^{(i,j)}\lambda_{o} \sim\mathcal{LN}(ln[\sum_{o}e^{(\mu_{o}^{\alpha}{'}+(\sigma_{o}^{\alpha})^{2}/2)}]-\frac{\sigma_{I^{(i,j)}}^{2}}{2},\sigma_{I^{(i,j)}}^{2}), \\ &\sigma_{I^{(i,j)}}^{2}=ln[\frac{\sum_{o}e^{(2(\mu_{o}^{\alpha})+(\sigma_{o}^{\alpha})^{2})}(e^{(\sigma_{o}^{\alpha})^{2}}-1)}{(\sum_{o}e^{(\mu_{o}^{\alpha}\prime)+(\sigma_{o}^{\alpha})^{2}/2)})^{2}}+1]), \\ &\mu_{o}^{\alpha\prime}=\mu_{o}^{\alpha}+ln(\lambda_{o}) \end{aligned} \tag{11}

λ(i,j)=o∈O∑αo(i,j)λo∼LN(ln[o∑e(μoα′+(σoα)2/2)]−2σI(i,j)2,σI(i,j)2),σI(i,j)2=ln[(∑oe(μoα′)+(σoα)2/2))2∑oe(2(μoα)+(σoα)2)(e(σoα)2−1)+1]),μoα′=μoα+ln(λo)(11)

式中

λ

(

i

,

j

)

‾

\overline{\lambda^{(i,j)}}

λ(i,j)为

λ

(

i

,

j

)

\lambda^{(i,j)}

λ(i,j)的上界。为简单起见,我们将

λ

(

i

,

j

)

‾

\overline{\lambda^{(i,j)}}

λ(i,j)的均值表示为

μ

I

(

i

,

j

)

\mu_{I(i,j)}

μI(i,j),方差表示为

σ

I

(

i

,

j

)

2

\sigma_{I(i,j)}^{2}

σI(i,j)2。同样,我们从多元对数正态分布

N

(

μ

β

,

Σ

β

)

\mathcal{N}(\mu^{\beta},\Sigma^{\beta})

N(μβ,Σβ)采样

β

\beta

β。对于变量

β

(

i

,

j

)

λ

(

i

,

j

)

‾

\beta^{(i,j)}\overline{\lambda^{(i,j)}}

β(i,j)λ(i,j),它可以被视为两个对数正态分布的乘积,它也遵循对数正态分布,其均值也是两个分布的均值和方差的总和。因此,为了将边缘

λ

(

i

,

j

)

‾

\overline{\lambda^{(i,j)}}

λ(i,j)上的分布推广到中间节点

λ

(

j

)

‾

\overline{\lambda^{(j)}}

λ(j)上的分布,我们在公式11中将

o

o

o替换为

j

j

j,将

μ

o

α

+

l

n

(

λ

o

)

\mu_o^{\alpha}+ln(\lambda_o)

μoα+ln(λo)替换为

μ

(

i

,

j

)

β

+

μ

I

(

i

,

j

)

\mu_{(i,j)}^{\beta}+\mu_{I^{(i,j)}}

μ(i,j)β+μI(i,j),将

(

σ

o

α

)

2

(\sigma_o^{\alpha})^{2}

(σoα)2替换为

(

σ

(

i

,

j

)

β

)

2

+

σ

I

(

i

,

j

)

2

(\sigma_{(i,j)}^{\beta})^{2}+\sigma_{I^{(i,j)}}^{2}

(σ(i,j)β)2+σI(i,j)2,和获得

λ

(

j

)

‾

=

∑

i

<

j

β

(

i

,

j

)

λ

(

i

,

j

)

‾

\overline{\lambda^{(j)}}=\sum_{i<j}\beta^{(i,j)}\overline{\lambda^{(i,j)}}

λ(j)=∑i<jβ(i,j)λ(i,j)的对数正态分布写作:

λ

(

j

)

‾

=

∑

i

<

j

β

(

i

,

j

)

λ

(

i

,

j

)

‾

∼

L

N

(

l

n

[

∑

o

e

(

μ

(

i

,

j

)

β

′

+

(

[

σ

(

i

,

j

)

β

′

]

/

2

)

]

−

σ

I

(

j

)

2

2

,

σ

I

(

j

)

2

)

,

σ

I

(

j

)

2

=

l

n

[

∑

j

e

(

2

(

μ

(

i

,

j

)

β

′

)

+

[

σ

(

i

,

j

)

β

′

]

)

(

e

[

σ

(

i

,

j

)

β

′

]

−

1

)

(

∑

o

e

(

μ

(

i

,

j

)

β

′

+

[

(

σ

(

i

,

j

)

β

′

]

/

2

)

)

2

+

1

]

)

,

μ

(

i

,

j

)

β

′

=

μ

(

i

,

j

)

β

+

μ

I

(

i

,

j

)

,

σ

(

i

,

j

)

β

′

=

(

σ

(

i

,

j

)

β

)

2

+

σ

I

(

i

,

j

)

2

(12)

\begin{aligned} &\overline{{\lambda^{(j)}}}=\sum_{i<j}\beta^{(i,j)}\overline{{\lambda^{(i,j)}}} \sim\mathcal{LN}(ln[\sum_{o}e^{(\mu_{(i,j)}^{\beta}{}^{\prime}+([\sigma_{(i,j)}^{\beta}{}^{\prime}]/2)}]-\frac{\sigma_{I(j)}^{2}}{2},\sigma_{I(j)}^{2}), \\ &\sigma_{I(j)}^{2}=ln[\frac{\sum_{j}e^{(2(\mu_{(i,j)}^{\beta}{}^{\prime})+[\sigma_{(i,j)}^{\beta}{}^{\prime}])}(e^{[\sigma_{(i,j)}^{\beta}{}^{\prime}]}-1)}{(\sum_{o}e^{(\mu_{(i,j)}^{\beta}{}^{\prime}+[(\sigma_{(i,j)}^{\beta}{}^{\prime}]/2)})^{2}}+1]), \\ &{\mu_{(i,j)}^{\beta}}^{\prime}=\mu_{(i,j)}^{\beta}+\mu_{I(i,j)} , \\ &{\sigma_{(i,j)}^{\beta}}^{\prime}=(\sigma_{(i,j)}^{\beta})^{2}+\sigma_{I(i,j)}^{2} \end{aligned} \tag{12}

λ(j)=i<j∑β(i,j)λ(i,j)∼LN(ln[o∑e(μ(i,j)β′+([σ(i,j)β′]/2)]−2σI(j)2,σI(j)2),σI(j)2=ln[(∑oe(μ(i,j)β′+[(σ(i,j)β′]/2))2∑je(2(μ(i,j)β′)+[σ(i,j)β′])(e[σ(i,j)β′]−1)+1]),μ(i,j)β′=μ(i,j)β+μI(i,j),σ(i,j)β′=(σ(i,j)β)2+σI(i,j)2(12)

均值和方差分别记为

μ

I

(

j

)

\mu_I(j)

μI(j)和

σ

I

‾

(

j

)

2

\sigma_{\underline{I}(j)}^2

σI(j)2。根据公式10, 与

λ

(

j

)

\lambda^{(j)}

λ(j)的乘积为界。因此,

λ

F

‾

\overline{\lambda_{\mathcal{F}}}

λF服从对数正态分布,平均值

μ

=

I

n

(

C

)

+

∑

k

N

∑

j

n

μ

I

(

j

)

\mu=In(C)+\sum_{k}^{N}\sum_{j}^{n}\mu_{I(j)}

μ=In(C)+∑kN∑jnμI(j),方差

σ

2

=

∑

k

N

∑

j

n

σ

I

(

j

)

2

\sigma^2=\sum_{k}^{N}\sum_{j}^{n}\sigma_{I^{(j)}}^{2}

σ2=∑kN∑jnσI(j)2。我们引入了一个置信超参数

η

∈

[

0

,

1

]

T

\eta\in[0,1]^{\mathrm{T}}

η∈[0,1]T使自信的学习有这样的约束

P

r

α

,

β

[

λ

F

‾

⩽

λ

F

∗

‾

]

=

P

r

α

,

β

[

C

∏

k

N

∏

j

n

∑

i

<

j

β

(

i

,

j

)

∑

o

∈

O

α

o

(

i

,

j

)

λ

o

⩽

λ

F

∗

‾

]

⩾

η

,

(13)

\begin{aligned}&Pr_{\alpha,\beta}[\overline{{\lambda_{\mathcal{F}}}}\leqslant\overline{{\lambda_{\mathcal{F}}^{*}}}]\\&=Pr_{\alpha,\beta}[C\prod_{k}^{N}\prod_{j}^{n}\sum_{i<j}\beta^{(i,j)}\sum_{o\in\mathcal{O}}\alpha_{o}^{(i,j)}\lambda_{o}\leqslant\overline{{\lambda_{\mathcal{F}}^{*}}}]\geqslant\eta,\end{aligned} \tag{13}

Prα,β[λF⩽λF∗]=Prα,β[Ck∏Nj∏ni<j∑β(i,j)o∈O∑αo(i,j)λo⩽λF∗]⩾η,(13)

其中

λ

F

∗

‾

\overline{\lambda_{\mathcal{F}}^{*}}

λF∗是

F

\mathcal{F}

F的期望Lipschitz常数上界,注意在公式13中,

λ

‾

F

\overline\lambda_{\mathcal{F}}

λF的方差被减小以满足不等式,与公式10中没有置信学习的情况相比,这加强了对

λ

F

\lambda_{\mathcal{F}}

λF的Lipschitz常数近似的置信度。为了获得

μ

\mu

μ和

Σ

\Sigma

Σ中的凸约束,我们通过累积函数的格式将公式13重新表述为:

P

r

[

λ

F

‾

⩽

λ

F

∗

‾

]

=

P

r

[

l

n

(

λ

F

‾

)

−

μ

σ

⩽

l

n

(

λ

F

∗

‾

)

−

μ

σ

]

=

Φ

(

l

n

(

λ

F

∗

‾

)

−

μ

σ

)

,

(14)

\begin{aligned}Pr[\overline{{\lambda_{\mathcal{F}}}}\leqslant\overline{{\lambda_{\mathcal{F}}^{*}}}]&=Pr[\frac{ln(\overline{{\lambda_{\mathcal{F}}}})-\mu}{\sigma}\leqslant\frac{ln(\overline{{\lambda_{\mathcal{F}}^{*}}})-\mu}{\sigma}]\\&=\Phi(\frac{ln(\overline{{\lambda_{\mathcal{F}}^{*}}})-\mu}{\sigma}),\end{aligned} \tag{14}

Pr[λF⩽λF∗]=Pr[σln(λF)−μ⩽σln(λF∗)−μ]=Φ(σln(λF∗)−μ),(14)

其中

Φ

\Phi

Φ表示正态分布的累积函数,因为

l

n

(

λ

F

‾

)

−

μ

σ

\frac{ln(\overline{\lambda_{\mathcal F}})-\mu}\sigma

σln(λF)−μ是服从正态分布的随机变量。由此,我们建立了

μ

,

σ

\mu,\sigma

μ,σ和

η

\eta

η之间的直接关系:

l

n

(

λ

F

∗

‾

)

−

μ

σ

⩾

Φ

−

1

(

η

)

.

(15)

\frac{ln(\overline{\lambda_{\mathcal{F}}^*})-\mu}{\sigma}\geqslant\Phi^{-1}(\eta). \tag{15}

σln(λF∗)−μ⩾Φ−1(η).(15)

通过省略

σ

\sigma

σ的平方根,我们得到了一个凸约束。除了Lipschitz常数的上界外,我们还提出将

λ

‾

F

\underline{\lambda}_{\mathcal{F}}

λF的下界一并最小化以更好地控制

λ

F

\lambda_{\mathcal{F}}

λF。利用krF(x;y;W;A)k≤λF,则

∥

∇

F

(

x

,

y

;

W

,

A

ˇ

)

∥

≤

λ

F

\|\nabla\mathcal{F}(x,y;W,\check{\mathcal{A}})\|\leq\lambda_{\mathcal{F}}

∥∇F(x,y;W,Aˇ)∥≤λF。结合公式15中的约束,我们将公式4中的优化目标重新表述为:

min

μ

α

,

Σ

α

,

μ

β

,

Σ

β

,

W

L

C

E

(

F

(

x

;

W

,

A

)

,

y

)

+

∥

∇

F

(

x

,

y

;

W

,

A

)

∥

,

s

.

t

.

l

n

(

λ

F

∗

‾

)

−

μ

⩾

Φ

−

1

(

η

)

σ

2

,

A

∼

L

N

(

μ

α

,

Σ

α

)

,

L

N

(

μ

β

,

Σ

β

)

.

(16)

\begin{aligned}&\min_{\mu^{\alpha},\Sigma^{\alpha},\mu^{\beta},\Sigma^{\beta},W}\mathcal{L}_{CE}(\mathcal{F}(x;W,\mathcal{A}),y)+\|\nabla\mathcal{F}(x,y;W,\mathcal{A})\|,\\&s.t.\:ln(\overline{{\lambda_{\mathcal{F}}^{*}}})-\mu\geqslant\Phi^{-1}(\eta)\sigma^{2},\\&\mathcal{A}\sim\mathcal{LN}(\mu^{\alpha},\Sigma^{\alpha}),\mathcal{LN}(\mu^{\beta},\Sigma^{\beta}).\end{aligned} \tag{16}

μα,Σα,μβ,Σβ,WminLCE(F(x;W,A),y)+∥∇F(x,y;W,A)∥,s.t.ln(λF∗)−μ⩾Φ−1(η)σ2,A∼LN(μα,Σα),LN(μβ,Σβ).(16)

直观地,公式16中的约束揭示了

σ

\sigma

σ对采样结构参数的影响。随着

σ

\sigma

σ的增加,

μ

\mu

μ的值减小以满足不等式,其中对于相对较大的

σ

\sigma

σ,相应的

μ

α

\mu^{\alpha}

μα和

μ

β

\mu^{\beta}

μβ变为0,这意味着当其相应的置信度较低时,操作或连接不太可能被采样。因此,可以根据其在Lipschitz约束中的置信度对体系结构进行采样。我们采用ADMM优化框架,通过将约束合并成极大极小问题来求解这一约束优化,使得公式16可以改写为:

min

μ

α

,

Σ

α

,

μ

β

,

Σ

β

max

θ

L

C

E

+

λ

F

‾

+

θ

(

c

(

μ

,

Σ

)

)

+

ρ

2

∥

c

(

μ

,

Σ

)

∥

F

2

,

c

(

μ

,

Σ

)

=

μ

+

Φ

−

1

(

η

)

σ

2

−

l

n

(

λ

F

∗

‾

)

,

(17)

\begin{aligned}&\min_{\mu^{\alpha},\Sigma^{\alpha},\mu^{\beta},\Sigma^{\beta}}\max_{\theta}\mathcal{L}_{CE}+\underline{\lambda_{\mathcal{F}}}+\theta(c(\mu,\Sigma))+\frac{\rho}{2}\|c(\mu,\Sigma)\|_{F}^{2},\\&c(\mu,\Sigma)=\mu+\Phi^{-1}(\eta)\sigma^{2}-ln(\overline{\lambda_{\mathcal{F}}^{*}}),\end{aligned} \tag{17}

μα,Σα,μβ,ΣβminθmaxLCE+λF+θ(c(μ,Σ))+2ρ∥c(μ,Σ)∥F2,c(μ,Σ)=μ+Φ−1(η)σ2−ln(λF∗),(17)

其中

θ

\theta

θ为对偶变量,

ρ

\rho

ρ为ADMM中预定义的正数。第一步是在固定其他变量的同时更新

μ

\mu

μ,第二步是在固定其他变量的同时更新

σ

\sigma

σ:

μ

t

+

1

←

μ

t

−

γ

∇

μ

[

L

C

E

+

λ

F

‾

+

θ

(

c

(

μ

,

Σ

t

)

)

+

ρ

2

∥

c

(

μ

,

Σ

t

)

∥

F

2

]

,

σ

t

+

1

←

σ

t

−

γ

∇

σ

[

L

C

E

+

λ

F

‾

+

θ

(

c

(

μ

t

,

Σ

)

)

+

ρ

2

∥

c

(

μ

t

,

Σ

)

∥

F

2

]

,

(18)

\mu_{t+1}\leftarrow\mu_{t}-\gamma\nabla_{\mu}[\mathcal{L}_{CE}+\underline{\lambda_{\mathcal{F}}}+\theta(c(\mu,\Sigma_{t}))+\frac{\rho}{2}\|c(\mu,\Sigma_{t})\|_{F}^{2}],\\\sigma_{t+1}\leftarrow\sigma_{t}-\gamma\nabla_{\sigma}[\mathcal{L}_{CE}+\underline{\lambda_{\mathcal{F}}}+\theta(c(\mu_{t},\Sigma))+\frac{\rho}{2}\|c(\mu_{t},\Sigma)\|_{F}^{2}], \tag{18}

μt+1←μt−γ∇μ[LCE+λF+θ(c(μ,Σt))+2ρ∥c(μ,Σt)∥F2],σt+1←σt−γ∇σ[LCE+λF+θ(c(μt,Σ))+2ρ∥c(μt,Σ)∥F2],(18)

其中

μ

α

,

Σ

α

,

μ

β

,

Σ

β

\mu^{\alpha},\Sigma^{\alpha},\mu^{\beta},\Sigma^{\beta}

μα,Σα,μβ,Σβ通过反向传播更新。对偶变量

θ

\theta

θ用

ρ

\rho

ρ的学习率更新:

θ

t

+

1

←

θ

t

+

ρ

⋅

c

(

μ

t

,

Σ

t

)

(19)

\theta_{t+1}\leftarrow\theta_t+\rho\cdot c(\mu_t,\Sigma_t) \tag{19}

θt+1←θt+ρ⋅c(μt,Σt)(19)

采用置信学习算法的整个鲁棒网络架构搜索,记为RACL,如算法1所示。该算法对结构参数

α

\alpha

α和

β

\beta

β值进行置信学习,增强了鲁棒结构采样的置信度。

4 EXPERIMENTS

在本节中,我们进行了一系列实验,以经验证明所提出的RACL算法的有效性。我们重新训练搜索到的网络架构和将其与NAS算法搜索的各种网络架构以及最先进的网络架构进行比较。研究表明,在各种对抗攻击设置下,RACL搜索的鲁棒网络架构总是比其他基线具有更好的鲁棒性。

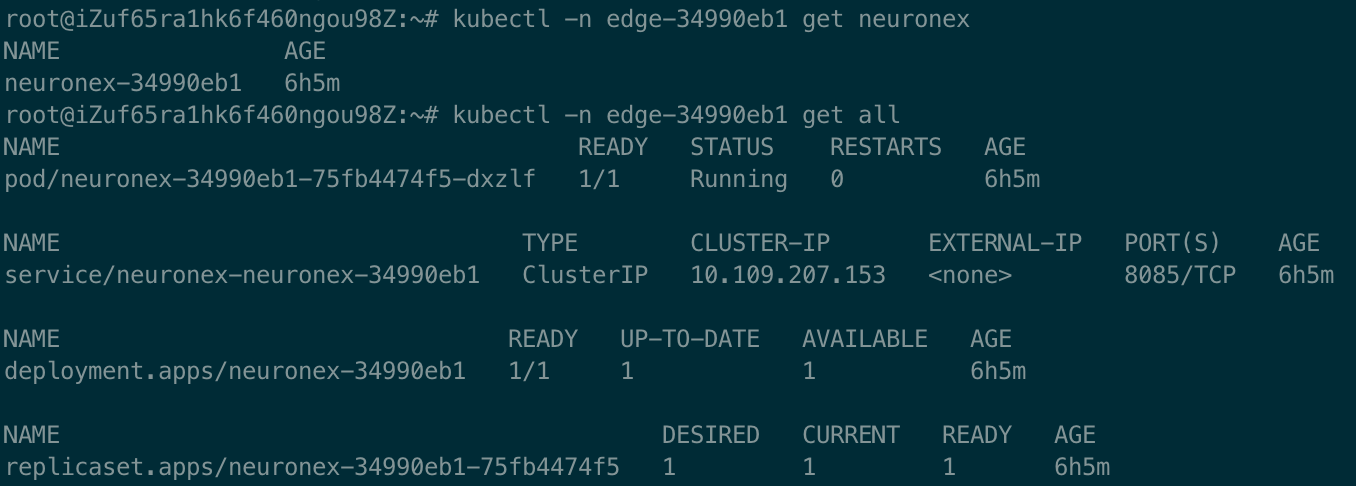

4.1 实验设置

网络架构搜索设置 根据之前的工作[17],[19],我们在包含10个类别的50K训练图像和10K验证图像的CIFAR-10数据集上搜索鲁棒神经架构。在搜索阶段,将训练集分成大小相等的两部分,分别进行结构优化和权值优化。搜索空间包括8个候选:3 × 3和5 × 5可分离卷积、3 × 3和5 × 5扩张可分离卷积、3 × 3最大池化、3 × 3平均池化、跳过连接和零,参考文献[17]、[19]。该超网络由8个单元堆叠而成,其中6个正常单元和2个约简单元,每个单元包含6个节点。对于训练设置,我们遵循PC-DARTS的设置[17]。搜索阶段需要50个epoch,批大小为128。我们使用带有动量的SGD。初始学习率为0.1,动量为0.9,权值衰减为3 × 10−4来更新超网络的权值。使用Adam更新结构参数,学习率为6 × 10−4,权重衰减为1 × 10−3。RACL的搜索时间为0.5 GPU-Day。

数据集和再训练细节 我们在三个数据集(包括CIFAR-10、CIFAR-100和Tiny-ImageNet)上广泛评估了所提出的算法,并与其他先前的工作进行了广泛的比较。根据提出的采样策略对搜索到的优网络架构进行采样。按照NAS[17]、[19]中的设置,我们将搜索到的单元进行堆叠,形成一个20层的网络,并使用整个训练集对其进行再训练。在评估阶段,我们采用流行的对抗性训练框架对所有基线进行再训练。我们从头开始训练网络100次,在整个训练集上批量大小为128。我们使用SGD优化器,初始学习率为0.1,动量为0.9,权重衰减为2 × 10−4。标准梯度裁剪设置为5。根据[62],平衡对抗损失和KL散度的超参数设为6。由于我们关注架构对对抗鲁棒性的影响,因此我们使用相同的对抗训练设置来训练搜索的架构以及最先进的网络架构。通过以相同的对抗性方式训练这些体系结构,我们在不同的体系结构之间进行了公平的比较,并演示了它们如何改进或约束对抗性鲁棒性。对于CIFAR-10和CIFAR-100,我们使用总扰动大小 ϵ \epsilon ϵ= 8/255的对抗性训练。设置攻击的最大迭代次数为10,步长为$\epsilon$2/255。对于Tiny-ImageNet,我们设置 ϵ \epsilon ϵ= 4/255。设置攻击的最大迭代次数为6,步长为2/255。图3显示了搜索到的正常单元和约简单元的示意图,关于搜索到的鲁棒网络架构的更多分析将在第4.5节中介绍。

4.2 对抗白盒攻击

为了评估所提出的RACL的优越性,我们将搜索的单元与SOTA NAS算法进行了比较,包括DARTS [17], PC-DARTS [19], NASNet [52], AmoebaNet[58]。我们还比较了RACL与SOTA人工设计的网络架构,如ResNet和DenseNet[3],[4]。此外,还包括一些针对对抗鲁棒性的NAS算法进行比较,包括RobNet[13]和ABanditNAS[54]。此外,我们还将我们的结果与其他防御机制进行了比较,包括随机加权平均(SWA)[63]和实例自适应对抗训练(IAAT)[64]。为了鲁棒性评估,我们选择了各种流行的强大攻击,包括快速梯度符号法(FGSM)[22]、动量迭代法(MIM)[65]、投影梯度下降法(PGD)[31]、连续波攻击[66]和自动攻击[67]。与之前的对抗性文献[31],[45]一致,在 l ∞ l_{\infty} l∞范数下考虑扰动,总扰动大小在CIFAR-10/100上为8/255,在Tiny-ImageNet上为4/255。对于连续攻击,步长设置为1000,学习速率为0.01。

对CIFAR-10、CIFAR-100和Tiny-ImageNet的评估尽管对抗性训练是一种强大的防御方法,但架构的影响总是被忽视。在本实验中,我们证明了通过RACL搜索的网络架构构建网络可以进一步提高对抗训练后的鲁棒性。为了公平比较,我们对所有模型使用PGD对抗训练重新训练搜索单元,以评估RACL在防御机制主要基准上的鲁棒性。设置PGD攻击迭代次数为20次和100次,步长为2/255,建议采用[13]。详细评价结果如表1所示。每个列的最佳结果以粗体突出显示。

如表1所示,在所有数据集上,RACL比其他最先进的网络架构实现了更好的对抗精度。例如,与我们在CIFAR-10上的基线PC-DARTS相比,尽管RACL和PC-DARTS都实现了相似的clean精度和模型大小,但它们在对抗性训练中的表现不同。在FGSM攻击下,RACL的准确率为62.55%,比PC-DARTS提高了1.47%(61.08%$\rightarrow 62.55 62.55%),在PGD100攻击下,比PC-DARTS提高了2.96%(52.36% 62.55\rightarrow 55.32 55.32%)。此外,在CIFAR-100和Tiny-ImageNet的不同攻击下,RACL比其他基线获得了最好的鲁棒精度。例如,RACL在自动攻击下的准确率为52.26%,提高了1.25% (24.30% 55.32\rightarrow $25.55%),优于CIFAR-100上的DARTS。同样,在Tiny-ImageNet数据集上,RACL在连续攻击下的准确率为42.99%,提高了1.06% (41.93% $\rightarrow $42.99%)超过了NASNet。我们的经验表明,在各种攻击下,RACL在相同搜索空间下的鲁棒性优于其他NAS算法,这表明通过对架构参数施加Lipschitz约束可以进一步提高对抗鲁棒性。

基于CIFAR-10的人为设计架构与鲁棒NAS算法的比较 除了标准的NAS算法外,还存在一些针对对抗鲁棒性的NAS算法以及一些流行的人为设计的架构,这些架构在对抗鲁棒性基准测试中被广泛比较。我们包括ResNet18, ResNet-50, WideResNet-28-10和DenseNet-121进行比较。结果如表2所示。与这些人为设计的体系结构相比,RACL在各种攻击和参数较少的情况下,在所有基线上都显示出明显的鲁棒精度优势。在鲁棒NAS算法方面,RobNet采用鲁棒架构搜索算法来探索不同预算下的RobNet家族[13]。与RobNet-S、RobNet-M和RobNet-L相比,RACL的性能始终是最好的,但差距很大。与RobNet-free相比,RACL以更少的参数获得了更好的结果。例如,在PGD100攻击下,RACL的准确率为55.32%,提高了2.75% (52.57% $\rightarrow $55.32%),超过了RobNet-free。与在其搜索空间中包含去噪操作的ABanditNAS相比,RACL在对抗精度上优于后者。例如,RACL在PGD100攻击下的准确率为55.32%,提高了5.81% (54.19% $\rightarrow $60.00%)高于ABanditNAS。总体而言,RACL在参数、干净精度和对抗精度之间实现了较好的权衡,这突出了所提出的RACL算法的有效性和效率。

与现有防御机制的比较 我们认为初始化具有鲁棒网络架构的网络可以被视为对抗对抗样本的有效防御方法。为了说明鲁棒架构如何提高对抗训练的性能,我们将RACL与先前提出的防御机制在不同数据集上进行比较,包括CIFAR-10、CIFAR-100和Tiny-ImageNet。对于CIFAR-10和CIFAR-100,摄动预算设置为8/255。对于Tiny-ImageNet,我们考虑两个摄动预算。根据[63]、[69],将PGD攻击的扰动预算

ϵ

\epsilon

ϵ设为4/255,20次迭代为PGD20。我们还考虑了Tiny-ImageNet中另一个更强的攻击设置,如下[13]。PGD攻击的扰动预算设置为

ϵ

\epsilon

ϵ=8/255,迭代100次,即PGD100。我们包括各种防御机制进行比较。RACL还与FAT[68]、SWA[63]、IAAT[64]和NADAR[69]进行了比较,FAT[68]旨在更好地权衡自然精度和鲁棒性之间的关系,SWA[63]引入了权重平滑来解决对抗训练中的过拟合问题,IAAT[64]强制执行样本特定的扰动边界以获得更好的泛化,而NADAR[69]则提出搜索扩张网络以获得对抗鲁棒性。具体结果如表3所示。与所有SOTA防御技术相比,RACL在所有场景下的性能都是最好的,这表明了RACL作为防御机制的优越性。注意,RACL可以与其他对抗性训练算法协作,以获得更好的性能。

4.3 对抗黑盒攻击

基于传输的黑盒攻击 评估我们接下来评估了RACL在黑盒攻击下的鲁棒性。根据先前的文献[31],[70],我们应用基于转移的黑盒攻击,使用受害者模型生成对抗性样本并将其提供给目标模型。在本文中,我们以一个ResNet-110网络作为受害者模型。传输的对抗样本是通过FGSM、MIM和PGD攻击生成的。在输入这些转移的对抗样本后,比较不同架构的对抗精度,如表4所示。与其他标准NAS算法相比,RACL在这些基于传输的攻击的所有场景下都具有最高的鲁棒精度,这突出了本文算法对基于传输的黑箱攻击的对抗鲁棒性。

PGD攻击下CIFAR-10的可移植性 测试继[13]之后,我们进一步对CIFAR-10进行可移植性测试。我们使用不同的NAS算法作为源模型,通过10次迭代PGD攻击生成对抗性样本,并将其作为交叉黑盒攻击提供给其他目标模型。结果如表5所示。每一行表示来自同一源模型的不同目标模型在黑箱攻击下的鲁棒精度。相应的,每一列表示目标模型在受到不同源模型攻击时的鲁棒性。对比每一行,RACL在不同源模型的攻击下准确率最高,这说明虽然这些架构在相同的搜索空间内进行搜索,但在攻击下表现出不同的鲁棒性。RACL与其他基线的巨大差距也凸显了RACL在黑盒设置下的优越性。此外,通过比较每个模型对之间的可转移性,RACL倾向于生成更强的对抗样本。例如,RACL$\rightarrow $AmoebaNet实现了35.52%的成功攻击成功率和AmoebaNet !我们的攻击成功率达到了29.59%。RACL以NASNet、DARTS和PC-DARTS为目标模型,生成除白盒攻击外攻击成功率最高的对抗样本。

RFGSM攻击下CIFAR-10的可移植性测试 此外,我们通过对CIFAR-10在RFGSM攻击下的可转移性测试,对RACL进行了额外的鲁棒性评估[71]。具体结果如表6所示。下划线表示白盒RFGSM攻击下的对抗精度,其中总扰动设为8/255。对比对角线精度,RACL在RFGSM攻击下的白盒性能最好。每一行表示来自同一源模型的不同目标模型在黑盒攻击下的鲁棒性。对比各列,RACL作为源模型显示出较强的对抗性可转移性。比较每一行,RACL在所有场景中都达到了更好的黑盒对抗精度,如表6中粗体所示。例如,如第四行所示,PC-DARTS $\rightarrow $ RACLL实现了18.84%的成功攻击成功率, PC-DARTS$\rightarrow $ AmoebaNet为21.30%,PC-DARTS $\rightarrow $NASNet的19.32%和PC-DARTS $\rightarrow $DARTS为22.98%。类似地,RACL利用RFGSM攻击实现了很强的对抗性可转移性。因此,RACL对不同的基于传输的攻击表现出优越的对抗鲁棒性,这证明了我们算法的有效性。

4.4 不同扰动大小和攻击迭代下的鲁棒性

增加攻击迭代下的鲁棒性 我们进一步用不同的白盒攻击参数进行实验,包括扰动大小和迭代次数。根据[13],我们通过将PGD攻击的攻击迭代次数提高到100次,步长为2/255,来加强对抗性攻击。与其他基线的比较如图4 (a)所示,其中RACL在不同的PGD迭代中始终达到最佳精度。此外,随着迭代次数的增加,RACL对PGD攻击的防御能力也相对较强。例如,NasNet在PGD20下达到了53.35%,在PGD100下达到了52.83%,差距为0.52%,而RACL在PGD20下达到了55.68%,在PGD100下达到了55.32%,差距为0.36%,这说明在更多的攻击迭代后,RACL可以更好地保持鲁棒性。与在PGD100上具有相同搜索空间的RobNet家族相比[13],RACL在参数较少的情况下取得了比RobNet-small、RobNet-medium、RobNetlarge和RobNet-free更好的性能,但准确率分别提高了7.25%、6.36%、6.08%和2.75%,这也显示了RACL的效率。

增大扰动大小下的鲁棒性 除了攻击迭代外,我们还评估了不同摄动预算下的对抗鲁棒性。如图4 (b, c)所示,PGD和FGSM攻击的总扰动大小都在0.01 ~ 0.05之间。我们提出的RACL算法在不同的扰动预算下总是比其他基线表现更好,这说明RACL可以提供更强的防御各种对抗性攻击。同样,当允许攻击具有更大的总扰动大小时,我们的优势变得更加明显。例如,将NasNet与RACL在PGD0.01和PGD0.05上进行比较,当攻击规模增加时,差距增加了0.71% (75:.33% $\rightarrow $76.89%在PGD0.01和33.57% $\rightarrow $35.84 (PGD0.05);在FGSM0.01和FGSM0.05上,AmoebaNet与RACL的差异增大了1.65%(75.10%)。FGSM0.01 77.33%和47.55% $\rightarrow $51.43% (FGSM0.05),这突出了RACL在更广泛的扰动空间内针对各种攻击的对抗性鲁棒性。

4.5 RACL的潜在模式和方差

搜索单元的可视化 除了图3中显示的单元外,我们还多次运行RACL以探索RACL倾向于发现的潜在模式,并为搜索的鲁棒神经架构提供更多见解。图5给出了更多的搜索架构。结合图3中搜索到的单元,我们发现存在一些RACL更喜欢的潜在模式。在搜索的正常单元中总是存在一个类似resnet的模式。例如,每个节点的输入往往是跳跃连接和另一个具有可训练参数的操作的组合,如图3 (a)和图5 ©中的节点0,1,2。除了在正常单元中具有类似ResNet的模式外,在约简单元中,RACL更倾向于选择3 × 3 max pooling等池化层,而不是跳过连接,如图3 (b)和图5 (b)、(d)所示。总体而言,RACL的搜索单元看起来像是ResNet的调优版本。

搜索单元的鲁棒稳定性 为了进一步证明RACL的有效性,我们通过多次运行报告了RACL和其他基线的误差条,以评估搜索单元的鲁棒稳定性。根据之前的NAS工作[17],我们对所有基线进行了多次重新训练,并报告了由不同NAS算法和RACL搜索的神经架构的性能(共5次运行)。具体结果如表7所示。对于每种算法,我们报告了平均干净和鲁棒精度与标准误差。对比每一列,在多次运行后,RACL在各种攻击下始终保持最佳的平均鲁棒精度。例如,在自动攻击下,RACL的平均准确率为50.14%,在PGD20下为55.50%,比其他基线高出约2%。在误差条上,RACL在几乎所有场景下都具有较小的波动,表明RACL可以发现鲁棒性和稳定性较好的神经结构。

4.6 消融分析

在本节中,我们对RACL算法的超参数以及置信学习进行了消融研究。消融研究结果如表8所示。我们首先在预定义的搜索空间内应用随机搜索算法,以排除主要改进来自搜索空间的可能性。我们随机抽取了10个模型,从中选择了最好的模型进行比较。然后我们去掉置信学习,并应用公式10中的约束来评估置信学习的有效性。类似地,我们去掉了公式16中的梯度范数约束用于评价下界约束的有效性。

通过比较第一行和其他行,随机搜索算法无法在预定义的搜索空间内获得有竞争力的结果,这证明了发现鲁棒神经结构的必要性。对比第二行和最后一行,没有置信学习的搜索架构往往具有相对较高的自然准确率。相反,我们提出的RACL通过置信学习实现了相对较大的对抗精度增量,这突出了所提出的置信度架构采样的重要性。然后,我们研究了超参数ρ的影响,并报道了在不同ρ值下搜索到的鲁棒细胞在CIFAR-10上的性能。通过比较,ρ值过大会影响对干净图像的分类性能。相反,较小的ρ值会降低Lipschitz约束的影响,导致较差的对抗精度。研究了置信度超参数η的影响。由公式16可知,η控制着Lipschitz常数λF的均值和方差之间的平衡。通过交叉验证,将η值设置为0.9,以获得最佳的对抗精度。

5 CONCLUSION

在本文中,我们建议通过结合NAS框架来解决神经网络的脆弱性。通过从可训练的对数正态分布中采样结构参数,我们证明了整个网络的近似Lipschitz常数可以表示为单变量对数正态分布,这使得所提出的鲁棒结构置信学习算法能够通过Lipschitz约束对鲁棒性形成结构参数的置信学习。深入的实验证明了体系结构对对抗鲁棒性的影响,以及RACL在不同数据集的各种攻击下的有效性。