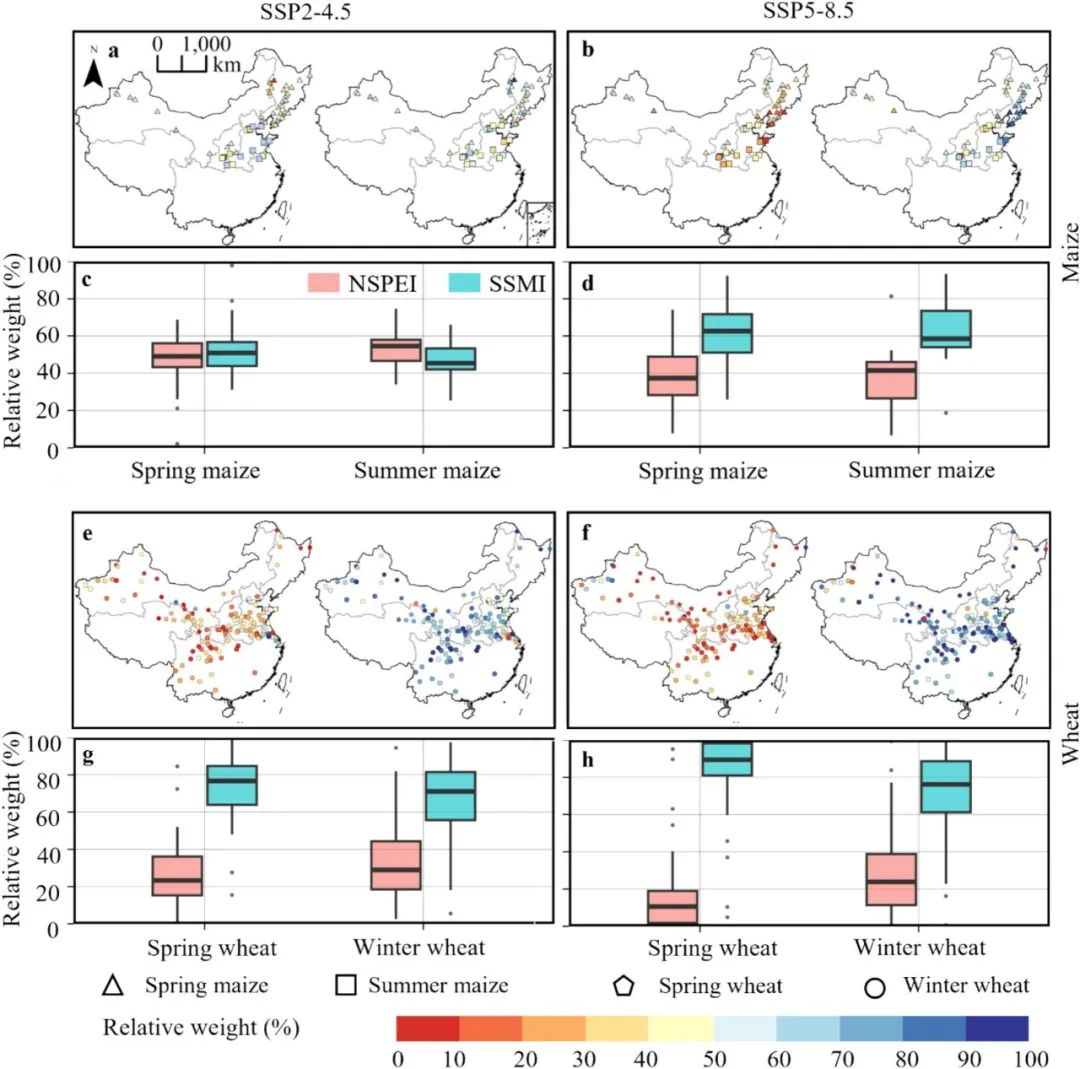

看到文章《Ollama可以玩GLM4和CodeGeeX4了,快来魔搭玩起来》,参考的运行了一遍,折腾了一个晚上加一个上午,终于搞定了。本来很简单的事情,对这个代码小白,还是有点坑。。

GPU要明显快很多,CPU的速度,也还凑合吧。

个人尝试,整个过程如下:

1)启动魔塔社区的Notebook环境:

2)启动一个Terminal

3)在启动的Terminal输入以下命令:

先需要下载模型

modelscope download --model=LLM-Research/glm-4-9b-chat-GGUF --local_dir . glm-4-9b-chat.Q5_K.gguf

使用魔搭镜像环境安装,这一步是必须的:

modelscope download --model=modelscope/ollama-linux --local_dir ./ollama-linux

cd ollama-linux

sudo chmod 777 ./ollama-modelscope-install.sh

./ollama-modelscope-install.sh

启动Ollama服务

ollama serve

显示如下:

3)然后再启动一个Terminal

注意,需要另外启动一个Terminal

创建ModelFile

复制模型路径,创建名为“ModelFile”的meta文件,内容如下:

FROM /mnt/workspace/glm-4-9b-chat.Q5_K.gguf

#FROM /mnt/workspace/codegeex4-all-9b-Q5_K_M.gguf

# set parameters

PARAMETER stop "<|system|>"

PARAMETER stop "<|user|>"

PARAMETER stop "<|assistant|>"

TEMPLATE """[gMASK]<sop>{{ if .System }}<|system|>

{{ .System }}{{ end }}{{ if .Prompt }}<|user|>

{{ .Prompt }}{{ end }}<|assistant|>

{{ .Response }}"""

创建自定义模型

使用ollama create命令创建自定义模型

ollama create myglm4 --file ModelFile

运行模型:

ollama run myglm4

然后就成功了,显示如下:

4)也尝试了一下CodeGeeX4-ALL-9B 的Ollama部署

基本过程也一样

就是需要先下载模型:

modelscope download --model=LLM-Research/codegeex4-all-9b-GGUF --local_dir . codegeex4-all-9b-Q5_K_M.gguf

修改ModelFile,把“#FROM /mnt/workspace/codegeex4-all-9b-Q5_K_M.gguf”的注释取消,把“FROM /mnt/workspace/glm-4-9b-chat.Q5_K.gguf”注释掉

最后结果如下: