继 《Transformer模型-2-模型架构》该文主讲Transformer的基本工作流程。

第一步: 获取输入句子某单词的向量X。

X:是指某单词的向量,transformer是分别计算word embedding和position embedding并将两者相加得到向量X。

Embedding Embeddings 是一种将现实世界的对象和关系表示为向量的密集数值表示形式,把字或词转为向量的动作或行为。在机器学习/深度学习中我们用向量表示物体的,这个物体可以是一个单词、一条语句、一个序列、一件商品、一个动作、一本书、一部电影等。拿到语料之后,首先需要做一些必要的清理工作,如清理特殊符号、格式转换、过滤停用词等,然后进行分词、索引化,再利用相关模型或算法把单词、词等标识符向量化。最后输出给下游任务,如下图:

现在主流的分词处理工具是BPE, 好处是不需要像jieba一样需要开发者保存二维数据

图片描述增加了主流分词工具标注。

词嵌入或预训练模型是关键,它们的质量好坏直接影响下游任务的效果。如word2vec、Transformer、BERT、ALBERT等方法。刷新了自然语言处理、语言识别、推荐任务、搜索排序等任务在性能方面的纪录

Transformer中包含两种Embedding:

- word embedding:将字或词转为index之后,查表转化为向量,经过模型的迭代之后,矩阵会越来越准确,生成的Embedding的结果就会越来越发。

- position embedding:告诉模型正确的语序(transformer不是时序模型,是并行输入的,需要专门的位置Embedding才能知道句子顺序)。

PS: 向量矩阵理解 假设有一个1000千万的数据按词(早期按字去切分)切分, 再根据词表大小建立了一个数据矩阵或lookup的一张表,该矩阵或表的特点如下:

- 行数,有多少词就有多少行

- 列数:取决于模型的维度(训练维度),可以是768维,512维等,具体要根据模型的维度和输入数据要求的维度(Transformer是512维,BERT是768维)

- index:每一行代表一个词,第一行(词)都有一个唯一的index,每一个index对应到矩阵中的一行(0开始计),按词的列表做一个倒排,哪一个词出现的更多,就更靠前。

- 查询:用index去矩阵中去(lookup)查,可以查到唯一的记录。查询返回第index行的向量,拿到该向量可作为词的表征

第二步: 将获得的单词向量矩阵X传入Encoder

将得到的单词表示向量矩阵(每一行是一个单词的向量x) 传入Encoder中,经过6个 Encoder block 后可以得到句子所有单词的编码信息矩阵 C,如下图:

Transformer的Encoder的6层中,每一层的结构相同,经过6层的结构处理,每一层的输出是下一层的输出。 单词向量矩阵用 Xn∗dX_{n*d}Xn∗d 表示, n是句子中单词个数,d 是表示向量的维度 (论文中 d=512)。每一个 Encoder block 输出的矩阵维度与输入完全一致。

第三步: 将Encoder输出的编码信息矩阵C传递Decoder

将Encoder输出的编码信息矩阵C传递到Decoder中,Decoder依次会根据当前翻译过的第i个单词,翻译下一个单词(i+1),如下图所示。在使用的过程中,翻译到第i+1单词时候需要通过Mask操作遮盖住(i+1)之后的单词。

在Transformer中Decoder的6层结构,每一步都会结合 Encoder 输出的编码信息矩阵 C 执行,最后输出预测结果

下图展示了 Transformer 使用时候的大致流程: Decoder接收了Encoder的编码矩阵C,然后首先输入一个翻译f起始符 “”,预测第一个单词 “I”;然后输入翻译开始符 “” 和单词 “I”,预测单词 “like”,以此类推。

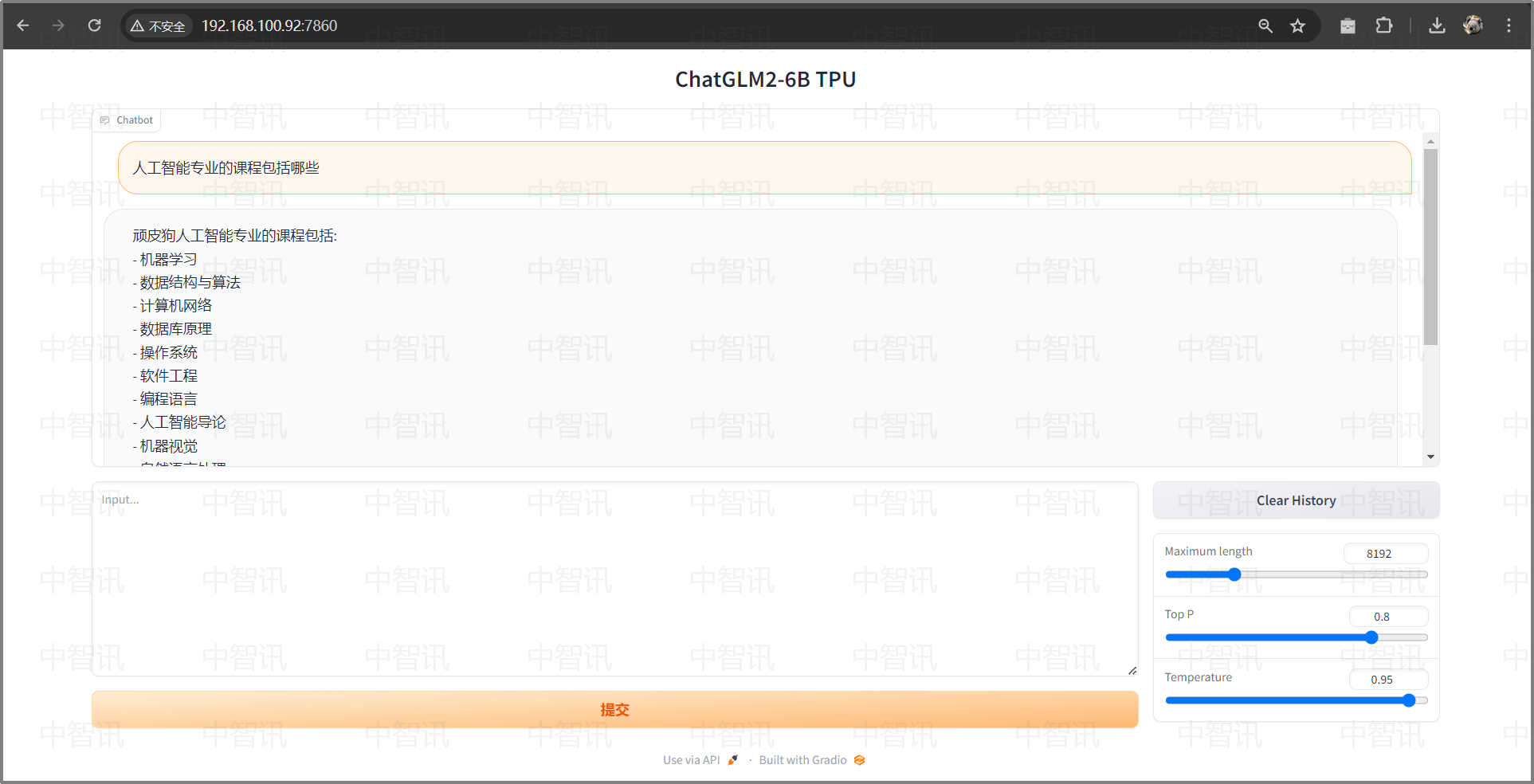

如何学习AI大模型?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高

针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉[CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)]()👈

学习路线

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓