点一下关注吧!!!非常感谢!!持续更新!!!

目前已经更新到了:

- Hadoop(已更完)

- HDFS(已更完)

- MapReduce(已更完)

- Hive(已更完)

- Flume(已更完)

- Sqoop(已更完)

- Zookeeper(已更完)

- HBase(已更完)

- Redis (已更完)

- Kafka(已更完)

- Spark(正在更新!)

章节内容

上节完成的内容如下:

- Standalone提交

- SparkContext相关概念

- Shuffle 概念、历史、V1和V2对比

SparkSQL 概述

简单介绍

SparkSQL 是 Apache Spark 中用于处理结构化数据的模块。它不仅支持 SQL 查询,还允许你将 SQL 查询与 Spark 的其他强大功能结合使用,如数据流处理和机器学习。SparkSQL 提供了对数据的高度优化的访问方式,可以处理大量的结构化和半结构化数据集。

核心功能

- SQL 支持:SparkSQL 允许用户使用标准的 SQL 语句查询数据,类似于传统的关系型数据库。它支持基本的 SQL 操作,如 SELECT、JOIN、GROUP BY 等。

- 数据框 API:数据框(DataFrame)是 SparkSQL 中最重要的概念之一。它是一个分布式的数据集,类似于关系数据库中的表。数据框提供了一个统一的接口来处理不同的数据源,如 Hive、Parquet、JSON、CSV 等。你可以用类似 SQL 的方式对数据框进行操作,如过滤、聚合等。

- 与其他 Spark 组件的集成:SparkSQL 无缝集成了 Spark 的其他组件,如 Spark Streaming 和 Spark MLlib。你可以将结构化数据处理与流数据处理或机器学习算法结合在一起。

- Catalyst 优化器:SparkSQL 使用 Catalyst 优化器来自动优化 SQL 查询。这是一个强大的查询优化器,可以对查询执行计划进行转换和优化,从而提高查询的执行效率。

- 统一的数据访问:SparkSQL 提供了一种统一的数据访问方式,可以处理结构化、半结构化和非结构化数据。它支持多种数据源,如关系数据库(通过 JDBC)、Hive、HDFS、Amazon S3 等。

使用场景

- 数据仓库和商业智能:利用 SparkSQL 可以对大规模数据集进行复杂的查询和分析,非常适合用于数据仓库和商业智能场景。

- 数据集成:SparkSQL 可以集成多个不同的数据源,将它们整合成一个统一的视图进行处理。

- 数据管道:在数据管道中,SparkSQL 常用于数据的清洗、转换和聚合。

Hive

- Hive的诞生,主要是因为MapReduce程序对Java的要求比较高,为了他们能够操作HDFS上的数据,推出了Hive。

- Hive 和 RDBMS 的 SQL模型比较类似,容易掌握。

- Hive 的主要缺陷在于它的底层是基于MapReduce的,执行比较慢。

Spark 0.x: Shark

在Spark 0.x版的时候推出了Shark,Shark与Hive是紧密关联的,Shark底层很多东西还是依赖于Hive,修改了内存管理、物理计划、执行三个模块,底层使用Spark基于内存的计算模型,性能上比Hive提升了很多倍。

Shark更多的是对Hive的改造,替换了Hive的物理执行引擎,提高了执行速度。但Shark继承了大量的Hive代码,因为给优化和维护带来了大量的麻烦。

Spark 1.x: Shark

在Spark1.x版本时Shark被淘汰,在2014年7月1日的SparkSummit上,Databricks宣布终止对于Shark的开发,将重点放到了 SparkSQL 上。

Shark终止后,产生了两个分支:

- Hive On Spark:Hive社区的,源码在Hive中

- Spark SQL (Spark On Hive):Spark社区的,源码在Spark中

Spark 3.0

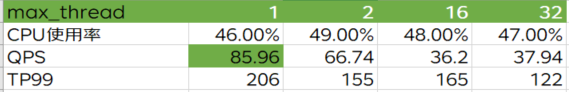

Spark3.0 超过3400个Jira问题被解决,下面是各个核心组件中分布情况:

Spark SQL 特点

Spark SQL 从面世以来不仅结果了 Shark 的接力棒,为Spark用户提高高性能的 SQL On Hadoop 的解决方案,换为Spark带来了通用的、高效的、多元一体的结构化的数据处理能力。

Spark SQL 的优势:

- 写更少的代码

- 读更少的数据(Spark SQL的表数据在内存中存储不使用原生态JVM对象存储方式,而是内存列存储)

- 提供更好的性能(字节码生成技术、SQL优化)

Spark SQL 数据抽象

Spark SQL 提供了两个新的抽象,分别是:

- DataFrame

- DataSet

DataFrame

DataFrame 的前身是SchemaRDD,Spark 1.3更名为 DataFrame,不继承RDD,自己实现了RDD的大部分功能。

与RDD类似,DataFrame也是一个分布式的数据集:

- DataFrame可以看做分布式Row对象的集合,提供了由列组成的详细模式信息,使其可以得到优化-

- DataFrame不仅有比RDD更多的算子,还可以进行执行计划的优化

- DataFrame更像传统数据的二维表格,除了数据以外,还记录数据的结构信息,即 Schema

- DataFrame支持嵌套数据类型(struct、array、map)

- DataFrame API 提供了一套高层的关系操作,比函数式的RDD API要更加友好,门槛更低。

- DataFrame 的劣势在于编译期间缺少安全检查,导致运行时出错。

下图是RDD存储和DataFrame存储的对比图:

Dataset

Dataset是在Spark1.6中添加的新的接口

- 与RDD相比,保存了更多的描述信息,概念上等同于关系型数据库中的二维表

- 与DataFrame相比,保存了类型信息,是强类型的,提供了编译时类型检查

- 调用Dataset的方法先会生成逻辑计划,然后Spark的优化器进行优化,最终生成物理计划,然后提交到集群中运行

- Dataset包含了DataFrame的功能,在Spark2.0中两者得到了统一,DataFrame表示为Dataset[Row],即Dataset的子集

Row & Schema

DataFrame = RDD[Row] + Schema。DataFrame的前身是 SchemaRDD

Row是一个泛化、无类型的JVM Object

我们可以启动 spark-shell 进行直观的体验:

spark-shell --master local[*]

尝试运行下面的代码:

import org.apache.spark.sql.Row

val row1 = Row(1, "abc", 1.2)

row1(0)

row1(1)

row1(2)

row1.getInt(0)

row1.getString(1)

row1.getDouble(2)

row1.getAs[Int](0)

row1.getAs[String](1)

row1.getAs[Double](2)

运行过程如下所示:

三者共性

- RDD、DataFrame、Dataset是Spark平台下的分布式弹性数据集,为处理海量数据提供便利

- 三者都有许多相同的概念,如分区、持久化、容错等,有许多共同的函数,如 Map、Filter、SortBy

- 三者都有惰性机制,只有在遇到Action算子时,才会开始真正的计算。

- 对DataFrame和Dataset进行操作许多操作都需要这个包进行支持(import spark.implicits._)

三者区别

DataFrame(DataFrame = RDD[Row] + Schema)

- 与RDD和DataSet不同,DataFrame每一行的类型固定为Row,只有通过解析才能获取各个字段的值

- DataFrame与Dataset均支持SparkSQL的操作

Dataset(Dataset = RDD[case class].toDS)

- Dataset和DataFrame拥有完全相同的成员函数,区别只是每一行的数据类型不同

- DataFrame 定义为 Dataset[Row],每一行的类型是Row,每一行究竟有哪些字段,各个字段又是什么类型都无从得知,只能用前面的提到的getAs的方式来拿出字段

- Dataset每一行的类型都是一个 case class,在自定义了 case class之后可以很自由的获得每一行的信息

数据类型

SparkSQL 支持多种数据类型,这些数据类型可以表示不同种类的结构化数据。理解这些数据类型有助于你在使用 SparkSQL 进行数据处理时,正确地定义和操作数据。

基本类型

- StringType:表示字符串类型的数据。用于存储文本数据。

- BinaryType:表示二进制数据类型,用于存储字节数组。

- BooleanType:表示布尔类型的数据,只有两个可能的值:true 和 false。

- DateType:表示日期类型的数据,不包含时间部分。格式通常为 YYYY-MM-DD。

- TimestampType:表示时间戳类型的数据,包含日期和时间。格式通常为 YYYY-MM-DD HH:MM:SS.SSSSSS。

- DoubleType:表示双精度浮点数类型的数据。用于存储高精度的数值。

- FloatType:表示单精度浮点数类型的数据。比 DoubleType 占用更少的存储空间,但精度较低。

- ByteType:表示一个 8 位有符号整数的数据类型。取值范围为 -128 到 127。

- ShortType:表示一个 16 位有符号整数的数据类型。取值范围为 -32768 到 32767。

- IntegerType:表示一个 32 位有符号整数的数据类型。取值范围为 -2147483648 到 2147483647。

- LongType:表示一个 64 位有符号整数的数据类型。用于存储长整型数据。

- DecimalType:表示精确的小数类型的数据。通常用于存储货币或需要精确计算的小数。

复杂类型

- ArrayType:表示一个数组类型,可以存储相同数据类型的多个值。它的元素类型可以是任何数据类型(包括嵌套的复杂类型)。

- MapType:表示键值对(key-value pairs)的集合,类似于哈希表或字典。键和值都可以是任意数据类型。

- StructType:表示一个结构体类型,类似于关系数据库中的行。它由一组字段组成,每个字段都有一个名称和类型。StructType 是用来定义表的模式的主要方式。

特殊类型

- NullType:表示空值的类型,通常在处理空数据或缺失数据时使用。

- CalendarIntervalType:表示一个时间间隔,用于存储时间差异,例如几年几个月几天。