什么是Scrapy框架?

Scrapy框架是Python编写的一个强大、快速的网络爬虫和网页抓取框架。它能帮助开发者轻松地从网站上提取数据,并进行数据处理和存储。Scrapy的设计灵活且功能强大,适用于各种数据采集任务。

为何需要在Scrapy中添加代理IP?

在进行大规模数据采集时,频繁的访问请求很容易引起目标网站的警觉,甚至可能被封禁。这就需要我们在Scrapy中添加代理IP,通过模拟来自不同IP地址的请求,避免被网站封禁,从而顺利完成数据采集任务。

IPIPGO-海外IP代理|稳定高匿国外HTTP|Socks5|动静态IP代理服务商【免费试用】IPIPGO是提供稳定高匿的ip代理服务商,拥有9000W+海外家庭IP,24小时去重,IP可用率达99.9%,提供http代理、socks5代理、动静态ip代理等国外ip代理服务器,在线网页或软件代理ip方便快捷,可免费试用.![]() http://www.ipipgo.com/?promotionLink=ea6618

http://www.ipipgo.com/?promotionLink=ea6618

如何在Scrapy中添加代理IP?

在Scrapy中添加代理IP并不复杂,下面将详细介绍添加代理IP的步骤。

步骤一:安装必要的库

首先,我们需要安装`scrapy`和`scrapy-proxies`这两个库。可以使用以下命令进行安装:

pip install scrapy

pip install scrapy-proxies

步骤二:修改Scrapy的设置文件

在Scrapy项目的`settings.py`文件中,添加以下配置:

# 启用代理中间件

DOWNLOADER_MIDDLEWARES = {

'scrapy.downloadermiddlewares.httpproxy.HttpProxyMiddleware': 110,

'scrapy_proxies.RandomProxy': 100,

}

# 代理列表文件路径

PROXY_LIST = '/path/to/proxy/list.txt'

# 代理模式:随机选择

PROXY_MODE = 0在上述配置中,我们启用了代理中间件,并指定了代理列表文件的路径。代理模式设置为0,表示随机选择代理IP。

步骤三:创建代理列表文件

接下来,我们需要创建一个代理列表文件,文件名为`proxy_list.txt`,内容如下:

http://username:password@proxy1:port

http://username:password@proxy2:port

http://username:password@proxy3:port

如果代理IP不需要认证,可以省略`username:password@`部分,直接写成:

http://proxy1:port

http://proxy2:port

http://proxy3:port步骤四:编写爬虫代码

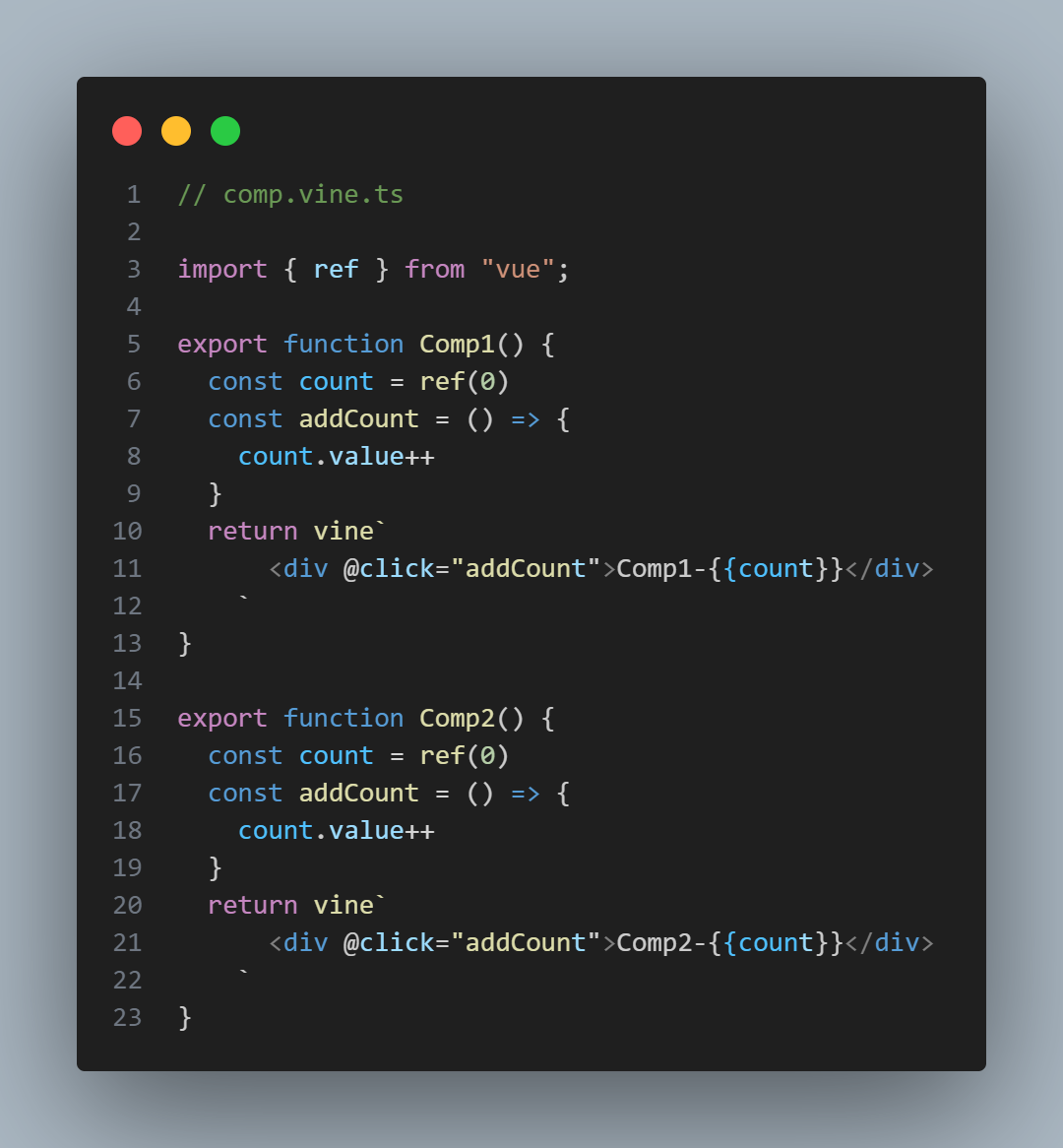

最后,我们编写爬虫代码,示例如下:

import scrapy

class MySpider(scrapy.Spider):

name = 'my_spider'

start_urls = ['http://example.com']

def parse(self, response):

self.log('Visited: %s' % response.url)

# 处理页面内容在上述代码中,我们定义了一个简单的爬虫,访问`http://example.com`并记录访问的URL。

使用代理IP的注意事项

在使用代理IP时,有几个事项需要特别注意。首先,不要频繁更换代理IP。频繁更换IP地址可能会引起目标网站的怀疑,甚至可能被封禁。

其次,尽量避免使用免费代理。免费的东西往往有其隐患,免费代理IP可能会记录你的上网活动,甚至可能带有恶意软件。

最后,确保代理IP的速度和稳定性。选择那些有良好声誉的服务提供商,避免使用来历不明的代理。

结语

通过在Scrapy框架中添加代理IP,我们可以有效地隐藏真实身份,避免被目标网站封禁,从而顺利完成数据采集任务。希望这篇文章能帮助你更好地理解和使用Scrapy中的代理IP,让你的数据采集工作更加顺畅、高效。